Kurzfassung

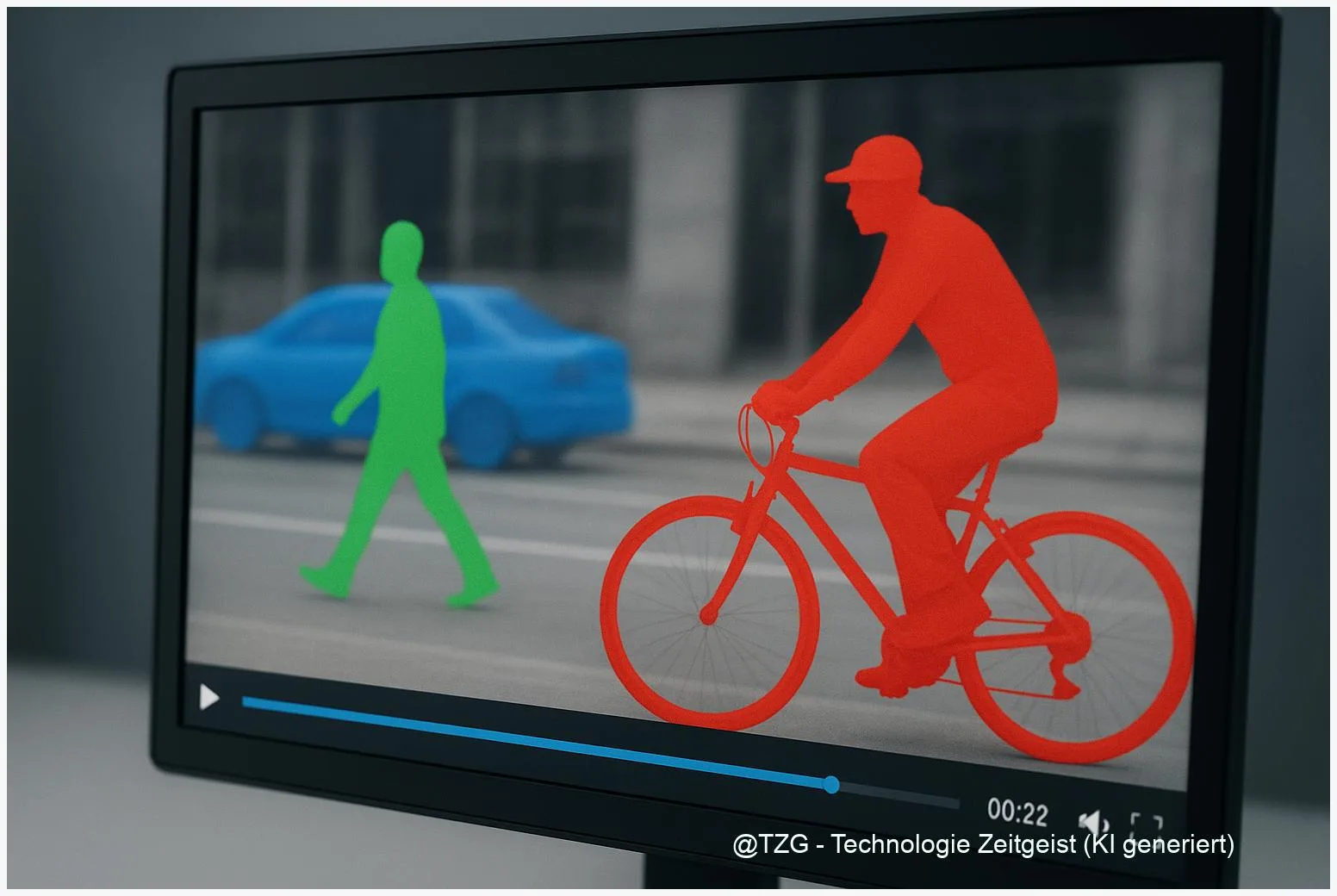

SAM 3 steht für einen neuen Ansatz in der Bild‑ und Videosegmentierung, der besonders auf promptable concept segmentation abzielt. Dieser Artikel erklärt, was SAM 3 und das dazugehörige SA‑Co‑Benchmark praktisch bedeuten und wie sich daraus belastbare Video‑Annotation‑Pipelines bauen lassen. Leser erhalten einen klaren Fahrplan für Tests, Integration und die wichtigsten rechtlichen sowie methodischen Prüfungen.

Einleitung

Das Thema hier ist technisch, aber vor allem praktisch: Wie lassen sich moderne Modelle wie SAM 3 für zuverlässige Video‑Annotation nutzen? In den folgenden Abschnitten erläutere ich kurz die Kernideen hinter SAM 3 promptable concept segmentation, skizziere den SA‑Co‑Datensatz und zeige, wie man eine Pipeline plant, die Tracking, Qualitätssicherung und rechtliche Prüfungen verbindet. Ziel ist kein akademischer Tiefgang, sondern ein klarer Leitfaden für Teams, die mit Videodaten arbeiten.

Was SAM 3 bedeutet

SAM 3 beschreibt einen klaren Entwicklungsschritt: Segmentierungsmodelle akzeptieren jetzt nicht nur Klicks oder grobe Boxen, sondern auch textliche und exemplarische Prompts, um präzisere Konzepte zu finden. In der Praxis heißt das: Statt „markiere alles, was ein Hund ist“ kann ein Prompt ein enger gefasstes Konzept adressieren, etwa „heller Hund auf Gras“. Dieser Ansatz nennt sich promptable concept segmentation und eröffnet neue Wege für semantisch reichere Annotationsaufgaben.

„Promptable Concept Segmentation verschiebt die Kontrolle vom Labeling‑Interface in die Semantik der Anfrage.“

Der Gewinn liegt in der Flexibilität: Teams können mit wenigen Beispielen oder kurzen Texten sehr unterschiedliche Objektgruppen erfassen. Läuft das Modell stabil, reduziert das den manuellen Aufwand beim Bounding‑Box‑Erstellen und macht Labeler schneller. Gleichzeitig steigt die Abhängigkeit von sorgfältig formulierten Prompts und robusten Tracking‑Mechanismen bei Videoaufnahmen.

Kurz erklärt: Promptable concept segmentation kombiniert drei Bausteine — ein Auffindmodul, das auf Prompt reagiert; ein Segmenter, das feine Masken liefert; und bei Videos ein Tracker, der Objekte über Frames hinweg konsistent hält. Bei produktiver Nutzung ist es wichtig, die Grenzen dieser Bausteine zu kennen und systematisch Fehlerarten zu dokumentieren.

Zur Orientierung ein kleiner Vergleich in Stichpunkten:

| Merkmal | Beschreibung | Kurz |

|---|---|---|

| Prompttypen | Textprompts und exemplarische Bildprompts | Text & Beispiel |

| Output | Feingranulare Masken statt nur Boxen | Masken |

Wichtig: Viele der technischen Details stammen aus Metas Veröffentlichungen und Repositorien. Für produktive Einsätze prüft man Lizenzbedingungen und Testsets, bevor man Checkpoints in Produktion bringt.

SA‑Co und die Video‑Herausforderung

SA‑Co ist Metas Antwort auf die Notwendigkeit großer, semantisch reich annotierter Datensätze für promptable tasks. Das Dataset liefert eine Vielzahl von Konzepten und ein separates Video‑Eval‑Set, das speziell für promptbasierte Prüfungen gedacht ist. Für Teams, die mit realen Videos arbeiten, ist dieser Datentyp interessant, weil er Beispiele für wechselnde Perspektiven, Beleuchtung und Objektkopfbewegungen enthält.

Videodaten bringen drei häufige Probleme: erstens das Tracking von Objekten, wenn sie teilweise verdeckt werden; zweitens die Konsistenz von Konzeptdefinitionen über viele Frames; drittens die Skalierung der Annotation, wenn jedes Frame maskiert sein müsste. SA‑Co und SAM 3 zielen darauf ab, diese Punkte durch automatisierte Prompt‑Antworten und Tracker‑Module zu mildern — doch das funktioniert nicht ohne systematische Validierung.

In der Praxis empfiehlt sich ein abgestuftes Vorgehen: Man beginnt mit kleinen Videoclips, evaluiert cgF1‑ähnliche Metriken auf den vorgegebenen Eval‑Splits und analysiert Fehlsegmente qualitativ. Die Kombination aus automatischer Vorschlagssegmentierung und menschlicher Korrektur erzeugt schnell brauchbare Labels, wenn die Prompt‑Strategie sauber dokumentiert ist.

Ein weiterer Punkt ist die Domänendifferenz: Modelle, die auf allgemeinen Videodaten gut arbeiten, zeigen nicht automatisch die gleiche Präzision in Spezialdomänen wie Verkehr, Medizin oder industrielle Inspektion. Hier lohnen sich gezielte Feinabstimmungen auf kleinen, kuratierten Sets und der Einsatz von heuristischen Trackern, die kurzzeitige Übertragungsfehler ausgleichen.

Schließlich: SA‑Co ist kein Freifahrtschein. Lizenzhinweise und Zugangsbeschränkungen können die Nutzung reglementieren. Teams sollten daher rechtliche Fragen früh klären, bevor sie große Produktionspipelines aufbauen.

Pipelines: Robustheit, Tracking und Annotation

Für eine belastbare Video‑Annotation‑Pipeline verbinden Teams mehrere Bausteine: Vorverarbeitung, Prompt‑Strategie, Modellinferenz, Tracking und Quality Assurance. Die Arbeit mit SAM 3 promptable concept segmentation verändert vor allem die Phase der Prompt‑Strategie: Gute Prompts reduzieren Ambiguität und verringern Korrekturbedarf. In Workshops zahlt es sich aus, verschiedene Prompt‑Templates zu testen und ihre Wirkung systematisch zu protokollieren.

Technisch empfiehlt sich eine zweistufige Inferenz: Zuerst eine schnelle, grobe Erkennung pro Frame, dann ein feiner Segmentierungslauf nur für die relevanten Regionen. Das spart Rechenzeit und reduziert Fehlmasken. Parallel läuft ein Tracker, der Objekt‑IDs stabil hält. Moderne Tracker nutzen sowohl visuelle Eigenschaften als auch interne Repräsentationen des Segmenters, um Objekte auch bei temporärer Verdeckung wiederzufinden.

Wichtig ist die Metrik‑Auswahl. Für promptable Aufgaben sind klassische Pixel‑IoU‑Werte allein oft irreführend. Ergänzende Metriken wie concept‑group F1 messen, ob ein Modell tatsächlich alle Instanzen eines beschriebenen Konzepts findet. In der QA‑Phase helfen Stichprobenchecks, in denen menschliche Annotatoren typische Fehlerklassen markieren: fehlende Instanzen, falsche Zugehörigkeit und unstabile Maskenkanten.

Operationalisierung heißt zudem: Automatisierte Alerts für ungewöhnliche Prompt‑Reaktionen einbauen. Wenn ein Prompt plötzlich viele Falschpositiv‑Masken erzeugt, sollte die Pipeline den Clip zur manuellen Überprüfung markieren. Ebenso sinnvoll sind Version‑kontrollierte Prompt‑Sets, damit Änderungen am Promptverhalten reproduzierbar bleiben.

Abschließend ein praktischer Tipp: Beginnen Sie mit kurzen Iterationen und bauen Sie eine kleine Referenz‑Suite aus Clips auf, die typische Herausforderungen Ihrer Domäne abdeckt. So lernen Prompt‑Strategie, Tracker‑Feinjustierung und menschliche Nachbearbeitung zusammen und schaffen eine robuste Grundlage für skalierbare Annotation.

Ethische, rechtliche und praktische Prüfungen

Tech allein reicht nicht. Der Einsatz von großen Datensätzen und leistungsfähigen Segmentern birgt rechtliche und ethische Pflichten. SA‑Co wird mit Lizenzhinweisen ausgeliefert; für kommerzielle Anwendungen oder biometrische Nutzung sind rechtliche Prüfungen unumgänglich. Teams sollten Datenschutzbeauftragte früh einbinden und klären, welche Videotypen und personenbezogenen Inhalte annotiert werden dürfen.

Transparenz ist ein weiterer Punkt: Dokumentieren Sie, welche Prompts verwendet wurden, welche Versionen eines Modells liefen und wie menschliche Korrekturen vorgenommen wurden. Diese Nachvollziehbarkeit ist wichtig für Qualitätssicherung und mögliche Audits. Ebenfalls empfehlenswert sind Bias‑Analysen auf repräsentativen Subsets, um zu prüfen, ob bestimmte Gruppen systematisch schlechter erkannt werden.

Praktisch heißt das: Führen Sie vor dem produktiven Rollout drei Prüfungen durch — Lizenzcheck, Datenschutz‑Review und ein kleines Replikationsexperiment auf einem evaluierten SA‑Co‑Subset. Nur so lässt sich die vermeintliche Leistungsfähigkeit in echte Produktqualität überführen.

Zum Abschluss noch ein realistischer Blick: Auch fortgeschrittene Modelle brauchen menschliche Kontrolle in anspruchsvollen Domänen. Die Kombination aus automatisierter Segmentierung und gezielter Nacharbeit bleibt der praktischste Weg, um sowohl Effizienz als auch Verlässlichkeit zu gewährleisten.

Fazit

SAM 3 und das SA‑Co‑Benchmark bringen echte Möglichkeiten für promptbasierte Bild‑ und Videoarbeit. Für produktive Pipelines zählen aber weniger Hype‑Worte als saubere Tests: Lizenzklarheit, reproduzierbare Prompt‑Sätze und sorgfältige QA. Mit iterativen Tests, stabilen Trackern und dokumentierten Prompt‑Strategien lassen sich die Stärken von SAM 3 praktisch nutzen und Risiken kontrollieren.

*Diskutieren Sie Ihre Erfahrungen mit SAM 3 und SA‑Co in den Kommentaren und teilen Sie diesen Leitfaden, wenn er für Ihr Team nützlich war.*

Schreibe einen Kommentar