Kurzfassung

Opik local LLM pipeline ist heute ein pragmatischer Weg, um LLM‑Anwendungen lokal beobachtbar und reproduzierbar zu betreiben. Dieser Artikel zeigt, wie Opik als Tracing‑ und Evaluationsplattform mit colocated Models kombiniert wird, welche Metriken wirklich zählen und wie Prompt‑Planung sowie QA‑Pipelines messbar gemacht werden. Leser bekommen konkrete Schritte für ein lokales Proof‑of‑Concept, wichtige Fallstricke und Hinweise zur Validierung von Herstellerangaben.

Einleitung

Wer ML‑Modelle lokal betreibt, will zwei Dinge zugleich: Kontrolle und Nachvollziehbarkeit. Opik local LLM pipeline ist kein Marketingbegriff, sondern eine Pragmatik — ein Instrument, das Traces, Metriken und Evaluationsläufe zusammenführt, damit Entwickler Entscheidungen begründet treffen können. In den folgenden Abschnitten skizziere ich ein praktikables Setup: lokale Opik‑Instanz für Entwicklung, colocated Models neben der Pipeline, und eine Reihe von Tests und Metriken, die echte Qualitätsentscheidungen ermöglichen. Das ist kein Deep‑Tech‑Lehrgang, sondern ein Alltagspakt zwischen Ingenieurskunst und Verantwortlichkeit.

Warum Transparenz lokal beginnt

Transparenz ist kein technisches Extra, sie ist ein soziales Versprechen: ein System muss erklären können, wie es zu einer Antwort gelangt ist. Lokal gehostete Pipelines reduzieren Latenz und erlauben sensibles Datenhandling, zugleich eröffnen sie die Möglichkeit, Observability‑Daten näher an der Quelle zu sammeln. Opik bietet genau dafür ein Set an: Tracing von Calls und nested spans, annotierbare Antworten und Evaluationsmetriken, die aus konkreten Läufen entstehen. Wer auf lokalem Boden misst, erkennt Abweichungen schneller und kann Korrekturen engmaschiger vornehmen.

„Messbarkeit macht Entscheidungen möglich. Ohne Messung bleibt vieles Intuition.“

Die Praxis beginnt meist mit einem einfachen Experiment: eine Opik‑Instanz via ./opik.sh lokal starten, ein kleines Modell‑Service colocated betreiben und die SDK‑Instrumentierung (Python/TypeScript) aktivieren. Schon dieser minimale Schritt erzeugt Traces, die Aufschluss über Token‑Kosten, Latenzen und Fehlerfälle geben. Genau diese Daten sind die Grundlage für Prompt‑Optimierung, für QA‑Suiten und für die Frage, ob ein Model‑wechsel lokal sinnvoll ist.

Welche Metriken zählen? Nicht alle Kennzahlen sind gleich aussagekräftig. Die folgende Tabelle zeigt eine Auswahl an pragmatischen Metriken, die sich für eine erste Priorisierung eignen — sie sind Hinweise, keine ultimative Wahrheit.

| Merkmal | Warum es wichtig ist | Beispiel |

|---|---|---|

| Antwort‑Genauigkeit | Kern für Nutzerzufriedenheit und QA | Niedrige Fehlerrate |

| Latenz | Spürbar für Interaktivität | Schnell vs. langsam |

Architektur: Opik trifft Colocated Models

Eine klare Architektur reduziert Fehlerquellen. In der Praxis bedeutet das: ein leichtgewichtiger Modell‑Service (Colocated Model) läuft auf derselben oder benachbarten Infrastruktur wie die Applikation; Opik wird lokal als Observability‑Layer betrieben und zeichnet jeden LLM‑Aufruf als Trace auf. Für Entwicklung ist der Weg simpel: Repo klonen, ./opik.sh ausführen, Python‑SDK installieren und OpikTracer oder entsprechende Decorators in den Call‑Pfad einhängen.

Wichtig ist, die Tracing‑Grenzen zu definieren. Ein Trace sollte Input, Prompt‑Version, Modell‑Version, Response und Metadaten enthalten. Nested spans markieren Subschritte: Prompt‑Konstruktion, Anfrage an das Model, Post‑Processing, externe Tool‑Calls. Opik stellt APIs für Decorators, Kontextmanager und LangChain‑Callbacks bereit — das erlaubt granularere Einsichten ohne invasive Code‑Umbauten.

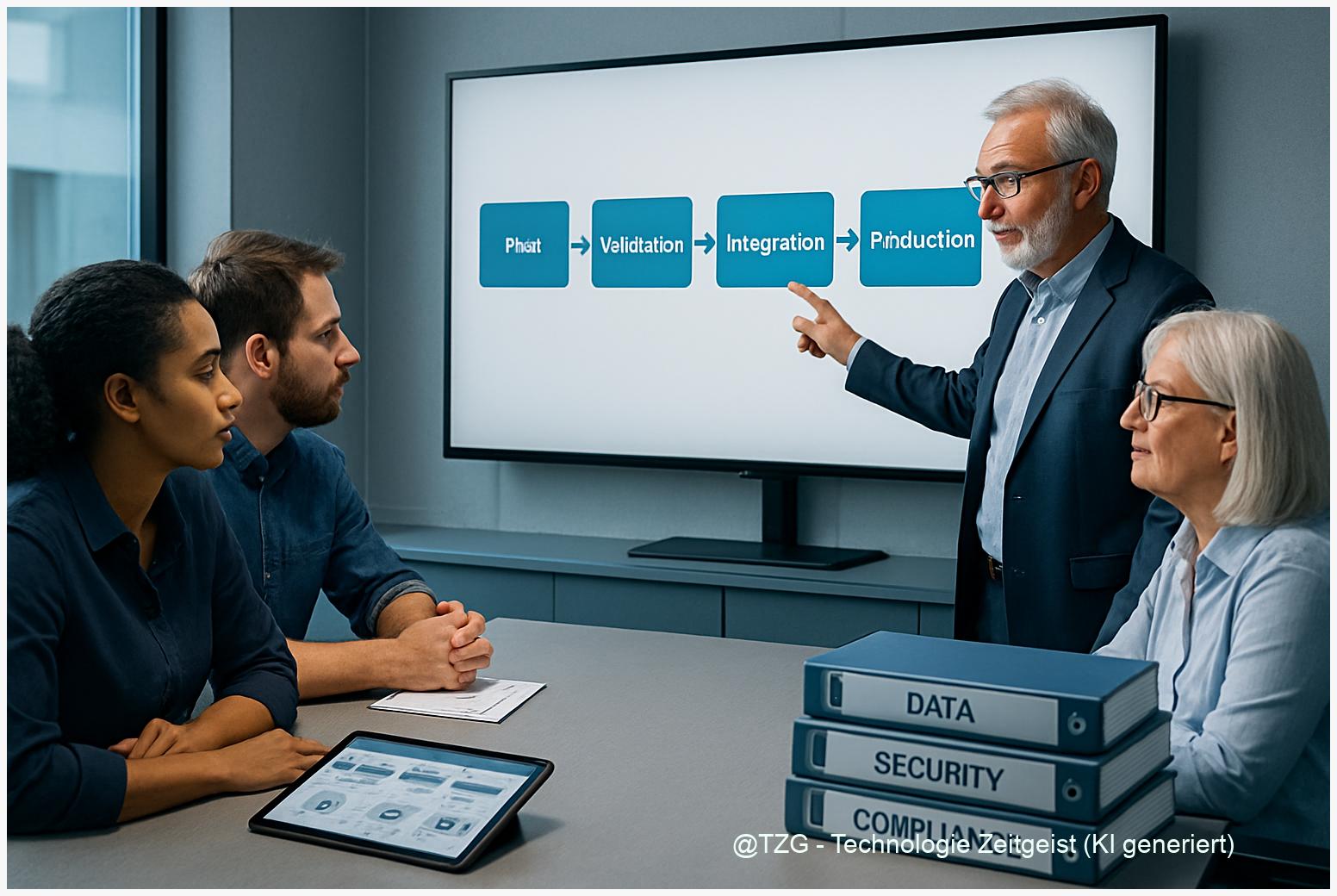

Für Produktion empfiehlt Opik selbst Kubernetes/Helm; Docker‑Compose bleibt ein Dev‑Werkzeug. Hersteller geben Skalenzahlen als Designziel an — solche Angaben (z. B. hohe Trace‑Raten) sind nützlich, sollten aber vor dem produktiven Einsatz durch eigene Lasttests verifiziert werden. Zusätzlich ist es sinnvoll, eine Sampling‑Strategie zu implementieren: nicht jeder Call braucht vollen Trace, Sampling reduziert Speicher und erhöht Performance.

Organisatorisch zahlt sich eine Tracing‑Policy aus: welche Felder verpflichtend sind, wie PII gehandhabt wird und welche Sampling‑Regeln gelten. Diese Policy wird zur Vertragsgrundlage zwischen Entwicklerteams und Produktverantwortlichen — und sie ist das, was aus Observability echte Governance macht.

Reproduzierbarkeit, Prompt‑Planung und QA

Reproduzierbarkeit ist ein praktisches Gebot: Wenn ein Test fehlschlägt, muss er wiederholt werden können. Das beginnt mit Versionskontrolle für Prompt‑Sets, klaren Testdaten und deterministischen Abläufen. Opik unterstützt das durch Experiments und Datasets: Läufe werden mit Metadaten versehen, sodass ein Fehlerfall auf einen konkreten Prompt‑Commit zurückgeführt werden kann. Prompt‑Planung wird so zur wiederholbaren Aktivität statt zur lose dokumentierten Idee.

In der QA‑Pipeline sind zwei Mechanismen besonders hilfreich: automatisierte Regressionstests und «LLM as a Judge». Erstere führen definierte Inputs gegen aktuelle Modelle und vergleichen strukturierte Outputs; Letztere nutzen Modelle — oder vorzugsweise mehrere Judger—, um Relevanz, Korrektheit und Konsistenz zu bewerten. Opik bietet Frameworks, die diese Bewertungen erfassen und in Dashboards sichtbar machen, damit ein menschlicher Reviewer nur dort eingreift, wo die Metrik‑Signale schwach sind.

Praktisch heißt das: automatisierte Tests in CI laufen bei jedem Commit, erzeugen Traces und Metriken, und schlagen Alarm, wenn definierte Qualitätsbarrieren unterschritten werden. Wichtige Elemente sind Seed‑Management für zufallsabhängige Steps, Snapshotting von Prompt‑Input/Output und eine kleine, kuratierte Testmenge für schnelle Durchläufe. Für größere Releases empfiehlt sich zusätzlich eine umfangreiche Evaluations‑Suite mit menschlicher Überprüfung.

Schließlich ist Transparenz gegenüber Stakeholdern entscheidend: QA‑Ergebnisse, Fehlerraten und Änderungen an Prompt‑Versionen sollten als kleine, nachvollziehbare Stories dokumentiert werden — das schafft Vertrauen und verringert riskante Schnellschüsse in Produktion.

Messen, Tracen und validieren

Messung ohne Kontext bleibt stumm. Deshalb sollten Metriken immer mit Hypothesen verknüpft werden: Was bedeutet eine höhere Latenz für das Nutzererlebnis? Ab wann darf eine Halluzination als Incident gelten? Opik liefert Rohdaten; Entscheidend ist, welche Kennzahlen als Policy definiert sind und welche Alerts sie auslösen.

Technisch bietet Opik Traces, nested spans und Annotierungen, sodass jeder Schritt einer Request‑Kette nachvollziehbar ist. Für die tägliche Praxis empfiehlt sich eine kleine Metrik‑Kollektion: Erfolgsrate, Medianlatenz, Anteil defekter Antworten, Veränderung der Bewertungs‑Scores (via LLM‑Judger). Diese Metriken bilden zusammen das Lagebild, das Teams in Standups und Post‑Mortems diskutieren.

Ein weiterer Punkt: Validierung von Herstellerangaben. Opik‑Dokumentation nennt Designziele für hohe Trace‑Raten — das sind produktrelevante Hinweise, keine Garantie. Führen Sie reproduzierbare Lasttests durch, messen Sie Speicher‑ und I/O‑Metriken und protokollieren Sie die Konfigurationen. Nur so lässt sich die praktische Skalierbarkeit belegen.

Abschließend: Setzen Sie auf iteratives Monitoring. Beginnen Sie klein, heben Sie das Sampling an kritischen Stellen auf Voll‑Tracing und automatisieren Sie die Alerts. Dokumentieren Sie jede Änderung und die zugrundeliegende Hypothese — so verwandelt sich Observability von einem Reporting‑Tool in einem Steuerungsinstrument für sichere, nachvollziehbare KI‑Anwendungen.

Fazit

Opik kombiniert Tracing, Evaluationsmetriken und Integrationen so, dass lokale LLM‑Pipelines transparent und prüfbar werden. Colocated Models reduzieren Latenz und erlauben engere Kontrolle über Datenflüsse, während reproduzierbare Tests und LLM‑Judges die Qualitätsarbeit automatisieren. Entscheidend bleibt die institutionelle Disziplin: klare Policies, Sampling‑Regeln und wiederholbare Lasttests.

Praktischer Rat: Starte lokal, instrumentiere früh, messe kontinuierlich und validiere Skalenvorgaben selbst — erst die Messung macht die Entscheidung belastbar.

*Diskutieren Sie Ihre Erfahrungen in den Kommentaren und teilen Sie diesen Leitfaden in sozialen Netzwerken, wenn er Ihnen weiterhilft.*

Schreibe einen Kommentar