Schlagwort: Rechenzentrum

-

Souveräne KI: Warum immer mehr Firmen Modelle selbst betreiben wollen

Souveräne KI wird für viele Unternehmen zum Prüfstein, weil KI-Modelle plötzlich in Bereiche rutschen, die früher klar getrennt waren. in Kundendialoge, interne Dokumente, Quellcode und

AWS Cloud für Deutschland: Was sich für Nutzer jetzt ändert

Viele Menschen nutzen Cloud-Dienste, ohne es bewusst zu merken. Fotos, Videokonferenzen, Onlineshops oder auch interne Firmen-Tools laufen oft auf großen Rechenzentren. Mit der AWS Cloud

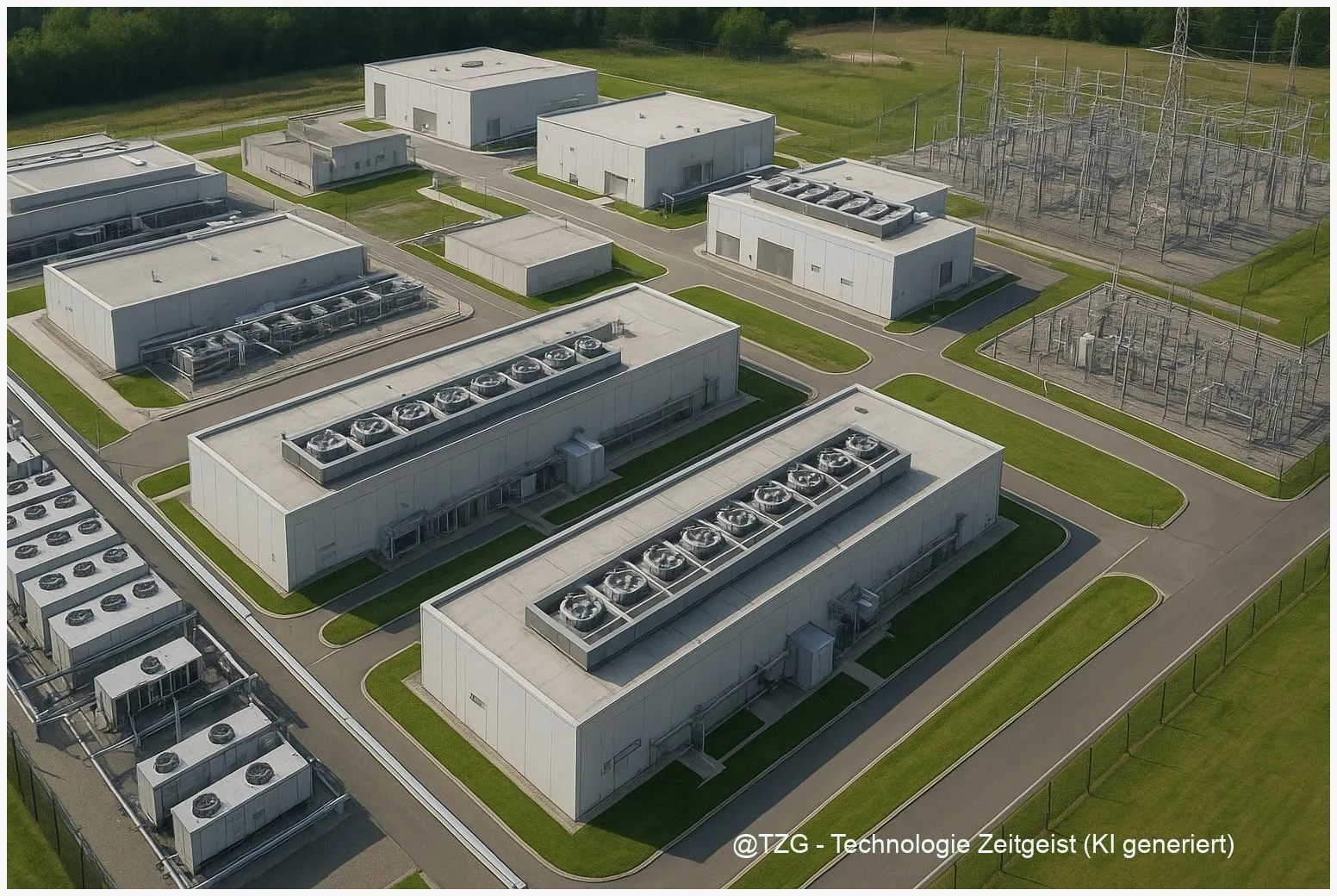

Warum KI‑Rechenzentren Milliarden kosten – und was das für Energie bedeutet

KI‑Rechenzentren sind heute ein zentraler Treiber für Nachfrage nach Strom, Kühlung und Infrastruktur. Dieses Abstract fasst zusammen, warum der Bau und Betrieb solcher Anlagen hohe

Warum KI‑Rechenzentren neue Verbindungen brauchen: Kupfer, Glasfaser, Funk

KI‑Rechenzentrum‑Netzwerke stoßen physikalisch an Grenzen: Kupferleitungen verlieren bei den hohen Frequenzen von modernen KI‑Interconnects rapide an Leistung, optische Verbindungen und Photonik bieten Reichweite und Bandbreite,

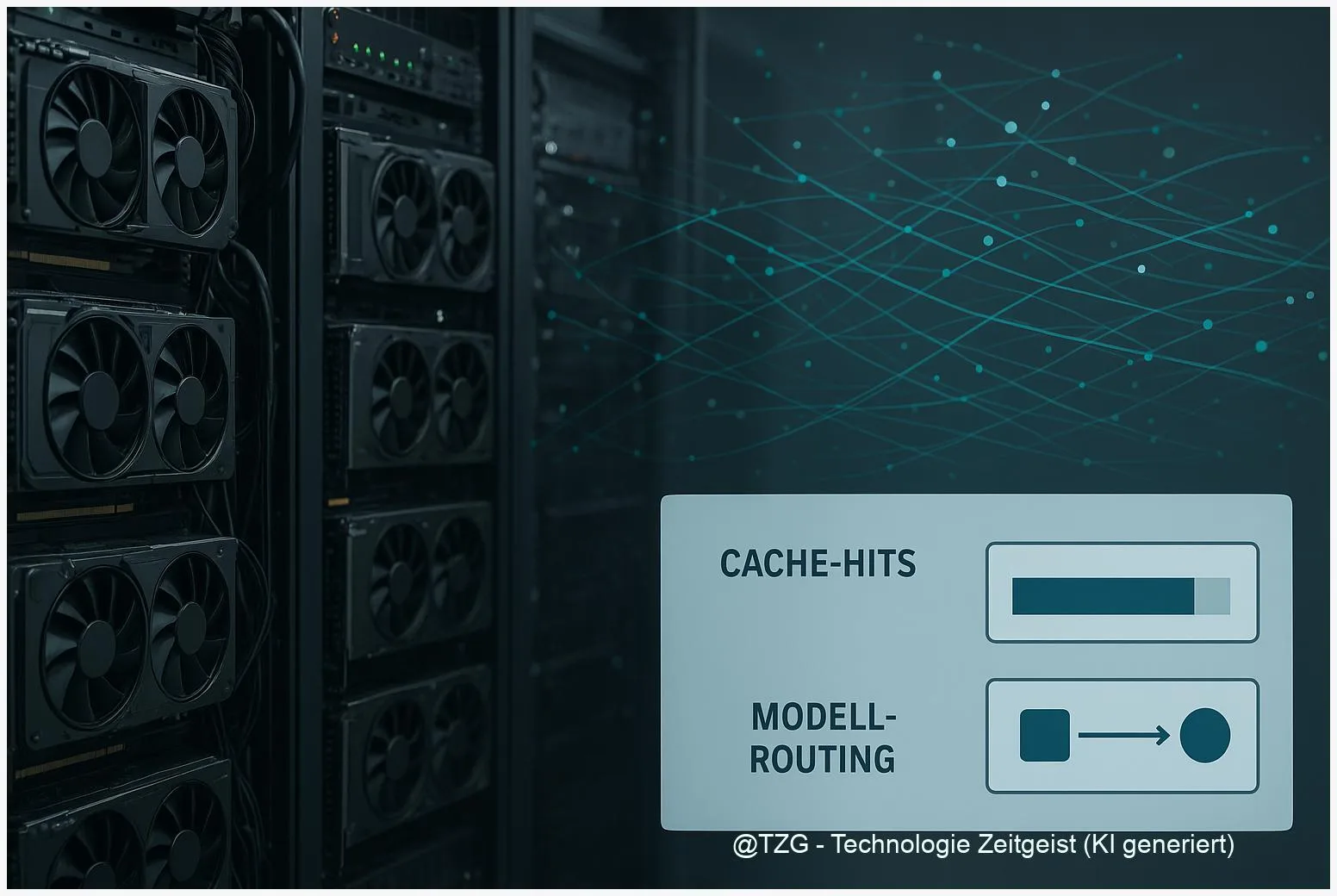

Warum GenAI in Produktion teuer wird – und wie Orchestrierung Kosten senkt

Generative KI in Produktion kann schnell hohe laufende Kosten verursachen – vor allem durch Inference-Aufwände, großes Kontextfenster und häufige Modellaufrufe. Dieses Stück zeigt, wie LLM

Wie viel Wasser verbraucht KI – und wie lässt sich der Fußabdruck senken?

Der Wasserverbrauch von KI ist vor allem ein Infrastrukturproblem: Beim Training großer Modelle und beim Betrieb beliebter Dienste fällt Kühlwasser in Rechenzentren an. Dieser Text

Rechenzentren kühlen ohne Wasserstress: Technik, Energie, Regeln

Rechenzentren Kühlung bestimmt zunehmend, wie nachhaltig Cloud‑Dienste und KI betrieben werden können. Dieser Text erklärt die wichtigsten Kühlmethoden, wie sie Wasser und Strom beanspruchen und

Boom der Rechenzentren: Warum Strombedarf, KI und Akzeptanz kollidieren

Rechenzentren Stromverbrauch ist längst kein rein technisches Thema mehr: Mit dem Wachstum von Cloud‑Diensten und KI steigt der Strombedarf sichtbar an und trifft auf begrenzte

Data‑Center‑Boom 2025: Wie KI den Energiebedarf in Europa antreibt

Europas Rechenzentren erleben einen beschleunigten Ausbau: Rechenzentren Ausbau 2025 treibt den Strombedarf spürbar. 2024 lag der geschätzte Verbrauch in Europa bei rund 96 TWh, etwa 3 %

Rechenzentren auf dem Vormarsch: Warum Strom, Klima und Akzeptanz kollidieren

Rechenzentren Energieverbrauch ist ein zentrales Thema für die digitale Infrastruktur Europas: Der Strombedarf großer Serverparks wächst, die Netze geraten lokal unter Druck und Anwohnerinnen und

KI‑Boom verursacht so viel CO₂ wie eine Großstadt — was Europa tun muss

In den aktuellen Abschätzungen fallen die KI CO2-Emissionen 2025 in eine Größenordnung, die mit der Emission einer großen Stadt vergleichbar ist. Dieser Text ordnet die

Der ökologische Fußabdruck der KI: 2025 so viel CO2 wie New York City

Im Jahr 2025 zeigen Analysen, dass die KI CO2-Emissionen 2025 in einer Größenordnung liegen könnten, die mit den jährlichen Emissionen einer großen Stadt vergleichbar ist.

KI‑Rechenzentren und steigende Stromkosten: Was Europa jetzt tun muss

KI Rechenzentren sind heute einer der treibenden Faktoren für wachsenden Strombedarf in Europa. In diesem Text wird erklärt, warum Rechenzentren für KI besonders viel Energie

Rechenzentren und Wasserknappheit: Lektionen aus den Great Lakes für Europa

Der wachsende Rechenzentren Wasserverbrauch steht zunehmend im Spannungsfeld mit knapper werdenden lokalen Wasserressourcen. Dieser Text ordnet Erkenntnisse aus der Great‑Lakes‑Region ein und zeigt, welche technischen,

Langzeitspeicher für KI‑Rechenzentren: Wie neue Batterien Energie planbar machen

Langzeitspeicher Rechenzentrum sind Schlüssel, damit große Rechenzentren Strom über Stunden oder Tage planbar vorhalten können. Dieses Abstract nennt die zentralen Vorteile: neue Zellformate mit hoher