Roboterethik prägt autonome Systeme und Industrie. Wie Unternehmen moralische KI effektiv integrieren, lesen Sie hier. Jetzt informieren und mitgestalten!

Inhaltsübersicht

EinleitungEthische Prinzipien: Grundpfeiler autonomer Systeme

Moralische KI im Praxistest: Wirtschaft und Regulierung

Gesellschaftliches Vertrauen: Der Schlüssel zur Akzeptanz

Die Zukunft ethischer Roboter: Testläufe und Ausblick

Fazit

Einleitung

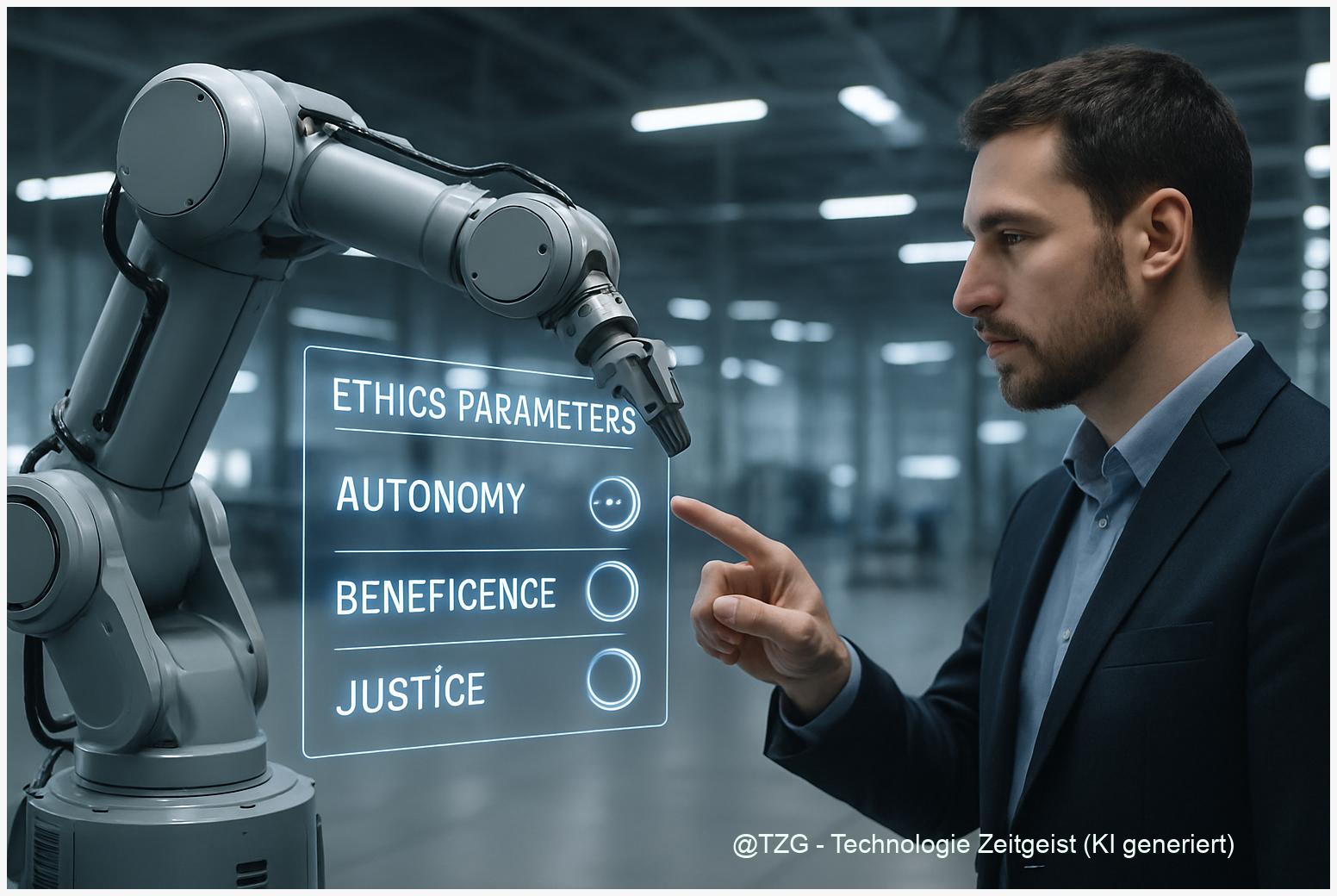

Autonome Roboter übernehmen immer komplexere Aufgaben in Industrie, Mobilität und Alltag. Doch wie treffen diese Maschinen moralische Entscheidungen – und wer legt die Regeln fest? Roboterethik wird zunehmend zum entscheidenden Faktor für Akzeptanz, Rechtssicherheit und nachhaltige Wertschöpfung. In diesem Artikel beleuchten wir technologiegetrieben die neuen ethischen Prinzipien, regulatorische Standards und die technische Umsetzung moralischer Entscheidungsmechanismen. Wir analysieren, wie Unternehmen mit den Herausforderungen globaler KI-Governance umgehen, und wie das gesellschaftliche Vertrauen in autonome Systeme gemessen wird. Abschließend werfen wir einen spannenden Blick auf neue Methoden, um moralische Grenzen von Robotern zu testen, und diskutieren Chancen und Risiken für Gesellschaft und Wirtschaft bis 2050. Wer ethische Roboter verstehen will, findet hier Fakten, Einordnung und Impulse für die nächste Innovationswelle.Ethische Prinzipien: Grundpfeiler autonomer Systeme – Standards, Praxis und Kontroversen

Roboterethik ist 2024 der Kompass für autonome Systeme, die immer öfter in sensiblen Bereichen wie Medizin und Industrie eingesetzt werden. Die Frage, wie KI ethisch handeln soll, ist längst nicht mehr nur akademisch: Sie entscheidet darüber, ob Vertrauen, Sicherheit und gesellschaftliche Akzeptanz wachsen oder schwinden.

Internationale Standards: IEEE, ISO & EU-Leitlinien

Globale Standards prägen die Roboterethik. Die EU-Leitlinien für vertrauenswürdige KI fordern Transparenz, Datenschutz und Nachvollziehbarkeit für alle autonomen Systeme. IEEE 7000 adressiert die Integration ethischer Werte in Technikentwicklung, während ISO 13482 explizit Sicherheitsanforderungen für persönliche Assistenzroboter festlegt. In der Praxis verpflichten sich Unternehmen, KI-Algorithmen so zu entwickeln, dass diese Fairness, Sicherheit und Rückverfolgbarkeit gewährleisten (evoluce.de).

Von Prinzipien zur Praxis: Medizin & Industrie

- Medizinische Robotik: Moralische Leitlinien wie „do no harm“ werden technisch durch Risikomanagement und Echtzeitüberwachung realisiert. Ein Beispiel: KI-basierte OP-Roboter dokumentieren jede Entscheidung, damit sie im Schadensfall transparent nachvollziehbar bleibt (Studysmarter).

- Industrieroboter: Kollaborative Roboter („Cobots“) müssen sicher mit Menschen interagieren. ISO-Standards schreiben maximale Kraft und Not-Aus-Funktionen vor. Unternehmen implementieren Ethik-Boards und Audit-Prozesse, um Compliance und gesellschaftliche Verantwortung zu sichern (Number Analytics).

Gesellschaftliche Relevanz und offene Fragen

Roboterethik ist mehr als technische Pflicht: Sie entscheidet, wem wir Kontrolle und Verantwortung übertragen. Kontroverse Fälle – wie autonome Fahrzeuge im Dilemma zwischen Insassen- und Fußgängerschutz – zeigen die Grenzen aktueller Regeln. Für Unternehmen bleiben Fragen nach Haftung, dynamischer Anpassung der Standards und der praktischen Umsetzung moralischer KI ungelöst (evoluce.de).

Im nächsten Kapitel untersuchen wir, wie moralische KI im Praxistest Wirtschaft und Regulierung herausfordert – und welche „Best Practices“ sich für Unternehmen abzeichnen.

Moralische KI im Praxistest: Wirtschaft, Regulatorik und neue Standards im Wettbewerb

Roboterethik ist längst zum Prüfstein für die industrielle Praxis geworden: Unternehmen stehen 2024 vor der Herausforderung, moralische KI-Mechanismen nicht nur zu entwerfen, sondern skalierbar und regelkonform in autonome Systeme zu integrieren. Wie bei klassischen Sicherheitstests, bei denen Bremswege oder Not-Aus-Funktionen geprüft werden, verlangen Regulierungen nun auch nachvollziehbare und erklärbare Entscheidungsfindungen von KI-gesteuerten Robotern.

KI-Ethik im industriellen Einsatz: Use Cases & Herausforderungen

In der Fertigung regeln Ethik-Boards, wie autonome Systeme auf Störungen oder potenzielle Unfälle reagieren. In der Logistik müssen KI-gesteuerte Roboter Lieferentscheidungen nach Fairness und Sicherheit abwägen – ein Spagat zwischen Effizienz (z. B. Just-in-Time-Lieferung) und ethischen Standards. Die Automobilindustrie testet Explainable AI, um die Entscheidungen autonomer Fahrzeuge auf Audits und Compliance-Prüfungen vorzubereiten. Ein Beispiel: Mobile Roboter von ABB oder KUKA werden regelmäßig auf ethische Algorithmus-Updates und Revisionssicherheit geprüft.

Regulatorik, Business Cases und globale Unterschiede

- Regulierung: Der EU AI Act fordert Risikobewertungen, Dokumentationspflichten und Auditierbarkeit für KI-Systeme. In den USA und China setzen Unternehmen auf branchenspezifische Selbstregulierung, was zu internationalen Compliance-Konflikten führt.

- Business Cases: Firmen mit robusten Ethik- und Auditprozessen gewinnen schneller Partner und Kunden. Investitionen in Explainable AI und Ethik-Boards können sich auszahlen, da sie rechtliche Risiken und Imageschäden minimieren.

- Skalierung: Multinationale Unternehmen passen Roboterethik-Standards flexibel an lokale Gesetzeslagen an – dies erfordert interdisziplinäre Teams und kontinuierliche Weiterbildung.

Innovative Ansätze wie KI-Audits, interdisziplinäre Ethik-Boards und die Integration von Explainable AI sind Treiber für Vertrauen und globale Wettbewerbsfähigkeit. Dennoch bleibt die Definition von “Moral” für KI kulturell umstritten und verlangt nach dynamischer Anpassung.

Im nächsten Kapitel analysieren wir, wie gesellschaftliches Vertrauen zum Schlüssel für die Akzeptanz autonomer Systeme wird – und welche Kommunikationsstrategien Unternehmen nutzen.

Gesellschaftliches Vertrauen: Der Schlüssel zur Akzeptanz autonomer Systeme

Ob autonome Fahrzeuge, Industrieroboter oder KI-basierte Diagnosesysteme – das gesellschaftliche Vertrauen in Roboterethik entscheidet, ob technologische Innovationen angenommen werden. Laut einer EU-Umfrage (2023) stufen 61 % der Bürger fehlende Transparenz und mangelnde Kontrolle als größte Hürde für die Akzeptanz autonomer Systeme ein (EU-Kommission).

Wie Wissenschaftler Vertrauen messen

Forschungsinitiativen wie das Trustworthy Autonomous Systems Hub (UK) oder das DFG-Projekt “Vertrauen in autonome Systeme” setzen auf kombinierte Methoden: Online-Umfragen, Labor-Pilotstudien und Feldexperimente. Eine häufig genutzte Skala ist das “Trust in Automation Questionnaire” (TAQ), das Faktoren wie Vorhersehbarkeit, Erklärbarkeit und Fehlerkultur abbildet. In der Industrie werden Nutzerfeedback, Akzeptanzraten und Incident-Reporting als harte Kennzahlen eingesetzt. Beispiel: In einem Pilotprojekt der Deutschen Bahn mit autonomen Shuttles gaben 78 % der Testpersonen an, sich mit “transparenter Kommunikation über Algorithmen und Sicherheitsmaßnahmen” sicherer zu fühlen (DB Forschungsbericht).

Algorithmische Verantwortung und ethische Normen

Unter algorithmischer Verantwortung versteht man die Pflicht, dass KI-Algorithmen nachvollziehbar, fair und im Einklang mit gesellschaftlichen Werten agieren. Technisch werden hierfür Explainable-AI-Ansätze, Audit-Trails und Bias-Checks genutzt. So schreibt die EU KI-Verordnung (AI Act) vor, dass jede autonome Entscheidung dokumentiert und im Streitfall rückverfolgbar sein muss.

Gesellschaftliche und wirtschaftliche Auswirkungen

- Akzeptanz: Studien zeigen: Steigt das Vertrauen, steigen Nutzungsraten und Innovationsgeschwindigkeit.

- Haftung: Klare Algorithmen-Dokumentation verringert juristische Grauzonen und erleichtert die Zuordnung von Verantwortung.

- Wahrnehmung: Öffentliche Pilotprojekte und offene Kommunikation stärken das Image und senken Markteintrittsbarrieren für neue KI-Anwendungen.

Im nächsten Kapitel blicken wir auf die Zukunft ethischer Roboter: Testläufe, internationale Benchmarks und die Frage, wie sich gesellschaftliche Anforderungen weiterentwickeln werden.

Die Zukunft ethischer Roboter: Testläufe, Risiken und Handlungsempfehlungen

Die Roboterethik steht vor einer neuen Bewährungsprobe: Je autonomer KI-Systeme werden, desto wichtiger ist die technische Überprüfung moralischer Leitplanken. Entwickler simulieren dazu ethische Dilemmata – etwa, wie ein Assistenzroboter zwischen zwei schädlichen Optionen abwägen soll. Solche Simulationen reichen von Software-Tests über physische Prototypen bis zu großangelegten Pilotprojekten.

Methoden: Ethik-Sandbox und globale Wettbewerbe

Führende Forschungslabore und Unternehmen setzen auf Ethik-Sandboxes: kontrollierte digitale Testumgebungen, in denen autonome Systeme mit Grenzfällen und moralischen Konflikten konfrontiert werden. Internationale Wettbewerbe wie der RoboCup@Home oder die Ethics in AI Challenge bringen Entwickler und Ethiker zusammen, um Standards für faire und sichere KI-Entscheidungen zu entwickeln (RoboCup@Home). Hier werden Algorithmen nicht nur auf Effizienz, sondern gezielt auf ethisches Verhalten geprüft.

Chancen, Risiken und Fehlermöglichkeiten

- Chancen: Systematische Tests fördern robuste, vertrauenswürdige autonome Systeme – und helfen, gesellschaftliche Akzeptanz zu stärken.

- Risiken: Simulierte Dilemmata decken nicht alle realen Szenarien ab; Fehlannahmen in der Sandbox oder kulturell geprägte Ethik-Definitionen können zu unerwünschten Nebenwirkungen führen.

- Fehlermöglichkeiten: Algorithmen könnten in komplexen Alltagssituationen versagen, wenn Trainingsdaten oder Testumgebungen zu eng gefasst sind.

Ausblick: Entwicklung bis 2030/2050 und Empfehlungen

Bis 2030 werden verbindliche EU-Standards und ISO-Normen für ethische KI erwartet. Unternehmen müssen verstärkt interdisziplinäre Teams für Ethik-Tests aufbauen und ihre Auditprozesse ausweiten. Forschung sollte die Vielfalt realer Lebenssituationen stärker abbilden. Für die Politik gilt: Förderung internationaler Standards und Investitionen in offene Ethik-Testumgebungen sind entscheidend, um Innovation und gesellschaftliche Sicherheit gleichermaßen zu sichern.

Das nächste Forschungsfeld: Wie können ethische Prüfverfahren automatisch skaliert und in den globalen KI-Regelbetrieb integriert werden?

Fazit

Ethische Entscheidungsmechanismen sind der Schlüssel für nachhaltige Roboterintegration. Unternehmen und Politik müssen gemeinsam Standards weiterentwickeln, technische Lösungen evaluieren und das gesellschaftliche Vertrauen stärken. Bis 2050 können ethisch ausgelegte autonome Systeme unsere Wirtschaft und Gesellschaft spürbar resilienter und gerechter machen – sofern Chancen und Risiken konsequent adressiert werden.Diskutieren Sie mit Experten und gestalten Sie ethische Robotik aktiv mit – Ihr Wissen zählt!

Quellen

Roboterethik: Beeinflussen Maschinen moralische EntscheidungenEthik der Robotermedizin: Herausforderungen & Prinzipien

Navigating Industrial Ethics in Robotics

KI und Moral: Wie Unternehmen Verantwortung übernehmen (KIT)

EU AI Act und seine Folgen für die Industrie (PwC)

Ethik-Boards und Explainable AI in der Praxis (UrbanLogiq)

Ethics guidelines for trustworthy AI (EU-Kommission)

Autonomes Fahren: DB baut Forschung aus (Deutsche Bahn)

Trustworthy Autonomous Systems Hub (UKRI)

RoboCup@Home – Offizielle Website

Testing Ethical Boundaries in Autonomous Systems (Nature AI)

Ethics Sandboxes for AI – UK Government Report

Hinweis: Für diesen Beitrag wurden KI-gestützte Recherche- und Editortools sowie aktuelle Webquellen genutzt. Alle Angaben nach bestem Wissen, Stand: 7/23/2025

Schreibe einen Kommentar