Prompt Engineering ist die Kunst, Eingaben an große Sprachmodelle so zu formulieren, dass die Antworten präzise, nützlich und verlässlich sind. Dieses Stück erklärt nachvollziehbar, warum klar formulierte Prompts Zeit sparen, bessere Ergebnisse liefern und Fehler reduzieren können. Leserinnen und Leser erhalten praktische Beispiele, typische Fehlerquellen und erprobte Strategien — vom einfachen Instruktionssatz bis zu Retrieval‑basierten Abläufen — und lernen, wie sich die Arbeit mit Prompts in Organisationen systematisch messen lässt.

Einleitung

Wenn Chat‑Assistenten unpräzise Antworten liefern, Code fehlerhaft erzeugt wird oder Fakten fehlen, liegt das häufig weniger am Modell als an der Eingabe. Prompts sind die Schnittstelle zwischen Mensch und Modell: ein kurzer Text, in dem der gewünschte Stil, Umfang und die Aufgabe beschrieben werden. Wer klare Prompts nutzt, spart Zeit: weniger Nachfragen, weniger Korrekturen, bessere Automatisierung.

Im Alltag zeigt sich der Effekt überall: Beim Verfassen einer E‑Mail‑Vorlage, beim Generieren von Code‑Snippets oder bei der Suche nach validen Quellen. Für Organisationen bedeutet das: wer Prompting systematisch angeht, erhöht Produktivität und Zuverlässigkeit. Dieser Text führt Schritt für Schritt durch die Grundlagen, zeigt praktische Vorlagen und benennt typische Risiken und sinnvolle Gegenmaßnahmen.

Grundlagen: Was ist Prompt Engineering?

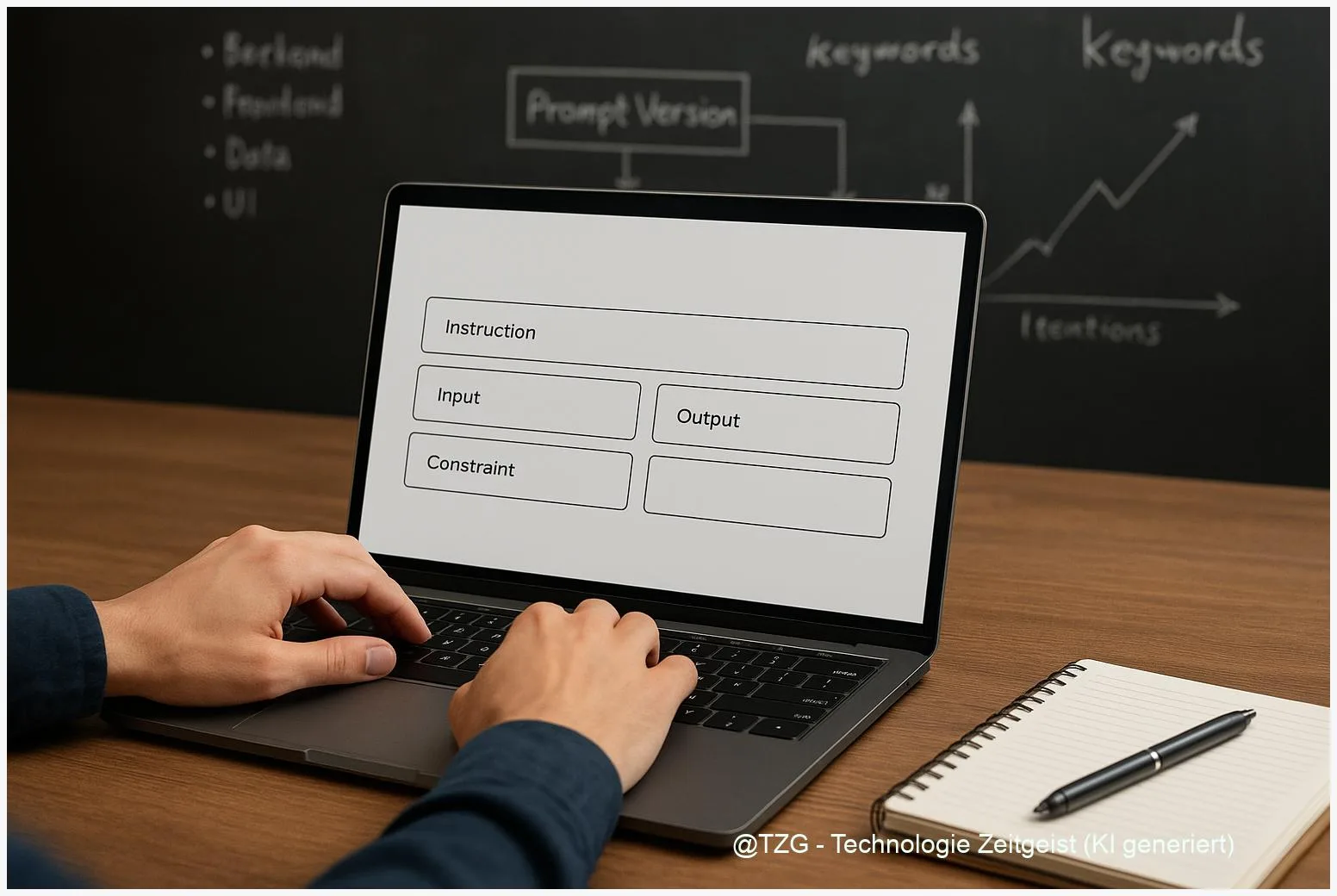

Prompt Engineering beschreibt das bewusste Formulieren und Testen von Eingaben an Sprachmodelle, sodass die Ausgaben eine gewünschte Form, Genauigkeit und Lesbarkeit erreichen. Ein Prompt kann eine kurze Anweisung sein („Schreibe ein kurzes Feedback“) oder eine strukturierte Vorlage mit Beispielen (sogenanntes few‑shot prompting). Ziel ist, Verhalten des Modells zu steuern, ohne das Modell selbst umzubauen.

Vereinfacht gesagt: ein Modell reagiert auf Wahrscheinlichkeiten. Durch präzise Instruktionen, Beispiele und Kontext lässt sich die Wahrscheinlichkeit gewünschter Antworten erhöhen. Manche Techniken funktionieren auffällig gut erst bei sehr großen Modellen; andere helfen unabhängig von Modellgröße.

Genaue Anweisungen und passende Beispiele reduzieren Fehlinterpretationen und machen die Ausgabe reproduzierbarer.

Wesentliche Prompt‑Strategien im Überblick:

| Merkmal | Beschreibung | Wert |

|---|---|---|

| Direkte Instruktion | Einfache Aufgaben mit klarer Anweisung | Kurz, deterministisch |

| Few‑shot | Beispiele im Prompt, um gewünschtes Format zu zeigen | Hilfreich bei komplexen Mustern |

| Chain‑of‑Thought (CoT) | Explizite Zwischenschritte erlauben mehrstufiges Denken | Stärker bei großen Modellen |

Hinweis zur Forschung: Die CoT‑Technik wurde in frühen Arbeiten (etwa 2022) beschrieben und zeigte besonders bei sehr großen Modellen erhebliche Leistungszuwächse. Diese Studien sind älter als zwei Jahre und bleiben dennoch eine wichtige Referenz für mehrstufiges Reasoning.

Prompting im Alltag: Beispiele und Vorlagen

Konkrete Prompts machen den Unterschied. Ein paar leicht anpassbare Vorlagen für typische Aufgaben helfen sofort:

E‑Mail‑Entwurf (konkret & knapp): “Formuliere eine freundliche, 3‑Satz Antwort auf eine Lieferverzögerung, betone Entschuldigung und nenne ein neues Lieferdatum.”

Code‑Snippets prüfen: “Prüfe folgenden Python‑Code auf Syntax‑ und Logikfehler und benenne maximal drei Änderungen.”

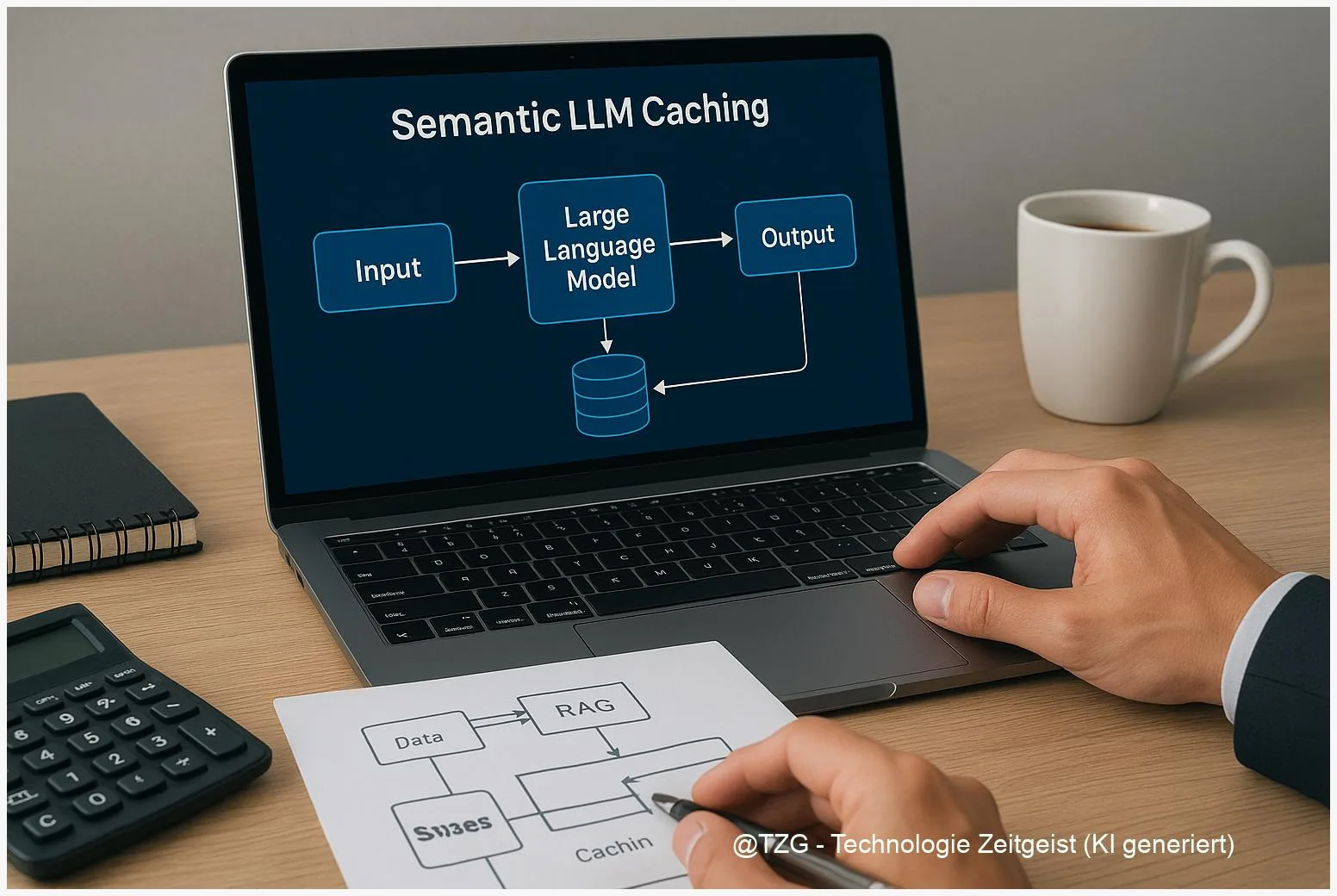

Recherche mit Quellenprüfung: Kombinieren Sie Retrieval (Embeddings/RAG) mit klaren Prüfregeln: das Modell liefert eine Kurzantwort plus die drei stärksten Quellen. Wird eine Quelle nicht verifiziert, soll das Modell “Quelle nicht bestätigt” ausgeben.

Ein praktischer Ablauf für zuverlässige Ergebnisse:

- Klare Instruktion: gewünschtes Format, Ton und Länge benennen.

- Kontext liefern: relevante Daten, Fakten, früherer Text.

- Beispiele geben: ein bis zwei Beispiele für das gewünschte Ergebnis.

- Verifikation einbauen: Prüfroutinen oder Tests definieren.

Für Aufgaben mit Faktenlage empfiehlt sich Retrieval‑Augmented Generation (RAG): externe Texte werden eingebunden, sodass das Modell nicht allein auf seinem internen Wissen basiert. Funktionale Schnittstellen (function‑calling) helfen, strukturierte Antworten zurückzugeben und externe Prozesse anzustoßen.

In Unternehmenskontexten können wiederverwendbare Prompt‑Templates als Bausteine dienen. Diese Vorlagen werden versioniert und in A/B‑Tests geprüft, sodass kleine Formulierungsänderungen messbar werden.

Chancen und Risiken beim Prompting

Prompting schafft Effizienz: Routineaufgaben lassen sich automatisieren, Texte schneller erstellen und Antworten personalisieren. In Kombination mit Retrieval und Funktionen steigt die Faktentreue. Aus Sicht von Teams bedeutet das: weniger manuelle Nacharbeit, schnellere Iteration und bessere Skalierbarkeit.

Risiken bestehen jedoch weiterhin. Modelle halluzinieren gelegentlich Fakten, liefern inkonsistente Begründungen oder reproduzieren Verzerrungen aus Trainingsdaten. Solche Fehler sind oft nicht allein durch eine einzige bessere Formulierung zu beseitigen.

Gängige Gegenmaßnahmen sind:

- Retrieval und Quellen‑Beilage, um Fakten extern zu prüfen.

- Automatisierte Evals und A/B‑Tests, um Änderungseffekte messbar zu machen (Beispiel‑Richtwerte: ≈10 / ≈100 / ≈1 000 / ≈10 000 Beispiele, je nach gewünschter Nachweisstärke).

- Prompt‑Versionierung, Rollback‑Mechanismen und menschliche Review‑Schleifen bei sicherheitskritischen Ergebnissen.

Ein weiterer Aspekt ist Datenschutz: Prompts dürfen keine sensiblen personenbezogenen Daten enthalten, wenn das System nicht entsprechend gesichert ist. Governance‑Regeln sollten regeln, welche Informationen in Prompts erlaubt sind und wann zusätzliche Prüfungen nötig sind.

Zusammenfassend bieten Prompting‑Techniken große Vorteile, erfordern aber strukturierte Tests und verantwortungsvolle Prozesse, damit die Antworten zuverlässig und vertrauenswürdig bleiben.

Blick nach vorn: Entwicklung und Praxis

Prompt Engineering wird sich weiter professionalisieren. Erwartbar sind spezialisierte Tools zur Versionsverwaltung von Prompts, automatisierte Evaluationspipelines und eine stärkere Integration von Retrieval‑Systemen. Gleichzeitig entstehen neue Rollen: Prompt‑Designerinnen und Prompt‑Analytiker, die Vorlagen pflegen, Effekte messen und Governance‑Regeln überwachen.

Technisch ist mit einer stärkeren Verzahnung von LLMs und spezifizierten Funktionen zu rechnen: Modelle geben strukturierte Antworten, externe Dienste verifizieren Fakten und Fallback‑Logiken reduzieren Halluzinationen. Für Nutzerinnen und Nutzer bedeutet das: die Interaktion wird präziser, aber auch technischer — Templates und kuratierte Bausteine helfen, Komplexität zu verbergen.

Für kleinere Teams lohnt es sich, früh einfache Standards einzuführen: eine Prompt‑Bibliothek mit klaren Namensschemata, minimale Testabdeckung (z. B. 100 Beispiele für grobe Wirkungsindikatoren) und definierte Reviews bei Änderungen. So bleibt Entwicklung nachvollziehbar und Änderungen bleiben messbar.

Langfristig könnten Werkzeuge automatische Prompt‑Optimierung anbieten — mit Vorsicht: automatisches Tuning muss immer mit menschlicher Überprüfung kombiniert werden, um unbeabsichtigte Nebenwirkungen zu erkennen.

Fazit

Gute Prompts sind kein Luxus, sondern die Voraussetzung für zuverlässige KI‑Arbeit. Wer klare Instruktionen formuliert, Kontext liefert und systematisch testet, reduziert Fehler und erhöht den Nutzwert von KI‑gestützten Tools. Techniken wie few‑shot‑Beispiele oder Chain‑of‑Thought können helfen; besonders wirksam sind sie in Kombination mit Retrieval und automatischen Prüfungen. Für Teams empfiehlt sich ein pragmatisches Vorgehen: einfache Standards schaffen, Vorlagen versionieren und Änderungen messen. So bleibt die Arbeit mit Sprachmodellen kontrollierbar und nützlich.

Wenn Sie Gedanken oder Erfahrungen zu Prompts haben, teilen Sie diese gern in den Kommentaren oder per Social Share.

Schreibe einen Kommentar