Einleitung

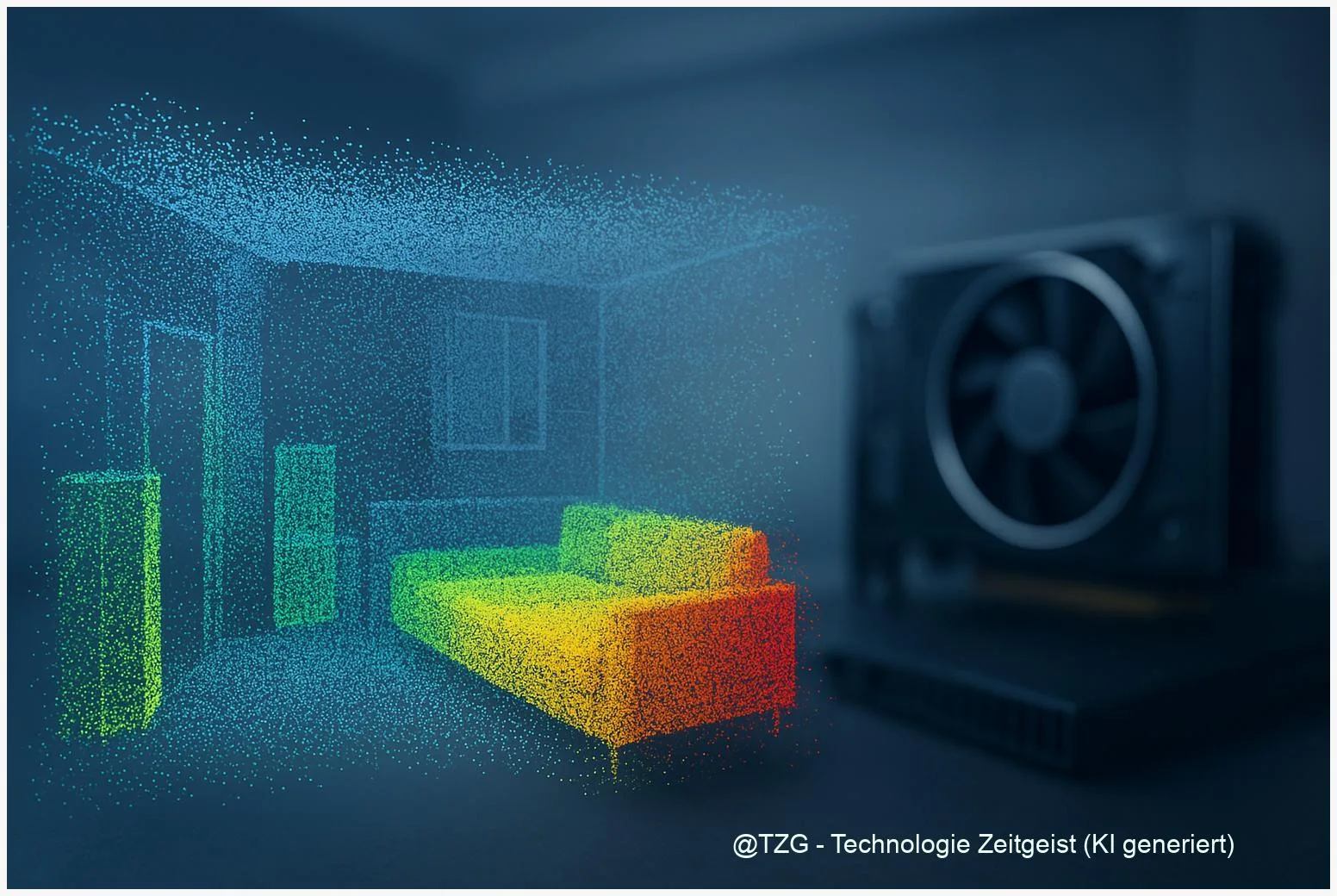

3D‑Segmentierung ist Grundlage für Anwendungen wie Innenraum‑Mapping, autonomes Fahren oder AR‑Anwendungen. Typische Eingaben sind Punktwolken oder Voxel‑Raster, und konventionelle 3D‑Netze verarbeiten oft große, weitgehend leere Volumen. Das kostet Zeit und Rechenressourcen, gerade wenn hohe räumliche Auflösung gefragt ist. Sparse‑Convolutions umgehen dieses Problem, indem sie nur die vorhandenen Punkte rechnen. Für Praktikerinnen und Praktiker stellt sich daher die Frage: Wann lohnt sich der Umstieg, welche Engine wähle ich, und wie messe ich echten Nutzgewinn?

Dieser Text ordnet die Technik sachlich ein, zeigt konkrete Beispiele aus Forschung und Praxis und nennt Messgrößen für kontrollierte Vergleiche. Die Fundamente bleiben auch in einigen Jahren relevant: Die grundlegende Dreieinigkeit aus Daten‑Sparsity, Kernel‑Implementierung und Hardware entscheidet langfristig über den Nutzen.

Wie sparse Convolutions funktionieren

Bei sparse Convolutions wird die Eingabe nicht als dichtes Gitter aus Werten, sondern als Liste belegteter Zellen (Coordinates) mit zugehörigen Merkmalen repräsentiert. Das Netz berechnet Faltungen nur dort, wo Daten vorhanden sind. Technisch entstehen sogenannte sparse Tensors, begleitet von Hash‑Tabellen oder Index‑Maps, die Nachbarschaften schneller auffindbar machen.

Sparse‑Ansätze sparen Rechenzeit, weil sie Leerräume nicht durchrechnen; der Aufwand verlagert sich aber auf effiziente Index‑ und Speicherverwaltung.

Die Methode hat zwei Seiten: Bei sehr sparsamen Szenen sind die Rechenersparnisse groß. Dichtere Szenen oder feine Voxel‑Grids können dagegen den Overhead der Indizierung auffressen. Weitere technische Unterschiede ergeben sich durch die Art der Kernel‑Implementierung: Hash‑basierte Lookups versus compiler‑generierte gebündelte Kernel, Kernel‑Fusion oder Spezialisierung für Nachbarschaftssuche.

Eine kompakte Gegenüberstellung in typischen Kriterien:

| Merkmal | Beschreibung | Wert |

|---|---|---|

| Datenstruktur | Sparse Tensor, Coordinate Lists | geringer Speicherbedarf bei sparsity |

| Kernel‑Pfad | Hash Lookup vs Codegen/Fusion | entscheidet über Geschwindigkeit |

Wie sich 3D‑Segmentierung beschleunigen lässt

Es gibt drei Hebel, um 3D‑Segmentierung beschleunigen zu können: effizientere Datenrepräsentation (sparse statt dicht), optimierte Implementierung der Faltungsoperatoren (Kernel‑Optimierung, Fusion, Compiler), und angepasste Betriebsparameter (Voxelgröße, Batch, Mixed‑Precision). Welcher Hebel am meisten bringt, hängt vom Datensatz und Ziel ab.

Bei Punktwolken mit vielen leeren Bereichen führt sparse Verarbeitung oft zu spürbar besserer GPU‑Auslastung und geringerer Inferenzzeit. Forschungsarbeiten zeigen, dass bibliotheken wie die MinkowskiEngine robuste, reproduzierbare Implementationen für generalized sparse Convolutions anbieten und damit in vielen Fällen bereits deutliche Vorteile bringen. Die ursprünglichen Vergleichswerte stammen aus einer Veröffentlichung von 2019; diese Angaben sind älter als zwei Jahre und sollten vor einer Entscheidung mit aktuellen Benchmarks verifiziert werden.

Parallel haben neuere Projekte (z. B. TorchSparse, TorchSparse++ und compiler‑basierte Ansätze wie TACO‑UCF) gezeigt, dass zusätzliche Optimierungen an der Kernel‑Generierung und Nachbarschaftsverwaltung die Performance weiter steigern können. Für ein Entwicklungsprojekt empfiehlt sich folgende Reihenfolge:

- Prototyp mit einer gut dokumentierten Engine (z. B. MinkowskiEngine) aufbauen.

- Kontrollierte Benchmarks: identische Datensätze, Voxelgröße, Batch‑Größe, HW und Messgrößen (Latency, Throughput, GPU‑Util, Memory).

- Vergleich mit alternativen Engines (TorchSparse / TorchSparse++) und ggf. compiler‑basierten Kernels, wenn Inferenz‑Durchsatz kritisch ist.

Typische Messmetrik: Samples pro Sekunde (throughput) und mittlere Latenz pro Szene. Wenn ein Modell für Echtzeit gedacht ist, zählt Latenz; bei Batch‑Inference zählt eher Throughput und Energieeffizienz.

Praxisbeispiele und Messwerte

Eine oft zitierte Studie zur MinkowskiEngine nennt auf dem ScanNet‑Datensatz eine mIoU von rund 72 % für ein typisches Modell (MinkowskiNet42, 2 cm Voxel). Diese Benchmark stammt aus dem Jahr 2019 und ist damit älter als zwei Jahre; sie zeigt allerdings die Größenordnung, in der sparse Ansätze konkurrenzfähig sind.

In Bezug auf Laufzeit dokumentierte das ursprüngliche Paper Einzelfälle mit reduzierter Inference‑Zeit durch temporale Bündelung (4D‑Variante). Neuere Arbeiten (2022–2023) berichten in mehreren Benchmarks, dass alternative Engines und compiler‑gestützte Kernel‑Generatoren in bestimmten Pfaden 2× bis 3× höhere Geschwindigkeiten erreichen können. Das bedeutet: MinkowskiEngine ist ein stabiler Ausgangspunkt, aber spezialisierte Kernel können bei hohem Durchsatzbedarf vorteilhafter sein.

Konkrete Praxisregel: Wenn Ihre Szenen über 80–90 % freie Räume aufweisen, ist die Chance hoch, dass sparse Convolutions gegenüber dichten Ansätzen Zeit und Speicher sparen. Bei kompakteren, dichten Szenen lohnt sich zuerst Optimierung an Voxelgröße, Mixed‑Precision und Batch‑Strategie.

Chancen, Risiken und Spannungsfelder

Chance: Sparse‑Methoden ermöglichen höhere räumliche Auflösung bei begrenzten Ressourcen, weil sie Leerräume nicht mitrechnen. Das ist für Innenraumerkennung, Roboter‑Perzeption oder Web‑AR sinnvoll, wenn detailreiche Oberflächen wichtig sind.

Risiko: Die Performance hängt stark von Implementationsdetails, Versionsstand und Hardware ab. Messungen aus Forschungsarbeiten können veraltet sein, wenn sich CUDA‑Versionen, GPU‑Architekturen oder Bibliotheken verändert haben. Deshalb sind Rebenchmarks mit dokumentierten Software‑Versionen unverzichtbar.

Spannungsfeld: Flexibilität versus Durchsatz. Bibliotheken wie MinkowskiEngine bieten Vielseitigkeit und sind gut gepflegt; compiler‑basierte Lösungen oder stark optimierte Engines erreichen oft besseren Inferenz‑Durchsatz, sind aber komplexer zu integrieren. Bei Forschung zählt oft Reproduzierbarkeit; bei Produktivbetrieb zählt stabiler, messbarer Durchsatz.

Fazit

Sparse‑Convolutions sind ein praktikabler Weg, um 3D‑Segmentierung beschleunigen zu können — besonders bei sehr sparsamen Eingaben und wenn hohe räumliche Auflösung benötigt wird. Die MinkowskiEngine bietet eine solide, gut dokumentierte Basis für Prototypen und Forschung, während neuere Engines und compiler‑basierte Kernel zusätzliche Performance‑Gains liefern können. Entscheidend ist eine kontrollierte Benchmark‑Strategie: gleiche Daten, gleiche Voxel‑Einstellung, identische Hardware und klare Metriken. Nur so lässt sich zuverlässig feststellen, welche Kombination aus Engine, Voxelgröße und Implementierung für ein konkretes Projekt den größten Nutzen bringt.

Wenn Sie Erfahrungen mit Benchmarks oder einer bestimmten Engine haben, teilen Sie Ihre Erkenntnisse und diskutieren Sie die Ergebnisse gern weiter.

Schreibe einen Kommentar