Mit der kurzfristigen Deaktivierung zentraler Grok-3-Funktionen steht xAI vor einem Wendepunkt. Für Unternehmen und Entwickler birgt dies Chancen und Risiken – denn der Schritt könnte eine neue Ära sicherer, autonomer KI-Agenten einläuten.

Inhaltsübersicht

Einleitung

Was genau wurde abgeschaltet? Die Technik hinter strukturierten Ausgaben und Funktionsaufrufen

Wer entschied – und warum gerade jetzt? Entscheidungsfindung bei xAI

Wie xAI mit Sicherheitslücken und Spekulationen umgeht

Was bedeutet dies für Markt und Unternehmen? Strategische Perspektiven und Zukunftsszenarien

Fazit

Einleitung

Plötzlich war Schluss: Am 26. Mai stoppte xAI im Grok-3-Modell zentrale Funktionen wie strukturierte Ausgaben und Funktionsaufrufe – bis dahin das Herzstück fortschrittlicher KI-Agenten. Diese drängende Maßnahme betrifft nicht nur Entwickler, sondern sorgt auch branchenweit für Unruhe. Was steckt wirklich hinter dieser Entscheidung? Zwischen Sicherheitslücken, technischer Weiterentwicklung und möglichen Vorbereitungen auf eine neue Agenten-Generation stehen viele Fragen im Raum. Dieser Artikel zerlegt die Hintergründe, analysiert die Folgen und zeigt, welche Weichen im Markt für autonome KI-Systeme jetzt gestellt werden.

Was genau wurde abgeschaltet? Die Technik hinter strukturierten Ausgaben und Funktionsaufrufen

Strukturierte Ausgaben: Schnittstelle zwischen KI und Wirklichkeit

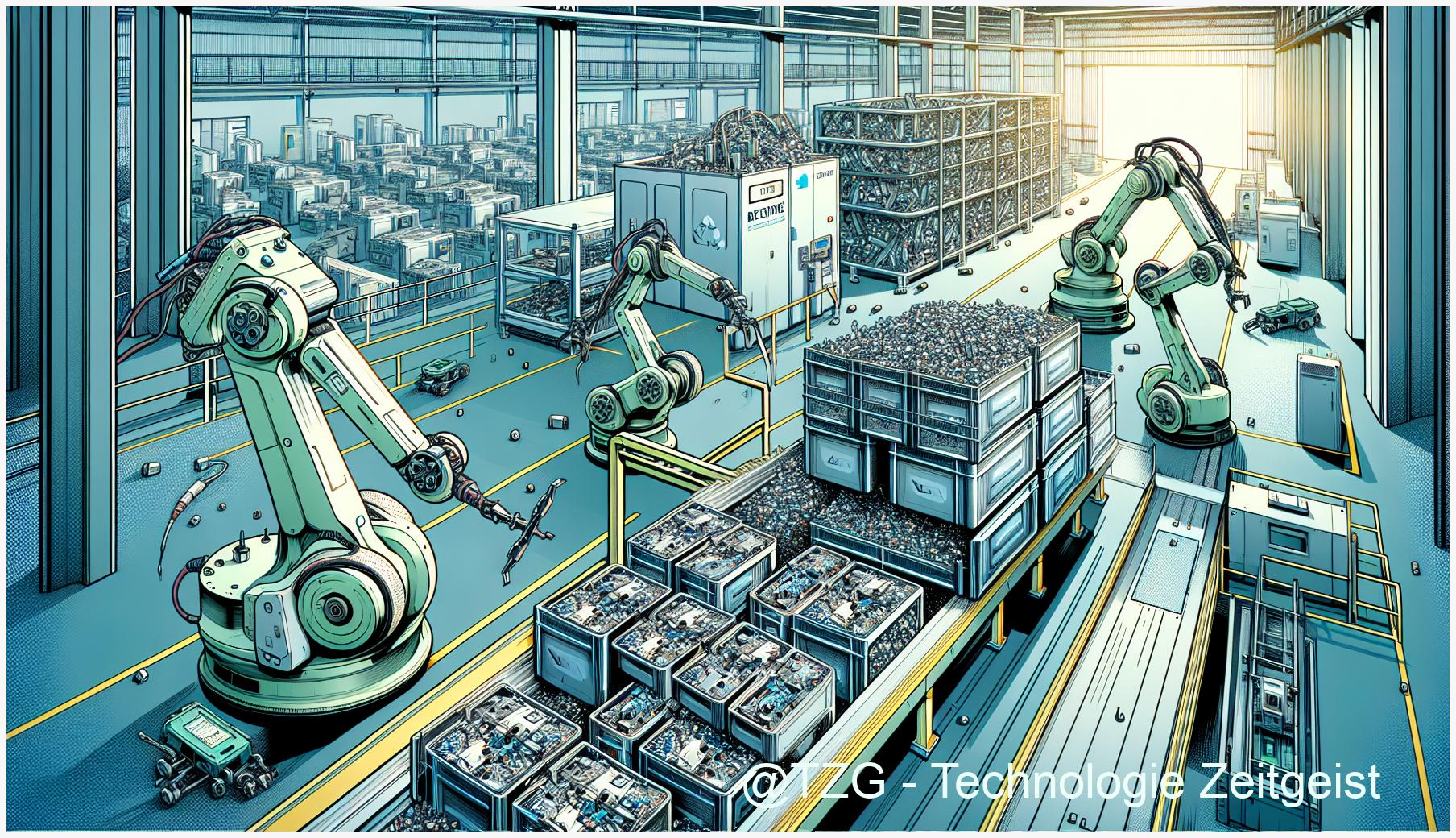

Strukturierte Ausgaben sind das Rückgrat moderner KI-Agenten. Einfach gesagt, liefern sie nicht bloß Fließtext, sondern geben Ergebnisse in vorher festgelegten Formaten aus – etwa als Listen, Tabellen oder JSON-Objekte. Das ist essenziell, damit Software, Services oder sogar Maschinen die Antworten eines Systems wie Grok-3 zuverlässig verarbeiten können. Erst dadurch lassen sich autonome Systeme flexibel steuern oder Aufgaben automatisieren. Im Alltag bedeuten strukturierte Ausgaben zum Beispiel, dass ein KI-Agent direkt Buchungen vornimmt, Datenbanken aktualisiert oder Produktionsdaten nahtlos zwischen Programmen austauscht.

Funktionsaufrufe: KI-Agenten, die handeln statt nur reden

Funktionsaufrufe gehen noch einen Schritt weiter. Grok-3 kann damit aktive Handlungen auslösen, indem der Agent bestimmte Software-Kommandos startet. Ein Beispiel: Ein Nutzer formuliert sein Ziel, Grok-3 übersetzt das in eine definierte Systemfunktion – wie das Planen eines Termins oder das Bestellen eines Produkts. Diese Brücke zwischen menschenähnlicher Kommunikation und echter Aktion macht KI-basierte Automatisierung skalierbar. Ohne Funktionsaufrufe bleibt künstliche Intelligenz auf reinen Dialog beschränkt.

Risiken und Auswirkungen der Abschaltung

Mit der Abschaltung dieser Funktionen verliert die Technologieplattform von xAI ihre operative Tiefe – zumindest vorübergehend. Unternehmen und Entwickler, die auf autonome KI-Agenten angewiesen sind, können damit plötzlich nicht mehr auf zentrale Automatisierungsprozesse zugreifen. Es geht nicht nur um Komfortverlust, sondern um einen realen Einschnitt in die KI-Entwicklung: Workflows stehen still, Projekte werden ausgebremst.

Die schnelle Deaktivierung – mutmaßlich durch eine Sicherheitslücke ausgelöst – wirft drängende Fragen zur KI-Sicherheit und den Mechanismen hinter dem Softwareupdate auf. Branchenweit beobachten Akteure die weiteren Schritte von xAI; ein Incident-Report steht aus. Klar ist: Die technische Disruption könnte ein Weckruf für neue Standards bei autonomen Systemen sein – heute kostet sie jedoch Produktivität und Vertrauen.

Wer entschied – und warum gerade jetzt? Entscheidungsfindung bei xAI

Die Hauptakteure hinter dem Kurswechsel

xAI ist kein anonymer Koloss – hinter der abrupten Deaktivierung der Grok-3-Schlüsselfunktionen stehen konkrete Teams und Köpfe. Maßgeblich beteiligt war laut Entwicklerstatements das KI-Sicherheitsteam, das interne Incident-Reports kontinuierlich auswertet. Die Verantwortung für die operative Entscheidung lag bei den leitenden Entwicklern der Grok-3-Technologieplattform, unterstützt von den Produktmanager:innen für autonome Systeme.

Wie Incident-Reports zur Handlung zwangen

Am 26. Mai startete eine Kettenreaktion: Ein offizieller Incident-Report meldete potenzielle Schwachstellen im Umgang mit strukturierten Ausgaben und Funktionsaufrufen. Diese Komponenten machen Grok-3 für KI-Agenten erst wirklich nützlich, da sie Aufgaben präzise ausführen und automatisierte Abläufe steuern können. Genau darin liegt jedoch das Risiko: Die hohe Autonomie erhöht die Angriffsfläche – ein klassischer Zielkonflikt zwischen Fortschritt in der KI-Entwicklung und der Sicherheit von autonomen Systemen.

Strategische Erwägungen und das Timing

Die Entscheidung, zentrale Funktionen zu stoppen, fällt selten spontan. Laut Entwicklerkreisen bündelte xAI technisches Risiko-Assessment und strategische Marktüberlegungen: Einerseits drohte eine Sicherheitslücke, die schnelle Reaktionsbereitschaft erforderte. Andererseits deutet der Zeitpunkt auf vorbereitende Maßnahmen für ein umfangreicheres Softwareupdate und womöglich eine neue Generation KI-Agenten hin. Im Kern setzte xAI damit ein Signal: KI-Sicherheit hat in der KI-Entwicklung Priorität – auch wenn das einen gravierenden Einschnitt für Nutzerinnen und Entwickler der Technologieplattform bedeutet.

Wie xAI mit Sicherheitslücken und Spekulationen umgeht

Am 26. Mai informierte xAI seine Nutzer auf gewohnt direktem Weg: Über die Entwickler-Channels und Plattform-Status-Seiten wurde die Abschaltung wesentlicher Grok-3-Funktionen – darunter strukturierte Ausgaben und Funktionsaufrufe – kommuniziert. Die Sprache war nüchtern, die Begründung: Überprüfung potenzieller Sicherheitslücken. Offizielle Incident-Reports blieben im Detail vage, nannten aber als Auslöser einen „ungewöhnlichen Systemzustand“. Für die Entwickler, die auf die automatisierten Fähigkeiten von Grok-3 bauen, kam das praktisch über Nacht.

Die Community reagierte prompt. Auf Diskussionsforen wurden Logs verglichen und Workarounds diskutiert – viele befürchteten, dass sich grundlegende Paradigmen der KI-Entwicklung bald verändern könnten. Während manche in dem Schritt ein reines Softwareupdate für die bestehende Technologieplattform vermuten, verdichten sich Hinweise, dass xAI bereits an einer neuen Architektur für autonome KI-Agenten arbeitet.

Gerade das Risiko durch potenzielle Sicherheitslücken scheint der treibende Faktor gewesen zu sein. Das offene Eingeständnis möglicher Schwachstellen seitens xAI ist eher untypisch für das Unternehmen – und wurde in der Branche sowohl als Zeichen gestiegener KI-Sicherheit als auch als Hinweis auf größere Umwälzungen gelesen.

Was kommt als Nächstes? Spekulationen drehen sich um sichere Schnittstellen für Agenten, bessere Kontrolle über strukturierte Ausgaben und neue Protokolle für Funktionsaufrufe. Damit könnten autonome Systeme in kritischen Anwendungen widerstandsfähiger und transparenter werden – und die gesamte Branche in eine Phase tiefgreifender Entwicklung eintreten.

Was bedeutet dies für Markt und Unternehmen? Strategische Perspektiven und Zukunftsszenarien

Spontaner Stillstand, neue Spielregeln

xAI hat mit dem abrupten Abschalten zentraler Grok-3-Features am 26. Mai mehr als nur Technik gestoppt: Von jetzt auf gleich fielen strukturierte Ausgaben und Funktionsaufrufe weg – zwei Grundpfeiler, auf denen eigenständig handelnde KI-Agenten bisher gebaut wurden. Unternehmen, die im täglichen Betrieb auf diese Technologieplattform setzten, geraten in Erklärungsnot. Entwickler müssen Workarounds suchen, während Produktmanager neu priorisieren. Wer sich schnell anpasst, kann gestärkt aus der Phase hervorgehen – doch es ist ein Wettlauf auf unsicherem Terrain.

Risiko und Chance: Marktverschiebungen am Horizont

Dieses ungeplante Softwareupdate, ausgelöst durch eine mutmaßliche Sicherheitslücke, bringt kurzfristig Verluste, etwa durch gestoppte Automatisierungsprozesse und Integrationen. Doch mittelfristig eröffnen sich neue Felder: Wenn xAI tatsächlich an einer neuen Generation autonomer Systeme arbeitet, könnten robuste KI-Sicherheits-Standards und zertifizierte KI-Entwicklung zum Marktvorteil werden. Unternehmen mit Expertise in Incident-Response oder Auditing sind jetzt gefragt.

Drei realistische Szenarien

- Stabilitäts-Push: xAI veröffentlicht bald ein Update, das strukturierte Ausgaben und Funktionsaufrufe sicherer macht. Die Branche atmet auf, setzt aber ab sofort höhere Standards für KI-Sicherheit – mit entsprechender Signalwirkung auch für Wettbewerber.

- Agenten-Neustart: Ein radikaler Kurswechsel führt zu ganz neuen autonomen KI-Agenten, vielleicht mit stärkerem Fokus auf Schutzmechanismen und Governance.

- Anhaltende Disruption: Verzögerungen oder neue Incident-Reports verunsichern Kunden, treiben Marktanteile kurzfristig zu anderen Anbietern und erschweren Investitionsentscheidungen.

Die kommenden Wochen entscheiden, ob xAI eine vertrauenswürdige Technologieplattform für autonome Systeme bleibt – oder ein neues Wettrennen im KI-Markt auslöst.

Fazit

Die vorübergehende Abschaltung zentraler Grok-3-Funktionen markiert einen neuralgischen Punkt – in Sachen Vertrauen, Sicherheit und Wettbewerbsfähigkeit für KI-getriebene Systeme. Für Technologieunternehmen und Entwickler ist jetzt eine Phase des Abwartens und der strategischen Orientierung angebrochen. Doch die aktuellen Maßnahmen könnten den Grundstein für sicherere, leistungsfähigere KI-Agenten legen. Klar ist: Wer beim nächsten Technologiesprung vorne mitspielen will, sollte die weiteren Entwicklungen bei xAI und Grok-3 genau im Blick behalten.

Diskutieren Sie mit: Was erwarten Sie von der nächsten KI-Agenten-Generation? Teilen Sie Ihre Einschätzung in den Kommentaren.

Quellen

Grok 3 Beta — The Age of Reasoning Agents | xAI

Grok (chatbot) – Wikipedia

Grok 3 kann durch Tweets manipuliert werden

Hinweis: Für diesen Beitrag wurden KI-gestützte Recherche- und Editortools sowie aktuelle Webquellen genutzt. Alle Angaben nach bestem Wissen, Stand: 5/26/2025

Schreibe einen Kommentar