KI Stromverbrauch in Rechenzentren ist oft Thema öffentlicher Debatten. Dieser Text fasst zusammen, weshalb Rechenzentren für große KI‑Modelle besonders viel Energie benötigen, welche technischen Hebel meist übersehen werden und welche Folgen das für Netze und Klima hat. Er zeigt, wie Effizienzgewinne den Verbrauch dämpfen können, wo aber weiterhin Lücken bestehen und welche praktikablen Ansätze jetzt am meisten Wirkung entfalten.

Einleitung

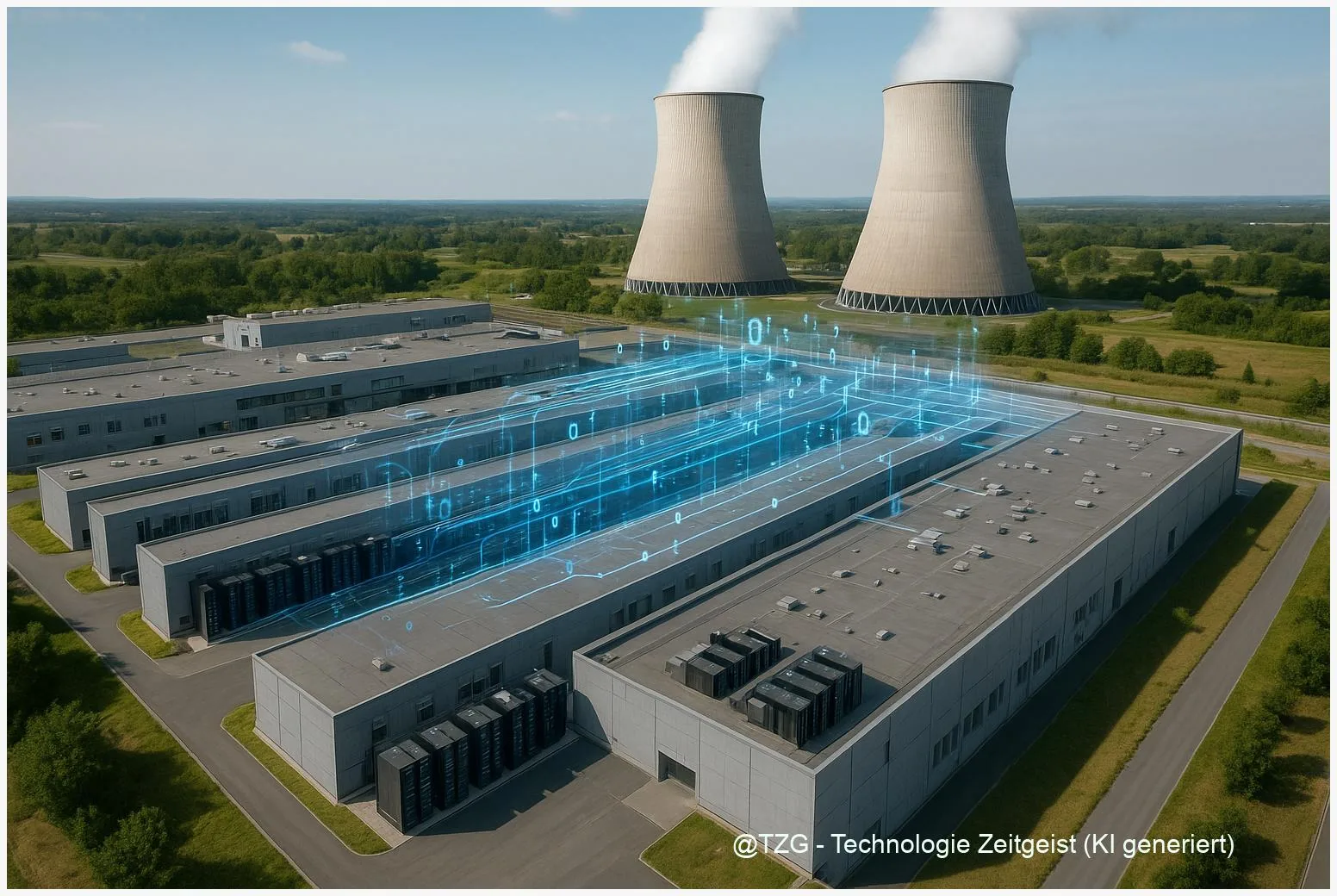

Wenn ein Smartphone‑Assistent in Millisekunden antwortet oder ein Foto in Sekundenschnelle beschrieben wird, läuft im Hintergrund oft eine Cloud‑Instanz, die KI‑Modelle nutzt. Für einzelne Nutzerinnen und Nutzer ist das kaum spürbar. Auf Infrastrukturebene jedoch bedeutet mehr künstliche Intelligenz: mehr spezialisierte Hardware, längere Trainingsläufe und größere Datenflüsse.

Die öffentliche Frage lautet deshalb nicht nur, wer die KI‑Ergebnisse liefert, sondern wieviel Strom dafür tatsächlich fließt und ob sich der Energiebedarf nachhaltig steuern lässt. Länder und Anbieter melden verschiedene Kennzahlen; internationale Analysen zeigen, dass Rechenleistung schneller wächst als der gemessene Energieverbrauch, teilweise dank Effizienzsteigerungen. Gleichzeitig fehlen oft präzise, einheitliche Daten, die Aussagen nach Region und Art der Nutzung erlauben. Diese Lücke macht es schwer abzuschätzen, wie stark KI allein Netze und Klimabilanz belastet.

KI Stromverbrauch in Rechenzentren

Rechenzentren verbrauchen Strom in zwei klaren Bereichen: die IT‑Last (Server, Beschleuniger wie GPUs/TPUs) und die Gebäudetechnik (Kühlung, Stromversorgung, Licht). Power Usage Effectiveness (PUE) ist eine Standardmetrik, die das Verhältnis von Gesamtverbrauch zu IT‑Last beschreibt; ein niedrigerer PUE‑Wert bedeutet höhere Effizienz. Für KI‑Workloads ist vor allem die IT‑Last relevant, weil Trainings und aufwendige Inferenz starke Rechenleistung benötigen.

Internationale Analysen zeigen: Die Rechenleistung wächst schneller als der Gesamtenergieverbrauch, weil Effizienzgewinne (bessere Hardware, Kühlung, Auslastungsoptimierung) einen Teil der Nachfrage kompensieren.

Das heißt nicht, dass KI keinen zusätzlichen Energiebedarf bedeutet, sondern dass Effizienzmaßnahmen und Verlagerung zu großen, modernen Rechenzentren die aggregierte Zunahme abschwächen können. Probleme entstehen, wenn Nachfrage (mehr und größere Modelle) die Effizienzfortschritte übersteigt oder wenn Kapazitäten lokal konzentriert sind und dadurch Netze vor Ort belasten.

Eine kleine Tabelle hilft, die Schlüsselgrößen grob zu unterscheiden:

| Merkmal | Bedeutung | Typische Einflussgröße |

|---|---|---|

| IT‑Last | Direkter Strombedarf für Server und Beschleuniger | Hoch bei Training großer Modelle |

| PUE | Effizienz der Infrastruktur (Kühlung, USV, Verteilung) | Wirkungsvoll: kann Gesamtverbrauch deutlich senken |

Wichtig ist die Unterscheidung zwischen Training und Inference: Das einmalige Training eines großen Modells kann hohe Rechenzeit und damit Energie beanspruchen, die anschließende Inference (Anfragen von Nutzerinnen und Nutzern) verteilt diesen Aufwand über viele Nutzungen und ist pro Anfrage in der Regel wesentlich sparsamer.

Wie KI‑Anwendungen im Alltag Strom nutzen

Im Alltag begegnen Menschen KI vor allem in Form von Empfehlungssystemen, Suchfunktionen, Sprachassistenten und Bildverarbeitung. Viele dieser Dienste laufen als Inference in der Cloud: Ein Nutzerrequest wird an ein Modell gesendet, das Ergebnis zurückgegeben — der Energiebedarf pro Anfrage ist vergleichsweise klein, weil spezialisierte Hardware und Skaleneffekte greifen.

Anders beim Modelltraining: Große Sprachmodelle oder Bildklassifizierer werden oft über Tage bis Wochen auf Hunderten bis Tausenden von GPUs trainiert. Solche Trainingsläufe sind rechenintensiv und können lokal hohe Leistungsanforderungen erzeugen. Für Unternehmen und Forschungseinrichtungen ist das relevant, weil Training wiederkehrend nötig ist, etwa bei Anpassung an neue Daten oder bei Hyperparameter‑Suche.

Ein weiteres Alltagsbeispiel sind personalisierte Empfehlungen beim Streaming. Hier erzeugt das laufende System eine große Anzahl kleiner Berechnungen für viele Nutzerinnen und Nutzer zugleich. Die Summe der Anfragen kann über ein Jahr gesehen deutlich ins Gewicht fallen, obwohl die einzelne Inference gering erscheint. Die räumliche Verteilung solcher Lasten beeinflusst das lokale Netz: Konzentrieren sich viele Rechenzentren in einer Region, kann das zu Engpässen führen und zusätzlichen Bedarf an Netzverstärkung auslösen.

Für Nutzerinnen und Nutzer ist das Ergebnis ambivalent: Verbesserte Dienste durch KI kommen mit einem unsichtbaren Energieaufwand. Auf Systemebene entscheidet die Wahl von Rechenzentrum, Hardware und Betriebszeitfenstern darüber, wie groß die ökologische Wirkung letztlich ist.

Chancen und Risiken: Effizienz gegen Nachfrage

Fortschritte in Hardware und Rechenzentren sind eine Chance: neuere GPUs, spezialisierte Beschleuniger und bessere Kühlung senken den Energiebedarf pro Recheneinheit. Softwareseitig hilft Optimierung (komprimierte Modelle, sparsames Quantisieren, Batch‑Processing) zusätzlich. International analysierte Berichte zeigen, dass diese Effizienzgewinne bereits einen großen Einfluss haben.

Auf der anderen Seite wächst die Nachfrage beständig. Immer größere Modelle und neue Anwendungsfelder (z. B. multimodale KI, Echtzeit‑Analysen) können Effizienzfortschritte überkompensieren. Ein strukturelles Risiko entsteht, wenn Wachstum regional konzentriert ist: Lokale Netze brauchen dann stärkere Leitungen, Speicher oder flexible Laststeuerung, sonst drohen Engpässe oder höhere Netzentgelte.

Politisch entsteht ein Spannungsfeld zwischen Förderung digitaler Innovation und Klimazielen. Transparenz‑anforderungen (standardisiertes Reporting zu Verbrauch und Emissionen) können helfen, belastbare Vergleichswerte zu schaffen. Zugleich zeigen Strategien wie zeitvariable Energiepreise, Direktabnahme von erneuerbarem Strom und Zertifikatslösungen praktikable Wege, Nachfrage zeitlich und energetisch zu steuern.

Quality‑Checks in der Datenlage sind wichtig: Studien verwenden verschiedene Annahmen zu PUE, Strommix und Abgrenzung von Rechenzentren, weshalb direkte Vergleiche oft schwierig sind. Solche methodischen Unterschiede erklären teils die Bandbreite in vorhandenen Schätzungen.

Blick nach vorn: Szenarien und politische Ansätze

In den nächsten Jahren sind drei Entwicklungslinien wahrscheinlich: Erstens verstärkte Effizienz durch spezialisierte Hardware und bessere Kühlung; zweitens vermehrte Nutzung zeitlich flexibler Betriebsmodelle (z. B. Trainingsläufe at night, carbon‑aware scheduling); drittens stärkere Regulierungsanforderungen an Transparenz und Reporting. Kombinationen dieser Ansätze können den Energiebedarf begrenzen, ohne Innovation zu blockieren.

Für Betreiber bedeutet das: Mehr Offenlegung von PUE‑Werten, IT‑Strom und Emissionsdaten erleichtert regulatorische Steuerung und Marktvergleiche. Für Netzbetreiber ist wichtig, Lastspitzen planbar zu machen, etwa durch Nachfrageflexibilisierung und Energiespeicher. Auf politischer Ebene sind Standards für das Reporting von Rechenzentrumsenergie hilfreich, ebenso Anreize für Direktabnahme von erneuerbarem Strom.

Für Unternehmen und Forschende lohnt es sich, Trainingsläufe zu optimieren, Modelle sparsamer zu konzipieren und regionale Stromprofile zu berücksichtigen. Solche Maßnahmen reduzieren nicht nur CO₂, sondern oft auch Kosten. Internationaler Austausch über Messmethoden und erprobte Best Practices hilft, Unsicherheiten in Schätzungen zu verringern und vergleichbare Daten zu schaffen.

Fazit

Der Strombedarf von KI ist ein Zusammenspiel aus wachsender Rechenleistung und technischen Gegenbewegungen: Effizienz‑ und Architekturgewinne dämpfen den Zuwachs, können ihn aber nicht ohne begleitende Maßnahmen vollständig aufheben. Wichtig sind verlässliche Daten, standardisiertes Reporting und gezielte Investitionen in Hardware‑ und Softwareeffizienz. Lokale Netzwirkungen bleiben eine Herausforderung, wenn Nachfrage und Rechenkapazität räumlich konzentriert sind. Wer heute auf Transparenz und intelligente Betriebsmodelle setzt, schafft die besten Voraussetzungen, damit KI‑Leistungen nachhaltig, kosteneffizient und netzverträglich bereitgestellt werden können.

Diskutieren Sie gern Ihre Erfahrungen mit KI‑Diensten und teilen Sie diesen Beitrag, wenn Sie ihn informativ fanden.

Schreibe einen Kommentar