Große KI‑Modelle verlangen enorme Rechenleistung. Warum KI so viel Compute braucht ist die zentrale Frage dieses Beitrags: Er zeigt, welche technischen Gründe hinter hohen FLOP‑Zahlen stehen, wie Forschung und Industrie Trainingsaufwand messen und welche Folgen das für Kosten, Energie und Forschungsteilnahme hat. Die Analyse stützt sich auf vergleichende Studien und Primärquellen, nennt Unsicherheiten bei Schätzungen und liefert praktische Einordnungen, die auch in den kommenden Jahren relevant bleiben.

Einleitung

Wenn ein Sprachassistent flüssig antwortet oder ein Bildgenerator in Sekunden komplexe Szenen rendert, steht hinter diesen Momenten oft ein sehr aufwendiger Trainingslauf. Das Training großer Modelle ist kein einzelner Server‑Job, sondern ein koordiniertes Zusammenspiel aus spezialisierten Chips, massiven Datenmengen und langer Rechenzeit. Für Interessierte ist wichtig zu verstehen, warum diese Kombination so rechenintensiv ist: Es bestimmt, wer Zugang zu Spitzenmodellen hat, wie teuer Forschung wird und wie sich Energieverbrauch und Infrastruktur entwickeln. Dieser Text erklärt die Mechanik, zeigt Praxisbeispiele und ordnet die wichtigsten Studien ein, damit die Diskussion fundiert geführt werden kann.

Warum KI so viel Compute braucht – die Grundlagen

Compute im KI‑Kontext wird oft in FLOPs gemessen, also in Rechenoperationen wie Additionen und Multiplikationen. Große Modelle bedeuten mehr Schichten, mehr Parameter und längere Trainingsläufe. Jede Epoche über viele Milliarden Token multipliziert die benötigten FLOPs; zudem erhöhen größere Batch‑Größen und längere Trainingsläufe die Gesamtmenge signifikant.

Rechenleistung skaliert nicht linear: doppelte Modellgröße kann mehr als doppelt so viel Training erfordern.

Seit 2012 beobachteten Forscherinnen und Forscher ein starkes Wachstum der für Spitzen‑Trainings eingesetzten Rechenleistung. Eine frühe Analyse aus 2018 meldete eine sehr schnelle Verdopplung (diese Studie stammt aus dem Jahr 2018 und ist damit älter als zwei Jahre). Spätere, größere Datensammlungen (2022) bestätigen hohes Wachstum, ordnen es aber in mehrere Epochen und schätzen die Verdopplungszeiten etwas moderater ein. Diese Unterschiede entstehen unter anderem durch die Auswahl der betrachteten Modelle und durch Unsicherheiten in den FLOP‑Schätzungen.

Die wichtigsten Treiber im Kurzüberblick sind:

- Modellgröße: mehr Parameter = mehr Matrixoperationen.

- Datenmenge: längere Texte oder größere Datensätze bedeuten mehr Trainingsschritte.

- Architektur und Präzision: manche Architekturen benötigen mehr Operationen, niedrigere numerische Präzision kann Kosten senken.

- Forschungsstrategie: größere Experimente, Hyperparameter‑Sweeps und Replikationen erhöhen den Gesamtbedarf.

Eine kompakte Vergleichstabelle fasst zentrale Kennzahlen zusammen:

| Quelle | Kernaussage | Stichtag |

|---|---|---|

| OpenAI | Sehr schnelles Wachstum, angebene Verdopplung ≈ 3.4 Monate | 2018 (älter als zwei Jahre) |

| Sevilla et al. (Epoch) | Breiteres Dataset, Verdopplung ≈ 5–6 Monate (2010–2022) | 2022 (älter als zwei Jahre) |

| OpenAI (Algorithmic efficiency) | Algorithmische Verbesserungen können Compute‑Bedarf deutlich senken | 2020 (älter als zwei Jahre) |

Kurz gesagt: Die technische Struktur von neuronalen Netzen und die Praxis des Forschungsbetriebs erklären, warum KI‑Trainings so rechenintensiv sind. Messmethoden und Auswahl der betrachteten Modelle bestimmen zusätzlich, wie dramatisch das Wachstum erscheint.

Wie Modelle trainiert werden: Praxis und Beispiele

Ein Trainingslauf beginnt mit Daten — Text, Bilder oder Ton — und einem Architekturentwurf. In jedem Trainingsschritt wird ein Datensatz‑Batch durch das Modell geleitet, Fehler werden berechnet und Gewichte angepasst. Je mehr Daten und Parameter, desto mehr Schritte sind nötig, um brauchbare Leistung zu erreichen. Große Sprachmodelle sehen daher oft Billionen von Token während des Trainings.

Praktische Beispiele helfen: Für ein mittelgroßes Transformer‑Modell kann ein einzelner Trainingslauf Wochen auf Hunderten von GPUs dauern. Große Experimente kombinieren oft mehrere Trainingsläufe für Feintuning und Hyperparameter‑Suche. Unternehmen und Forschungsteams sprechen in Einzelfällen von Kosten im Bereich von einigen Millionen US‑Dollar für Spitzenläufe; solche Angaben sind je nach Methode Schätzungen.

Messgrößen, die in der Praxis verwendet werden:

- FLOPs pro Trainingslauf: direkte Zählung der Rechenoperationen.

- GPU‑Stunden: praktische Abrechnungseinheit bei Cloud‑Providern.

- Datensatzgröße und Token‑Anzahl: wie viel Material das Modell gesehen hat.

Wichtig ist, dass algorithmische Verbesserungen den Compute‑Bedarf pro Leistungsziel reduzieren können. Studien zeigen, dass bessere Optimierer, effizientere Architekturen und Quantisierung die benötigten FLOPs deutlich senken können. Damit bleibt Compute zwar ein zentraler Engpass, aber nicht der einzige Faktor für Fortschritt.

Für die breite Forschung bedeutet das: Wer begrenzten Zugang zum größten Compute hat, kann durch kluge Architekturwahl, effizientere Trainingsverfahren und Datennutzung oft trotzdem konkurrenzfähige Modelle entwickeln. Das ist eine zentrale Beobachtung für Hochschulgruppen und Startups, die nicht mit den größten Budgets arbeiten.

Chancen und Risiken: Kosten, Energie und Konzentration

Der hohe Compute‑Bedarf hat sichtbare Folgen. Kosten und Energieverbrauch steigen mit der Modellgröße. Für die öffentliche Debatte sind drei Aspekte besonders relevant: finanzielle Zugangsbarrieren, Umwelteinfluss und Markt‑Konzentration.

Finanziell entstehen Barrieren für Akademie und kleinere Teams: Wenn Spitzenläufe Millionen kosten, bleiben solche Experimente meist großen Organisationen vorbehalten. Das verengt die Forschungsperspektiven und kann Innovationspfade beeinflussen. Gleichzeitig treibt Wettbewerb Investitionen in effizientere Hardware und bessere Software voran, was langfristig Kosten senken kann.

Der Energieaufwand für Training ist nicht trivial. Konkrete CO2‑Werte schwanken stark je nach Standort und Strommix; eine belastbare Umrechnung von FLOPs in Energie erfordert viele Annahmen. Trotzdem ist klar: Je mehr große Trainingsläufe, desto größer der Energiefußabdruck der KI‑Forschung insgesamt.

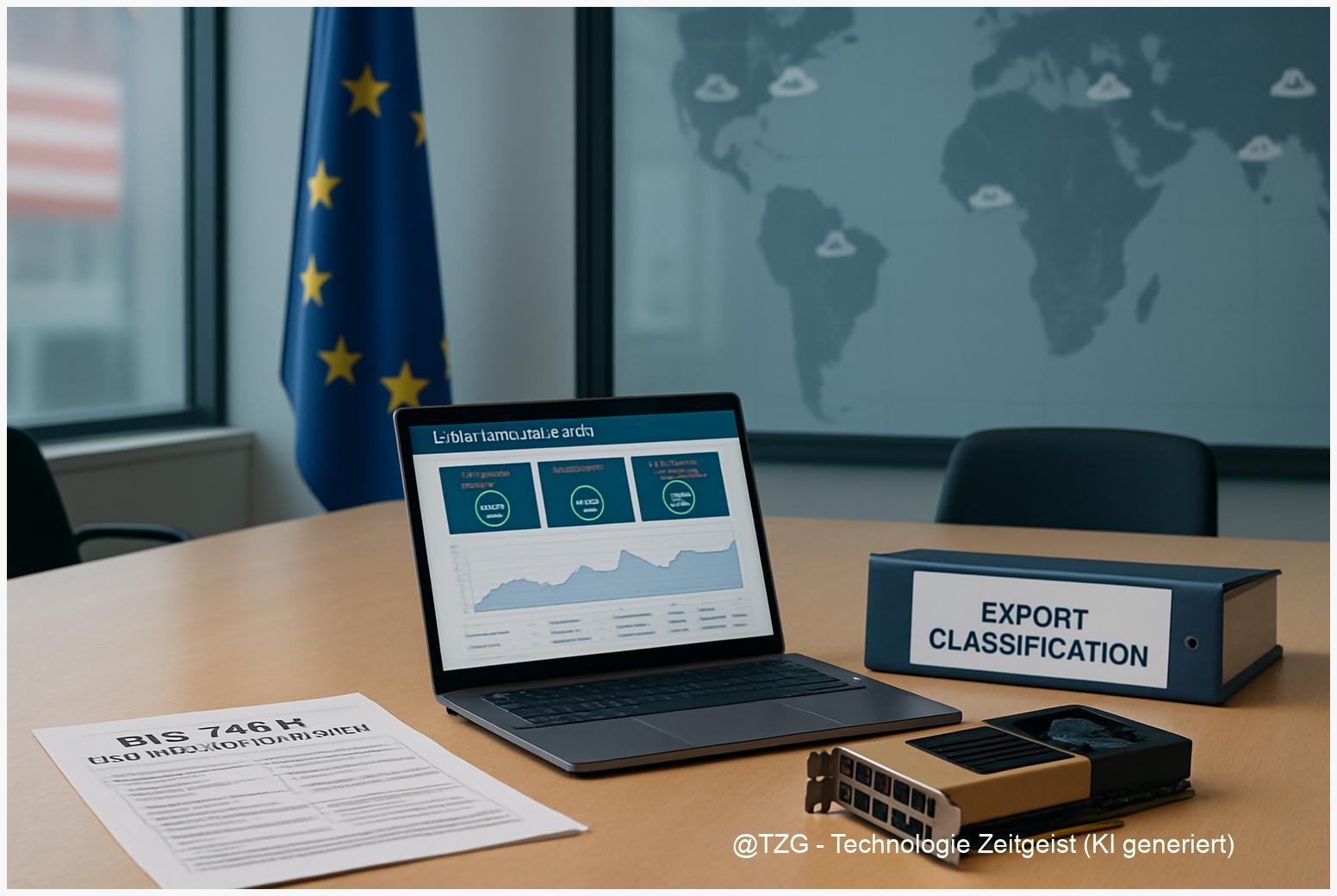

Schließlich verstärkt hoher Compute‑Bedarf die Konzentration: Wer viel Rechenleistung, spezialisierte Chips und großes Budget besitzt, hat einen strategischen Vorteil. Das kann Innovationsgeschwindigkeit erhöhen, gleichzeitig aber Abhängigkeiten schaffen. Politik und Wissenschaftsförderung arbeiten deshalb an Mechanismen, um Zugang und Transparenz zu verbessern.

Wichtig zu beachten ist: Studien, die reines Wachstum extrapolieren, unterscheiden sich in ihren Ergebnissen. Frühere Analysen berichteten sehr schnelle Verdopplungsraten; umfassendere Datensätze kommen zu moderateren Raten. Solche methodischen Details verändern die Einschätzung, wie dringend politische Maßnahmen sein sollten.

Wie sich Nachfrage verändern könnte: Szenarien bis 2030

Welche Entwicklungen sind plausibel? Drei Szenarien bringen die zentralen Treiber zusammen: technischer Fortschritt, Ökonomie und Politik. Erstens ein moderates Szenario, in dem Compute‑Wachstum weitergeht, aber durch Kostendegressionen und bessere Algorithmen gedämpft wird. Zweitens ein konzentriertes Szenario, in dem wenige Akteure mit großen Budgets dominieren und Large‑Scale‑Modelle häufiger werden. Drittens ein gedämpftes Szenario, in dem Rohstoffbeschränkungen, Chipknappheit oder politische Regulierungen das Wachstum bremsen.

Alle Szenarien basieren auf Annahmen mit hoher Unsicherheit. Studien aus 2018 und 2022 liefern wichtige Referenzpunkte, sind aber in Teilen älter als zwei Jahre und müssen für aktuelle Prognosen nachgeprüft werden. Deshalb sind flexible, überprüfbare Indikatoren sinnvoll: Preis pro FLOP, verfügbare Beschleuniger‑Einheiten und Fortschritte in algorithmischer Effizienz.

Für Anwenderinnen und Anwender bedeuten diese Szenarien konkretere Empfehlungen: Budgetplanung sollte mit mehreren Annahmen rechnen; Forschungsteams können durch Software‑Optimierung und kollaborative Nutzung von Infrastruktur wettbewerbsfähig bleiben. Für die Gesellschaft ist relevant, wie Zugang, Klimaauswirkungen und industrielle Konzentration reguliert und ausgeglichen werden.

Langfristig bleibt Rechenleistung ein zentraler, aber nicht alleiniger Faktor. Datenqualität, Architekturinnovation und gezielte Evaluationen werden in vielen Anwendungen genauso entscheidend sein wie rohe FLOP‑Zahlen.

Fazit

Die Menge an Rechenleistung, die moderne KI‑Modelle verlangen, folgt aus ihrer Architektur, der Datenmenge und der Praxis des Forschungsbetriebs. Studien aus verschiedenen Jahren zeigen weiterhin ein schnelles Wachstum, unterscheiden sich aber in der geschätzten Verdopplungsrate; deshalb ist Vorsicht bei Direkt‑Extrapolationen geboten. Algorithmische Effizienz und Infrastrukturinvestitionen können den Bedarf dämpfen, doch kurzfristig bleiben Kosten, Energie und Zugang zentrale Herausforderungen. Eine differenzierte Beobachtung von FLOPs, Kosten pro FLOP und Hardwareverfügbarkeit hilft dabei, realistische Szenarien zu entwickeln und Politik sowie Forschung pragmatisch zu planen.

Wenn Sie diesen Beitrag nützlich fanden: Diskutieren Sie ihn gern und teilen Sie ihn in Ihrem Netzwerk.

Schreibe einen Kommentar