Kurzfassung

Wer heute eine kosteneffiziente lokale Recheninfrastruktur plant, muss das Prinzip des local AI inference cluster begreifen: Die Balance aus Latenz, Energie und Kontrolle entscheidet. Dieser Text erklärt, warum Thunderbolt‑5‑Verkettung, macOS‑Clustering und moderne GPUs nicht nur Technik sind, sondern Bausteine für praktische, energieeffiziente Inference‑Farmen — mit klaren Prüfungen, realistischen Erwartungen und einem konkreten PoC‑Fahrplan.

Einleitung

Lokale Inference‑Farms sind keine abstrakte Idee mehr; sie sind eine praktische Antwort auf Latenz‑ und Datenschutzanforderungen. Wer heute ein local AI inference cluster in Erwägung zieht, denkt an kurze Antwortzeiten, datenschutzfreundliche Verarbeitung und Kontrolle über die Energiebilanz. Dieser Artikel führt durch die technischen Optionen — von Thunderbolt‑5‑Verkettung über macOS Tahoe‑Clustering bis zu Kosten‑ und Energieüberlegungen — und zeigt, wie ein kleines, belastbares Setup gelingt.

Warum lokale Inference‑Farmen jetzt Sinn ergeben

Der Wunsch nach unmittelbarer Reaktion — ohne Wolke dazwischen — ist praktisch und emotional. Für Anwendungen mit strengen Latenz‑ oder Datenschutzanforderungen (Chatbots in Echtzeit, vertrauliche Dokumentenprüfung, Edge‑Sensorik) verschiebt sich die Kostenrechnung: weniger Netzwerktransit, bessere Antwortzeiten und volle Datenhoheit. Gleichzeitig haben Optimierungen wie Quantisierung oder Distillation die Hardwareansprüche gesenkt; kleinere Modelle liefern für viele Aufgaben mittlerweile eine ausreichende Qualität.

„Eine Inference‑Farm ist weniger eine Maschine als eine Haltung: Kontrolle über Daten, Antwortzeit und Betrieb.“

Pragmatisch betrachtet reduziert ein lokal betriebenes Setup die Abhängigkeit von Cloud‑Peering‑Gebühren und erspart die ständige Übertragung sensibler Daten. Die Kehrseite: Kapitalbindung (Hardware), Betrieb und Kühlung. Entscheidend ist die Arbeitslast: Bei hoher, stetiger Auslastung amortisiert sich On‑Prem‑Betrieb häufiger; bei sporadischen Peaks bleibt Cloud‑Bursting ökonomisch attraktiv.

Einfachere Rechnung, kein Zahlensalat: Messen Sie die reale Anfrage‑Last, testen Sie modelloptimierte Varianten und vergleichen Sie dann Strom‑ und Wartungskosten mit Cloud‑Angeboten. Viele Projekte sparen zuerst an Modellsichtbarkeit (Quantisierung, Caching), bevor sie in Hardware investieren.

Kurze Tabelle zur Orientierung:

| Merkmal | Typischer Nutzen | Hinweis |

|---|---|---|

| Latenz | Bessere Antwortzeiten bei lokalem Betrieb | Messung per End‑to‑End‑Test nötig |

| Datenschutz | Daten bleiben vor Ort, Compliance leichter | Policies und Logging zentral prüfen |

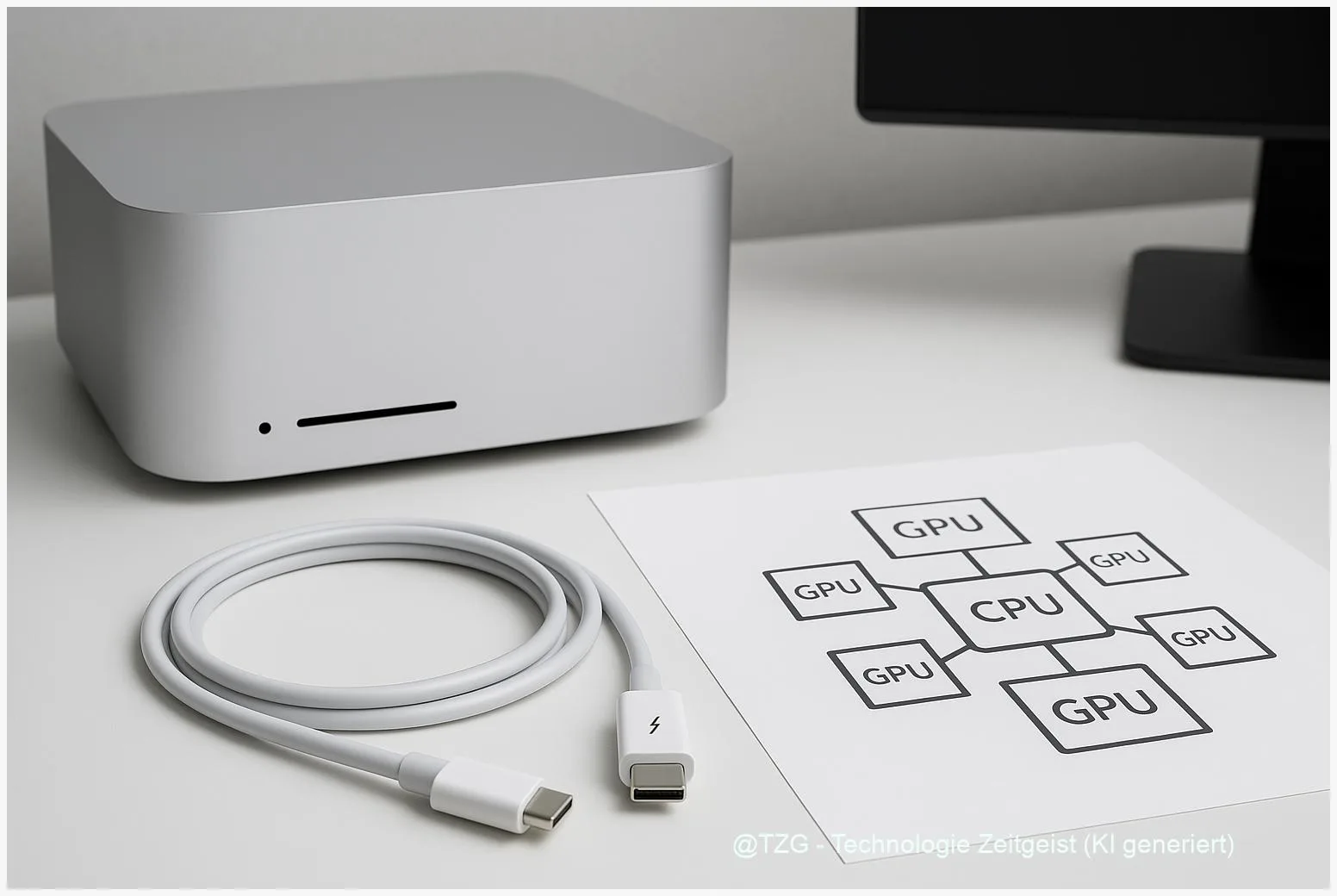

Thunderbolt‑5‑Clustering: Chancen und reale Grenzen

Thunderbolt 5 bringt nominale Bandbreiten, die Desktop‑Interconnects neu definieren. In der Spezifikation sind deutlich höhere Punkt‑zu‑Punkt‑Raten als bei klassischen 10/25‑GbE‑Setups genannt, was externe PCIe‑Anbindungen und schnelle Peer‑to‑Peer‑Transfers interessant macht. Apple hat mit macOS Tahoe 26.2 Funktionen angekündigt, die mehrere Macs zu einer vernetzten ML‑Ressource zusammenfassen sollen — das ist ein Versprechen, das in Labors neugierige Blicke erzeugt.

Die Praxis zeigt jedoch Nuancen: Community‑Implementierungen und frühe Tests berichten über Topologie‑Limitierungen, Aktivierungsregeln für Links und inkonsistente Speicherverteilung bei Multi‑Mac‑Setups. Solche Probleme deuten weniger auf theoretische Grenzen als auf Firmware‑, Treiber‑ und Middleware‑Reife hin. Kurz: TB5 ist schnell, aber Skalierung verlangt sorgfältige Validierung.

Für Entscheider bedeutet das: Planen Sie Proof‑of‑Concepts mit 2–4 Knoten, prüfen Sie Verkettungstiefen und messen Sie Durchsatz pro Hop. Validieren Sie, ob die Software tatsächlich verteiltes Laden von Modellgewichten erlaubt oder eher auf zentralen Speicher setzt. Ohne diese Tests kann vermeintliche Bandbreite zu einer trügerischen Erwartung werden.

Technisch relevante Punkte, die bereits belegt sind: TB5‑PHY bietet deutlich höhere Bandbreiten als TB4; macOS‑Updates adressieren ML‑Optimierungen; Community‑Repos (z. B. exo) arbeiten an Integrationsschichten. Für den produktiven Einsatz sollten Sie ferner RDMA‑Äquivalente, Link‑Topologie und Fallback‑Netzwerk (10/25/40/100‑GbE) in Ihre Architektur aufnehmen.

Empfehlung: Priorisieren Sie Messungen (iperf, RDMA‑Bench, micro‑latency), dokumentieren Sie Firmware‑Versionen und halten Sie ein Ethernet‑Fallback bereit. Damit bleibt das Versprechen von niedriger Latenz praktisch erreichbar — ohne Überraschungen.

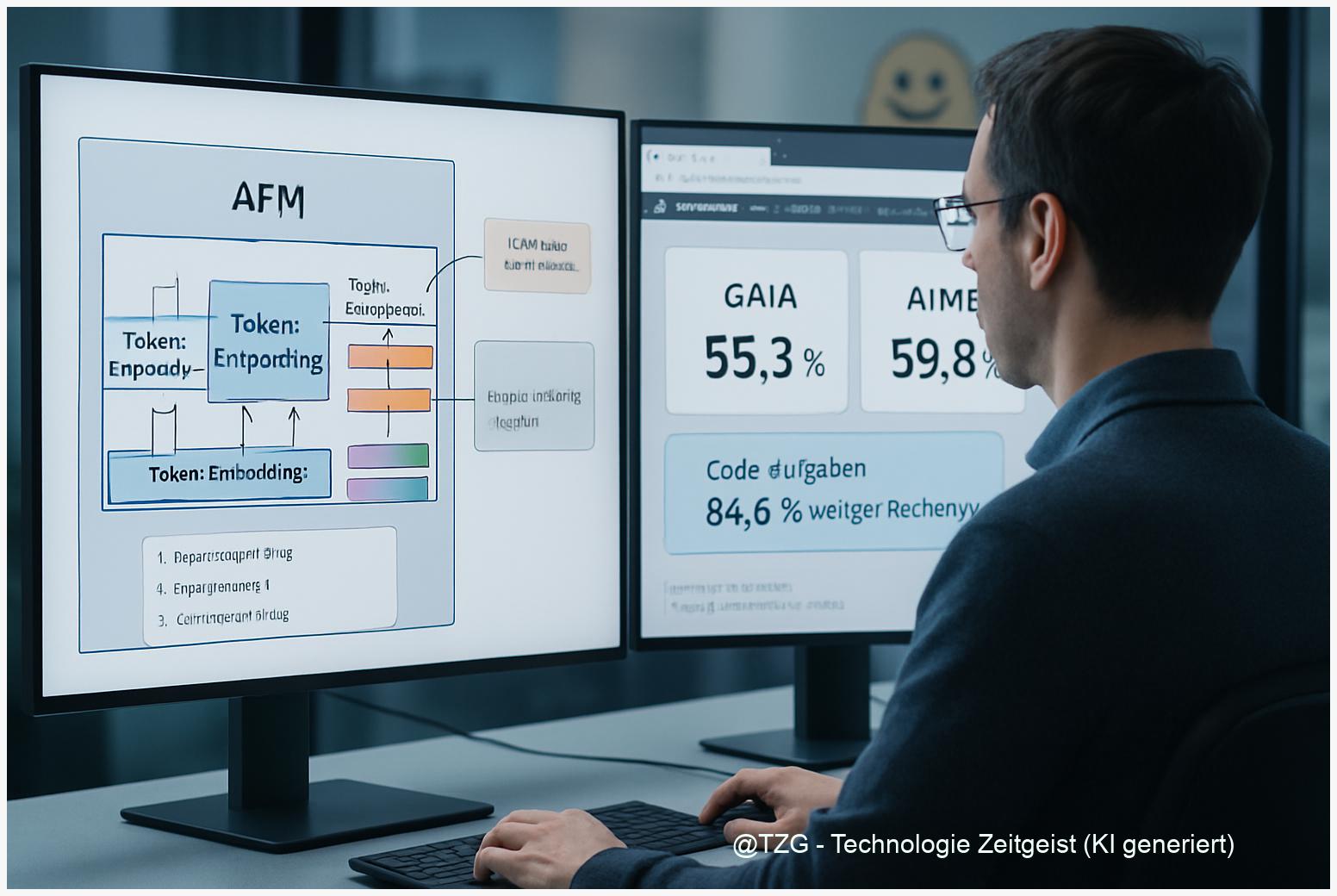

Architekturen: Macs, GPUs und hybride Knoten

Die Entscheidung, ob ein Knoten ein Mac mit integriertem Neural‑Accelerator, eine GPU‑Workstation oder ein CPU‑lastiges Edge‑Device sein soll, ist keine Frage von Mode, sondern von Workloadprofil. Moderne GPUs liefern oft das beste Performance‑/Watt‑Verhältnis für große Transformer‑Modelle; Apples M‑Serie punktet bei integrierter Effizienz und Unified‑Memory‑Design — ideal für bestimmte Inferenzpfade und kleinere bis mittelgroße Modelle.

Wichtig: Der Vergleich GPU vs CPU‑Inference ist kontextabhängig. Für hohe Durchsatzraten und große Modelle sind dedizierte Beschleuniger meist wirtschaftlicher; für latenzkritische, leichtgewichtige Tasks können CPUs oder NPUs (in Mac‑Chips) konkurrenzfähig bleiben. Energieeffizienz lässt sich durch Optimierungen stark beeinflussen: Quantisierung, Batch‑Strategien und adaptive Skalierung reduzieren sowohl Verbrauch als auch Kosten pro Anfrage.

Im Zusammenspiel mit Thunderbolt‑Clustern entstehen hybride Designs: Ein Mac kann als Steuerknoten dienen, der über TB5 schnelle Anbindungen zu GPU‑Enclosures oder anderen Macs herstellt. Solche Topologien erlauben eine feingranulare Arbeitsteilung — aber sie verlangen, dass Software‑Stapel (MLX, exo, Runner) klar orchestrieren, welche Komponenten Modellteile halten, welche inferieren und welche einfach Daten verschieben.

Aus Sicht der Kosten: Mac‑basierte Knoten haben oft höhere Anschaffungspreise pro Rechenleistung, bieten dafür aber Integration und geringeren Verwaltungsaufwand. Reine GPU‑Racks sind in vielen Fällen effizienter auf reinen Durchsatz gerechnet. Für kosteneffiziente lokale Inference‑Farmen empfiehlt sich daher ein hybrides Muster: wenige leistungsfähige GPU‑Knoten flankiert von energieeffizienten Mac‑ oder CPU‑Nodes für leichte, sensible Aufgaben.

Zusammengefasst: Messen, optimieren, orchestrieren — und das Design an Erwartung (Latenz, Datenschutz, Energie) ausrichten. Dann entfaltet sich die Effizienz.

Praktische Anleitung: Aufbau einer kosteneffizienten Inference‑Farm

Starten Sie klein und messen Sie präzise: Ein 2–4‑Knoten‑PoC reicht, um Topologie‑Grenzen und Software‑Reife zu testen. Benötigt werden hochwertige TB5‑Kabel/Docks, identische macOS‑Versionen (z. B. Tahoe 26.2) sowie ein offenes Orchestrierungs‑Setup (exo oder ähnliche Middleware). Ziele des PoC: Node‑Discovery, verteiltes Laden von Modellgewichten, Per‑Hop‑Durchsatz und Energie‑Profiling.

Messplan (kurz): Führen Sie iperf‑Durchläufe zur Bandbreitenabschätzung, RDMA‑Benches für Latenz, und ML‑Microbenchmarks (Inference tokens/s, Tail‑Latency) durch. Parallel dazu messen Sie Watt‑Verbrauch pro Node unter Last. Die gewonnenen Daten füttern eine einfache TCO‑Rechnung: CAPEX, OPEX (Strom, Kühlung, Wartung) sowie Break‑Even‑Punkte gegenüber Cloud‑Renting.

Operational‑Checks: Legen Sie ein Logging‑Schema an, das Firmware‑Revision, macOS‑Build, Kabel‑Version und exo‑Logs aufzeichnet. Dokumentieren Sie außerdem Fehlerbilder (z. B. Node‑Drop, nur erster Knoten lädt Modell). Solche Details sind später entscheidend, wenn Sie Skalierung oder Support‑Tickets an Hersteller melden.

Architektur‑Empfehlung für Kostenbewusste:

- Basis: 2–4 Macs (Steuer‑/Edge‑Nodes) mit Tahoe 26.2.

- Beschleuniger: 1–2 GPU‑Enclosures oder Mac‑Studio‑ähnliche Knoten als Durchsatzmotor.

- Netzwerk: TB5 für niedrige Latenz, 25/40/100‑GbE als Backup und für Aggregate‑Traffic.

Fallbacks und Skalierung: Planen Sie Cloud‑Bursting für Spitzen, automatisches Energie‑Hoch/Herunterfahren bei Netztiefen und einen klaren Upgrade‑Pfad für TB5‑fähige Hardware. Wichtig: Bevor Sie groß kaufen, validieren Sie den Software‑Stack — oft ist hier der Flaschenhals, nicht die Steckverbindung.

Fazit

Lokale Inference‑Farmen sind 2026 pragmatisch erreichbar — sofern Planung, Messung und PoC die Basis bilden. Thunderbolt‑5 bietet echte Chancen, doch Software‑Reife und Topologiefragen bestimmen die Skalierbarkeit. Hybrid‑Architekturen kombinieren die Stärken von Macs und GPU‑Knoten und sind oft die kosteneffizienteste Wahl. Wer misst, orchestriert und flexibel bleibt, gewinnt Kontrolle über Leistung und Kosten.

_Diskutieren Sie Ihre Erfahrungen mit lokalen Clustern in den Kommentaren und teilen Sie diesen Beitrag, wenn er Ihnen geholfen hat._

Schreibe einen Kommentar