Tinygrad Transformer verstehen Schritt für Schritt: Dieses Stück zeigt, wie die Kernelemente eines Transformer‑Modells in tinygrad zusammenwirken und welche Teile wirklich wichtig sind, wenn man einen kleinen GPT‑artigen Prototyp baut. Leserinnen und Leser gewinnen ein klares Bild von Autograd, Multi‑Head‑Attention, Positionscodierung und Trainingsschleife in einer leicht zugänglichen Sprache. Am Ende lässt sich besser einschätzen, wann tinygrad zum Lernen reicht und wo echte Produktionsprojekte andere Werkzeuge erfordern.

Einleitung

Viele, die sich mit großen Sprachmodellen beschäftigen, fragen zuerst: Wie funktionieren diese Modelle unter der Haube? Tinygrad ist ein bewusst kleines Deep‑Learning‑Framework, das die wichtigsten Mechanismen offen und gut lesbar abbildet. In der Praxis bedeutet das: statt einer Blackbox aus Tausenden Zeilen optimiertem C++‑Code liegt der Fokus auf klaren Bausteinen wie Tensor, Autograd und einfachen JIT‑Schritten. Für Lernzwecke und schnelle Prototypen eignet sich das sehr gut. Bei Produktivaufgaben dagegen sind Performance‑Optimierungen, robuste Quantisierung und breite Hardware‑Unterstützung oft entscheidend.

Dieser Beitrag führt in die zentralen Komponenten eines Transformer‑Modells ein und zeigt, wie sie konkret in tinygrad zusammenspielen. Anhand konkreter Alltagsbeispiele wird deutlich, welche Schritte beim Aufbau eines Mini‑GPT nötig sind und welche Fallstricke typisch sind. Die Darstellung bleibt technisch korrekt, aber so knapp wie möglich, damit sie für Leserinnen und Leser ab sechzehn Jahren gut nachvollziehbar bleibt.

Tinygrad Transformer verstehen Schritt für Schritt

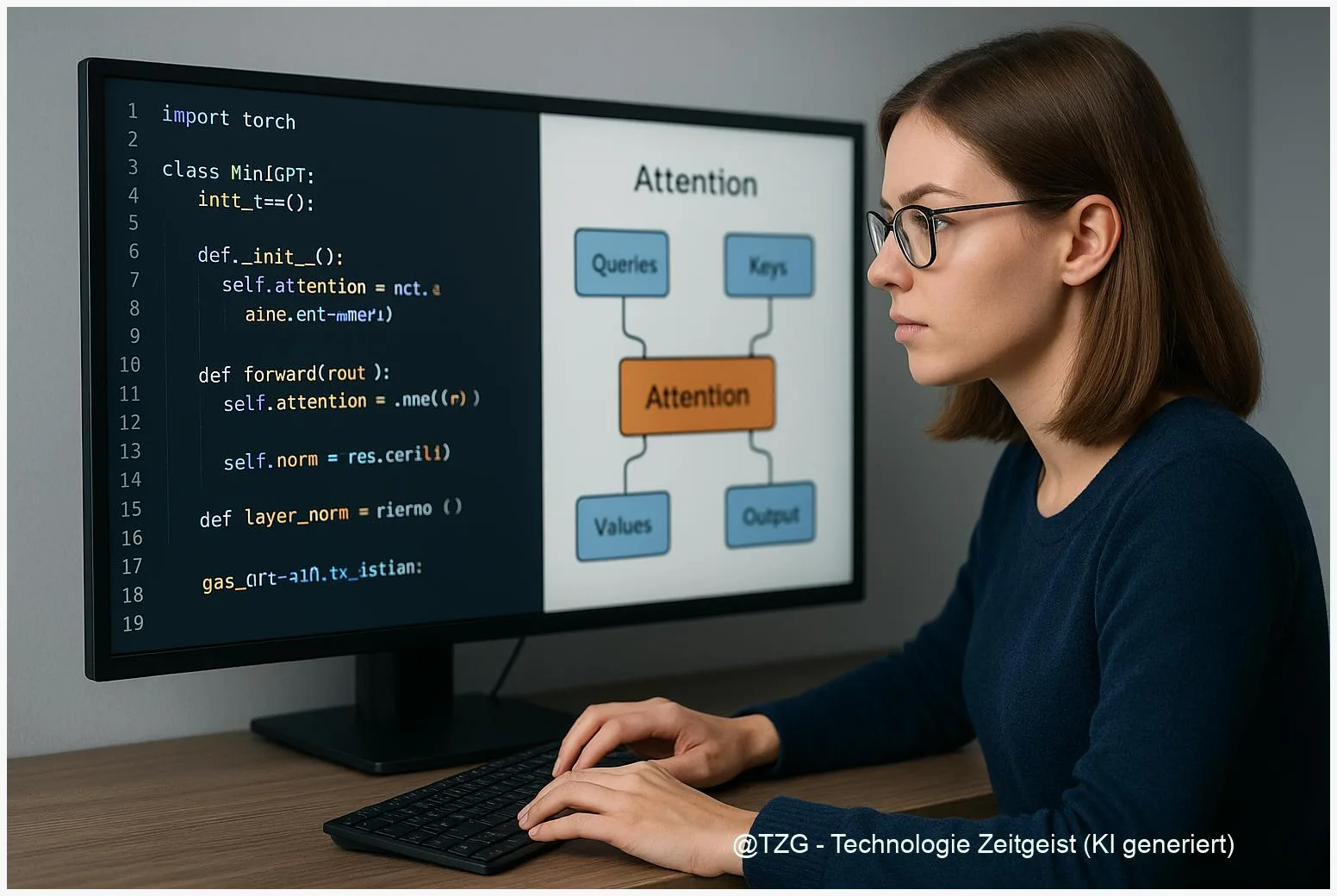

Ein Transformer besteht aus wenigen wiederkehrenden Bausteinen. Im Kern sind das: Attention (Aufmerksamkeitsmechanismus), eine Feed‑Forward‑Schicht, LayerNorm und Positionscodierung. Tinygrad liefert die Grundwerkzeuge: einfache Tensors mit Autograd, eine kleine Bibliothek an Operationen (Matrixmultiplikation, Softmax, LayerNorm) und oft eine leichte JIT‑Schicht, die kleine Optimierungen erlaubt. Die Idee: jedes Bauteil bleibt kurz genug, um es vollständig zu überblicken und zu ändern.

Attention ist das zentrale Konzept. Kurz gesagt vergleicht sie einzelne Positionen einer Eingabesequenz miteinander, um gewichtete Mischungen zu berechnen. Multi‑Head‑Attention bedeutet, diesen Vergleich parallel in mehreren “Köpfen” durchzuführen, sodass das Modell verschiedene Aspekte gleichzeitig betrachtet. Positional Encoding ergänzt sequenzielle Informationen, weil reine Matrixoperationen keine Reihenfolge kennen. LayerNorm stabilisiert die Aktivierungen, und die Feed‑Forward‑Schicht bringt nichtlineare Verarbeitung zwischen den Attention‑Blöcken.

Wer an einem kleinen Modell arbeitet, lernt am meisten beim Zusammenspiel von Klarheit (lesbarer Code) und tatsächlichem Training auf Daten.

Die folgende Tabelle vergleicht die drei hauptsächlichen Attention‑Arten kurz und bündig, damit klar wird, warum der klassische Self‑Attention‑Mechanismus in Transformers verwendet wird.

| Merkmal | Beschreibung | Typischer Einsatz |

|---|---|---|

| Self‑Attention | Vergleicht Positionen innerhalb derselben Sequenz, gewichtet Hinweise über Kontext | Sprachmodelle, Übersetzung |

| Cross‑Attention | Bezieht Informationen aus einer zweiten Sequenz ein (z. B. Bildbeschreibung zu Text) | Encoder‑Decoder‑Modelle |

| Local/Windowed Attention | Begrenzt Vergleich auf nahe Nachbarn, spart Rechenzeit | Lange Sequenzen, Effizienzgewinne |

In tinygrad wird jede dieser Operationen oft als wenige Zeilen Python plus native Matrixoperationen realisiert. Das macht Änderungen leicht: man kann etwa eine andere Scaling‑Formel für Attention testen oder eine einfache Quantisierung ergänzen, um zu sehen, wie sich Genauigkeit und Geschwindigkeit verändern.

Wie ein Mini‑GPT in tinygrad praktisch entsteht

Der Bau eines Mini‑GPT lässt sich in drei pragmatischen Schritten denken: Modellbausteine zusammenstellen, Trainingsdaten und Trainingsloop vorbereiten, dann trainieren und testen. In tinygrad heißt das konkret: Tensor‑API nutzen, Module für Attention und Feed‑Forward schreiben, Autograd für Gradienten verwenden.

Beispiel: Ein Decoder‑Block enthält Multi‑Head‑Attention, gefolgt von LayerNorm, einer kleinen Feed‑Forward‑Schicht und noch einer LayerNorm. Die Implementierung umfasst typischerweise:

- Lineare Projektionen für Query/Key/Value (Matrixmultiplikationen),

- Skalierung und Softmax, um Aufmerksamkeit zu normalisieren,

- Zusammenführung der Köpfe und eine abschließende lineare Transformation,

- Feed‑Forward als zwei lineare Schichten mit Aktivierung (z. B. GELU).

Die Trainingsschleife bleibt bewusst einfach: Batches laden, Eingaben in Token umwandeln, Vorhersage berechnen, Kreuzentropie‑Loss, Backpropagation (Autograd) und ein Optimizer‑Schritt (zum Beispiel Adam). Tinygrad stellt oft einfache Optimizer bereit, manchmal muss man kleine Anpassungen selbst ergänzen.

Für erste Experimente reichen kleinere Datensets und kurze Sequenzen. Ein übliches Vorgehen ist, mit einem Character‑Level Dataset oder kleinen Textkorpora zu starten. So werden Trainingszeiten überschaubar, und das Verhalten der einzelnen Komponenten wird sichtbar. Wenn die Aufmerksamkeit nicht funktioniert, zeigt sich das schnell in schlechten Vorhersagen — Debuggen ist direkt, denn die meisten Zwischenwerte sind als Tensors einsehbar.

Wichtig: Performance‑Tricks wie Flash‑Attention, spezialisiertes Kernel‑Fusing oder quantisierte Inferenz sind in tinygrad nicht standardmäßig integriert. Sie lassen sich jedoch Schritt für Schritt ergänzen, wenn die Grundlagen klar sind.

Chancen und Grenzen beim Einsatz

Tinygrad bietet als Lehr‑ und Prototyping‑Werkzeug viele Chancen. Der klare, stark lesbare Code beschleunigt das Verständnis komplexer Mechanismen. Für Bildungszwecke, Forschungsideen und schnelle Experimente ist das ein großer Vorteil: Änderungen zeigen oft unmittelbar, welche Auswirkung sie auf Gradienten, Konvergenz und Ausgabe haben.

Auf der anderen Seite gibt es Einschränkungen: tinygrad ist nicht primär auf maximale Performance oder umfangreiche Produktionsfeatures ausgelegt. Bei großen Modellen werden Latenz, Speicherverwaltung und robuste Quantisierungs‑Pipelines schnell zum Problem. Ebenfalls relevant sind Stabilitätsfragen bei großen Batch‑Größen oder langen Sequenzen; hier fehlen oft fertige Lösungen, die etablierte Frameworks liefern.

Ein weiterer Punkt ist Community‑Support und Wartbarkeit. Viele Transformer‑Beispiele im tinygrad‑Ökosystem sind Community‑Repos mit unterschiedlichem Pflegegrad. Das heißt: für produktive Projekte sind zusätzliche Tests, Benchmarks und Sicherheitsprüfungen nötig. Für Lernende ist dies jedoch ein Vorteil: man kann direkt nachvollziehen, wie ein Fehler entsteht und ihn selbst beheben.

Bei ethischen und sicherheitstechnischen Aspekten gilt: Modelle erzeugen Verhalten basierend auf Trainingsdaten. Kleine Prototypen reduzieren zwar das Risiko großer Schadwirkung, sie sind aber nicht automatisch frei von problematischen Ausgaben. Testdaten, robustes Prompt‑Engineering und einfache Filtering‑Regeln bleiben wichtige Bestandteile auch bei Experimenten.

Blick nach vorn: Entwicklung und Einsatzszenarien

Die Entwicklung in diesem Bereich läuft in zwei parallelen Strängen: einerseits tieferes Verständnis durch kleine, gut lesbare Frameworks; andererseits Optimierungsarbeit für Produktion. Für tinygrad sehen sich Nutzer oft in der Situation, zuerst Grundlagen zu erforschen und dann gezielt einzelne Optimierungen zu übernehmen.

Praktische nächste Schritte für Interessierte sind: vorhandene Beispiele aus dem tinygrad‑Repo und Community‑Implementierungen lokal durchlaufen, einfache Benchmarks auf eigener Hardware durchführen und gezielt eine Optimierung implementieren (zum Beispiel effizientere Attention‑Kerne oder eine einfache Quantisierungsroutine). Solche Schritte zeigen, wie viel Aufwand nötig ist, um einen Prototypen produktreif zu machen.

Langfristig könnten Teile von tinygrad‑Ansätzen in hybride Workflows einfließen: klare, prüfbare Komponenten zum Prototyping und optimierte Laufzeitbibliotheken für Produktion. Für Lehrzwecke bleibt die Stärke von tinygrad bestehen: man lernt nicht nur Ergebnisse, sondern die Mechanik hinter jedem Ergebnis.

Fazit

Tinygrad ist kein Ersatz für großskalige Produktions‑Frameworks, aber ein sehr gutes Werkzeug, um die Kernprinzipien von Transformern praktisch zu verstehen. Wer sich für Modellarchitektur, Attention‑Mechanik und die Feinheiten von Autograd interessiert, findet hier ein direkt zugängliches Labor: die wichtigsten Bausteine sind sichtbar, änderbar und leicht zu debuggen. Gleichzeitig macht die begrenzte Feature‑Bandbreite klar, welche Schritte nötig sind, wenn ein Prototyp zur produktiven Anwendung werden soll. Für alle, die einen Mini‑GPT selbst bauen wollen, bleibt tinygrad ein sinnvoller Startpunkt — mit klaren Erwartungen an den weiteren Aufwand.

Wenn Ihnen dieser Artikel gefallen hat oder Sie eigene Erfahrungen mit tinygrad‑Transformer‑Implementierungen haben, freuen wir uns über Hinweise und das Teilen des Beitrags.

Schreibe einen Kommentar