Schlagwort: neuronale Netze

-

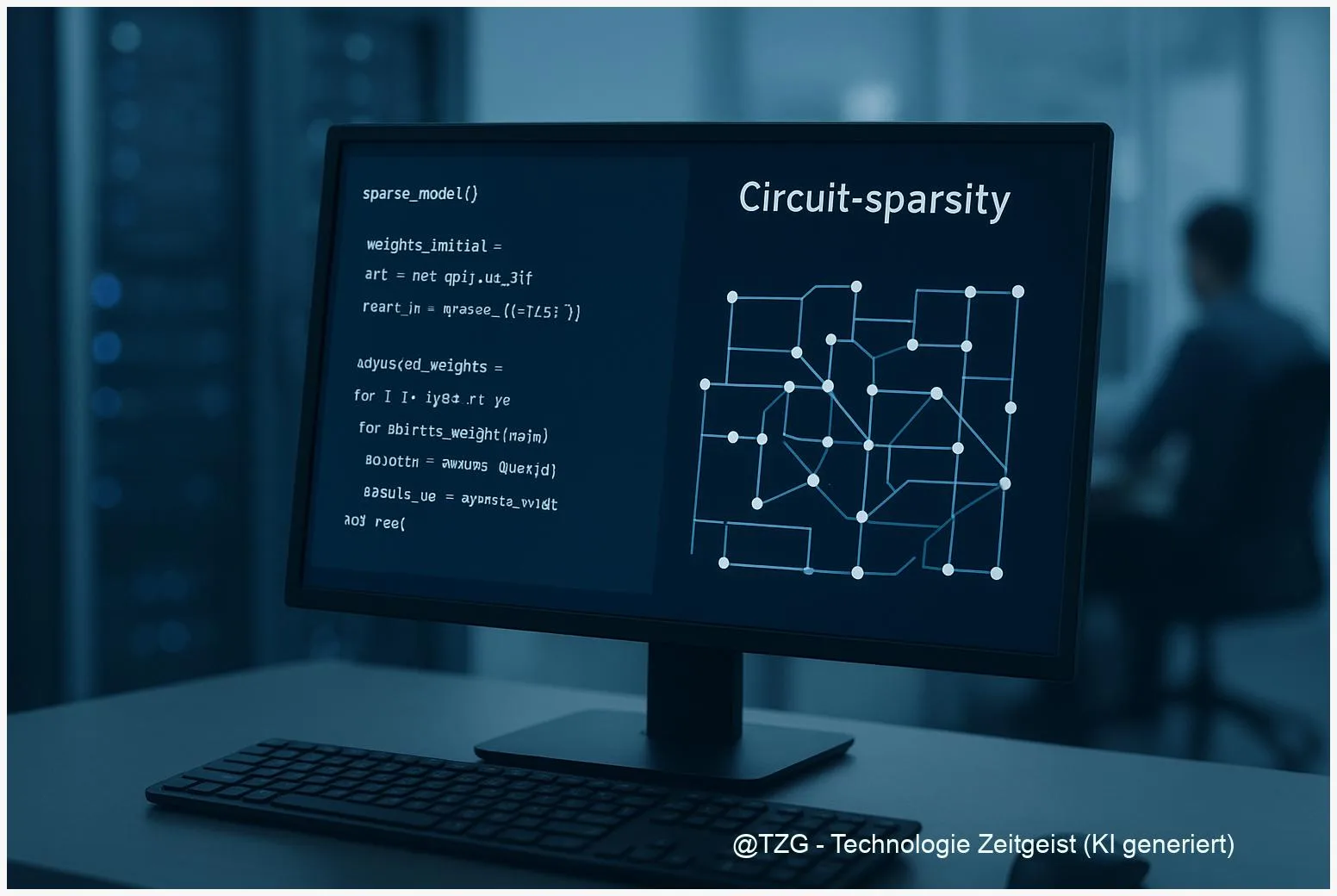

Circuit‑sparsity: Wie sparsames Training KI‑Modelle erklärbarer macht

Zuletzt aktualisiert: 14. December 2025 Berlin, 14. December 2025 Insights Circuit‑sparsity beschreibt ein Trainingsprinzip, bei dem ein Modell so viele Gewichte wie möglich auf null

5 KI‑Architekturen, die du verstehen solltest

Fünf grundlegende KI‑Architekturen prägen heute Forschung und Produkte: dichte Transformer‑Modelle (LLM), Vision‑Language‑Modelle, Mixture‑of‑Experts, große Aktionsmodelle und kompakte Modelle für Geräte. Wer sich mit KI beschäftigt,

KI‑Grundlagen verständlich: Wie Sprachmodelle arbeiten und was zählt

KI Grundlagen sind der Schlüssel, um zu verstehen, warum Sprachassistenten so plausibel wirken und welche Folgen das hat. In diesem Text erfahren Sie in kompakten

AlphaFold erklärt: Wie KI Proteinstrukturen vorhersagt

AlphaFold ist ein KI‑gestütztes System zur Proteinstruktur‑Vorhersage, das Forscherinnen und Forschern hilft, die Form von Eiweißen ohne aufwendige Versuchsaufbauten einzuschätzen. Die Vorhersagen liefern per‑Residue‑Konfidenz und

Generative Modelle einfach erklärt: Sampling, Mapping und ein klarer Vergleich

Generative Modelle beschreiben, wie Computer neue Daten erzeugen — von Bildern bis Texten. Dieses Stück zeigt, wie unterschiedliche Prinzipien wie Sampling und Mapping bei Variational

KI-gestützte Tests: Wie sie funktionieren, wann sie helfen und was zu beachten ist

KI-gestützte Tests beschleunigen die Erstellung von Prüfskripten und Testplänen durch den Einsatz von Sprachmodellen und automatisierten Heuristiken. Sie können Test-Templates erzeugen, Grenzfälle vorschlagen und in

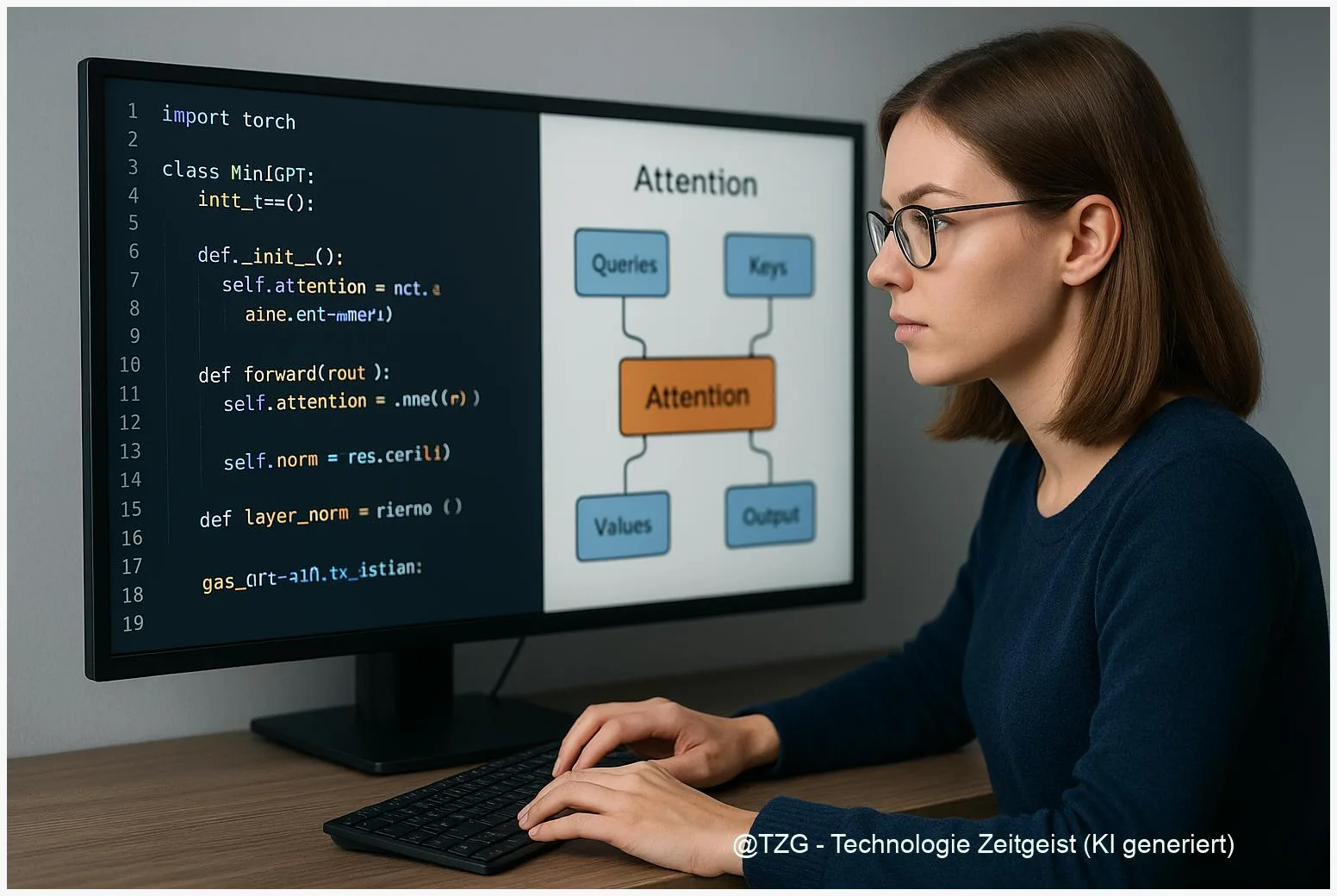

Tinygrad-Transformer verstehen: Komponenten eines Mini‑GPT Schritt für Schritt

Tinygrad Transformer verstehen Schritt für Schritt: Dieses Stück zeigt, wie die Kernelemente eines Transformer‑Modells in tinygrad zusammenwirken und welche Teile wirklich wichtig sind, wenn man

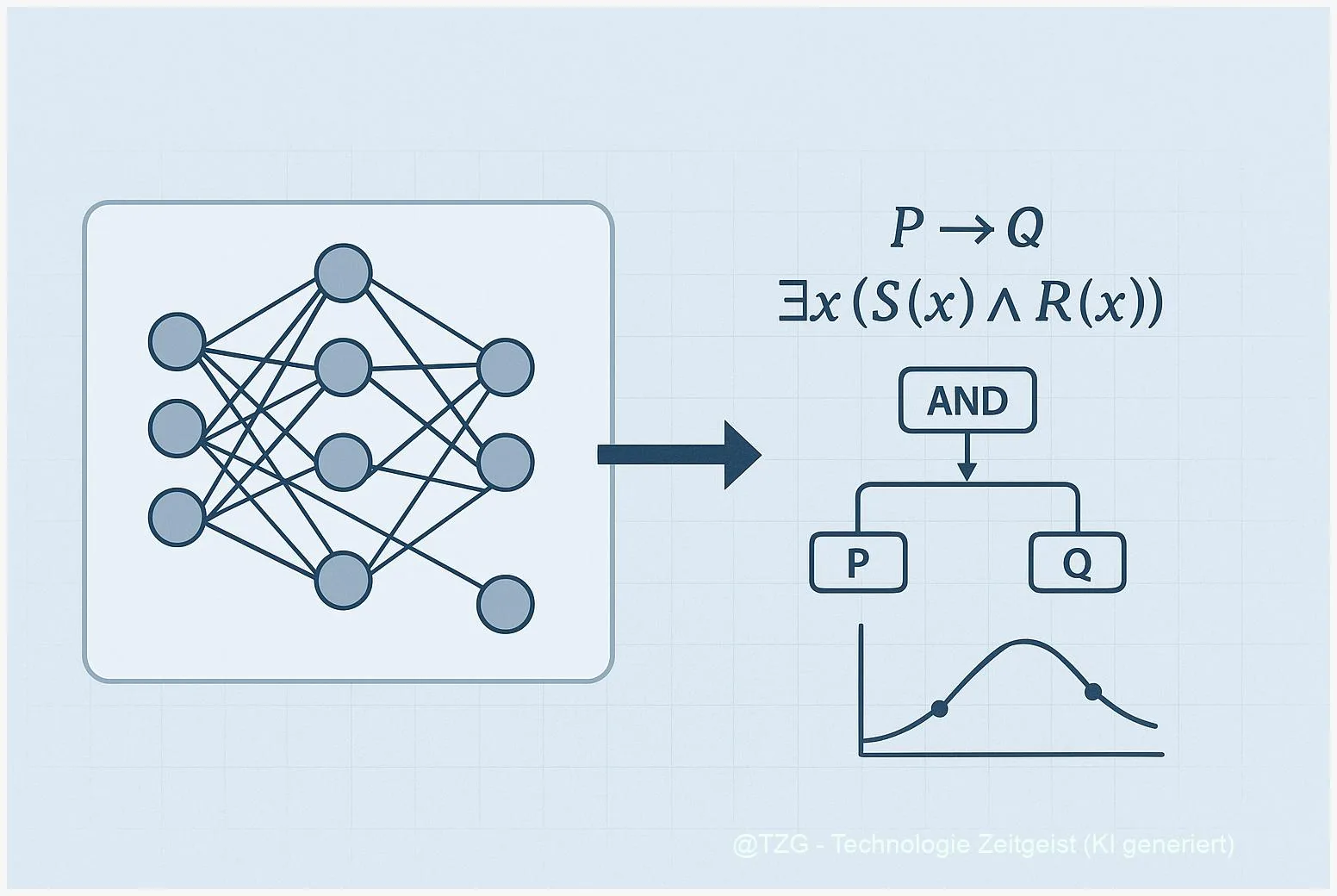

Neuro‑symbolische KI: Wie Lernen und Logik zusammenspielen

Neuro‑symbolische KI kombiniert neuronale Netze mit symbolischer Logik, um Lernen und strukturiertes Denken zu verbinden. Für viele Aufgaben – von visueller Erkennung bis zur Entscheidungsfindung

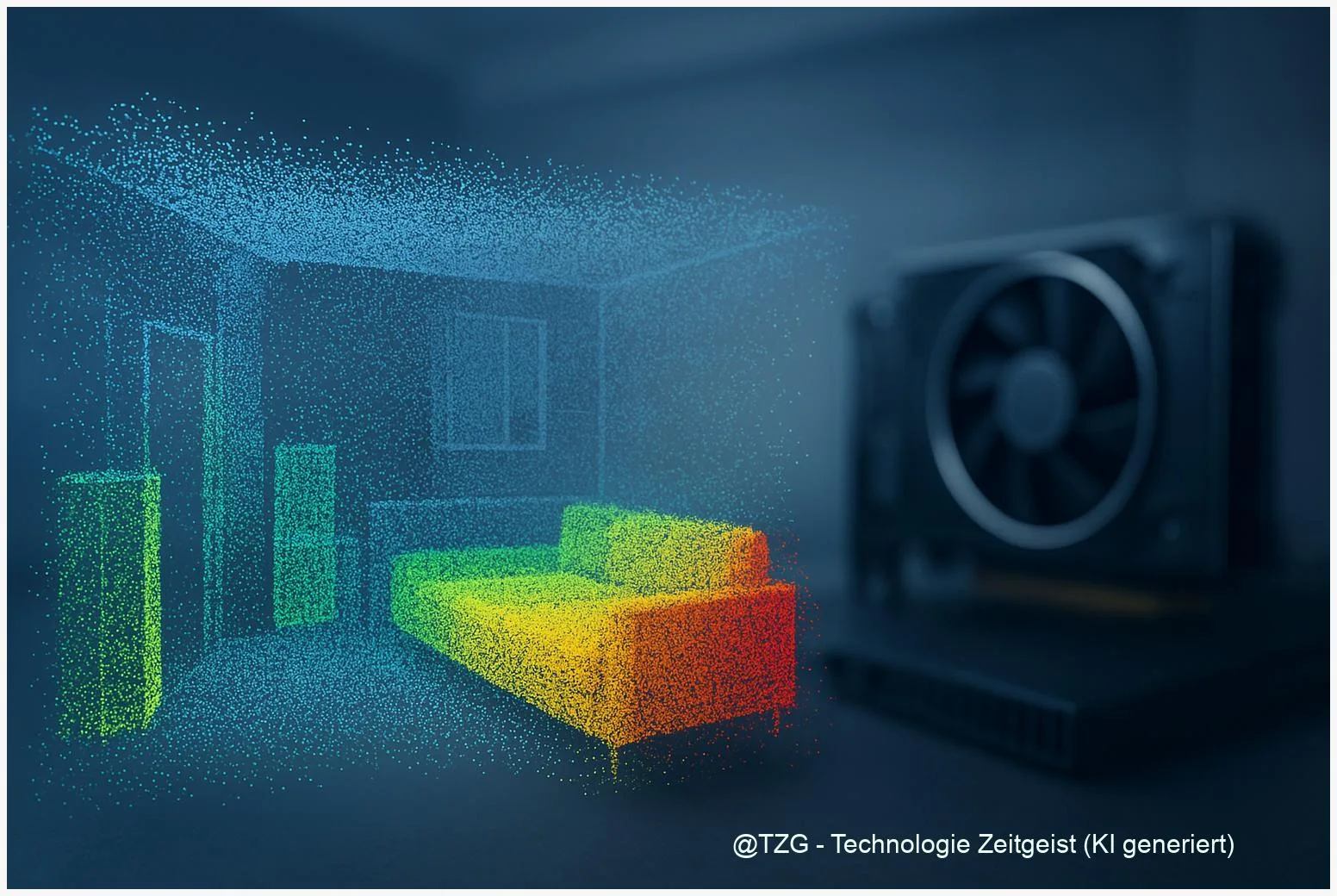

Wie Sie 3D‑Segmentierung beschleunigen: Sparse‑Convolutions praktisch nutzen

Sparse‑Convolutions sind ein wichtiger Hebel, um 3D‑Modelle schneller zu machen. Dieser Artikel erklärt, wie sich 3D‑Segmentierung beschleunigen lässt, wenn statt dichter Volumen rechnerisch nur belegte

Künstliche Intelligenz: Grundlagen und Alltagsnutzen

Insight Künstliche Intelligenz verändert unseren Alltag spürbar. Dieser Artikel erklärt die Grundlagen, zeigt praktische Anwendungen und beleuchtet Chancen sowie Risiken. Lesen Sie, wie KI-Systeme lernen,

MiniMax-M2-REAP deployment: Praxisguide für SMoE-Coding-Assistant

Zuletzt aktualisiert: 2025-11-16 Kurzfassung Dieser Praxisguide erklärt, wie ein ressourcenschonendes MiniMax-M2-REAP deployment für Coding‑Assistenten gelingt. Er erklärt die Grundidee der REAP‑Pruning‑Methode, nennt sinnvolle Prüfungen vor

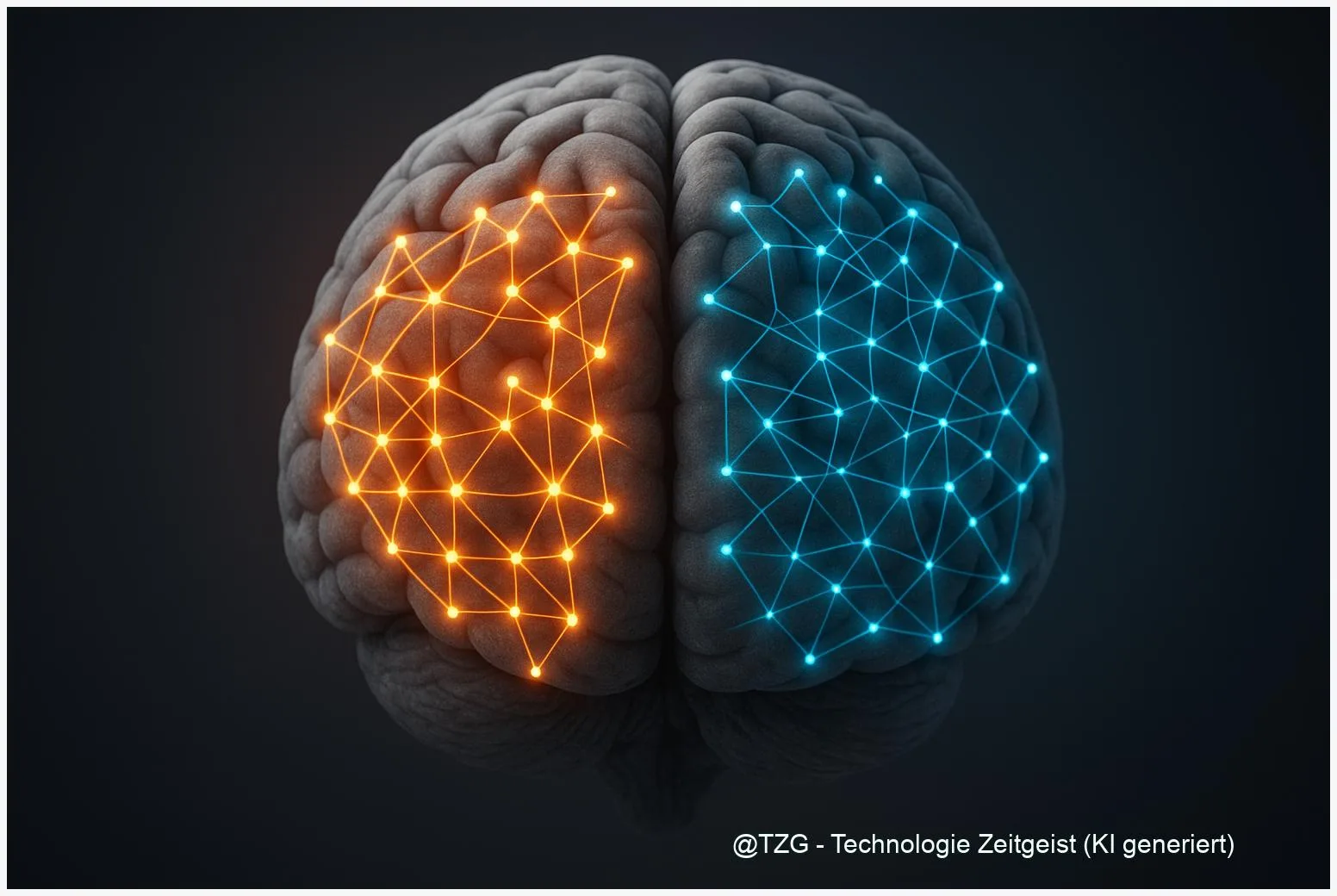

Memorization vs. Reasoning: Neural‑Pfade in LLMs verstehen

Zuletzt aktualisiert: 11. November 2025 Kurzfassung Forscher haben gezeigt, dass sich memorization vs reasoning neural pathways in modernen LLM‑Gewichten unterscheiden lassen. Die Goodfire‑Studie nutzt eine

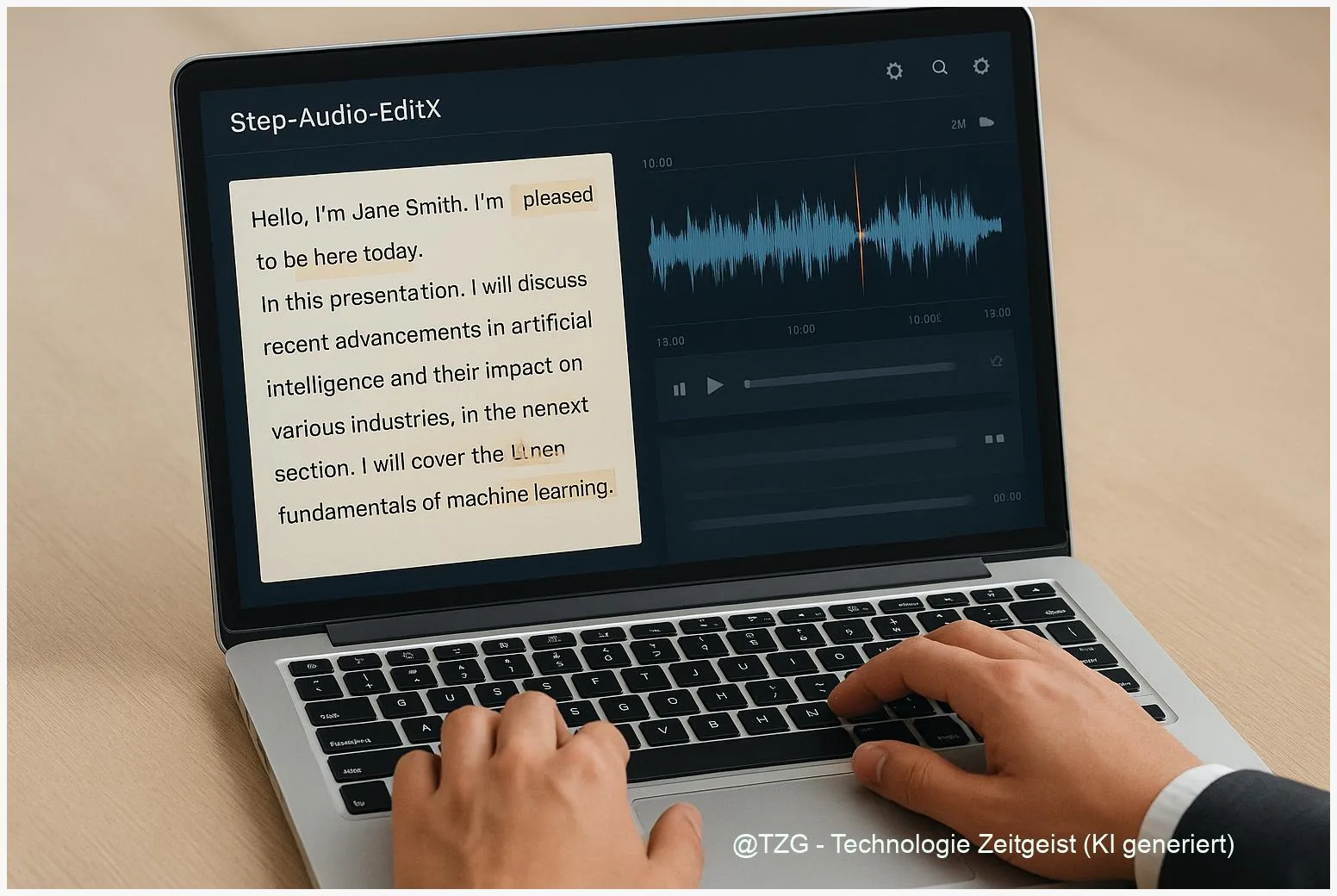

Text zu Stimme: Token‑Level Editing mit Step‑Audio‑EditX

Zuletzt aktualisiert: 10. November 2025 Kurzfassung Token‑level Audio Editing ermöglicht punktuelle Änderungen in Sprachaufnahmen — ohne die gesamte Datei neu aufzunehmen. Dieses Stück erklärt praktische

Nested Learning: Wie Modelle dem Vergessen entkommen

Zuletzt aktualisiert: 8. November 2025 Kurzfassung Nested Learning beschreibt Modelle als eine Reihe verschachtelter Optimierungsprobleme und bietet damit einen neuen Blick auf das Problem des

Deep Learning: Einblicke in neuronale Netze und ihre zentrale Rolle für KI und zukünftige Technologien

Deep Learning ist eine Schlüsselkomponente unserer digitalen Zukunft, die das Potenzial hat, die Art und Weise, wie wir leben, arbeiten und spielen, grundlegend zu verändern.