Skalierbare AI‑Dokumentenpipeline: Architektur und praktische Anleitung

Eine skalierbare AI Dokumentenpipeline hilft, große Mengen an Texten zuverlässig zu durchsuchen, relevante Passagen zu finden und darauf basierend präzise Antworten zu erzeugen. Sie verbindet Dokumenten‑Ingestion, Chunking, Embeddings, einen Vektor‑Store und eine Retrieval‑Schicht mit einem generativen Modell. Dieser Bericht beschreibt zentrale Architekturkomponenten, typische Designentscheidungen und bewährte Produktionsmuster, damit Teams Suchqualität, Latenz und Kosten in Balance halten können.

Einleitung

Unternehmen und Forschungsteams stehen oft vor der gleichen Frage: Wie gelangt man von tausenden Dokumenten zu zuverlässigen, schnellen Antworten? In vielen Anwendungen — Kundenservice, Compliance‑Checks oder interne Wissensdatenbanken — zählt nicht nur die korrekte Antwort, sondern auch die Wiederholbarkeit, Latenz und Betriebskontrolle. Eine Pipeline ordnet daher mehrere technische Stufen so, dass Daten sauber eingehen, semantisch erschlossen werden und beim Abruf die richtigen Textstücke geliefert werden.

Die Kunst liegt darin, Retrieval‑Methoden, Embeddings und das Sprachmodell so zu kombinieren, dass die Suche robust bleibt, ohne die Kosten explodieren zu lassen. Praktisch heißt das: bei niedriger Last reicht oft ein einfacher Hybrid‑Retriever; bei hohem Durchsatz sind Guardrails, Query‑Classification und eine straffe Observability‑Strategie entscheidend. Im Weiteren folgen konkrete Komponenten, Beispiele und Empfehlungen, die sich in Projekten bewährt haben.

Grundlagen einer skalierbaren AI Dokumentenpipeline

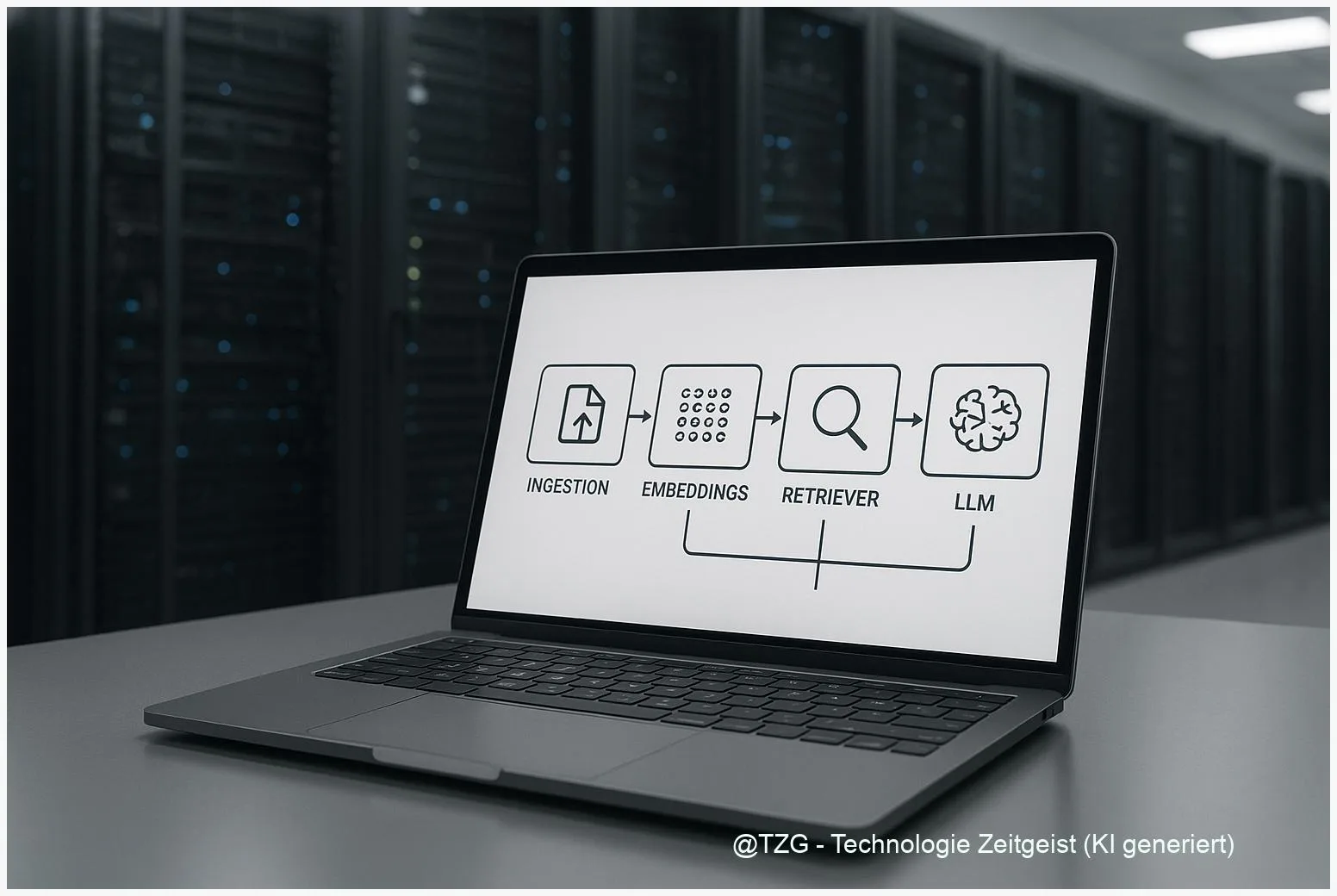

Eine grundlegende Pipeline besteht aus sechs Stationen: Ingestion, Parsing & OCR, Chunking/Tokenisierung, Embeddings, Index/Vector‑DB und Retrieval plus der Generationsebene (LLM). Jede Stufe hat eigene Qualitätsmetriken: zum Beispiel OCR‑Fehlerquote, durchschnittliche Chunk‑Länge, Embedding‑Dimension oder Recall@k beim Retrieval.

Gute Observability zeigt nicht nur Latenz und Fehlerraten, sondern auch, welche Dokumente tatsächlich für Antworten verwendet wurden.

Wichtig ist das Zusammenspiel: schlecht gechunkte Dokumente führen zu irrelevanten Embeddings; undefinierte Metadaten erschweren Filterung und Governance. Ein sauberes Design trennt PII vor dem Embedding, versieht Dokumente mit stabilen IDs (Hashes) und versieht Embedding‑Indizes mit Versionierung, damit bei Re‑Indexing nachvollziehbar bleibt, was sich geändert hat.

Die Tabelle zeigt typische Kernkomponenten und ihren Zweck.

| Merkmal | Beschreibung | Wert |

|---|---|---|

| Ingestion | Dokumente aufnehmen, OCR, Formatkonvertierung | Batch / Streaming |

| Embeddings | Semantische Repräsentation pro Chunk | 1536–3072 Dim. |

| Retriever | Dense / Sparse / Hybrid (BM25 + ANN) | Hybrid (Default) |

| Reranker | Feinere Relevanzbewertung vor LLM‑Aufruf | monoT5 / kleiner TILDEv2 |

Für die meisten Produktionsfälle ist ein Hybrid‑Retrieval ein robuster Default, kombiniert mit einem schnellen Reranker, falls die Latenz das zulässt. Embedding‑Versionierung und ein kleines Ground‑Truth‑Set mit nDCG@k/R@k sorgen für automatische Qualitätskontrollen.

Vom Dokument zur Suche: Praxis und Beispiele

In der Praxis beginnt der Aufwand bereits bei der Ingestion: Scans brauchen OCR, Tabellen benötigen spezielle Verarbeitung, und Metadaten (Datum, Autor, Sprache) verbessern späteres Filtern. Ein gängiger Ablauf ist: (1) Rohtext extrahieren, (2) semantisch sinnvolle Chunks erzeugen (typischerweise 256–1024 Tokens), (3) Metadaten anhängen, (4) Embeddings berechnen und in den Index schreiben.

Ein konkretes Beispiel: Eine Kundenservice‑Wissensdatenbank enthält Produktleitfäden, E‑Mails und FAQs. Durch sentence‑level Chunking und das Anhängen von Dokumentenmetadaten lässt sich bei einer Frage die genaue Passage mit hoher Wahrscheinlichkeit finden. Hybrid‑Retrieval (BM25+dense) verbessert Treffer in Fällen mit vielen gleichen Formulierungen; bei Tabellen oder numerischen Daten führt das Ergänzen der Zeilen mit Header‑Text zu deutlich besserer Auffindbarkeit.

Ein weiteres praktisches Muster sind Guardrails: Statt bei jeder Anfrage das LLM zu rufen, bewertet ein Intent‑Classifier die Notwendigkeit. Für einfache Informationsabrufe reicht oft eine Antwort aus zuvor gespeicherten FAQ‑Snippet‑Fenstern; nur komplexe Anfragen triggern vollständige RAG‑Prompts. Damit sinken Kosten und Latenz spürbar.

Monitoring in dieser Phase umfasst: Recall@k, Re‑retrieval‑Rate (wenn LLM zusätzliche Dokumente anfragt), Token‑Kosten per Query und Fehlerraten bei OCR/Parsing. Alerts für Drift (qualitative Verschlechterung der Treffer) sind wichtig, damit Teams Index‑Regeneration, Prompt‑Tuning oder neue Trainingsdaten planen können.

Chancen, Risiken und typische Spannungsfelder

Die Chancen liegen in schneller Zugänglichkeit zu Wissen, automatisierter Antwortgenerierung und der Möglichkeit, große Mengen historischer Dokumente nutzbar zu machen. Für Forschung und Support kann das die Effizienz deutlich steigern; in manchen Benchmarks sehen Teams deutliche Verbesserungen gegenüber reiner Stichwortsuche.

Risiken ergeben sich an mehreren Stellen: Halluzinationen des LLM, fehlerhafte OCR, falsch gesetzte Metadaten und Datenschutzprobleme bei PII in Embeddings. Besonders kritisch ist, dass Embeddings einmal erzeugt, oft lange Zeit verwendet werden; wer PII versehentlich einbettet, riskiert Datenschutzverstöße.

Ein weiteres Spannungsfeld ist Latenz vs. Qualität. Methoden wie HyDE‑Pseudo‑Doc‑Generierung und tiefe Reranker erhöhen die Genauigkeit, können aber die Abfragezeit deutlich steigern. In experimentellen Setups wurden Latenzen von mehreren Sekunden beobachtet; optimierte Cloud‑Setups können das allerdings auf etwa 1–2 s/Query reduzieren — das ist stark infraabhängig.

Evaluation ist eine Herausforderung: Automatisierte LLM‑Bewertungen (“LLM as judge”) zeigen in einigen Studien hohe Übereinstimmung mit menschlichen Bewertungen, doch zentrale Benchmarks stammen teils aus 2023 und sind damit älter als zwei Jahre; solche Ergebnisse sollten mit aktuellen Stichproben validiert werden.

Wie sich Systeme in den nächsten Jahren entwickeln könnten

In den kommenden Jahren ist mit drei Entwicklungen zu rechnen: bessere Hybrid‑Retriever, effizientere On‑Device Embeddings und stärkere Produktionsautomatisierung (MLOps für Index‑Lifecycle). Hybrid‑Strategien, also die Kombination aus BM25 und dichten Embeddings, werden weiterhin ein guter Default bleiben.

Für Teams bedeutet das: in frühen Phasen auf einfache, gut beobachtbare Pipelines setzen und nach Bedarf komplexere Bausteine hinzufügen. Guardrails und Query‑Classification können helfen, Kosten zu kontrollieren; kompakte Summarizer vor dem LLM reduzieren Kontextlänge und damit Token‑Kosten.

Technisch ist außerdem zu erwarten, dass Reranker und kleine spezialisierte Modelle stärker in die Retrieval‑Schicht wandern, um teure LLM‑Aufrufe zu reduzieren. Das macht die Systemlandschaft modularer: mehr Modelle, aber feinere Verantwortlichkeiten. Für Betreiber heißt das, dass Automatisierung bei Re‑Indexing, Metrik‑Alerting und Governance an Bedeutung gewinnt.

Für Entwickler bleibt ein zentrales Prinzip gültig: Iterativ messen, kleine Experimente fahren und Architekturentscheidungen an konkreten SLOs ausrichten. So lassen sich Qualität, Kosten und Betrieb entlang klarer Kriterien in Balance halten.

Fazit

Eine skalierbare AI Dokumentenpipeline vereint mehrere technische Disziplinen: Datenaufbereitung, semantische Repräsentation, Retrieval und generative Modelle. Praktisch zahlt sich ein schrittweises Vorgehen aus: mit einfachen, gut überwachten Komponenten starten, Hybrid‑Retrieval als Default nutzen und Guardrails einbauen, um Latenz und Kosten zu begrenzen. Kontinuierliches Monitoring und ein kleines Ground‑Truth‑Set helfen, Drift rechtzeitig zu erkennen. Wer diese Prinzipien beachtet, schafft eine Lösung, die heute nützlich ist und sich mit wachsendem Datenbestand anpassen lässt.

Diskutieren Sie gern Ihre Erfahrungen mit Retrieval‑Systemen und teilen Sie diesen Beitrag, wenn er hilfreich war.