KI-Singularität: nüchterner Überblick zu Fakten, Prognosen und Risiken – von sinkenden Inferenzkosten bis zu realen Fähigkeiten. Verständlich, aktuell, einordnend.

Kurzfassung

Die KI-Singularität fasziniert – doch was sagen Daten statt Bauchgefühl? Dieser Artikel bündelt belastbare Kennzahlen, Prognosen und Evaluationsbefunde: von rasant fallenden Inferenzkosten über wachsenden Trainings-Compute bis zu Zeithorizonten von 2027 bis 2045. So ordnen wir die KI-Singularität realistisch ein und trennen Vision von Wirklichkeit.

Einleitung

Die Inferenzkosten für ein GPT‑3.5‑ähnliches Leistungsniveau fielen zwischen November 2022 und Oktober 2024 von etwa 20 US‑$ auf 0,07 US‑$ je Million Tokens (Stand: Okt 2024) (Stanford AI Index 2025).

Dieser Sturzflug verändert, wer KI nutzen kann, und heizt Debatten um die KI‑Singularität an: den Punkt, an dem Systeme unsere kognitive Entwicklung rasant überholen. Bevor wir mit großen Worten jonglieren, schauen wir nüchtern auf Zahlen, Zeitachsen und echte Fähigkeiten – und sortieren Erwartungen von Evidenz.

Was wir unter Singularität fassen – und was messbar ist

Singularität wird oft als Kipppunkt beschrieben, ab dem KI schneller als Menschen eigene Fähigkeiten steigert. Weil das schwer zu definieren ist, arbeiten wir mit beobachtbaren Indikatoren: Rechenaufwand, Kosten und Fähigkeiten. Der Trainings‑Compute „bedeutender“ Modelle verdoppelt sich laut AI Index ungefähr alle fünf Monate (Stand: 2024/2025) (AI Index 2025, PDF).

Selbst ohne exakte Schwelle ist die Richtung klar: mehr Rechenleistung, mehr Möglichkeiten – und neue Risiken.

„Singularität ist keine einzelne Zahl – sie ist ein Cluster aus Trends: Skalierung, fallende Kosten, wachsende Autonomie. Messbar wird sie, wenn diese Linien zusammenlaufen.“

Damit nicht nur Bauchgefühl spricht, brauchen wir Tabellen und Tests. Die folgende Übersicht bündelt drei harte Signale: Compute‑Wachstum, Kostenrutsch und Forecasts. Jedes Signal für sich ist kein Beweis. Zusammen zeigen sie, weshalb der Begriff in den Mainstream rutscht – und warum Vorsicht bleibt.

| Signal | Kurzbeschreibung | Zahl/Quelle |

|---|---|---|

| Compute‑Skalierung | Verdopplungszeit für Trainings‑Compute großer Modelle | ≈5 Monate (Stand: 2024/2025) (AI Index 2025). |

| Inferenzkosten | Kostenrückgang pro 1 Mio. Tokens (Leistungsniveau ≈ GPT‑3.5) | 20 US‑$ → 0,07 US‑$ (Nov 2022 → Okt 2024) (AI Index 2025). |

| Zeithorizont | Median‑Forecast für „weakly general AI announced“ | 27. Mai 2027 (Stand: Q3 2025) (Metaculus). |

Rein rechnerisch bedeutet eine Verdopplungszeit von fünf Monaten, dass die benötigte Rechenleistung in einem Jahr um etwa den Faktor 5,3 wächst. Diese Dynamik liegt den AI‑Index‑Analysen zugrunde, die zugleich auf steigende absolute Trainingsaufwände und Emissionen an der Frontier hinweisen (Stand: 2024/2025) (AI Index 2025).

Singularität bleibt damit weniger Mythos als Frage, wie lange diese Kurven halten – technisch, ökonomisch, politisch.

Zeithorizonte: Forecasts, Kurzweil und die Spanne 2027–2045

Wer die KI‑Singularität zeitlich fassen will, landet schnell bei Forecasts. Die Metaculus‑Community sieht den Median für die öffentliche Ankündigung einer „weakly general AI“ am 27. Mai 2027; die Chance, dass ein großes Labor schon 2025 AGI beansprucht, wird nur mit etwa 1 % bewertet (Stand: Q3 2025) (Metaculus – Datum) (Metaculus – 2025‑Claim).

Das klingt bodenständig und widerspricht dem Bauchkribbeln, das viele beim täglichen KI‑Fortschritt spüren.

Auf der anderen Seite steht Ray Kurzweil, der seit Jahrzehnten exponentielle Technologiekurven verfolgt. Er hält in „The Singularity Is Nearer“ an zwei Daten fest: menschliches Leistungsniveau um 2029, umfassende „Singularität“ um 2045 (Stand: 2024) (The Guardian).

Die Spanne 2027 bis 2045 ist groß – aber sie entsteht aus unterschiedlichen Definitionen und Methoden: Community‑Forecasts für beobachtbare Ereignisse versus eine breite Vision technologischer Verschmelzung.

Was lässt sich daraus praktisch ableiten? Erstens: Kurzfristige Überschriften über „das Jahr der AGI“ sind mit Skepsis zu lesen. Die ~1 %‑Einschätzung für 2025 signalisiert, dass Vorhersager:innen selbst bei raschem Fortschritt nicht von einer unmittelbaren AGI‑Behauptung durch ein Top‑Labor ausgehen (Stand: Q3 2025) (Metaculus).

Zweitens: Mittelfristig liegen Kurzweils 2029‑These und der 2027‑Median gar nicht weit auseinander. Das spricht dafür, Notfall‑Pläne jetzt aufzusetzen – nicht erst, wenn Schlagzeilen kommen.

Drittens: Zeithorizonte bleiben beweglich, weil sie an Messgrößen hängen. Wenn Inferenzkosten binnen zwei Jahren über 280‑fach sinken (Stand: Okt 2024) (AI Index 2025),

kann die Nutzung explodieren – ohne dass die zugrundeliegende Autonomie schon „allgemein“ wäre. Eine reife Strategie hält diese Spannungen aus: Sie investiert in robuste Evaluations‑Infrastruktur und baut Frühwarnindikatoren, statt auf ein einziges Datum zu wetten.

Fähigkeiten heute: Was unabhängige Tests wirklich zeigen

Zwischen Vision und Wirklichkeit liegen Benchmarks. Das UK AI Safety Institute (AISI) hat im Mai 2024 fünf fortgeschrittene LLMs über Biologie/Chemie, Cyber‑Sicherheit, Agenten‑Aufgaben und Schutzmechanismen geprüft und dabei >600 private Expert:innen‑Fragen in Bio/Chem eingesetzt (Stand: Mai 2024) (AISI).

Die Ergebnisse sind zweischneidig: beeindruckend in Nischen, labil bei Schutz und Langzeit‑Planung.

In Cyber‑Tests lösten einige Modelle über 50 % der einfachen CTF‑Aufgaben, scheiterten aber an anspruchsvolleren Uni‑Niveaus (Stand: Mai 2024) (AISI).

In Agenten‑Szenarien zeigen sie Kurzstrecken‑Planung, stolpern jedoch bei stabiler Autonomie über längere Zeiträume. Und die Schutzmechanismen? AISI dokumentiert, dass alle getesteten Modelle für vergleichsweise einfache „Jailbreaks“ verwundbar blieben; in wenigen Versuchen pro Modell trat mindestens einmal eine gefährliche Antwort auf (Stand: Mai 2024) (AISI).

Was heißt das für die Singularität? Erstens: Hohe Punktzahlen auf Prüfungsfragen – teils „PhD‑ähnlich“ – bedeuten nicht automatisch generelle Problemlösung. AISI betont einen „Evaluation‑Gap“ zwischen beeindruckenden Antworten und robuster, sicherer Performanz in offeneren Aufgaben (Stand: Mai 2024) (AISI).

Zweitens: Selbst ohne AGI‑Status entstehen heute schon Risiken in Bio/Chem und Cyber, die Governance erfordern – von Zugriffskontrollen bis zu kontinuierlichen Tests außerhalb von Marketing‑Benchmarks.

Drittens: Fortschritt kann ungleichmäßig sein. Modelle werden in Fachdomänen gefährlich gut, während sie gleichzeitig banalen Trickfragen erliegen. Für Unternehmen und Behörden ist das eine doppelte Hausaufgabe: Teams müssen Fähigkeiten streng eingrenzen und Absicherungen härten. Parallel braucht es Lernkurven für Nutzer:innen – weil Prompt‑Technik und Gegenmaßnahmen ständig nachziehen.

Ökonomie der Skalierung: Kosten, Compute und Grenzen

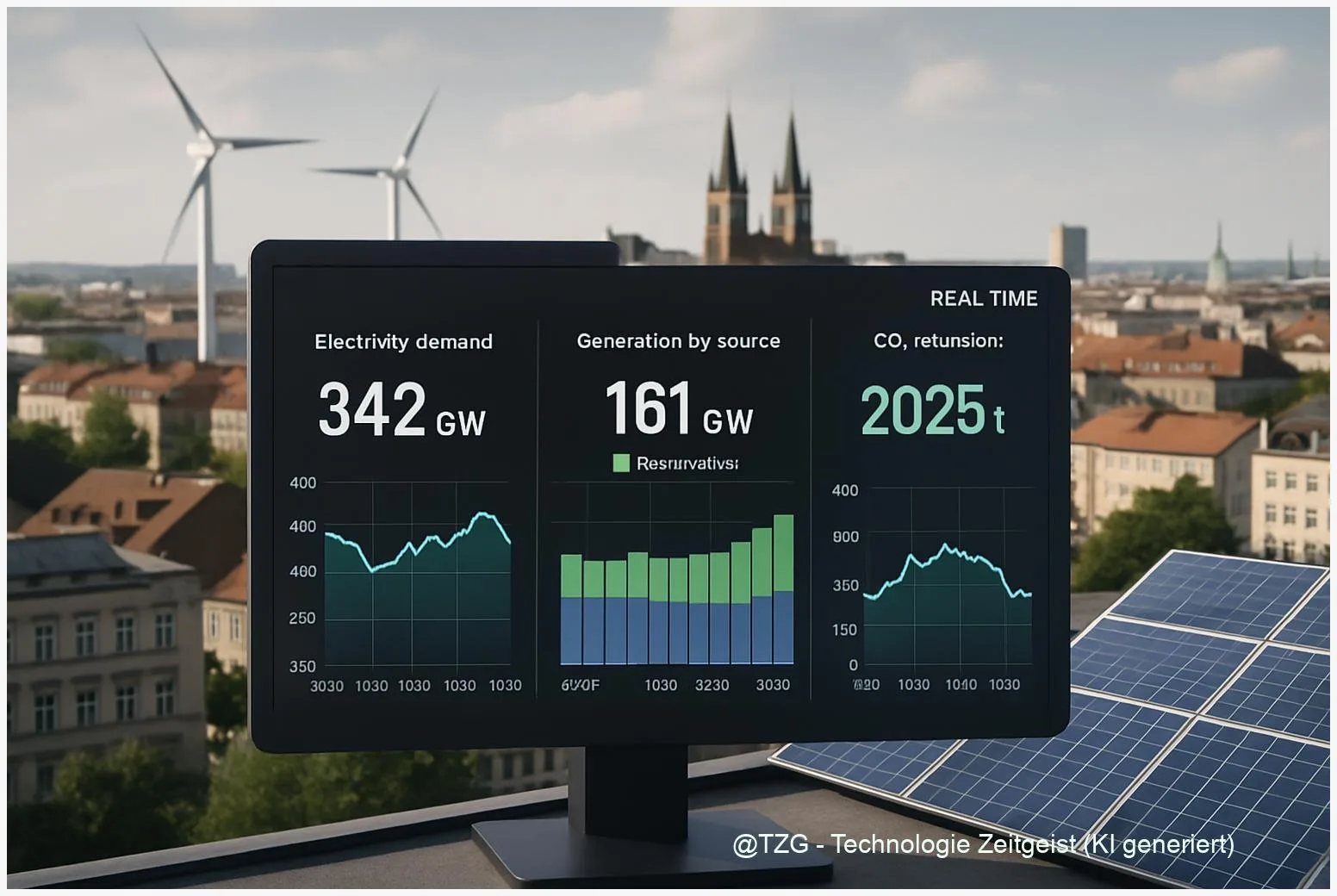

Singularität wird gern philosophisch diskutiert, aber bezahlt wird sie in Rechenzentren. Wenn sich der Trainings‑Compute an der Frontier etwa alle fünf Monate verdoppelt (Stand: 2024/2025) (AI Index 2025),

steigen Kapitalbedarf und Energieverbrauch an der Spitze schnell. In einem Jahr entspricht das grob 5,3‑fachen Compute – eine Hypothek für jeden, der mithalten will. Gleichzeitig setzt der Markt andere Anreize: Die Inferenzkosten pro 1 Mio. Tokens sanken binnen zwei Jahren von ~20 US‑$ auf 0,07 US‑$ (Stand: Nov 2022 → Okt 2024) (AI Index 2025).

Dieses Spannungsfeld erklärt, warum „mehr KI“ sich gleichzeitig teurer und günstiger anfühlt: Trainingsläufe werden für wenige Akteure zur Hochrisiko‑Wette; die Nutzung wird massenhaft billiger. Der AI‑Index vermerkt parallel steigende absolute Emissionen für größte Modelle, trotz Effizienzgewinnen (Stand: 2024/2025) (AI Index 2025).

Für Entscheider:innen heißt das: Budgets trennen (Trainings‑CapEx vs. Inferenz‑OpEx), Effizienzmethoden priorisieren und Nachhaltigkeit messen.

Wo liegen die Grenzen? Physikalisch in Energie und Kühlung; ökonomisch in knappen High‑End‑Chips; politisch in Zulassungen und Exportkontrollen. Strategisch sollten Organisationen zweigleisig fahren: erstens „klein, schnell, sicher“ (kompakte Modelle, Distillation, Quantisierung), zweitens selektive Partnerschaften für Frontier‑Zugriff. Und immer mit Blick auf die Zeitachsen: Community‑Forecasts geben der öffentlichen „weakly general“ Ankündigung einen Median 2027 (Stand: Q3 2025) (Metaculus),

während Kurzweil die eigentliche Singularität näher bei 2045 verortet (Stand: 2024) (The Guardian).

Zwischen diesen Polen entscheiden Investitionen heute, wie belastbar unsere Infrastruktur morgen ist.

Die KI‑Singularität ist damit weniger „Ereignis“ als Pfad. Wer ihn klug geht, baut Evaluations‑Ökosysteme auf, testet kontinuierlich gegen Missbrauch und nutzt die Kostendelle verantwortungsvoll – statt ihr blind zu vertrauen.

Fazit

Die Debatte um die KI‑Singularität gewinnt, wenn wir sie mit Evidenz erden: rasant sinkende Inferenzkosten, schnell wachsender Trainings‑Compute, real messbare Fähigkeiten – und seriöse Unsicherheiten in den Zeitachsen. 2025 ist nicht „das Jahr der AGI“, aber 2027 bis 2029 rücken in den Bereich plausibler Vorankündigungen. Wer jetzt Resilienz baut, begegnet 2045 gelassener.

Abonniere unseren Tech‑Briefing‑Newsletter und erhalte monatlich klare Analysen, Zahlen und Tools für deine KI‑Strategie.

Schreibe einen Kommentar