Mit KI-generierten Fakes wächst die Gefahr von Desinformation rasant. Anhand von praktischen Hinweisen und wissenschaftlicher Expertise zeigt dieser Artikel, wie Sie KI-Bilder und Deepfake-Videos selbst entlarven und warum digitale Medienkompetenz gerade jetzt so wichtig ist.

Inhaltsübersicht

Einleitung

KI-Fakes auf dem Vormarsch: Wieso und wie sie entstehen

Die Schwachstellen der KI: Wie Experten Deepfakes aufdecken

Die Zukunft der Fake-Erkennung: Chancen und Herausforderungen

Manipuliertes Vertrauen: Folgen für Demokratie, Wahrheit und unser Gedächtnis

Fazit

Einleitung

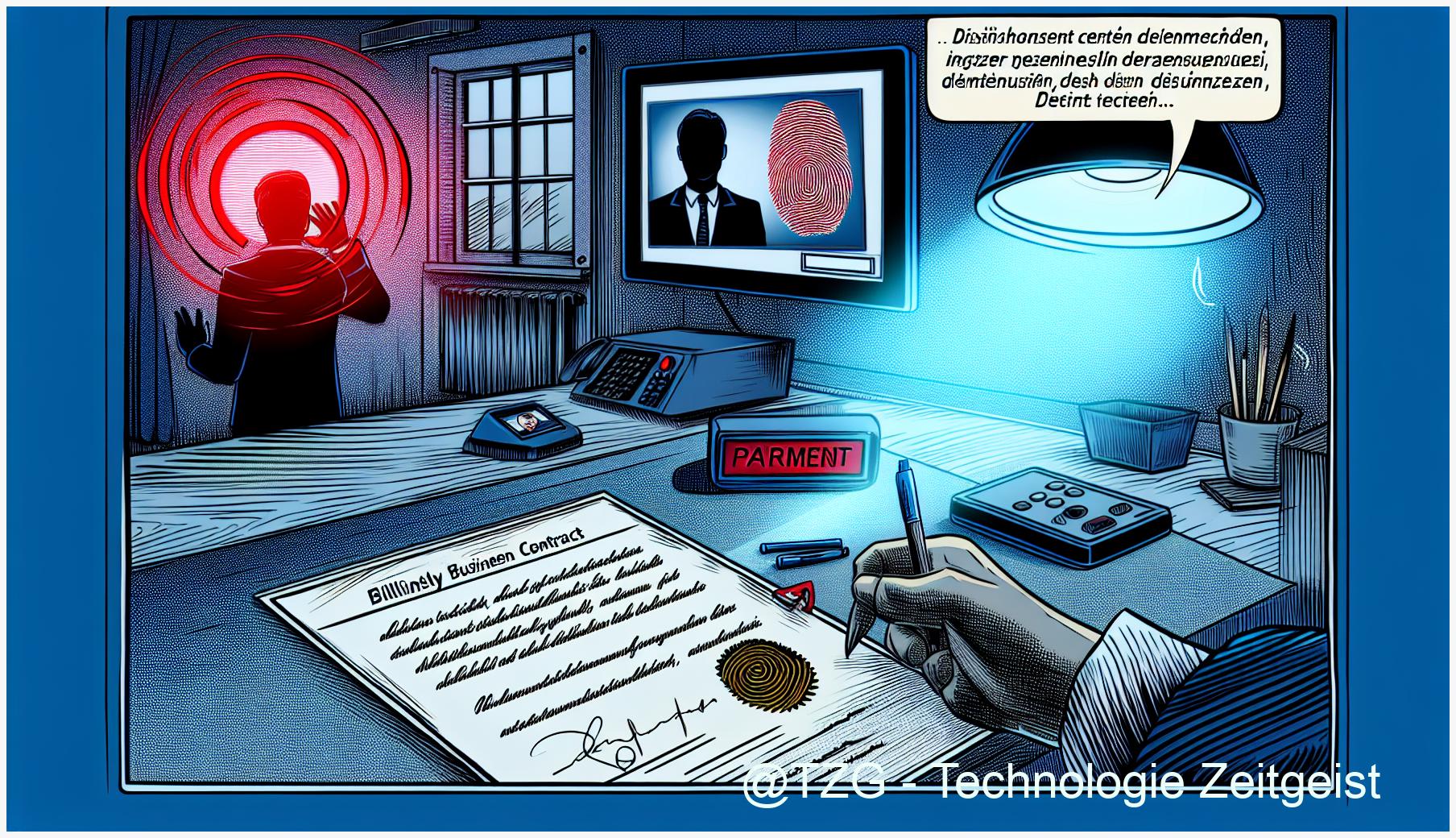

Täuschend echte Deepfakes gehen um die Welt – Videos, Fotos, Stimmen: Mit wenigen Klicks lassen sich heute täuschend echte Fälschungen erstellen. Die Technologie hinter diesen KI-generierten Fakes ist so ausgereift, dass selbst Profis manchmal ins Grübeln kommen. Damit wächst die Gefahr von Desinformation, Manipulation und Vertrauensverlust. Doch wie erkennt man ein Fake, das perfekt aussieht? Welche Merkmale sind verdächtig und was empfehlen Forensik- und Mediensicherheitsexperten? In diesem Artikel liefern wir Ihnen den klaren Fakten-Check, Hintergrundinfos zu den Tricks der KI und handfeste Expertentipps zum Erkennen von Fälschungen – inklusive Blick auf künftige Entwicklungen im digitalen Katz-und-Maus-Spiel.

Deepfakes erkennen: KI-Fakes boomen durch technische Fortschritte und globale Vernetzung

Deepfake erkennen ist wichtiger denn je: Dank Fortschritten in künstlicher Intelligenz und der allgegenwärtigen medialen Vernetzung ist die Zahl KI-generierter Fakes zuletzt exponentiell gestiegen. Laut einer Studie der Oxford Internet Institute wurden 2023 weltweit über 500.000 Deepfake-Videos im Netz identifiziert – eine Verfünffachung innerhalb von nur drei Jahren. In der zunehmenden Desinformation spielt neben raffinierter Technik auch die rasante Verbreitung über soziale Netzwerke eine entscheidende Rolle.

Weshalb KI-Fakes heute so schnell entstehen

Die Kombination aus leistungsfähigen neuronalen Netzen (vor allem sogenannten Generative Adversarial Networks, GANs) und offenen Deepfake-Tools macht die Produktion täuschend echter Fälschungen für Privatnutzer wie für Kriminelle leicht zugänglich [McAfee]. Plattformen wie DeepFaceLab, FaceSwap oder sogar Smartphone-Apps wie Reface bieten intuitive Oberflächen, sodass für die Erstellung von Deepfakes kaum technisches Wissen nötig ist. Über Messenger, TikTok oder Telegram verbreiten sich diese Clips in wenigen Minuten millionenfach. Dies erschwert die Bekämpfung von Desinformation und fordert neue Strategien zur Medienkompetenz.

Überblick: Zentrale Deepfake-Technologien

- GANs (Generative Adversarial Networks): Ermöglichen realitätsnahe Bild- und Video-Manipulationen

- Autoencoder/Decoder: Verschlüsseln und rekonstruieren Gesichter für Live-Überblendungen

- KI-Plattformen mit Open-Source-Charakter (z.B. DeepFaceLab, Faceswap)

Das Oxford Internet Institute und die MIT Technology Review berichten: Der gesellschaftliche Schaden reicht von politischer Manipulation, Erpressung bis zum Vertrauensverlust in digitale Inhalte. 2024 warnen Forensiker vor einer “Gefährdung der demokratischen Willensbildung”, sobald Deepfakes Wahlkämpfe beeinflussen.

Ausblick: Im nächsten Kapitel zeigen wir, wie Experten und forensische Teams die Schwachstellen der KI ausnutzen, um Deepfakes zu entlarven – und wie Sie sich gezielt schützen können.

Die Schwachstellen der KI: Wie Experten Deepfakes aufdecken

Deepfake erkennen setzt heute auf digitale Forensik und KI-gestützte Detektionsverfahren. Trotz technischer Fortschritte bleiben KI-generierte Fakes im Alltag erkennbar: Experten orientieren sich in der Analyse gezielt an typischen Mustern, Fehlerquellen und Artefakten. Laut aktuellen Studien wie Deepfake-Eval-2024 sinkt die Detektionsrate herkömmlicher Tools bei realen Social-Media-Deepfakes um bis zu 50 %, was die Herausforderung unterstreicht.

Typische Merkmale und Auffälligkeiten von Deepfakes

- Anatomische Unstimmigkeiten: Verzerrte Ohren, unscharfe Zahnreihen, unnatürliche Mimik oder ein fehlendes Blinzeln.

- Inkonsistente Schatten und Reflexionen: Lichtquellen, Schatten oder Spiegelungen stimmen oft nicht überein.

- Bild- und Tonartefakte: Verschwommene Übergänge, plötzliche Pixelbrüche, abgehackte Audiosegmente, Frequenzmuster außerhalb menschlicher Stimme (z.B. in politischen Deepfake-Audios aufgedeckt [DW]).

Tools, Verfahren und Standards in der digitalen Forensik

- Deepfake-Eval-2024: Ein KI-basierter Benchmark, trainiert auf aktuellen, realen Deepfake-Datensätzen (arXiv 2024).

- Forensische Bildanalyse: Prüft Metadaten, digitale Wasserzeichen und Bild-Konsistenz mit Spezialsoftware (z.B. Amped Authenticate, Serelay).

- Manuelle Expertenprüfung: Auffinden subtiler Artefakte und Abgleich mit Referenzbildern.

- Vertrauensindikatoren: Standardisierte Prüfmodelle und ISO-Normen, Transparenz über Quellen, Herkunft und Bearbeitungsschritte (Bundesregierung 2024).

Digitale Forensik entwickelt sich dynamisch, dennoch ist die Medienkompetenz der Nutzer entscheidend, um Desinformation zu bekämpfen. Professionelle Tools wie die von Fraunhofer und BVDW empfohlenen Systeme sind im Alltag häufig noch weniger verbreitet, doch sie erhöhen die Chancen, Deepfakes zuverlässig zu entlarven.

Im nächsten Kapitel beleuchten wir, wie die Zukunftstechnologien zur Fake-Erkennung aussehen, welche Chancen und Risiken sie bringen – und welche Kompetenzen künftig unverzichtbar werden.

Die Zukunft der Fake-Erkennung: KI, neue Methoden und gesellschaftliche Herausforderungen

Deepfake erkennen wird zunehmend zu einer Hightech-Aufgabe: Künstliche Intelligenz, speziell neuronale Netzwerke wie CNNs und Transformer-Modelle, prägen die nächste Generation der Deepfake-Detektion [ScienceDirect 2025]. Diese Systeme analysieren heute Bildstrukturen, Frequenzmuster und sogar die Synchronisation von Lippenbewegungen und Tonspuren – Technologien, die Fälschungen aufdecken und gleichzeitig ständig weiterentwickelt werden müssen.

Neue Methoden und zentrale Herausforderungen

- Multimodale Analyse: Verknüpfung von Bild-, Audio- und Metadaten zur erhöhten Erkennungssicherheit [BigData-Insider].

- Digital Fingerprinting: Referenzdatenbanken zur Überprüfung digitaler Echtheit.

- Standardisierung: Experten und Verbände wie ENISA, IEEE und Fraunhofer fordern gemeinsame Benchmarks und offene Datensätze.

Doch die Hürden sind erheblich: Deepfake-Generatoren werden selbst immer besser im Umgehen aktueller Detektionsstrategien. Niedrige Auflösungen, Video-Kompression und gezielte Angriffe auf Detektionssysteme erschweren die Arbeit der digitalen Forensik [Fraunhofer AISEC].

Bedeutung für Vertrauen und Medienkompetenz

Studien und Ethikräte warnen: Vertrauen in digitale Medien bleibt fragil. Die Unsicherheit, ob Inhalte authentisch sind, beeinflusst gesellschaftliche Diskurse, politische Debatten und sogar das kollektive Gedächtnis. Medienkompetenz und transparente Herkunftsnachweise werden zum Schlüsselfaktor, um Desinformation zu bekämpfen und gesellschaftliche Stabilität zu sichern [ComplyCube].

Ausblick: Das nächste Kapitel beleuchtet, wie manipulierbares Vertrauen nicht nur die Demokratie, sondern auch unsere kollektive Erinnerung und Wahrheitsbegriffe herausfordert.

Manipuliertes Vertrauen: Wie Deepfakes Demokratie, Wahrheit und Erinnerung bedrohen

Deepfake erkennen wird zur Schlüsselkompetenz in unserer digitalen Gesellschaft: KI-Generierte Fakes bedrohen nicht nur die individuelle Wahrnehmung, sondern auch die demokratische Meinungsbildung und das öffentliche Sicherheitsempfinden. Laut einer Studie des Fraunhofer ISI erkennt nur etwa die Hälfte der Bevölkerung Deepfakes zuverlässig, was gezielte Desinformationskampagnen massiv erleichtert [Fraunhofer ISI 2024].

Ethische und gesellschaftliche Risiken: KI-Fakes am Rande der Nicht-Nachweisbarkeit

Sind Deepfakes künftig nicht mehr zweifelsfrei zu erkennen, droht eine Erosion des gesellschaftlichen Grundvertrauens. Das Bundesamt für Sicherheit in der Informationstechnik (BSI) zeigt: Insbesondere in Wahlkampfzeiten könnten KI-generierte Fakes gezielt zur Manipulation politischer Diskurse eingesetzt werden. Beispiele aus den USA und Europa belegen bereits, dass falsche Video- oder Audioinhalte die öffentliche Debatte beeinflussen und das subjektive Sicherheitsgefühl schwächen [BSI 2022].

Verlust der Authentizität: Folgen für Erinnerung und digitale Archive

- Verfälschte Geschichte: Wenn KI-generierte Fakes in digitale Archive gelangen, wird die Unterscheidung zwischen Fakten und Manipulation nahezu unmöglich.

- Individuelles Gedächtnis: Massenhafte Fälschungen können persönliche Erinnerungen und biografische Nachweise kompromittieren.

- Institutionelle Risiken: Gerichte, Medien und Wissensarchive verlieren an Glaubwürdigkeit, wenn digitale Beweismittel leicht manipulierbar sind.

Fachliteratur warnt: Ohne robuste Prüfsysteme und eine breite Medienkompetenz droht eine “Wahrheitskrise”, in der die Authentizität digitaler Quellen permanent hinterfragt wird [CPI OpenFox 2024].

Ausblick: Im nächsten Kapitel analysieren wir, wie Gesellschaft und Politik auf die Krise des Vertrauens reagieren sollten – und welche technologischen, rechtlichen und ethischen Weichen für die Zukunft zu stellen sind.

Fazit

Wer heute die Tricks von KI-Fakes kennt und digitale Inhalte kritisch hinterfragt, schützt sich vor Manipulation und Desinformation. Die Fähigkeiten, Deepfakes zu erkennen und den Quellen zu trauen, werden zur Schlüsselkompetenz in einer vernetzten Gesellschaft. Doch mit der Entwicklung immer raffinierterer KI-Tools ist Wachsamkeit gefragt: Gesellschaft, Forschung und Tech-Industrie müssen gemeinsam daran arbeiten, dass Wahrheit und Vertrauen in digitalen Medien erhalten bleiben – trotz aller technischen Herausforderungen.

Testen Sie Ihr Wissen: Erkennen Sie KI-Fakes? Kommentieren Sie Ihre Erfahrungen und teilen Sie den Artikel mit Freunden.

Quellen

Der ultimative Leitfaden für KI-generierte Deepfakes | McAfee

Deepfakes: Impacts and Policy Responses (Oxford Internet Institute)

Fake videos are making it impossible for people to believe anything (MIT Technology Review)

Deepfake-Eval-2024 (arXiv, 2024)

Bundesregierung: KI gegen Deepfakes (2024)

Faktencheck: Wie erkenne ich Audio-Deepfakes? (DW, 2024)

Fraunhofer ISI: Deepfakes – Chancen und Risiken (2024)

BVDW Deepfakes Report 2024

Deepfake video detection methods, approaches, and challenges

So entlarvt Künstliche Intelligenz Deepfakes

Deepfakes – Fraunhofer AISEC

Deepfake-Erkennungssoftware zur Verhinderung betrügerischer Inhalte

Deepfakes: Chancen und Risiken für Politik, Wirtschaft, Gesellschaft (Fraunhofer ISI)

Deepfakes: Gefahren und Gegenmaßnahmen (BSI)

Deepfakes and their impact on society (CPI OpenFox)

Hinweis: Für diesen Beitrag wurden KI-gestützte Recherche- und Editortools sowie aktuelle Webquellen genutzt. Alle Angaben nach bestem Wissen, Stand: 7/12/2025

Schreibe einen Kommentar