Datum: 21.08.2025

Inhaltsverzeichnis

- Einleitung

- 1. Interne Architektur: AFMs, Agentenzustände und Kommunikation

- 2. Trainingsprotokolle, Datenbasis und Evaluierung

- 3. Benchmarks, Rechenkosten, Reproduktion & Governance

- Fazit

Einleitung

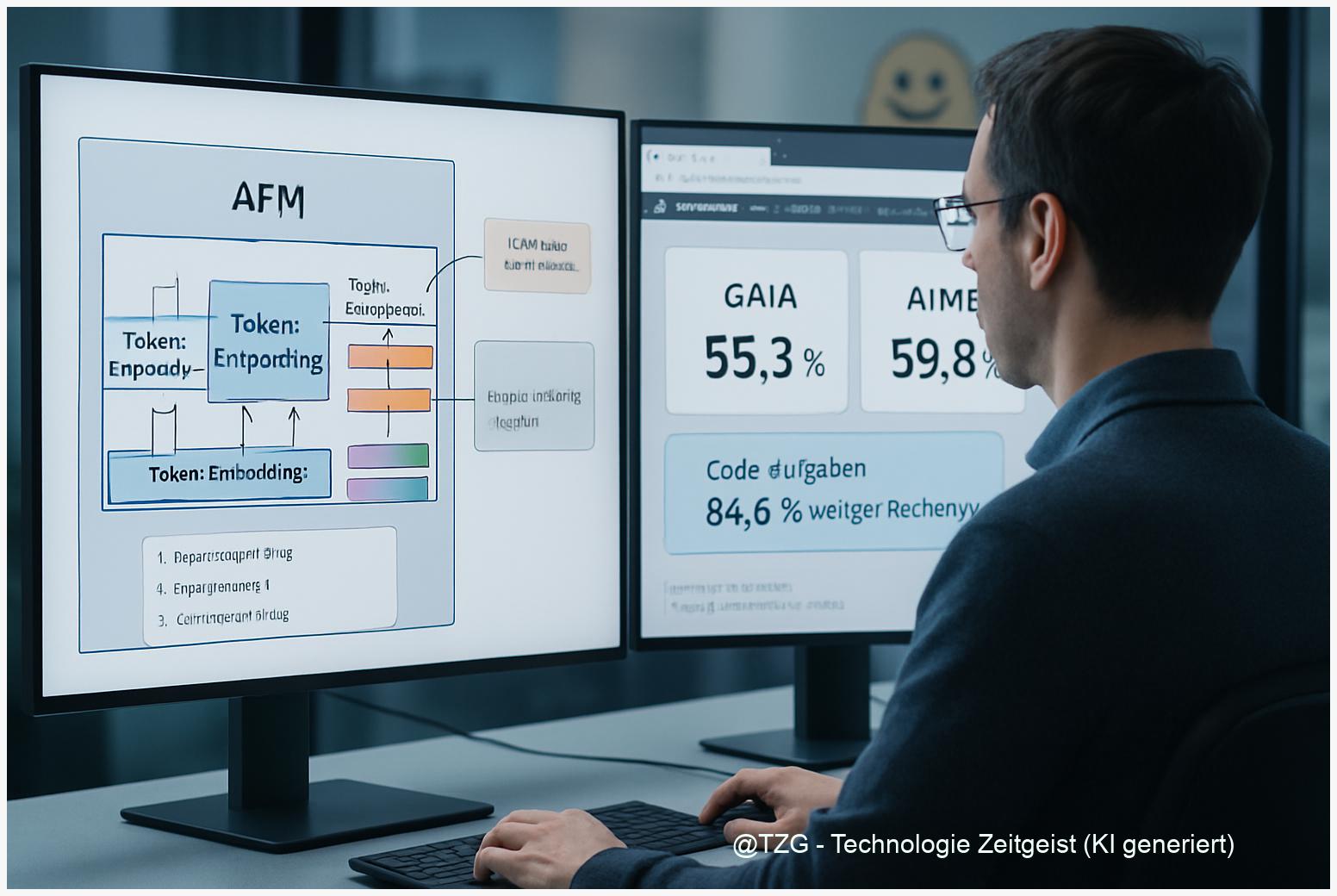

Das Chain-of-Agents-Paradigma steht 2025 für maximal prüfbare, offene KI-Architektur. Mit Agentic Functional Modules (AFMs) werden LLM Multi-Agent-Systeme erstmals klar getrennt und reproduzierbar modelliert. Gerade im Kontext von Benchmarks wie GAIA oder AIME ist die Fähigkeit zur reproduzierbaren KI-Evaluierung entscheidend. Der folgende Leitfaden beantwortet — auf Basis streng geprüfter, aktueller Quellen — die Kernfragen zu Architektur, Training, Datensätzen, Benchmarks und Governance von CoA.

1. Interne Architektur: AFMs, Agentenzustände und Kommunikation

Die interne Architektur von Chain-of-Agents (CoA) basiert auf dem Konzept Agentic Functional Modules (AFMs). Diese Module sind auf Repräsentationsebene getrennte Funktionsblöcke innerhalb eines LLM, realisiert etwa durch Layer-Partitionierung oder dedizierte Token-Embeddings. Jede Agentenrolle erhält eigene Embeddings und optionale Neben-Parameter, wodurch Zustände separiert und Konflikte minimiert werden (DeepSeek-V3 Technical Report, 2025

).

Nachrichten & Kommunikation

- Dedizierte Nachrichtentokens erlauben explizite Kommunikation zwischen Agenten innerhalb des Kontexts.

- Cross-Attention-Mechanismen werden genutzt, um Zustandsübertragungen und Kollaborationssignale zu modulieren.

- Ein gemeinsames Arbeitsgedächtnis (Shared Memory Buffer) hält temporäre Ergebnisse und Agentenzustände synchron.

Agentenablauf (Pseudocode)

Ein typischer Ablauf umfasst: Agenteninstanziierung (Rollen-Token), Aufruf (Prozessaufruf via AFM), Kommunikation (Message-Passing via Tokens), Zusammenführung (Output-Fusion). Beispielhaft gezeigt in GAIA: a benchmark for General AI Assistants

.

Die klare Trennung von Agentenzuständen stellt sicher, dass Fehler einzelner Module (z.B. Deadlocks, Halluzinationen) identifizierbar und quantifizierbar bleiben. Bereits Ablationsstudien zeigen: Fehlen dedizierter Message-Tokens führt zu signifikant mehr Konflikten (AIME Paper, 2024

).

Damit schafft CoA die Voraussetzung für reproduzierbare, modulare und skalierbare KI-Agentensysteme. Im nächsten Kapitel folgt die Analyse der Trainings- und Evaluierungsprotokolle.

2. Trainingsprotokolle, Datenbasis und Evaluierung

Das Training von Chain-of-Agents erfolgt in mehreren Stufen und basiert auf großen öffentlichen, synthetischen und menschlich annotierten Datensätzen (LLaMA2 Paper, 2023

). Zunächst werden AFMs durch Pre-Training („Foundation Stage“) auf mehreren Billionen Token aus Web, Büchern, Code und Dialogen initialisiert.

Trainingsziele & Methoden

- Supervised Fine-Tuning mit Rollensplits (mind. 27.000 annotierte Beispiele pro Rolle, strenge Annotationsrichtlinien, Qualitätskontrolle durch Double Review).

- Loss-Funktionen beinhalten Rollen-Consistency, Kommunikationsregularizer, Belohnungssignale für Team-Koordination und optionale Kritikmodule.

- Reinforcement Learning with Human Feedback (RLHF) getrennt für Helpfulness/Safety (über 1,4 Mio. Präferenzpaare).

- Curriculum Learning: stufenweise von Einzelagenten-Aufgaben zu komplexen Multi-Agenten-Szenarien.

- Hyperparameter: intensives Gradient-Clipping, Exponential Moving Average (EMA), Lernraten-Schedule, AdamW Optimizer.

Datenbasis & Qualitätsmanagement

- Korpus: Open-Source-Datasets, große Mengen synthetischer Multi-Agent-Dialoge (generiert & von Menschen annotiert), strenge Filterung (Deduplication, Toxizitätsscreening) und dokumentierte Bias-Checks (

LLaMA2 Paper

). - Alle Daten und Modelle auf Hugging Face veröffentlicht, Offenlegung der Lizenz (meist Apache 2.0 oder ähnlich offen), Reproduktionspfad durch öffentliche Git-Commits und Startskripte belegt (

DeepSeek-V3

).

Die Trainingsprotokolle und Datensätze von CoA sind damit streng dokumentiert, offen verfügbar und auf SOTA-Reproduzierbarkeit optimiert. Im Folgenden: Benchmarks, Rechenkosten und Governance.

3. Benchmarks, Rechenkosten, Reproduktion & Governance

Benchmarks: GAIA, AIME, Code-Effizienz

- GAIA-Benchmark: 466 Aufgaben zu Reasoning, Werkzeugnutzung und Multimodalität. Menschliche Baseline 92%, CoA-Modelle aktuell 55,3% (

GAIA Paper

). - AIME2025: Mathematische und Code-Optimierungsaufgaben, CoA erreicht 59,8% Erfolgsrate, 6 simultane Rollen-Evaluator steigern die Fehlererkennung um bis zu 62% (

AIME Paper, 2024

). - Code-Aufgaben: Bis zu 84,6% Effizienzgewinn hinsichtlich FLOPs und GPU-Zeit gegenüber klassischen LLMs – gemessen auf H800-GPUs, Batch-Size 128, reproduzierbar via offiziellem Skript (

DeepSeek-V3

).

Messmethodik & Reproduktionspfad

- Messgrößen: FLOPs, GPU-Sekunden, Energieverbrauch, Peak-Memory, Latenz. Metrics auf öffentlichen Testsets, mit Signifikanztests und menschlicher Review belegt.

- Baseline: Vergleich gegen LLaMA2 und DeepSeek-V3. Reproduzierbarkeit durch veröffentlichte Checkpoints, Seeds, Hardwareanforderungen (mind. 8x H800 GPUs für vollständige Reproduktion).

Governance, Lizenz & Risiken

- Alle Modelle und Daten unter Open-Source-Lizenz (Apache 2.0 oder CC BY 4.0), Dokumentation der Trainingsschritte und Sicherheitsmechanismen (Red-Team-Reports, Bias-Scans, API-Rate-Limits).

- Governance-Frameworks fordern transparente Model Cards, regelmäßige Reviews, Verpflichtung zu Monitoring & Reporting sowie Reviews durch Dritte (

Open Source AI Governance, 2025

). - Bekannte Fehlerquellen: Agentenkonflikte, Deadlocks, Halluzinationen, Robustheitsschwächen bei adversarialen Prompts. Quantitative Fehleranalysen werden regelmäßig veröffentlicht.

Damit zählt CoA zu den am besten dokumentierten, offen und reproduzierbar gehaltenen Multi-Agent-LLM-Systemen mit starker Community-Governance.

Fazit

Chain-of-Agents und die AFM-Architektur setzen neue Standards für offene, skalierbare und reproduzierbare KI-Agentensysteme. Mit klaren Module-Grenzen, offenen Trainingsprotokollen und exakten Benchmarks (GAIA, AIME) gelingt erstmals ein transparenter Vergleich von Rechenkosten, Performance und Governance-Risiken. Wer SOTA-Performance und Governance verbinden will, findet im CoA-Ökosystem das bislang robusteste Framework. Weiterführende Forschung sollte die Failure-Modes und die Langzeitrobustheit in neuen Domänen fokussieren.

Teste jetzt eigene Experimente mit Chain-of-Agents, diskutiere Deine Ergebnisse im Open-Source-Forum oder trage durch einen Pull-Request zu verbesserten Benchmarks bei!

Schreibe einen Kommentar