Kurzfassung

WeatherNext 2 ist ein neues, von DeepMind angekündigtes KI‑Wettermodell, das stündliche Vorhersagen und probabilistische Ensembles in deutlich kürzerer Zeit liefern will. Für Energiehandel und Logistik könnte das präzisere, schnellere Szenario‑Sampling Entscheidungsfenster verkürzen und operative Resilienz erhöhen. Der Artikel erklärt die Technik kurz, beleuchtet Chancen für Energiemärkte und Transportketten und nennt pragmatische Prüfungen für den produktiven Einsatz.

Einleitung

Neueste Ankündigungen zeigen, dass KI‑Modelle wie WeatherNext 2 stündliche, probabilistische Vorhersagen deutlich schneller erzeugen können als frühere Ansätze. Für Unternehmen, die auf präzise Wetterinformationen angewiesen sind, eröffnet das neue technische Möglichkeiten: schnellere Szenarien, dichter getaktete Aktualisierungen und eine engere Verzahnung mit Handels‑ oder Logistik‑Algorithmen. Doch Geschwindigkeit allein entscheidet nicht über Verlässlichkeit. Dieser Text ordnet die Technik ein, zeigt Einsatzfelder auf und gibt praktische Prüfhinweise, damit Entscheidungen auf belastbaren Grundlagen stehen.

Was ist WeatherNext 2 und wie arbeitet das FGN?

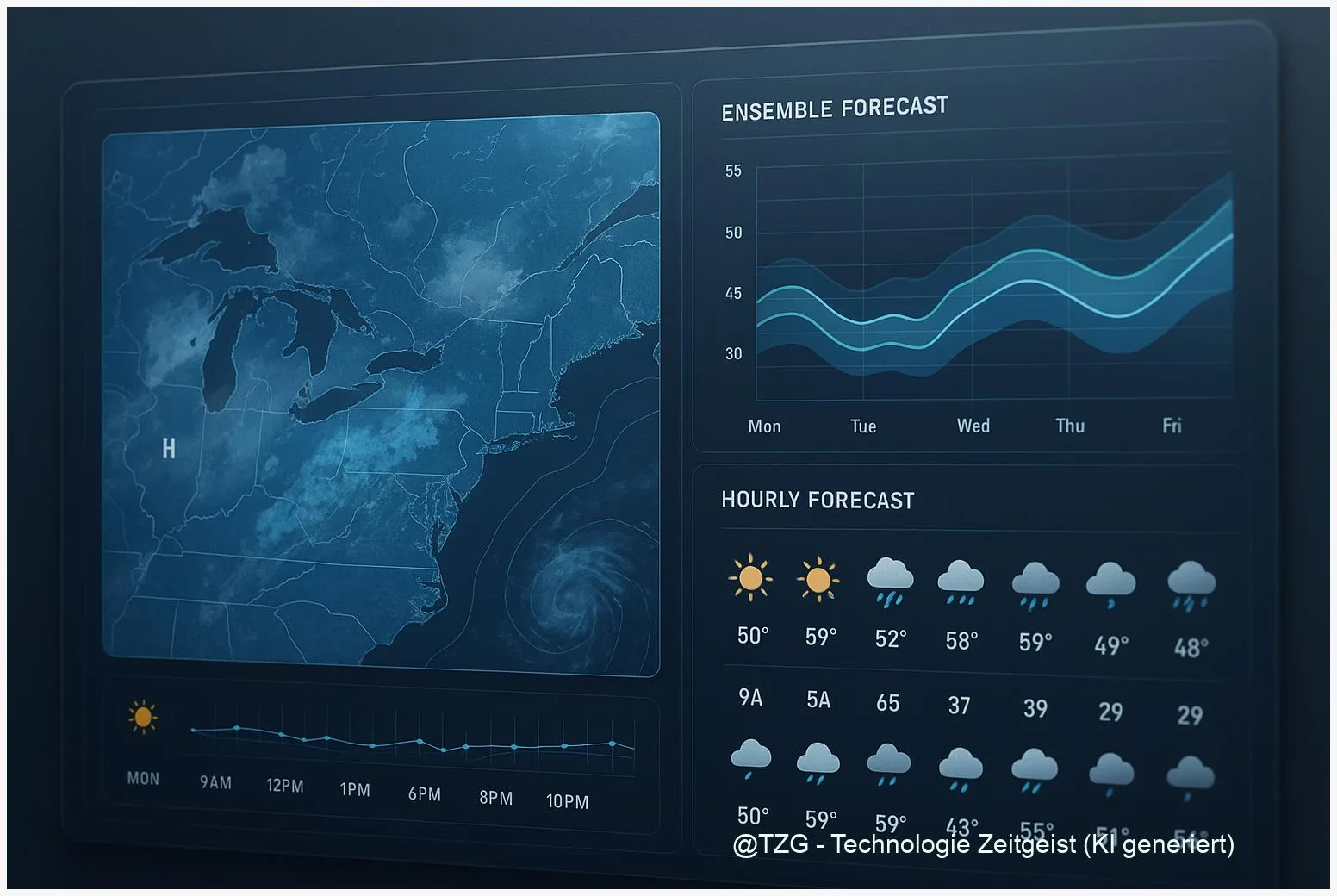

Kurz gesagt: WeatherNext 2 ist ein KI‑gestütztes Vorhersagesystem, das laut Hersteller stündliche Prognosen und große probabilistische Ensembles sehr schnell erzeugen kann. Technisch steckt dahinter ein sogenanntes Functional Generative Network (FGN). Anders als klassische Ensemble‑Ansätze, die viele vollständige Prognoseläufe starten, erzeugt ein FGN Varianten, indem es die Funktion selbst leicht «stört» — das Ergebnis sind kohärente, plausibel zusammenhängende Felder, ohne jeden Lauf einzeln rechnen zu müssen.

Das ist kein Zauberkasten, sondern ein architektonischer Kniff: Ein niedrigerdimensionaler Zufallsvektor moduliert intern Normalisierungs‑Schichten und erzeugt so zusammenhängende Varianten über Raum und Zeit. Zusätzlich nutzen die Entwickler mehrere Modell‑Seeds als Ensemble, um Unsicherheit zu adressieren. In Kombination entsteht ein probabilistisches Bild, das nicht nur einzelne Punkte, sondern zusammenhängende Wettermuster abbildet.

„Mehr Szenarien in kürzerer Zeit bedeutet: mehr Möglichkeitsräume, aber auch mehr Fragen zur Robustheit.“

Herstellerangaben sprechen von deutlich kürzeren Laufzeiten und besseren mittleren Vorhersagefehlern gegenüber früheren ML‑Modellen. Das ist relevant, weil betriebliche Systeme oft schnelle, wiederholte Szenario‑Abfragen brauchen. Dennoch gilt: Viele Leistungskennzahlen stammen aus internen Vergleichen. Externe, unabhängige Replikationen sind zurzeit noch rar. Wer das System einsetzen will, sollte deshalb eigene Validierungsprotokolle planen.

Im Kern: FGN verschiebt die Rechenlast von vielen vollwertigen physikalischen Läufen in eine effizientere, datengetriebene Repräsentation von Unsicherheit. Das eröffnet Tempo‑Vorteile, stellt aber neue Anforderungen an Tests und Kalibrierung.

Tabellenartige Vergleiche helfen, die Unterschiede zu sehen. Hier ein kleines Beispiel zur Einordnung:

| Merkmal | Traditionelle NWP | FGN / WeatherNext 2 |

|---|---|---|

| Ensemble‑Erzeugung | Mehrfache, vollständige Modellläufe | Funktionsraum‑Perturbation (weniger Läufe) |

| Latenz | Höher | Niedriger |

Warum Energiehandel und Logistik profitieren könnten

Energiehandel und Logistik sind klassische Bereiche, in denen Wetterunsicherheiten direkte Kosten erzeugen. Für Stromhändler zum Beispiel beeinflussen Wind‑ und Solarprognosen kurzfristig das Intraday‑Buch. Wenn KI‑Modelle schneller viele plausible Szenarien liefern, erlauben sie feinere Entscheidungen: intelligentere Ordergrößen, engere Hedging‑Intervalle und eine adaptivere Preisfindung.

Im Logistiksektor können stündliche, probabilistische Updates Routenoptimierung und Lagerentscheidungen verbessern. Ein dichteres Update‑Raster bedeutet, Verzögerungsrisiken früher zu erkennen und alternative Pläne zu aktivieren. Das reduziert Stillstand und erhöht die Lieferstabilität — zentral, wenn enge Zeitfenster oder knappe Kapazitäten den Unterschied machen.

Doch es gibt einen praktischen Vorbehalt: Modelle wie WeatherNext 2 liefern viele Szenarien, aber Entscheider brauchen aggregierte, handhabbare Signale. Roh‑Ensembles müssen deshalb in Entscheidungsmetriken übersetzt werden — beispielsweise in Wahrscheinlichkeiten für Grenzwerte (»Chance, dass Wind > X«) oder in verlustsensitiven Risikomaßen. Ohne diese Brücke bleibt der Mehrwert begrenzt.

Ein weiterer Faktor ist Latenz: In Märkten zählt jede Minute. Wenn ein System binnen Sekunden oder einer Minute hunderte Szenarien erzeugt, ermöglicht das automatisierte Handelsstrategien, die auf frischen Informationen basieren. Gleichzeitig steigt die Anforderungen an IT‑Architektur und Kosten. Cloud‑Anbindung, Zugriffslimits und Preismodelle können dabei zum Engpass werden.

Praktische Empfehlung für Unternehmen: Starten Sie mit kontrollierten Piloten, die die Modell‑Outputs gegen interne Marktkennzahlen messen. Definieren Sie einfache Performance‑Metriken (z. B. monetärer Vorteil pro Update‑Zyklus) und prüfen Sie, wie Forecast‑Uncertainty Ihre Entscheidungsgrenzen verschiebt. Nur so wird aus schneller Vorhersage wirklicher wirtschaftlicher Nutzen.

Von der Vorhersage zur betrieblichen Resilienz

Operative Resilienz entsteht nicht allein durch bessere Prognosen, sondern durch Prozesse, die Vorhersagen nutzen. Ein guter Forecast hilft nur, wenn er in Entscheidungs‑Workflows passt. Das beginnt bei klaren Schnittstellen: Welche Signale werden aus dem Ensemble gezogen? Wer im Betrieb erhält welche Warnstufe? Welche automatischen Aktionen dürfen ausgelöst werden?

Für Infrastrukturbetreiber heißt das: Definieren Sie Kontrollpunkte, an denen Forecast‑Informationen konkrete Maßnahmen auslösen. Beispiele sind Anpassungen der Dispatch‑Logik, Umplanung von Lkw‑Touren oder automatische Reservebereitstellungen im Netzbetrieb. Je präziser und schneller die Vorhersage, desto eher lassen sich Prozesse verkürzen — aber nur, wenn Verlässlichkeit und Kalibrierung stimmen.

Kalibrierung ist hier ein Schlüsselbegriff. Probabilistische Modelle müssen auf lokale Bedingungen abgestimmt werden. Das bedeutet: Systematische Biases erkennen, Wahrscheinlichkeiten in echte Eintrittswahrscheinlichkeiten übersetzen und die Entscheidungen darauf abstimmen. Einfachere, interpretable Produktiv‑Schnittstellen helfen: etwa klar deklarierte Unsicherheitsintervalle statt einer Flut von Roh‑Ensemble‑Felder.

Operational resilience erfordert außerdem Monitoring. Setzen Sie laufende A/B‑Tests auf, vergleichen Sie wirtschaftliche Kennzahlen mit und ohne neue Forecast‑Inputs und beachten Sie seltene, aber teure Extremereignisse. Es reicht nicht, mittlere Fehler zu minimieren; es geht darum, welche Folgen Fehler in kritischen Situationen haben.

Schließlich ist Governance wichtig: Verträge mit Anbietern sollten Transparenz über Trainingsdaten, Update‑Frequenz, SLAs und Haftungsfragen regeln. Bei cloudbasierten Angeboten gehören auch Kundenzugriffsrechte und Kostenstruktur zur Bewertung. Nur wer diese Aspekte früh adressiert, kann aus schnellerer Vorhersage nachhaltige betrieblichen Nutzen ziehen.

Risiken, Unsicherheiten und Teststrategien

KI‑Modelle bringen spezifische Unsicherheiten mit. Bei WeatherNext 2 berichten Quellen über interne Benchmarks mit guten Ergebnissen, aber unabhängige Replikationen sind derzeit begrenzt. Typische Risiken sind Artefakte durch Modell‑Mesh, Sensitivität gegenüber Zufallsseeds und eingeschränkte Aussagekraft für seltene Extremereignisse, weil Trainingsdaten solche Fälle nur begrenzt abbilden.

Für Praktiker heißt das: Testen, testen, testen. Ein robustes Prüfprogramm umfasst mehrere Schritte. Erstens: Backtesting gegen historische Ereignisse und gegen etablierte NWP‑Referenzen. Zweitens: Out‑of‑sample‑Tests, die regionale Besonderheiten und Extremereignisse einschließen. Drittens: Seed‑Robustheit prüfen, also wie stabil die Ergebnisse bei unterschiedlichen Initialisierungen sind.

Weiterhin sollten Nutzer Uncertainty‑Metriken operationalisieren. Probabilistische Scores wie CRPS helfen bei der Bewertung, doch Entscheider brauchen transformierte Signale: Eintrittswahrscheinlichkeiten für relevante Schwellen, erwarteter monetärer Schaden oder Entscheidungsbäume, die Ensemble‑Informationen nutzen. Ohne diese Übersetzung bleibt die Vorhersage schwer handhabbar.

Ein weiterer Prüfpunkt ist Konsistenz mit physikalischen Gesetzen. KI‑Modelle sind nicht automatisch energie‑ oder masseerhaltend. Hybridansätze, die physikalische Modelle mit ML‑Ensembles kombinieren, können hier sinnvoll sein. Ebenso wichtig sind vertragliche und ethische Fragen: Wer haftet bei fehlerhaften Signalen? Wie wird der Zugang geregelt, wenn Dienste kommerziell skaliert werden?

Abschließend: Ein gestuftes Pilotprogramm, klare Metriken zur Entscheidungsevaluierung und ein Plan für Governance und Monitoring sind die beste Antwort auf heutige Unsicherheiten. So lassen sich Chancen nutzen und Risiken kontrollieren.

Fazit

WeatherNext 2 zeigt, wie KI‑Ansätze die Geschwindigkeit und Dichte probabilistischer Wetterinformationen erhöhen können. Für Energiehandel und Logistik liegt der Wert in schnelleren Szenarien und dichterer Entscheidungsunterstützung. Gleichzeitig gilt: Interne Herstellerdaten sind ein Anfang, aber nicht das Ende der Prüfung. Wer das System produktiv nutzen will, braucht eigene Validierung, Kalibrierung und klare Governance.

Diskutieren Sie Ihre Erfahrungen in den Kommentaren und teilen Sie diesen Beitrag, wenn Sie ihn nützlich finden.

Schreibe einen Kommentar