Kurzfassung

Dieser Text fasst praktische Einsichten zum multimodal reasoning deployment zusammen und vergleicht zwei prominente Ansätze: Baidus ERNIE‑4.5 und Microsofts MMCTAgent. Ziel ist, Deployment‑Risiken, Kostenfaktoren und Prüfpfade so zu skizzieren, dass Teams schnell entscheiden können, welche Komponenten produktionsreif sind und wo genaueres Testing nötig ist. Die Perspektive bleibt technisch, aber lesbar und ergebnisorientiert.

Einleitung

Multimodale Modelle springen heute zwischen Bild, Video und Text; sie versprechen nicht nur Antworten, sondern schnelles Verstehen komplexer visueller Szenarien. Für Produktteams heißt das: Das Konzept “multimodal reasoning deployment” ist nicht nur Forschung — es ist ein operatives Problem. Die Erfahrung mit Baidus ERNIE‑4.5 und Microsofts MMCTAgent zeigt, dass technische Kapazität, Tool‑Orchestrierung und Prüfverfahren oft die Engpässe sind, nicht die Modelle selbst. Dieser Text erzählt praxisnah, welche Hürden entstehen und wie man sie verantwortbar überwindet.

Was ERNIE‑4.5 für Produktionsteams bedeutet

ERNIE‑4.5 ist ein multimodales MoE‑Modell, das Baidu als besonders effizient für Aufgaben wie Chart‑ und Dokumentenverständnis anbietet. Für Entwickler klingt das attraktiv: umfangreiche Fähigkeiten bei vergleichsweise schlanker Aktivierung. Technisch gesehen heißt das, das Modell hat viele Parameter, aktiviert aber nur einen Teil pro Token. Praktisch bedeutet das zwei Dinge: erstens, die Hardwareanforderungen sind hoch, wenn man das Modell unkomprimiert laden will; zweitens, es gibt Off‑Ramps — Quantisierung, spezialisierte Runtimes und sparsames Routing — die den Betrieb erträglicher machen.

“Herstellerangaben sind ein Startpunkt, nicht das Ende. Validierung im eigenen Kontext bleibt zwingend.”

Was heißt das konkret? Teams sollten zuerst kleine, reproduzierbare Benchmarks fahren: Chart‑QA‑Beispiele, Dokumentenextraktion, Bounding‑Box‑Aufgaben. Baidu stellt Modellartefakte und Anleitungen für vLLM, FastDeploy und eigene SDKs bereit. Die Empfehlung lautet, zunächst mit vLLM auf einer großen GPU‑Instanz zu testen und parallel eine quantisierte FastDeploy‑Variante zu prüfen. So lässt sich ein pragmatischer Trade‑off zwischen Latenz, Kosten und Genauigkeit herstellen.

Lizenzrechtlich ist ERNIE‑4.5 freundlich: Apache‑2.0‑Lizenz erlaubt kommerzielle Nutzung, dennoch sind Drittabhängigkeiten zu prüfen. Und: Performance‑Behauptungen in Herstellerdokumenten sind nicht automatisch reproduzierbar. Unabhängige Tests sind daher kein Nice‑to‑have — sie sind Pflicht.

In der Tabelle unten ein kompakter Blick auf typische Merkmale, wie sie beim ersten Deployment relevant werden.

| Merkmal | Praxiswirkung | Empfohlene Prüfung |

|---|---|---|

| MoE‑Architektur | Große Kapazität, selektive Aktivierung | Latency‑Profiling & Routing‑Analyse |

| Tool‑Calling | Ermöglicht externe OCR/Detektoren | End‑to‑End‑Fehleranalyse |

MMCTAgent: Video‑Reasoning als Tool‑Stack

Microsofts MMCTAgent ist kein einzelnes Modell, sondern ein orchestrierter Agentenbaukasten. Er zerlegt lange Videos und Bildmengen in kleine Aufgaben, ruft spezialisierte Tools ab und nutzt einen vision‑basierten Critic zur Verifikation. Für Produktteams ist das eine wichtige Lektion: komplexe multimodale Reasoning‑Aufgaben werden oft nicht durch ein größeres Modell allein gelöst, sondern durch geschickte Kombination von Modulen.

MMCTAgent demonstriert, wie Planner, Retriever, OCR, Objekt‑Erkennung und ein abschließender Critic zusammenspielen können. Der Nachteil ist offensichtlich: Mehr Komponenten bedeuten mehr Angriffsflächen — für Latenz, Kosten und Fehler. Das Paper und begleitende Microsoft‑Materialien zeigen solide Verbesserungen gegenüber Single‑call‑Baselines in Benchmarks, weisen aber auch auf erheblichen Rechenaufwand hin.

Ein zentraler Punkt ist die Tool‑Augmentation: Wer mit Videos arbeitet, muss entscheiden, welche Schritte lokal laufen und welche über Cloud‑APIs abgewickelt werden. OCR und ASR kann man oft lokal halten; für spezialisierte Planner greifen Teams jedoch häufig auf große, proprietäre Modelle zurück. Das beeinflusst Datenschutz, Kostenstruktur und Compliance deutlich.

Für Early‑Adopter empfiehlt sich folgender Pfad: 1) Code‑ und Lizenzstatus prüfen — ist der Research‑Code öffentlich? 2) Ein kleiner PoC in einer kontrollierten Umgebung: wenige Stunden Video, definierte QA‑Queries, Messung von False‑Positive‑Raten und Critic‑Fails. Drittens: Logging‑ und Rollback‑Mechanismen einbauen. So bleibt die Forschungsexzellenz von MMCTAgent nutzbar, ohne dass das Projekt von unvorhersehbaren Betriebsereignissen überrollt wird.

Das Fazit hier lautet: MMCTAgent zeigt das Potenzial von agentenbasiertem Reasoning, zwingt aber zu sorgfältiger Systemgestaltung. Komplexität muss man messen, nicht nur beschreiben.

Skalierung, Kosten und Sicherheitsprüfung

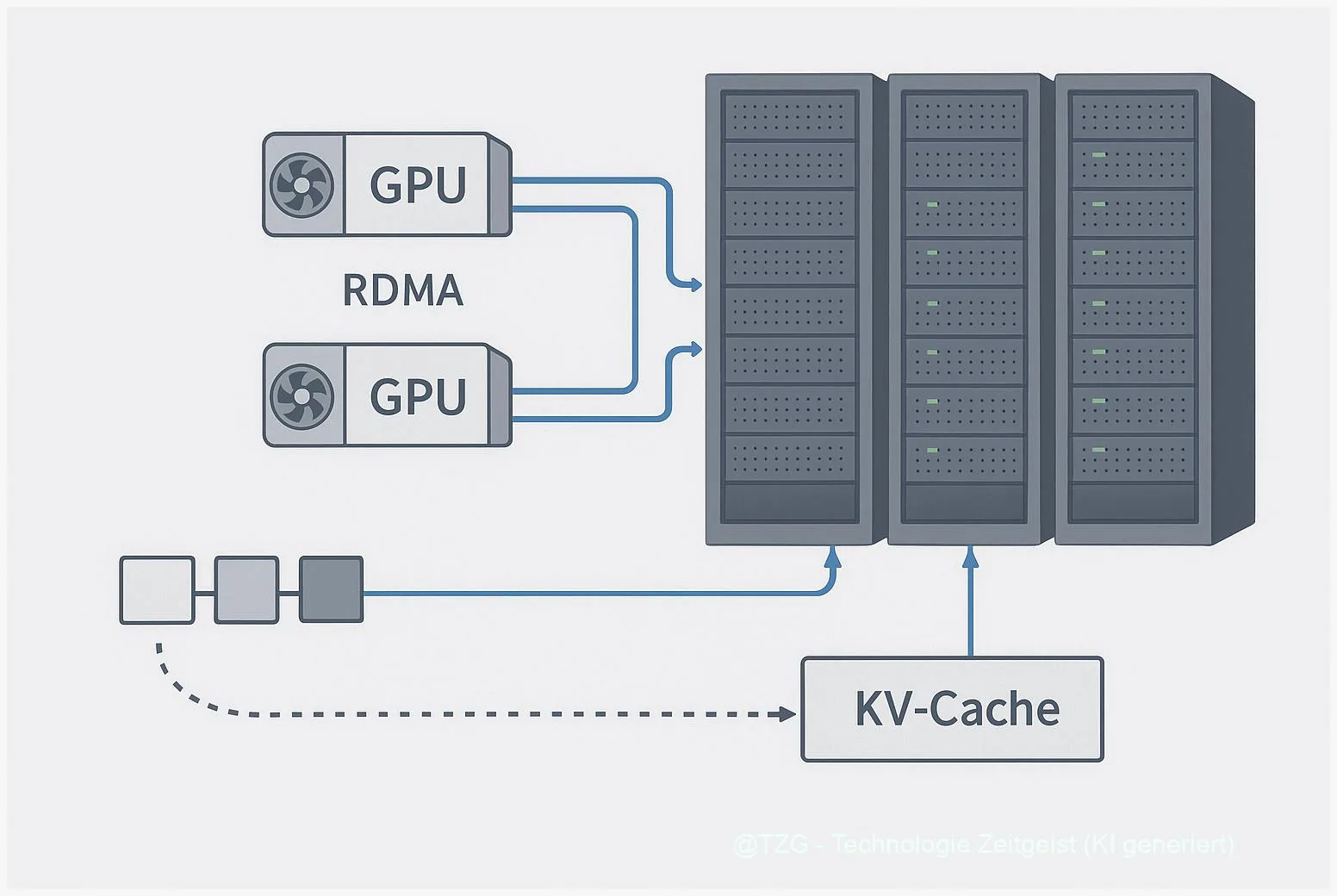

Wenn Modelle größer werden oder mehrere Tools orchestriert werden, steigen Betriebskosten und Komplexität exponentiell an. ERNIE‑4.5 verlangt laut Hersteller größere GPU‑Speicherprofile für unkomprimierte Varianten; MMCTAgent wiederum trägt Kosten durch Tool‑Pipelines und häufige Modellaufrufe. Entscheidend ist, diese Kosten nicht abstrakt zu diskutieren, sondern in Szenarien zu denken: wie viele Anfragen pro Stunde, welche Latenz wird toleriert, welche Daten dürfen die Cloud verlassen?

Ein einfacher Prüfpfad reduziert Risiken: erstens, ein funktionaler Smoke‑Test; zweitens, Belastungstests mit typischen Nutzlasten; drittens, gezieltes Bias‑ und Halluzinationstesting auf Domänendaten. Hersteller liefern Benchmarks — meist unter idealen Bedingungen. Deshalb ist eine eigene Prüf‑Suite nötig, die firmenspezifische Dokumente, Charts und Videoformate abbildet.

Sicherheit ist mehr als Datenschutz: Ein vision‑critic kann falsche Korrekturen ausgeben, Tools können inkonsistente Ergebnisse liefern, und Quantisierung führt zu subtilen Genauigkeitsverlusten. Monitoring‑Pipelines sollten daher fehlerhafte Antworten erkennen und automatisch zur menschlichen Prüfung eskalieren. Bei Video‑Workflows ergänzt das PII‑Masking und Retention‑Policies — essentielle Maßnahmen für Europa.

Operationalisierung heißt auch: Entscheidungen über Modellformate und Runtimes. vLLM kann für hohe Durchsatzanforderungen sinnvoll sein; FastDeploy und quantisierte Varianten reduzieren Speicherbedarf. In der Praxis zahlt sich ein hybrider Ansatz aus: Kerninferenz lokal, seltene teure Calls in der Cloud und konsequentes Observability‑Design.

Praxisleitfaden: Von PoC zur Produktion

Ein pragmatischer Fahrplan reduziert Überraschungen. Beginnen Sie mit klaren Prüffragen: Welche Aufgaben soll das System lösen? Wie sehen Fehlermodi aus? Welche Datenschutz‑Regeln gelten? Auf dieser Basis bauen Sie drei Iterationen: Proof‑of‑Concept, Pilot, Ramp‑Up. Bei jeder Stufe validieren Sie Genauigkeit, Latenz, Kosten und Governance.

Proof‑of‑Concept: kleiner Datensatz, klar definierte Metriken, Shadow‑Mode‑Betrieb neben dem bestehenden Workflow. Hier zeigt sich oft, ob das Modell die richtige Granularität hat — ob es also eher grobe Labels oder präzise Extraktionen liefert. Pilot: Skalieren auf reale Last, Instrumentierung aller Komponenten, A/B‑Vergleich mit Baseline. In dieser Phase lässt sich auch gut prüfen, wie Tool‑Calls wie OCR oder Object Detection die End‑Antworten beeinflussen.

Ramp‑Up: schrittweise Produktionsfreischaltung, SLOs definieren, automatisierte Rollbacks für Regressionen. Wichtig ist auch, dass Teams nicht nur Metriken, sondern Erklärungen sammeln: Warum hat das Modell geantwortet, wie sicher war die Antwort, welche Tools waren beteiligt? Solche Metadaten sind Gold wert, wenn später Fehler analysiert werden müssen.

Abschließend ein Hinweis zur Technologieauswahl: Das Schlagwort „multimodal reasoning deployment” steht für ein Bündel operationaler Herausforderungen. Es ist kein rein technisches Projekt, sondern ein Produkt‑ und Compliance‑Vorhaben. Erfolg misst sich nicht an Benchmarks, sondern daran, wie stabil und verantwortbar ein System Antworten in der realen Nutzung liefert.

Fazit

Multimodale Reasoning‑Modelle wie ERNIE‑4.5 und Agentenansätze wie MMCTAgent bieten jeweils klare Stärken: Kapazität versus Orchestrierung. Für den produktiven Einsatz gilt: testen, messen, absichern. Beginnen Sie klein, instrumentieren Sie umfassend und planen Sie Governance mit. Nur so werden diese Systeme in echten Produkten verlässlich und vertrauenswürdig.

Diskutiert mit uns in den Kommentaren und teilt den Artikel in den sozialen Medien!

Schreibe einen Kommentar