AMD MI350-GPU revolutioniert KI-Server: Führe dein Unternehmen mit besserer Performance, Effizienz und Kostenvorteilen in die Zukunft. Jetzt mehr erfahren!

Inhaltsübersicht

Einleitung

Warum die AMD MI350 jetzt alles verändert

Technische Details: Der 3-nm-KI-Meilenstein im Faktencheck

Praxisrelevanz und Impact: Was Unternehmen jetzt wissen müssen

Ausblick: Wie AMDs KI-Offensive die Zukunft prägt

Fazit

Einleitung

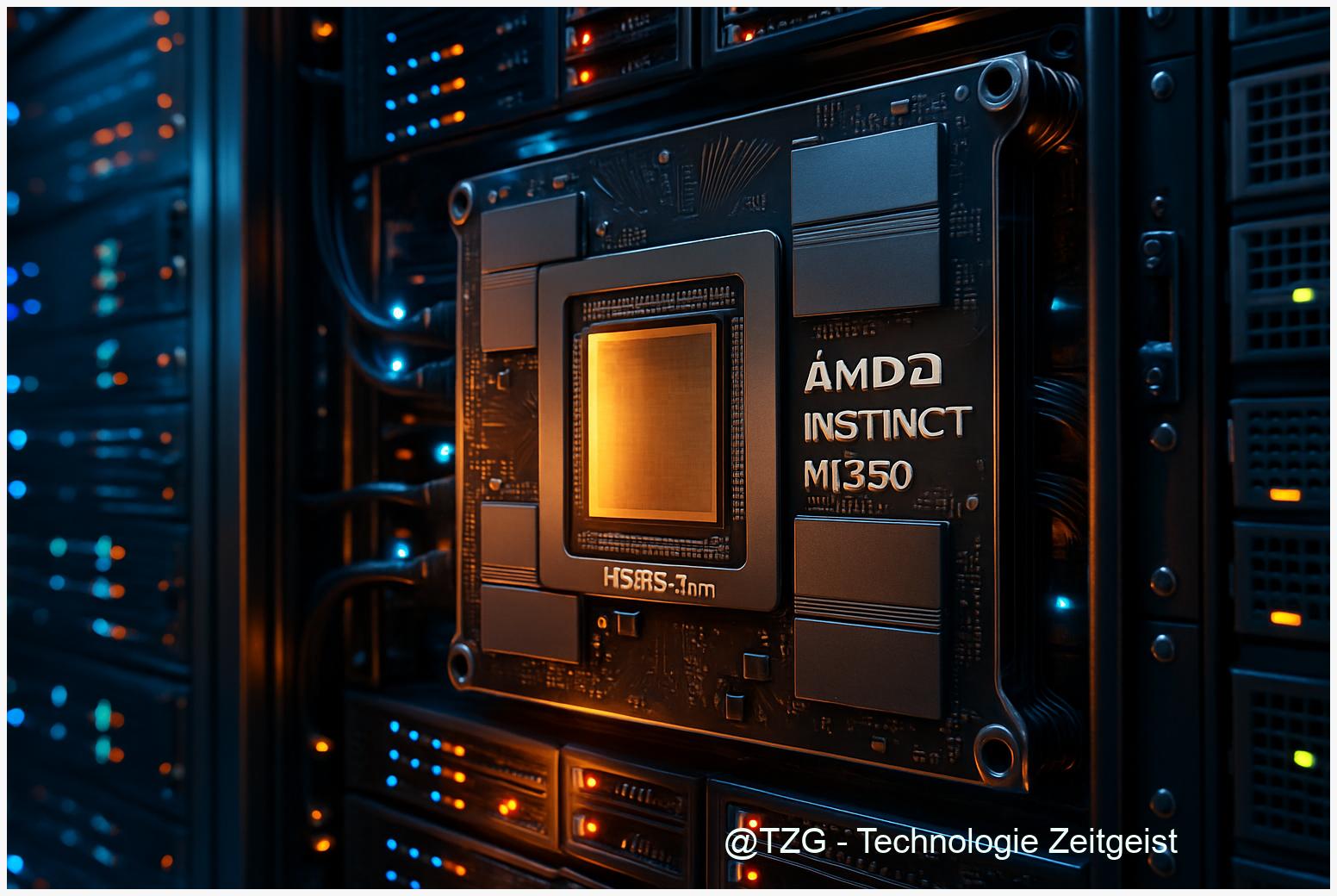

Im Wettlauf um die leistungsfähigsten KI-Chips sorgt AMDs brandneue MI350-GPU-Serie für Aufsehen. Der 3-nm-Chip verspricht, Trainingsgeschwindigkeit und Energieeffizienz in ganz neue Sphären zu heben. OpenAI bestellt als erstes Unternehmen die Hardware – ein bemerkenswertes Signal an die Branche. Dieser Artikel analysiert, weshalb die MI350 den Status quo im KI-Rechenzentrum kompromisslos herausfordert. Im ersten Kapitel klären wir, wie es zum Launch kam und welches Gesamtbild den KI-Markt derzeit prägt. Im Anschluss erläutern wir die technischen Innovationen der MI350 im Detail. Danach zeigen wir, welche realen Konsequenzen der Einstieg von OpenAI und die Vorteile des AMD-Konzepts für Unternehmen haben. Abschließend werfen wir einen fundierten Blick auf die zukünftige Entwicklung und die Implikationen für Markt und Technologie.

AMD MI350-GPU: Wendepunkt im KI-Chip-Wettlauf

Die Präsentation der AMD MI350-GPU am 12. Juni 2025 markiert einen neuen Höhepunkt im globalen KI-Chip-Markt – nicht nur wegen der technischen Innovation, sondern insbesondere wegen der Signalwirkung für die gesamte Branche. Mit der Entscheidung von OpenAI, die MI350-GPU frühzeitig zu übernehmen und aktiv an der Weiterentwicklung künftiger Chipgenerationen mitzuwirken, verschiebt sich das Kräfteverhältnis erstmals spürbar weg vom bisherigen Platzhirsch Nvidia und dessen H100-Serie. Der Moment verdeutlicht: Der KI-Hardwaremarkt ist kein Monolog mehr, sondern wird zum offenen Wettstreit der Giganten.

Marktdynamik: AMD fordert Nvidia heraus

Bislang dominierte Nvidia mit einem Marktanteil von 80 bis 95 Prozent die KI-Chip-Landschaft – insbesondere mit der Nvidia H100, die als Benchmark für Rechenzentren und KI-Training gilt. Im Zuge der exponentiellen Nachfrage nach KI-Workloads, etwa fürs Training von Modellen wie GPT-4, wuchs auch der Umsatz mit KI-beschleunigenden GPUs: 2024 lag das Gesamtvolumen laut Gartner bei 71 Milliarden US-Dollar, ein Plus von 33 Prozent gegenüber dem Vorjahr. Während Nvidia von dieser Marktdynamik profitierte, arbeitete AMD im Hintergrund an einem Technologiewechsel: Mit der MI300-Serie, ersten Server-Partnerschaften und gezielten Zukäufen (u.a. ZT Systems und KI-Talente von Untether AI) bereitete AMD den Boden für den Angriff auf die Spitze vor.

Der Launch der MI350-GPU und die Ankündigung, dass OpenAI auf AMD setzt, gelten nun als strategischer Wendepunkt. Branchenexperten und Analysten sehen darin nicht nur ein Signal an weitere Hyperscaler, sondern auch eine Herausforderung für Nvidias Preissetzungsmacht und Innovationsdruck. Das neue Helios-Serverkonzept von AMD – mit bis zu 72 Chips pro Einheit – ist explizit auf Konkurrenz zu Nvidias NVL72 ausgelegt und soll 2026 den High-End-Markt adressieren. Die Energy Efficiency der neuen Chips spielt dabei eine zentrale Rolle: Angesichts steigender Stromkosten und wachsender Emissionen werden effiziente Designs zur geschäftskritischen Größe für Rechenzentren.

KI-Chip-Wettlauf: Status 2024/2025

Die Entwicklung der letzten 24 Monate im KI Chip-Sektor liest sich wie ein Wettrennen: Während Nvidia mit Softwareoptimierungen die Energieeffizienz seiner H100-GPU kontinuierlich steigerte, beschleunigten Wettbewerber wie AMD die Iteration ihrer Hardware. OpenAI setzte bisher vor allem auf Nvidia, doch der strategische Wechsel zur MI350 und die Mitwirkung am MI450-Design verdeutlichen: Marktführer müssen sich neu beweisen. Die Dynamik spiegelt sich auch in den Marktanteilen wider: Im Desktopbereich konnte AMD seinen Anteil 2024 auf 17 Prozent steigern, während Nvidia auf 82 Prozent fiel – ein Trend, der sich im Serversegment fortsetzen könnte.

Der Startschuss für den nächsten Abschnitt im KI-Chip-Wettlauf ist gefallen – und die Branche wartet gespannt darauf, ob die AMD MI350-GPU auch technologisch hält, was der Markteintritt verspricht.

Im nächsten Kapitel nehmen wir die technischen Details und den 3-nm-Meilenstein der MI350-GPU faktenbasiert unter die Lupe.

3-nm-Architektur der AMD MI350-GPU: Fakten und Vergleiche

Die AMD MI350-GPU setzt mit ihrer 3-nm-Fertigung neue Maßstäbe im KI-Chip-Segment. Bereits vor dem offiziellen Marktstart sicherte sich OpenAI große Stückzahlen des neuen Chips, denn: Die technische Architektur der MI350 verspricht nicht nur eine drastische Steigerung der KI-Leistung, sondern krempelt auch die Energieeffizienz im Training und in der Inferenz um. Was steckt hinter diesem Technologiesprung, und wie hebt sich AMD von den bisherigen Platzhirschen wie Nvidia ab?

3-nm-Fertigung & CDNA-4: Effizienz auf neuem Niveau

Herzstück der MI350 ist die neue CDNA-4-Architektur, gefertigt im hochmodernen 3-nm-Prozess von TSMC. Dieser Schritt ermöglicht eine deutlich höhere Transistordichte – also mehr Rechenleistung auf gleicher Fläche – und senkt zugleich den Energiebedarf pro Rechenoperation. Im direkten Vergleich zur Vorgängergeneration, die noch auf 5 nm setzte, steigert die MI350 die KI-Leistung laut AMD um das 35-Fache. Die maximale Leistungsaufnahme bleibt mit rund 750 Watt bemerkenswert moderat. Im Gegensatz dazu liegt die Nvidia H100 oft bei 8.400 Watt unter Volllast. Diese Energy Efficiency ist ein Schlüsselfaktor für hyperskalierte Rechenzentren und KI-Trainingsfarmen.

Speicher, Tensor-Kerne und Bandbreite: Das Autobahnnetz der KI

Ein weiteres Highlight ist die Integration von bis zu 288 GB HBM3e-Speicher von Samsung, angebunden mit einer Bandbreite von bis zu 6 TB/s. Zur Einordnung: Die Nvidia H100 bietet maximal 80 GB HBM3 und eine Bandbreite von rund 3,35 TB/s. Speicherbandbreite lässt sich mit der Anzahl und Breite von Fahrspuren auf einer Autobahn vergleichen: Je größer sie ist, desto mehr Daten können gleichzeitig zwischen Speicher und Prozessor transportiert werden – das beschleunigt insbesondere komplexe KI-Trainings. Tensor-Kerne, spezialisierte Einheiten für Matrixoperationen, sorgen dabei für massive Parallelverarbeitung mathematischer Operationen – ähnlich wie ein Logistikzentrum, das viele Warenströme parallel abfertigt. Auch die Zusammenarbeit mit Micron im Bereich Highspeed-DDR5 unterstreicht AMDs Strategie, Engpässe im Datentransport zu eliminieren.

Vergleich zur Nvidia H100: Paradigmenwechsel im KI-Chip-Markt

Im Vergleich zur H100 von Nvidia überzeugt die MI350 nicht nur mit ihrer Speicher- und Rechenleistung, sondern besonders mit der Energieeffizienz. Während die H100 bereits als Branchenmaß galt, setzt AMD mit der MI350 neue Standards – sowohl beim Trainingstempo als auch bei der maximalen Rechendichte pro Watt. Das bedeutet: Mehr KI-Modelle lassen sich schneller und nachhaltiger trainieren. Für Unternehmen und Forschungseinrichtungen wird der Energiebedarf zum entscheidenden Kostenfaktor – und damit zum Wettbewerbsvorteil.

Mit diesen technischen Eckpunkten ist die AMD MI350-GPU bestens gerüstet, um die Zukunft des KI-Trainings maßgeblich mitzugestalten. Im nächsten Kapitel analysieren wir, was das konkret für Unternehmen und ihre KI-Strategien bedeutet.

AMD MI350-GPU: Neue Maßstäbe für Unternehmen und Cloudanbieter

AMD MI350-GPU verspricht nicht nur immense Leistungssteigerungen gegenüber bisherigen KI-Chips, sondern verändert bereits vor dem offiziellen Marktstart die strategischen Weichenstellungen bei Cloudanbietern, Rechenzentren und Startups. Mit der Vorbestellung durch OpenAI rückt die Frage nach Kosten, Energieeffizienz und Innovationspotenzial für Unternehmen stärker denn je in den Fokus.

Vergleich: Leistungsdaten, TCO und Energy Efficiency

Die AMD MI350-GPU setzt mit einer erwarteten FP16-Rechenleistung von über 1,3 Petaflops, 192 GB HBM3-Speicher und einer Speicherbandbreite von 5,3 TB/s neue technische Referenzwerte für KI-Workloads in Rechenzentren. Im Vergleich dazu bringt Nvidias H100 etwa 989 TFLOP/s (FP16), 80 GB HBM3 und 3,35 TB/s Bandbreite – bei einem Marktpreis von 30.000 bis 40.000 US-Dollar pro Einheit. Preislich könnte AMD mit der MI350 laut Branchenanalysten und früheren MI300X-Marktpreisen bis zu 40 % unter Nvidias H100 liegen, begünstigt durch niedrigere Hardware- und Netzwerk-Kosten. Energy Efficiency rückt ins Zentrum: Während die H100 etwa 20 TFLOPS/W (FP16) erreicht, wird für die MI350 ein nochmals besseres Verhältnis erwartet – und damit sinken Strom- und Kühlkosten spürbar.

Für Unternehmen bedeutet das: Die Gesamtbetriebskosten (TCO) sinken durch niedrigere Anschaffungskosten, effizienteren Energieeinsatz und günstigere Netzwerkinfrastruktur (Ethernet statt NVLink). In einem typischen 3-Jahres-Szenario könnten Cloudanbieter durch den Einsatz von MI350-GPUs bis zu 40 % Kostenersparnis gegenüber einer H100-basierten Lösung realisieren, wie Analysen von SemiAnalysis nahelegen.

Marktdynamik: OpenAIs Vorbestellung, Lieferketten und Wettbewerb

OpenAIs frühe Bestellung der MI350 ist mehr als ein Marktsignal – sie verstärkt den Druck auf bestehende Lieferketten und Marktpreise. Während Nvidias GPUs aufgrund hoher Nachfrage und Exportbeschränkungen bereits Wartezeiten von über 12 Monaten aufweisen, könnte AMD mit der MI350 als schnell verfügbare Alternative neue Wettbewerbsszenarien schaffen. Für Cloudanbieter wie Microsoft, Google und Amazon entstehen damit Optionen zur Diversifizierung, was mittelfristig Preisdruck auf GPUs und Cloud-Dienste erhöht und die Innovationszyklen beschleunigt.

Rechenzentren und Startups profitieren konkret von der kurzfristigen Verfügbarkeit sowie von geringeren Eintrittsbarrieren durch sinkende Hardwarepreise und bessere Energieeffizienz. Gleichzeitig zwingt der Markteintritt der MI350 etablierte Anbieter zu strategischen Anpassungen, etwa durch Investitionen in Software-Kompatibilität (Stichwort: CUDA vs. ROCm). Der verstärkte Wettbewerb dürfte die Entwicklung neuer Applikationen und KI-Services beschleunigen, aber auch für Verunsicherung im Arbeitsmarkt sorgen: Während AMD in KI-Chip-Entwicklung investiert, werden in anderen Bereichen Stellen abgebaut.

Mit der MI350 wächst für Unternehmen die Chance, KI-Projekte wirtschaftlicher und nachhaltiger zu realisieren. Die nächsten Monate werden zeigen, wie schnell sich die neue Hardware-Alternative etabliert – und wie tiefgreifend sie die Dynamik im KI-Infrastrukturmarkt verändert.

Im folgenden Kapitel analysieren wir, wie AMDs KI-Offensive und die MI350 die strategische Ausrichtung der Branche langfristig prägen könnten.

Chancen, Risiken und Marktverschiebungen durch AMD MI350-GPU

Mit der AMD MI350-GPU betritt ein KI Chip die Bühne, der durch 3-nm-Fertigung und neue KI-Architekturen die Karten im Sektor neu mischt. Dass OpenAI als Vorreiter im KI-Feld bereits vorab ordert, unterstreicht die strategische Bedeutung dieses Schritts. Die Kombination aus hoher Rechenleistung und deutlich verbesserter Energy Efficiency ist nicht nur ein Technologiesprung, sondern auch ein Signal an die Branche: Die Abhängigkeit von der Nvidia H100 könnte schwinden, sofern weitere Großabnehmer nachziehen.

Marktdynamik: Wettbewerb, Nachhaltigkeit und digitale Souveränität

Im Zentrum der Chancen steht die neue Fertigungstechnologie: Die 3-nm-Struktur der AMD MI350-GPU ermöglicht mehr Transistoren auf kleinerem Raum und senkt den Energieverbrauch je Recheneinheit. Gerade bei KI-Workloads für Deep Learning oder Large Language Models wie bei OpenAI sind Effizienzgewinne von zentraler Bedeutung. Unternehmen, die bisher fast ausschließlich auf Nvidia H100-Chips setzten, erhalten mit der MI350 erstmals einen ernstzunehmenden Alternativpfad – was Innovationen, Preissenkungen und einen gesünderen Wettbewerb fördern kann.

Besonders relevant werden nachhaltige Technik-Ansätze. Die MI350 adressiert mit optimierter Architektur und geringerer Leistungsaufnahme nicht nur Kostenaspekte, sondern auch ökologische Anforderungen. Rechenzentren stehen unter Druck, ihre CO₂-Bilanz zu verbessern – hier kann die Energy Efficiency neuer Chips zum entscheidenden Faktor werden. Gleichzeitig stärken offene Ökosysteme rund um AMD die digitale Souveränität, da Unternehmen und Staaten weniger von proprietären Nvidia-Lösungen abhängig sind.

Risiken: Lieferketten, technologische Engpässe und geopolitische Unsicherheiten

Doch der Aufschwung birgt Risiken. Die Halbleiterbranche bleibt anfällig für globale Lieferkettenprobleme. Engpässe bei 3-nm-Kapazitäten – etwa bei TSMC – oder geopolitische Spannungen zwischen den USA und Asien könnten die Verfügbarkeit der AMD MI350-GPU einschränken. Zudem ist der Software-Stack ein neuralgischer Punkt: Viele KI-Frameworks wie CUDA sind stark auf Nvidia optimiert. AMD muss hier zügig Kompatibilität und Performance nachziehen, sonst droht die Gefahr, dass die Hardware trotz technischer Stärken nicht in vollem Umfang genutzt wird.

Unternehmen müssen strategisch abwägen: Wer jetzt auf die MI350 setzt, positioniert sich früh am Markt, trägt aber auch das Risiko technologischer Kinderkrankheiten und möglicher Lieferverzögerungen. Der Wettbewerb um KI-Hardware könnte sich weiter verschärfen, wenn weitere Großabnehmer wie Cloud-Anbieter oder Forschungseinrichtungen aufspringen und die Nachfrage nach neuen Chips das Angebot übersteigt.

Die kommenden Jahre werden zeigen, ob AMD mit der MI350-GPU die Tür zu einem diverseren, nachhaltigeren KI-Markt aufstößt. Unternehmen sollten den Moment nutzen, um ihre Beschaffungsstrategien zu diversifizieren, Ökosysteme aktiv mitzugestalten und technologische Unabhängigkeit zu fördern. Wer jetzt mutig und vorausschauend handelt, kann den Wandel in der KI-Landschaft aktiv mitprägen.

Im nächsten Kapitel analysieren wir, welche konkreten Handlungsempfehlungen sich aus diesen Entwicklungen für IT-Entscheider ergeben – von Investitionsstrategien bis zu Partnerschaften im KI-Ökosystem.

Fazit

Die AMD MI350-GPU ist mehr als ein neues Chip-Flaggschiff: Sie definiert das Kraftverhältnis am KI-Markt neu und bietet Unternehmen einen echten Hebel für Effizienz und Wachstum. Mit OpenAI als Signalgeber dürfte der Marktumschwung schneller erfolgen als je zuvor. Jetzt gilt es für Entscheider, den richtigen Moment zu nutzen und Strategien proaktiv anzupassen. Die nächsten Quartale werden zeigen, ob AMDs Innovationsvorsprung verteidigt werden kann – fest steht: Die KI-Welt wird spürbar dynamischer. Gehen Sie den Wandel frühzeitig mit!

Jetzt mehr über AMDs MI350 erfahren und Wettbewerbsvorteil sichern!

Quellen

AMD unveils AI server as OpenAI taps its newest chips

AMD holt sich Marktanteile von Nvidia zurück | Netzwoche

Weltweiter Umsatz mit KI-Chips wächst 2024 um 33 Prozent – connect professional

Nvidia dominiert den KI-Chip-Markt, doch Herausforderungen bleiben nicht aus

AMD rolls out new AI chip to rival Nvidia

AMD Accelerates Pace of Data Center AI Innovation and Leadership with Expanded AMD Instinct GPU Roadmap

TSMC’s 3nm project list grows: AMD MI350 series, NVIDIA Rubin AI GPU, expected in 2H 2025

[News] Samsung Reportedly Signs USD 3 Billion HBM3e Deal with AMD | TrendForce News

NVIDIA H100: Leistung, Vorteile und Einsatzgebiete – IONOS

AMD MI350 vs. NVIDIA Blackwell: A Comparative Analysis of Next-Generation Chips – Zoomax Low Vision Aids

Ecosystem partner program: AMD | Micron Technology Inc.

AMD’s AI Ambitions: A Deep Dive into MI350 and Market Strategy

MI300X vs H100 vs H200 Benchmark Part 1: Training – CUDA Moat Still Alive

OpenAI setzt auf AMD und plant bis 2026 maßgeschneiderte KI-Chips – Dataconomy DE

Fokus auf KI-Chips: Stellenabbau bei AMD | heise online

AMD Unveils MI350 Series: Next-Gen AI Accelerators in 3nm

OpenAI’s strategic order of AMD MI350 GPUs

Nvidia H100 vs. AMD MI350: Market Impact and Ecosystem Shift

Hinweis: Für diesen Beitrag wurden KI-gestützte Recherche- und Editortools sowie aktuelle Webquellen genutzt. Alle Angaben nach bestem Wissen, Stand: 6/13/2025

Schreibe einen Kommentar