Wie zuverlässig sind Deepfake-Detektoren mit 98% Genauigkeit? Kurz gesagt: Die Zahl kann in Laborbenchmarks stimmen, fällt in freier Wildbahn aber oft schwächer aus. Entscheidend sind Datensätze, Testprotokolle und plattformübergreifende Robustheit. Dieser Leitfaden ordnet aktuelle Meldungen (u. a. Crescendo AI News, UC Riverside, Google) ein – und erklärt, worauf es bei Content‑Moderation und Regulierung ankommt.

Inhaltsübersicht

Einleitung

Grundlagen, Meilensteine und die 98%-Behauptung im Faktencheck

Vom Modell in die Praxis: Pipeline, Schnittstellen und Kennzahlen

Roadmaps, Alternativen und die Frage der Resilienz

Folgen, ausgelassene Perspektiven und der Fünf-Jahres-Check

Fazit

Einleitung

Deepfakes sind vom Kuriosum zum Risiko für Wahlen, Marken und Creator geworden. Parallel melden Forschungsteams und Unternehmen Trefferquoten nahe 98% – teils „plattformübergreifend“. Berichte wie jene von Crescendo AI News, eine Studie der University of California, Riverside und Googles Arbeiten zur Deepfake-Erkennung heizen die Debatte an. Doch eine Zahl allein sagt wenig über Fehlalarme, Latenz, Domänen-Bias oder die Stabilität gegen Ausweichmanöver aus. Für Content-Creator und Plattformen stellt sich die praktische Frage: Wie lässt sich ein Detektor verlässlich in Workflows einbinden, ohne legitime Kreativität zu beschädigen? Und für Regulatoren: Welche Nachweise brauchen Regeln, damit Kennzeichnung, Herkunftsnachweise und Sanktionen rechtssicher werden? Der folgende Artikel gruppiert die wichtigsten Aspekte in vier Schritten – von Grundlagen über Pipeline-Design bis zu gesellschaftlichen Folgen – und liefert eine Checkliste, wie sich kühne Zahlen belastbar prüfen lassen.

Grundlagen, Meilensteine und die 98%-Behauptung im Faktencheck

Deepfake-Detektor – der Begriff steht heute für Tools, die Künstliche Intelligenz nutzen, um manipulierte Medieninhalte mit teils beachtlicher Präzision zu entlarven. Die aktuelle Fokussierung auf „98% Genauigkeit“ spiegelt den rasanten Fortschritt in der Erkennung und die gestiegene Dringlichkeit angesichts täuschend echter Deepfakes wider. Jüngste Meldungen – etwa zu den Lösungen von Google („Deepfake Hunter“), Studien der UC Riverside und Berichte von Crescendo AI – zeigen: Die Forschung adressiert zunehmend reale Anwendungsszenarien und plattformübergreifende Herausforderungen.

Begriffe, Historie und technische Entwicklung

Deepfakes basieren auf generativen Modellen wie Autoencodern, GANs und neuerdings Diffusionsmodellen. Während erste Deepfakes vor allem Gesichter manipulierten, sind heute multimodale Fälschungen (Audio, Video, Text) gängig. Die Erkennung begann mit einfachen CNNs auf Frame-Basis (z.B. FaceForensics++), über komplexe Ensemble- und Transformer-Ansätze (Vision-Transformer, zeitliche Analysen, Audio-Forensik) bis hin zu physiologischen Signalen (z.B. Blinzeln, Puls).

Meilensteine & Paradigmenwechsel

- FaceForensics++: Frühes Standard-Dataset für Deepfake-Erkennung

- DFDC (Meta): Großes Benchmark-Projekt, offener Wettbewerb mit realitätsnahen Samples

- Celeb-DF v2, DeeperForensics-1.0, WildDeepfake: Verschiedenste Domänen, Qualität und Realweltbezug

- C2PA/CAI: Wandel von Artefakt-Erkennung zu Provenance-Konzepten und Herkunftsnachweis

Diffusionsmodelle erschweren die Erkennung, da sie typische Artefakte (wie Unschärfen) verwischen und so klassische Detektoren unterlaufen.

Die 98%-Genauigkeit im Kontext

Was bedeutet „98% Genauigkeit“ bei einem Deepfake-Detektor wirklich? Der Begriff kann verschiedene Maße meinen: Accuracy (Gesamtanteil korrekter Klassifikationen), Precision/Recall (Fehlalarme vs. Treffer), F1-Score (harmonisches Mittel) oder AUC (Fläche unter der Kurve). Gerade in unausgewogenen Datensätzen – z.B. wenn echte Videos überwiegen – kann die Accuracy trügen. Verlässliche Studien (etwa UC Riverside, DFDC) setzen auf Cross-Domain-Evaluierung (Training auf Datensatz A, Test auf B), plattformübergreifende Samples (z.B. TikTok, YouTube) und adversariale Störungen. Kritiker bemängeln oft fehlende Transparenz bei Industrieangaben (Google, Crescendo): Ohne genaue Angaben zu Datensätzen, Testprotokollen oder Fehlalarme-Raten bleiben 98%-Claims schwer vergleichbar.

Infokasten: Woran erkenne ich belastbare 98%-Claims?

- Offengelegte Datensätze und Benchmarks (z.B. DFDC, Celeb-DF v2)

- Detaillierte Testprotokolle (Cross-dataset, Open-Set, In-the-wild)

- Konfidenzintervalle und Fehlalarm-Raten

- Unabhängige Drittvalidierung, Peer-Review

- Transparente Dokumentation der Limitationen

Der nächste Abschnitt zeigt, wie Deepfake-Detektoren praktisch in Content-Moderation und Plattformprozesse eingebettet werden – inklusive Schnittstellen, Rollen, Rückkopplungen und was bei der Bewertung von 98%-Werten zu beachten ist.

Vom Modell in die Praxis: Pipeline, Schnittstellen und Kennzahlen

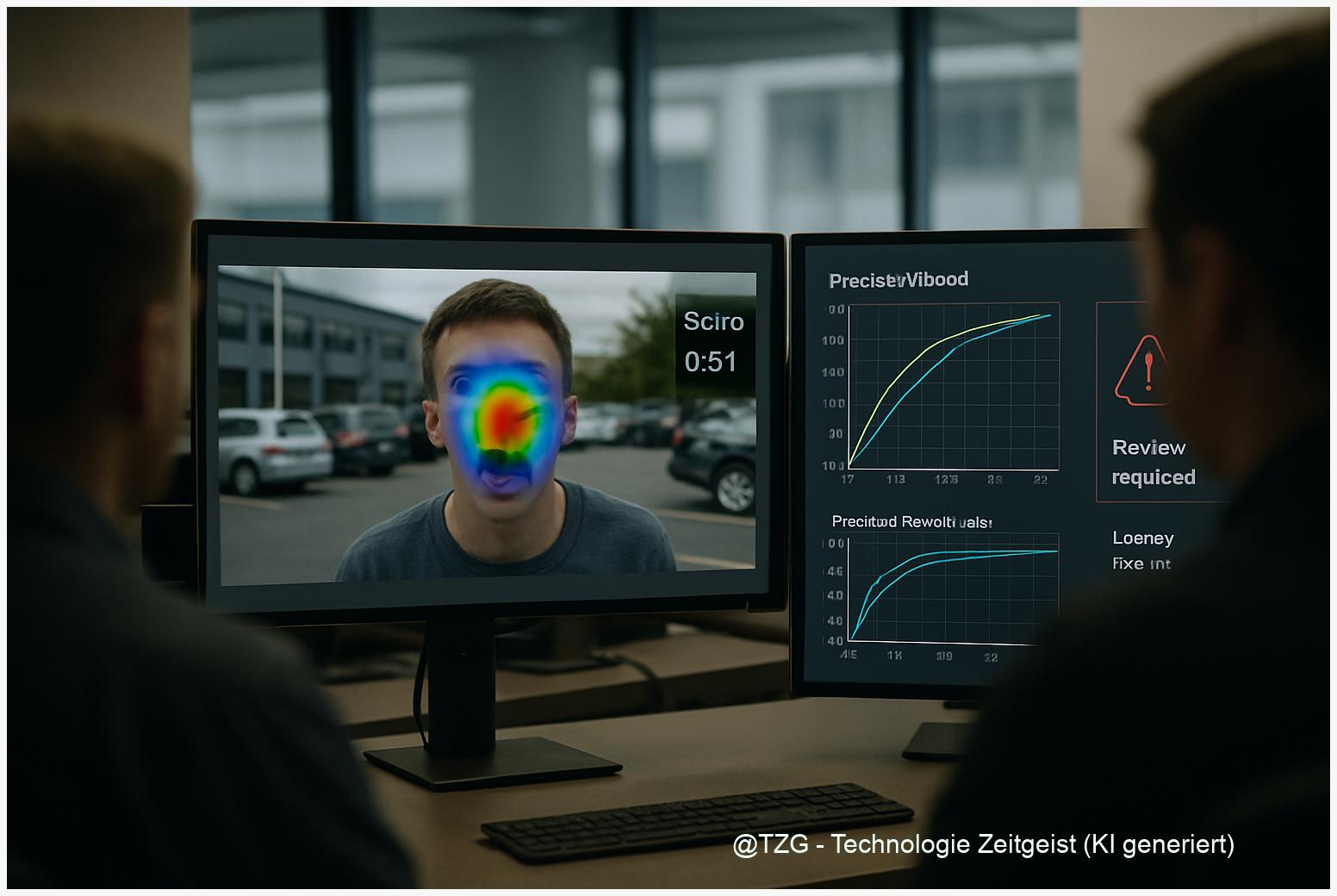

Die Integration moderner Deepfake-Detektoren in bestehende Content-Moderation-Pipelines entscheidet darüber, wie effektiv Plattformen auf die wachsende Flut synthetischer Medien reagieren. Aktuelle Systeme koppeln anspruchsvolle Modellarchitekturen – etwa 2D/3D-CNNs, Vision-Transformer (ViT) oder multimodale Netzwerke mit Audio-Analyse – mit schlanken Schnittstellen (REST/gRPC, Webhooks), um schnelle On-device- und Cloud-Inferenz zu ermöglichen. Der Deepfake-Detektor wird damit zur zentralen Instanz für den ersten Plausibilitätscheck direkt nach Upload – häufig im Batch- oder Streaming-Betrieb.

Architektur, Schnittstellen und Datenfluss

- Workflow: Creator-Upload → Medienvorverarbeitung → Deepfake-Detektor → Score & Erklärung → Policy-Engine → Mensch im Loop (bei Unsicherheit) → Feedback ins Trainingsset.

- Drittanbieter: Spezialisierte Trust-&-Safety-Vendoren liefern zusätzliche Audit-Logs, Eskalationspfade und rechtssichere Begründungen (z.B. für Plattform-Beschwerden oder Behörden).

- Governance: Schwellenwerte werden dynamisch nach Risikoklassen gesetzt – etwa strikter bei politischen Inhalten oder Werbung. Dokumentation erfolgt mit Model Cards, Audit Trails und nach EU-DSA-konformer Löschprotokollierung.

Leistungsmetriken und Tests

- Präzision (Precision), Trefferquote (Recall) und F1-Score: Beschreiben den Trade-off zwischen Fehlalarmen und verpassten Deepfakes, entscheidend für die 98% Genauigkeit.

- ROC-AUC, PR-AUC, Equal Error Rate (EER): Bewerten Robustheit und Schwellenoptimierung für verschiedene Nutzungskontexte.

- Latenz und Durchsatz: Edge-Inferenz kann < 100 ms pro Video dauern, im Server-Betrieb sind mehrere hundert Videos pro Sekunde möglich.

- Robustheitstests: Inferenz nach Re-Encoding, Framerate-Wechsel, Rauschen, Wasserzeichen-Entfernung oder adversarialen Attacken ist Pflicht – Benchmarks wie JPEG Fake Media und die Google- sowie UC Riverside-Pipelines führen solche Tests systematisch durch.

Trainingsannahmen & Standardisierung

- Modelle werden auf gemischten Datensätzen (synthetisch/real, mehrere Plattformen) trainiert und mit Augmentierungen wie Kompression, Sprachvariation oder Open-Set-Detektion robuster gemacht.

- Internationale Leitlinien wie C2PA (Content Provenance), NIST AI RMF 1.0, ISO/IEC 23894 und JPEG Fake Media sind zunehmend Standard für Dokumentation, Fairness, Auditierbarkeit und Risikoabschätzung.

- Datensparsamkeit und Rechtskonformität (z.B. EU DSA) bestimmen Speicherdauer und Regionenzuordnung. Incident-Response-Prozesse, Berufungswege und regelmäßige Reviews steuern Governance und Vertrauensaufbau.

Wie resilient diese Systeme gegen neue Angriffsmethoden bleiben, welche Alternativen wie Watermarking oder kontinuierliches Lernen diskutiert werden, und welche Roadmaps sich aktuell abzeichnen, zeigt das nächste Kapitel.

Roadmaps, Alternativen und die Frage der Resilienz

Die Widerstandsfähigkeit von Deepfake-Detektoren steht vor einer Bewährungsprobe: Während immer neue Fälschungstechniken entstehen, müssen sich auch die Erkennungssysteme und die Content-Moderation stetig weiterentwickeln. Die Roadmap aktueller Lösungen umfasst dabei nicht nur das klassische Modelltraining, sondern setzt verstärkt auf hybride Ansätze: kontinuierliches Lernen, signaturbasierte Deepfake-Erkennung sowie Provenance-Standards wie den C2PA Herkunftsnachweis. Ergänzend kommen Wasserzeichen-Technologien wie Google SynthID hinzu, die synthetische Inhalte kryptografisch markieren. Hardware-gestützte Capture-Chains, etwa als Teil neuer Smartphone-Generationen, bieten perspektivisch zusätzliche Sicherheitsschichten, sind aber teuer und in der Breite technisch noch nicht reif [Google SynthID].

Technische und regulatorische Abhängigkeiten

- Offene Benchmarks und Datenteilung: Plattformübergreifende Erkennung verlangt gemeinsame Standards und den Austausch von Hashes oder Perceptual Fingerprints. Red-Team-Ökosysteme werden gezielt eingesetzt, um Schwachstellen in Detektoren aufzuspüren.

- Rechtliche Rahmen: EU DSA verpflichtet Plattformen zu Transparenz über manipulative Inhalte, der EU AI Act reguliert Hochrisiko-KI wie Deepfake-Detektoren explizit. Klare Vorgaben zur Herkunftsnachweispflicht und zum Umgang mit Fehlalarmen fördern Innovation und Haftungssicherheit [EU DSA].

Alternativen und Ergänzungen zur Detektion

- Provenance & Watermarking: Wo der Deepfake-Detektor an die 98% Genauigkeit stößt, können C2PA-basierte Herkunftsprotokolle oder Wasserzeichen wie SynthID die Authentizität absichern – vorausgesetzt, Plattformen und Creator ziehen mit.

- Kontext-Label & Reichweitenbremsen: Ergänzende Mechanismen wie Fact-Checking-Partner, Uploader-Verifikation oder Reichweitenlimitierung für verdächtige Inhalte gewinnen an Bedeutung, vor allem bei schnellen News-Zyklen und Wahlperioden.

Stakeholder und Zielkonflikte

- Plattformen: Markensicherheit, regulatorisches Risiko (DSA, AI Act), Reduktion von Fehlalarmen.

- Staaten: Schutz der Wahlintegrität, Kampf gegen Desinformation.

- Content-Creator: Identitätsschutz, Nachweis von Authentizität.

- Werbetreibende: Brand Safety, Vermeidung von Ad Fraud.

- Öffentlichkeit: Vertrauen in Medien und demokratische Prozesse.

Die Kernfrage bleibt, wie sich Deepfake-Detektor und C2PA Herkunftsnachweis ergänzen und welche Backups greifen, wenn Evasion-Techniken die 98% Genauigkeit unterlaufen. Folgen, blinde Flecken und der Fünf-Jahres-Check schließen daran an.

Folgen, ausgelassene Perspektiven und der Fünf-Jahres-Check

Deepfake-Detektoren mit angeblich „98% Genauigkeit“ prägen zunehmend Arbeitsmärkte, Rechtssysteme und kulturelle Debatten. Die Einführung automatisierter Content-Moderation verschiebt Aufgaben von reiner Sichtung hin zu qualifizierter Analyse. Laut Studien entstehen so neue Jobprofile im Bereich Trust & Safety; gleichzeitig sinkt das Volumen manueller Kontrollen, während technische und ethische Qualifikationen steigen [Oxford Martin School].

Direkte und indirekte Folgen

- Creator-Economy: Deepfake-Detektoren können legitime Creator-Einnahmen gefährden, etwa durch Fehlalarme oder restriktive Plattform-Policies. Gleichzeitig bieten Herkunftsnachweise Chancen, Urheberrechte zu stärken.

- Arbeitsmarkt und Regionen: Moderationsjobs wandeln sich, vor allem im globalen Süden bleibt aber der Zugang zu moderner Detektionstechnik begrenzt [Brookings].

- Rechts- und Beweisführung: Die Akzeptanz digitaler Herkunftsnachweise (z. B. C2PA) wächst, aber Chain-of-Custody und Due Process sind in vielen Rechtssystemen ungeklärt [CAI].

- Kostenverteilung: Große Plattformen investieren in eigene Detektoren, kleinere Anbieter setzen auf Dritt-APIs, was zu ungleicher Risiko- und Kostenverteilung führt.

Ethische Konflikte und blinde Flecken

- Falschpositive können legitime Kunst, Satire oder Minderheitenkulturen treffen.

- Massenscans durch Deepfake-Detektoren werfen Datenschutzfragen auf – besonders ohne Transparenz über Trainingsdaten und Score-Interpretation.

- 98%-Narrative verschleiert oft, wie wenig validiert viele Systeme für unterrepräsentierte Dialekte, Sprachen und Bildkulturen sind. Unabhängige Red-Teams und offene Benchmarks fehlen meist.

Der Fünf-Jahres-Check

- Annähernd naiv: Einseitiges Vertrauen in Kennzahlen, Unterschätzung des Wettrennens zwischen Fälschung und Detektor, Hoffnung auf flächendeckende Adoption von Watermarking.

- Tragfähig: Mehrschichtige Sicherheit durch Detektion plus Provenance, unabhängige Dritt-Audits und versionssignierte Model Cards.

- Empfehlung: Heute sollten Cross-dataset- und Sprach-Benchmarks, unabhängige Audits, Red-Team-Berichte und Pre-Registrierung von Tests Standard werden [DFDC].

Praxisbox: FAQ und Demo-Links

- Wie teste ich einen Deepfake-Detektor? Viele Universitäten und Initiativen bieten kostenlose Online-Demos, z. B. DFDC Demo, Deepware Scanner, Sensity AI Free Trial.

- Welche Fehlalarmrate ist akzeptabel? In kritischen Bereichen (z. B. Wahlwerbung) werden <5% False Positive Rate angestrebt, in der Breite liegen akzeptierte Werte oft höher – abhängig von Policy und Kontext.

Die gesellschaftlichen, rechtlichen und technologischen Folgen der Deepfake-Detektion sind tiefgreifend – entscheidend bleibt die Offenlegung von Limitationen und der verantwortungsvolle Umgang mit Fehlerquoten und Transparenzpflichten.

Fazit

Detektoren mit hohen Trefferquoten sind ein wichtiger Baustein gegen synthetische Täuschungen, aber sie lösen das Problem nicht allein. Wer Verantwortung trägt – Creator, Plattform, Regulierer – braucht belastbare Tests, klare Prozesse und Zusatzmechanismen wie Herkunftsnachweise und transparente Berufungswege. Der kluge Weg ist ein Lagenmodell: robuste Erkennung, nachvollziehbare Governance und offene Standards, flankiert von unabhängigen Audits und realweltnahen Benchmarks. So sinkt das Risiko teurer Fehlentscheidungen, ohne legitime Kreativität zu ersticken. Entscheidend ist, heute die richtigen Nachweise einzufordern: plattformübergreifende Tests, per-Sprache- und per-Domäne-Kennzahlen, sequesterierte Evaluation und Red-Teams. Dann wird aus einer kühnen „98%“-Zahl ein überprüfbares Versprechen – und kein Vertrauensvorschuss.

Teste die verlinkten Detektoren in unserem Mini-FAQ, notiere Fehlalarme und Treffer – und teile deine Ergebnisse in den Kommentaren.

Quellen

FaceForensics++: Learning to Detect Manipulated Facial Images

The Deepfake Detection Challenge Dataset (DFDC)

Celeb-DF: A Large-scale Challenging Dataset for DeepFake Forensics

UC Riverside: Generalizable Deepfake Detection

Google Research Blog: Advancing Deepfake Detection

Crescendo AI News: Deepfake Detection Progress

Content Authenticity Initiative (C2PA Specification)

NIST AI Risk Management Framework (AI RMF 1.0)

ISO/IEC 23894:2023 Artificial intelligence — Guidance on risk management

JPEG Fake Media: Call for Proposals and Benchmarks

Google AI Blog: Deepfake Detection Progress and Benchmarks

UC Riverside: Robust Deepfake Detection Pipelines

Google SynthID: Identifying AI-generated images

C2PA Specification (Content Authenticity Initiative)

EU Digital Services Act (DSA)

EU Artificial Intelligence Act (AI Act) – amtliche Fassung

Robustness of Deepfake Detectors Under Evasion Attacks (2023, arXiv)

CAI (Content Authenticity Initiative) – Übersicht

AI and Content Moderation: Challenges and Opportunities (Oxford Martin School, 2023)

The global content moderation workforce (Brookings)

Content Authenticity Initiative (CAI)

DFDC: Deepfake Detection Challenge Dataset (Meta/Facebook)

Sensity AI Deepfake Detector (Demo)

Hinweis: Für diesen Beitrag wurden KI-gestützte Recherche- und Editortools sowie aktuelle Webquellen genutzt. Alle Angaben nach bestem Wissen, Stand: 8/7/2025

Schreibe einen Kommentar