Woke AI oder Zensurmaschine? Wie politische Bias in KI Narrative formt

Politische Bias in KI 2025: Wie Algorithmen Ideologien verstärken und Gesellschaft spalten – Untersuchung der “Woke AI”‑Debatte, möglicher Executive‑Order‑Folgen und Auswirkungen auf freie Meinungsäußerung mit überprüfbaren Quellen.

Kurzfassung

Politische Bias in KI ist mehr als ein Bauchgefühl: Aktuelle Forschung zeigt, dass generative Systeme Haltungen verschieben können und sprachabhängige Tendenzen besitzen. Das betrifft die Debatte um politische Bias in KI, mögliche Grenzen durch eine Woke AI Executive Order, algorithmische Zensur, Bias‑Audit soziale Medien und konkrete Auswirkungen auf Meinungsfreiheit. Dieser Leitfaden trennt Evidenz von Meinung und liefert sofort umsetzbare Schutzmaßnahmen.

Einleitung

Schon wenige Chatbot‑Nachrichten können politische Ansichten messbar verschieben. Ein Experiment der University of Washington berichtet, dass Teilnehmende nach wenigen Interaktionen mit bewusst voreingenommenen Chatbots ihre Positionen in Richtung der jeweiligen Tendenz änderten (N≈299; Präsentation: 2025) (Quelle).

Damit rückt eine alte Sorge in den Fokus: Wie vermeiden wir algorithmische Zensur, ohne Hass, Hetze und Desinformation ausufern zu lassen?

Gleichzeitig zeigt neue Evidenz, dass die Ausrichtung von Modellen je nach Sprache schwankt. Eine Studie über 14 Sprachen findet konsistente, links‑liberale Tendenzen bei ChatGPT und Gemini – mit deutlichen Unterschieden zwischen den Sprachen (2025) (Quelle).

In dieser Gemengelage prallen Schlagworte wie politische Bias in KI und Woke AI Executive Order aufeinander. Unser Ziel: Fakten sortieren, Risiken benennen, Lösungen zeigen – für Plattformen, Redaktionen und Bürger:innen.

Was zählt als Bias – und was als Moderation?

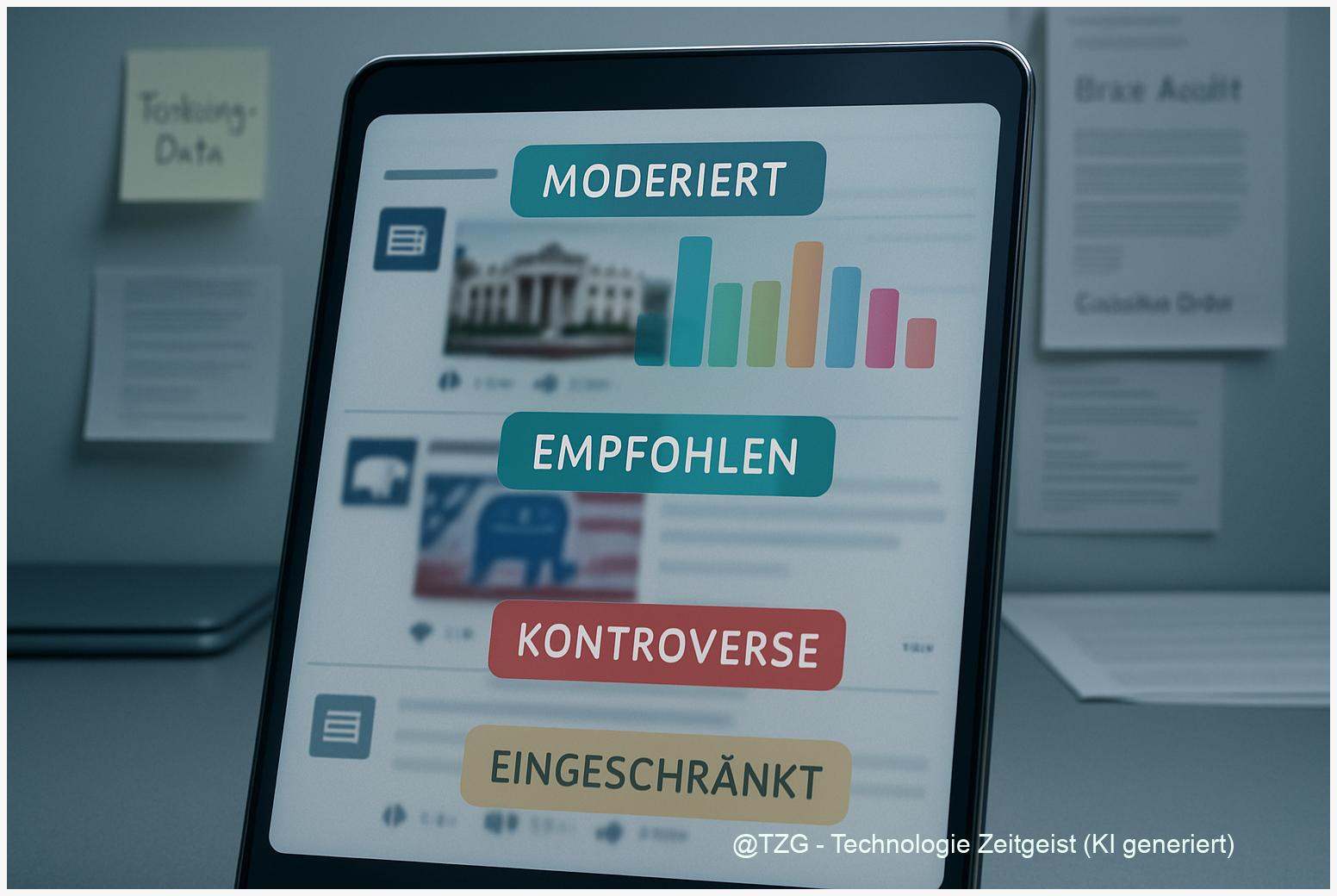

Wenn ein KI‑System politische Gewalt verherrlichende Inhalte stoppt, sprechen wir von Moderation. Wenn es jedoch legitime Positionen pauschal abwertet oder unsichtbar macht, reden wir über Bias. Der Unterschied liegt in Kriterien und Begründbarkeit: Sind Regeln öffentlich, konsistent und überprüfbar? Gibt es Widerspruchsrechte und Protokolle?

Die Forschung belegt, wie empfindlich Systeme auf Leitplanken reagieren. Die UW‑Studie zeigt, dass schon wenige, gezielt voreingestellte Prompts die Richtung von Antworten – und nachfolgend die Haltungen der Nutzenden – merklich verschieben können (Stand: 2025) (Quelle).

Für Plattformen heißt das: Moderationspolitiken dürfen nicht zum versteckten Redaktionsleitartikel werden.

Praxisleitlinie: Jede Entscheidung mit politischer Relevanz braucht einen sichtbaren Pfad. Beschreibe die Regel, protokolliere die Anwendung, ermögliche Einspruch. So trennst du notwendige Sicherheit von algorithmischer Zensur – und schaffst eine Basis für ein unabhängiges Bias‑Audit sozialer Medien.

Für Leser:innen und Creator gilt: Dokumentiere Interaktionen, in denen neutrale Anfragen systematisch in eine Richtung gelenkt werden. Setze Kontrollprompts mit neutralem und entgegengesetztem Framing. Wenn Unterschiede stabil sind, liegt ein Hinweis auf politische Bias in KI vor – ein Fall für Audits und Korrekturen.

Wie KI politische Haltungen beeinflussen kann

Menschen passen ihre Meinung an, wenn eine kompetent wirkende Stimme ihnen konsistente Frames anbietet. Genau das passiert bei Chatbots. In dem Experiment mit absichtlich liberal bzw. konservativ ausgerichteten Bots reichten wenige Interaktionen, um die Antworten der Teilnehmenden auf bisher wenig bekannte Themen zu verschieben (N≈299; 2025) (Quelle).

Wichtig: Die Effekte variierten mit Vorwissen. Die Forschenden berichten, dass höhere Selbsteinschätzungen zu KI‑Kenntnissen die Beeinflussung abschwächten – ein Hinweis auf den Schutzfaktor digitaler Bildung (2025) (Quelle).

Für die Praxis bedeutet das: Medienkompetenz‑Module gehören dorthin, wo politische Inhalte generiert oder empfohlen werden.

Damit werden Regulierungsdebatten greifbar. Ob man sie „Woke AI“ nennt oder anders: Entscheidend ist, nachvollziehbar zu machen, wann Systeme politisch sensibel handeln. Logs zu Policy‑Versionen, Prompt‑Schutz und Eskalationswegen helfen, Tatsachen zu schaffen – statt Schlagworte zu tauschen.

Für Redaktionen: Teste politisch relevante Prompts regelmäßig in A/B‑Varianten. Lege ein internes Register an, in dem du Modellversion, Datum und beobachtete Abweichungen festhältst. So baust du einen Evidenzpfad, der über Einzelfälle hinausweist – und im Zweifel schnelle Korrekturen ermöglicht.

Sprachabhängiger Bias: Ein globales Problem

Bias endet nicht an Ländergrenzen. Eine breit angelegte Untersuchung testete politische Ausrichtung über 14 Sprachen und fand konsistent links‑liberale Tendenzen in Antworten von ChatGPT und Gemini, wobei sich die Stärke je nach Sprache deutlich unterschied (2025) (Quelle).

Das ist heikel für Plattformen mit globalem Publikum – denn ein Thema kann je nach Sprachversion anders gerahmt werden.

Was folgt daraus? Erstens: Politische Features (z. B. Wahl‑Guides, News‑Briefings) sollten mehrsprachig geprüft werden. Zweitens: Teams brauchen lokale Expertise, die kulturelle Codes erkennt. Drittens: Sichtbares Version‑Tracking pro Sprache verhindert, dass unerkannte Änderungen Wochen im Produkt verbleiben.

Für Regulierer und NGOs öffnet die Studie die Tür zu systematischen Checks. Statt pauschaler Vorwürfe lassen sich Stichprobenpläne anlegen: gleiche Fragen, mehrere Sprachen, feste Zeitfenster, dokumentierte Modellversionen. So wird aus der Debatte ein Messprogramm – und aus Vermutungen werden belastbare Befunde.

Und Nutzer:innen? Wenn Antworten je nach Sprache kippen, lohnt sich ein schneller Gegencheck in einer zweiten Sprache oder mit anderem Framing. Unterschiede allein sind kein Beweis für algorithmische Zensur, aber ein Anlass für ein Bias‑Audit sozialer Medien – am besten mit offenen Protokollen.

Praktische Gegenmittel: Audits, Transparenz, Rechte

Die gute Nachricht: Wir sind nicht machtlos. Drei Maßnahmen wirken sofort. Erstens: verpflichtende Transparenz zu Moderationsregeln und Modellversionen. Zweitens: regelmäßige, unabhängige Bias‑Tests mit öffentlichen Methoden. Drittens: Stärkung von Medienkompetenz dort, wo KI politische Inhalte ausspielt.

Warum genau diese drei? Die UW‑Studie zeigt, dass schon wenige, gerahmte Interaktionen die Haltung verändern können – wer das weiß, kann Gegenmittel wie Aufklärung und neutrale Kontrollprompts gezielt einsetzen (2025) (Quelle).

Und: Mehrsprachige Tests belegen, dass Bias je nach Sprache variieren kann – Audits müssen das abbilden (2025) (Quelle).

Für Unternehmen heißt das: Baue ein zweistufiges Audit. Stufe 1: interne Checks mit repräsentativen Prompts, klaren Metriken und Regressionstests nach jedem Release. Stufe 2: externe Prüfungen durch unabhängige Auditorien, die Protokolle vergleichen und Abweichungen öffentlich machen. Für Bürger:innen: Nutze Transparenz‑Hinweise, melde systematische Verzerrungen, teile reproduzierbare Prompts.

Und die Politik? Statt Schlagwort‑Schlachten um „Woke AI“ braucht es Mindeststandards: klare Kennzeichen für politisch sensible Antworten, Einspruchs‑ und Prüfwege, sowie Berichte über Korrekturen. So schützen wir Meinungsfreiheit, ohne die Systeme unreguliert zu lassen – und machen Debatten wieder überprüfbar.

Fazit

Politische Bias in KI ist messbar, mehrsprachig und beeinflussbar. Studien zeigen Verschiebungen nach wenigen Interaktionen und sprachabhängige Tendenzen. Die Antwort liegt in Transparenz, Audits und Bildung – nicht in pauschalen Etiketten. Wer Regeln offenlegt, Versionen dokumentiert und neutrale Checks zur Routine macht, reduziert Risiken für die öffentliche Debatte.

Konkrete Takeaways: 1) Richtlinien veröffentlichen und Einspruch ermöglichen. 2) Mehrsprachige Bias‑Tests als Release‑Gate. 3) Medienkompetenz als Pflichtmodul in Produkten mit politischem Output. 4) Reproduzierbare Prompt‑Suiten für externe Auditorien bereitstellen. So werden Hypothesen prüfbar – und Einflüsse politischer Rahmung sichtbar (Quelle) (Quelle).

Was ist deine Erfahrung: Wo hast du politische Bias in KI bemerkt – und welche Gegenmaßnahme würdest du als Erstes einführen? Diskutiere mit uns in den Kommentaren.