Schlagwort: prompting

-

Transparente lokale LLM‑Pipelines mit Opik und Colocated Models

Zuletzt aktualisiert: 2025-11-22 Kurzfassung Opik local LLM pipeline ist heute ein pragmatischer Weg, um LLM‑Anwendungen lokal beobachtbar und reproduzierbar zu betreiben. Dieser Artikel zeigt, wie

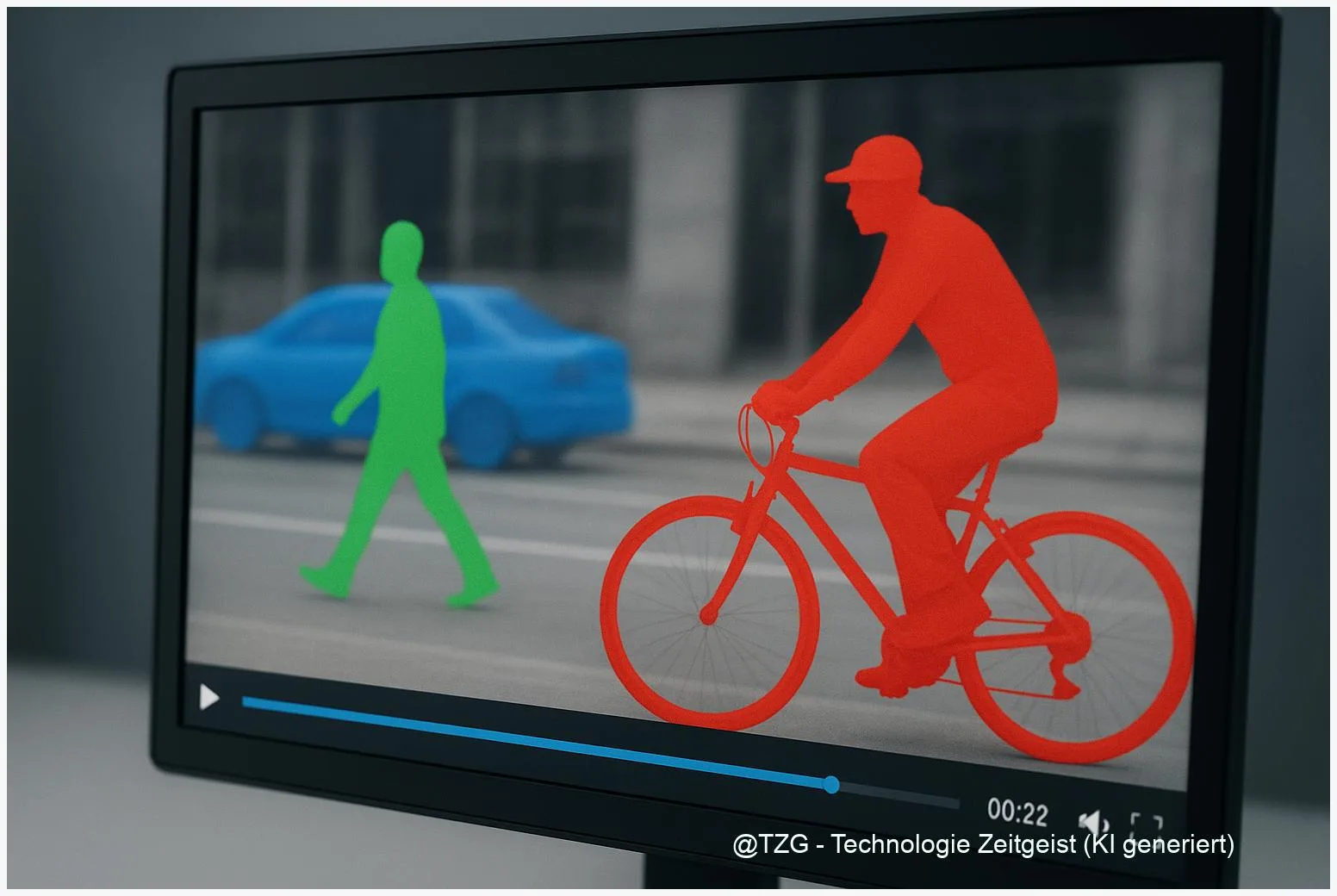

SAM 3: Promptable Concept Segmentation für robuste Video‑Annotation

Zuletzt aktualisiert: 2025-11-21 Kurzfassung SAM 3 steht für einen neuen Ansatz in der Bild‑ und Videosegmentierung, der besonders auf promptable concept segmentation abzielt. Dieser Artikel

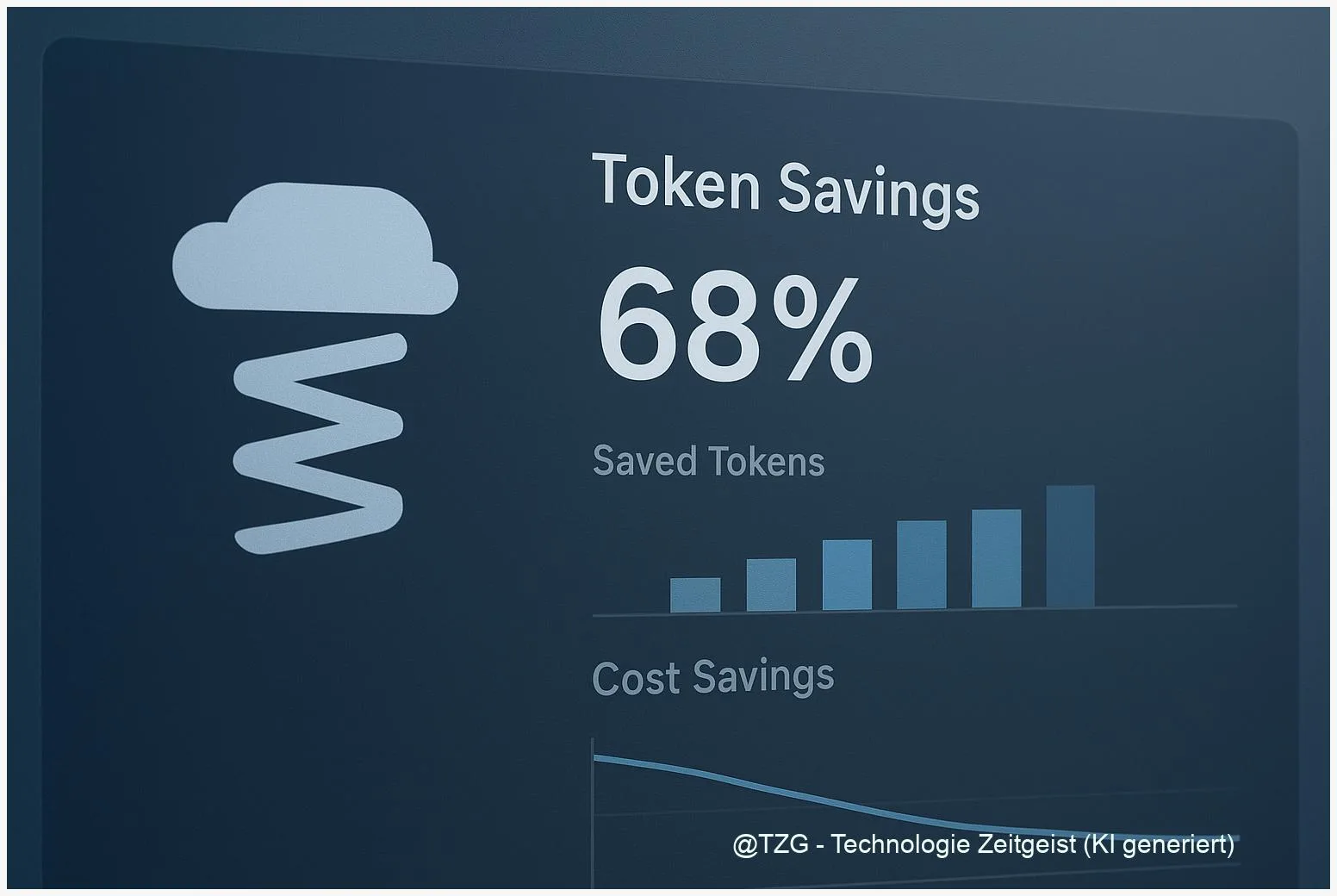

Prompt‑Compression mit LLMLingua: LLM‑API‑Kosten um 5–20× senken

Zuletzt aktualisiert: 2025-11-17 Kurzfassung Prompt compression llmlingua ist eine Technik, mit der lange Prompts verdichtet werden, um LLM‑API‑Kosten und Latenzen deutlich zu reduzieren. Dieser Praxis‑Guide

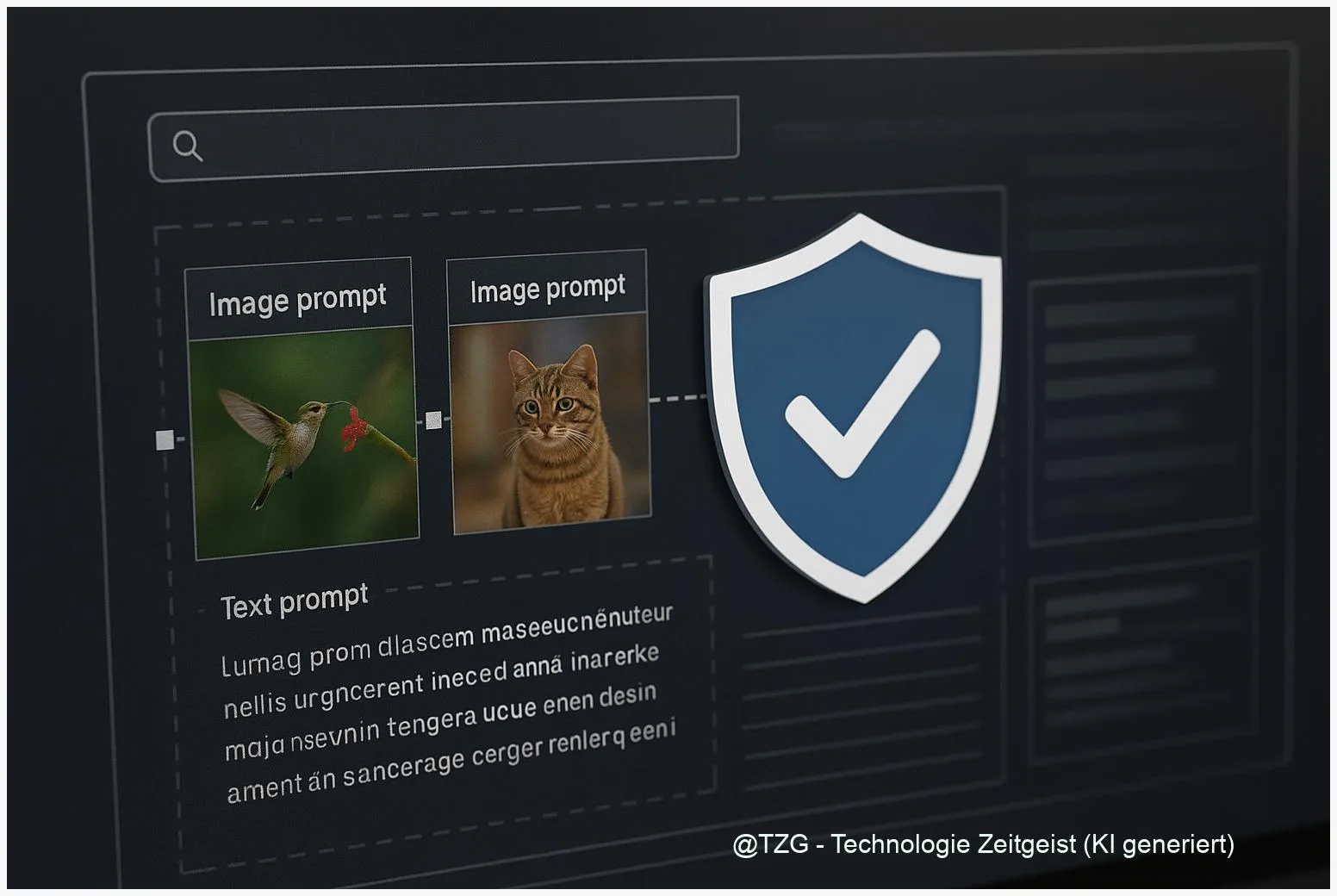

Multimodal‑AI schützen: Verteidigung gegen Prompt Injection 2.0

Zuletzt aktualisiert: 2025-11-17 Kurzfassung Multimodale Systeme sind angriffspfadreicher geworden: die neue Phase, oft als Prompt Injection 2.0 bezeichnet, kombiniert visuelle Träger, agentische Workflows und Trainings‑Angriffe.

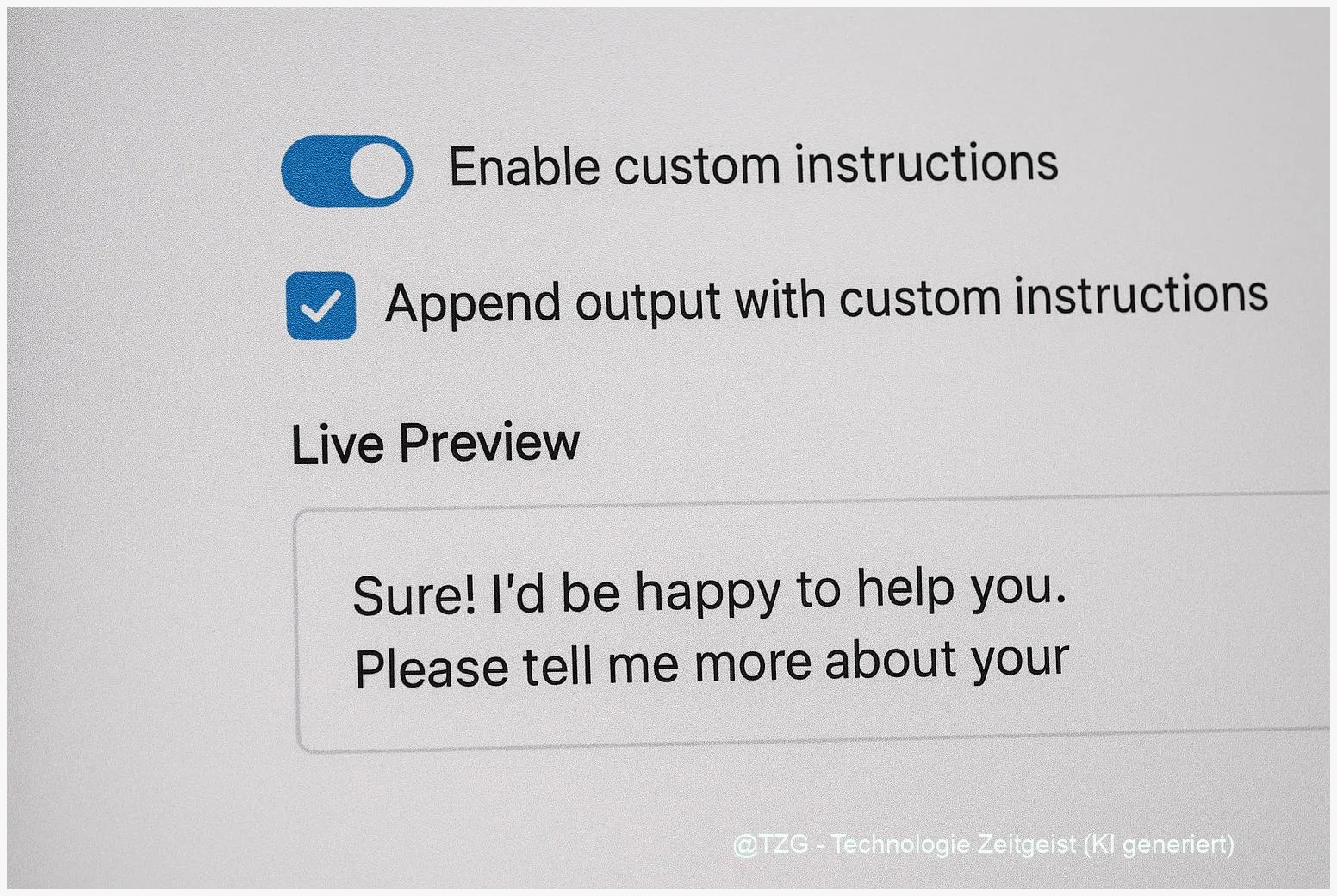

Micro‑UX für Custom Instructions: Wie kleine Format‑Fixes Signale ändern

Zuletzt aktualisiert: 2025-11-16 Kurzfassung Micro‑UX‑Steuerelemente verändern, wie Nutzer ihre custom instructions LLM micro-ux formulieren und wie Modelle darauf reagieren. Kleine Einstellungen — etwa eine Checkbox

MIVPG: Multimodal Fusion und Multi‑Image‑Design für MLLMs

Zuletzt aktualisiert: 2025-11-15 Kurzfassung MIVPG steht für einen praktischen Ansatz zur MIVPG multimodal fusion: mehrere Bilder werden nicht als einzelne Inputs, sondern als “Bag” von

DiverGen Deep Dive — Warum generative data diversity Scale bei Long‑Tail‑Vision schlägt

Zuletzt aktualisiert: 12. November 2025 Kurzfassung DiverGen zeigt, dass generative data diversity oft wirksamer ist als reine Skalierung — besonders bei Long‑Tail‑Aufgaben wie LVIS‑Segmentierung. Die

Fitness‑Trainer war einmal — mit ChatGPT zum eigenen Trainingsplan

Zuletzt aktualisiert: 1. November 2025 Kurzfassung Dieser Text zeigt, wie du in wenigen Schritten einen praktikablen Trainingsplan mit ChatGPT erzeugst, prüfst und sicher anwendest. Er

Chain-of-Thought vs. Chain-of-Draft: Balancing Accuracy and Efficiency in Prompting

Abstract Large Language Models can solve complex problems more effectively when guided by structured prompts. Two notable strategies are Chain of Thought (CoT) prompting –