Kurzfassung

SPICE ist ein neues Trainingskonzept, das ein einzelnes Sprachmodell in zwei Rollen teilt: einen Challenger mit Dokumentzugang und einen Reasoner ohne Zugriff. Durch dieses Self‑Play‑Setting entstehen faktenbasierte, überprüfbare Aufgaben aus realen Texten – und laut dem Meta/NUS‑Preprint steigen Reasoning‑Leistungen im Mittel um rund +8,9 % (Mathematik) bzw. +9,8 % (allgemeines Reasoning). Diese Zahlen stammen aus dem arXiv‑Paper; Unabhängige Replikationen sind noch ausstehend.

Einleitung

Es gibt Momente, in denen Forschung sich anfühlt wie ein Gespräch zwischen zwei Stimmen desselben Geistes. Das neue Meta/NUS‑Paper mit dem Namen SPICE beschreibt genau das: ein Modell, das sich selbst herausfordert und beantwortet. Es ist keine magische Abkürzung, sondern ein Versuch, Lernaufgaben aus echten Dokumenten zu schöpfen — statt aus künstlichen Aufgaben. Leserinnen und Leser, die verstehen wollen, wie KI besser Schlussfolgern lernt, finden hier eine knapp gehaltene, kritisch‑neutrale Darstellung der Idee und ihrer Implikationen.

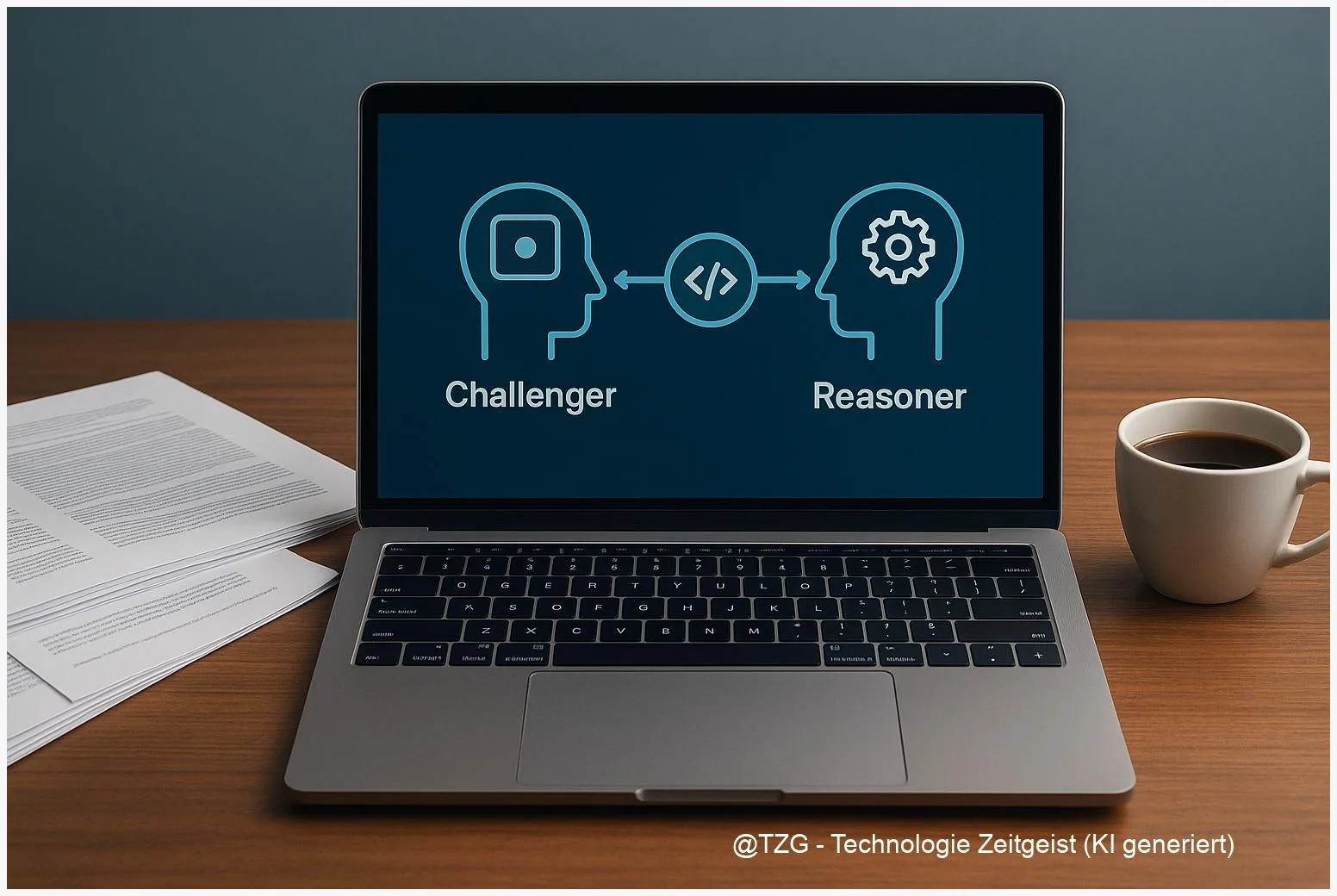

Wie SPICE funktioniert

SPICE organisiert ein Training als ein Spiel zwischen zwei Rollen, die ein und dasselbe Modell einnimmt: Der Challenger hat Zugang zu einem großen Korpus und erzeugt daraus anspruchsvolle, faktenbasierte Fragen samt Referenzantworten; der Reasoner bekommt nur die Fragen und muss sie ohne Dokumentzugriff lösen. Diese Informationsasymmetrie ist zentral: sie zwingt das Modell, robuste Schlussfolgerungen zu ziehen statt sich an Rohtexten zu orientieren.

Der Clou liegt im Belohnungsdesign: Der Challenger wird dafür incentiviert, Aufgaben zu erzeugen, die weder zu leicht noch zu schwer sind — konkret zielt die Reward‑Funktion auf eine mittlere Erfolgsrate beim Reasoner. So entsteht ein Curriculum, das sich dynamisch an die Leistungsgrenze des Reasoners anpasst. Weil die Aufgaben aus realen Dokumenten stammen, sind sie geerdet: Goldantworten sind extrahierbar und damit überprüfbar.

“Ein Modell fordert sich selbst mit Aufgaben aus der Welt — nicht nur mit synthetisch erzeugten Rätseln.”

Wichtig zu betonen: Die Methode ist ein Reinforcement‑Learning‑Ansatz, aber nicht allein auf simulierten Daten aufgebaut. Stattdessen dient ein Korpus als Umwelt, die kontinuierlich neue, verankerte Beispiele liefert. In der Praxis bedeutet das: Der Challenger muss dokumenttreue Fragen bauen, der Reasoner muss generalisieren. Und genau diese Wechselwirkung erzeugt laut Paper die berichteten Verbesserungen.

| Rolle | Zugang | Aufgabe |

|---|---|---|

| Challenger | Korpus (Dokumente) | Fragen + Goldantworten erzeugen |

| Reasoner | Kein Dokumentzugriff | Fragen lösen, generalisieren |

Was die Zahlen sagen — und wo Vorsicht gilt

Das Paper berichtet klare, relativ große Zugewinne: im Schnitt +8,9 % bei mathematischen Reasoning‑Benchmarks und +9,8 % bei allgemeinen Reasoning‑Tests. Einzelne Modellfamilien zeigen unterschiedliche absolute Verbesserungen — Beispiele aus dem Preprint nennen etwa +9,1 Punkte für Qwen3‑4B und +11,9 Punkte für das Modell OctoThinker‑8B. Diese Werte sind beeindruckend, aber sie sind primär Angaben der Autorinnen und Autoren und sollten als vorläufig betrachtet werden, bis unabhängige Replikationen vorliegen.

Es gibt mehrere Gründe für gebotene Vorsicht: Erstens stammen die Zahlen aus einem einzigen arXiv‑Preprint; Peer‑Review und externe Reproduktionen fehlen zum Stand dieses Artikels. Zweitens hängt viel von den Details des Korpus ab — das Paper nennt eine Trainingssammlung von ungefähr 20.000 Dokumenten, aber genaue Split‑Regeln und Crawl‑Metadaten werden nicht vollständig offen dargelegt. Solche Details beeinflussen, ob ein Modell wirklich generalisiert oder subtile Daten‑Lecks ausnutzt.

Doch die Autoren liefern auch ablationelle Befunde: Ohne Korpus schrumpfen die Verbesserungen, und ein feststehender Challenger produziert geringere Gewinne als der ko‑evolutive Ansatz. Diese Experimente stützen die Kernthese — dennoch bleibt die Frage, wie robust diese Effekte außerhalb der angegebenen Infrastruktur sind (z. B. andere Korpora, andere Verifier).

“Zahlen sind Fenster; man muss genau sehen, durch welches Glas sie blicken.”

Kurz: Die berichteten Gewinne sind real in der Autoren‑Evaluation, aber die externe Validierung fehlt noch. Für verantwortungsbewusste Anwendung und Forschung sind offene Repos, Checkpoints und detaillierte Korpusmetadaten essenziell, um die Ergebnisse zu überprüfen und auf breiter Basis zu testen.

Technische Feinheiten ohne Jargon

Wer sich nicht in Formeln verlieren möchte, dem sei dieses Bild angeboten: SPICE ist ein separates Übungs‑ und Prüfungszimmer innerhalb desselben Trainingsprozesses. Das Modell betreibt beide Räume abwechselnd. Im Übungsraum (Challenger) sammelt es Material und baut Aufgaben, im Prüfungsraum (Reasoner) wird das Gelernte abgefordert — aber ohne Zugriff auf das Material. Dieser Wechsel sorgt dafür, dass das Modell nicht nur kopiert, sondern lernt zu argumentieren.

Ein zentrales technischelement ist die Reward‑Formulierung für den Challenger. Statt maximale Schwierigkeit zu belohnen, zielt die Funktion auf Aufgaben mittlerer Schwierigkeit: wenn der Reasoner etwa zur Hälfte richtig liegt, sind die Aufgaben ideal, weil sie die Lernkurve maximal stimulieren. Das ist ein psychologisch plausibles Prinzip — nicht nur in Maschinen, auch in menschlichem Lernen.

Weitere Bausteine im Paper: eine Kombination aus offengelegten Korpora (angegeben: ~20.000 Dokumente aus Mischungen wie Math‑ und NaturalReasoning‑Sammlungen), ein Verifier‑Layer für mathematische Äquivalenz und eine RL‑Optimierungsroutine, die Rollenwechsel ermöglicht. Die Autoren beschreiben zudem Ablationsversuche, die zeigen, welche Komponenten den größten Beitrag leisten.

Technik wird hier absichtlich zugänglich dargestellt: Es geht nicht um exotische Tricks, sondern um ein klares Lernprinzip — geerdete Aufgaben + dynamisches Curriculum. Die praktischen Anforderungen bleiben jedoch nicht trivial: Trainings‑infrastruktur, Checkpoint‑Management und Evaluationstools bestimmen, ob ein Team die Idee robust nachstellen kann.

Chancen, Risiken und offene Fragen

SPICE eröffnet eine praktikable Route, damit Modelle aus realen Texten lernen statt nur aus synthetischen Übungen. Das hat großes Potenzial für bessere Nachvollziehbarkeit: Wenn Aufgaben aus Dokumenten stammen, lassen sich Antworten prinzipiell prüfen. Das vermindert das Risiko von Halluzinationen, weil Verifizierbarkeit zum Trainingsprinzip wird.

Gleichzeitig entstehen neue Risiken. Wenn der Korpus verzerrte oder fehlerhafte Texte enthält, kann der Challenger problematische Aufgaben erzeugen. Ohne strenge Filter und Qualitätsprüfungen könnte ein selbstverstärkender Kreislauf toxischer oder falscher Inhalte entstehen. Das Paper erwähnt diese Punkte und schlägt Curations‑Layer vor — in der Praxis ist das jedoch ein nichttrivialer Engineering‑Aufwand.

Weitere offene Fragen: Wie gut skaliert der Ansatz auf sehr große Korpora oder Multilingualität? Welche Kosten und welche CO₂‑Bilanz sind mit längeren Self‑Play‑Runs verbunden? Und ganz entscheidend: Replizieren unabhängige Teams die berichteten Effekte auf anderen Benchmarks und mit anderen Modellfamilien?

“Autonomie braucht Kontrolle: je selbstständiger ein System lernt, desto klarer müssen seine Umweltregeln sein.”

Aus Perspektive von Forschung und Praxis gilt: SPICE ist ein sauberes, nachvollziehbares Konzept, das geprüft werden sollte — nicht blind eingesetzt. Offene Daten, reproduzierbare Code‑Releases und gemeinschaftliche Replikationsprojekte sind die nächsten Schritte, die aus dem Konzept Vertrauen machen.

Fazit

SPICE kombiniert dokumentverankerte Aufgaben mit einem ko‑evolutiven Self‑Play‑Training und erzielt im Paper bemerkenswerte Verbesserungen bei Reasoning‑Benchmarks. Die Kernidee — Information‑Asymmetrie zwischen Challenger und Reasoner — ist elegant und nachvollziehbar. Wichtig bleibt, die Ergebnisse unabhängig zu reproduzieren und Korpus‑Transparenz sicherzustellen. Nur so lässt sich abschätzen, wie verallgemeinerbar die Gewinne wirklich sind.

*Diskutiere in den Kommentaren: Welche Fragen sollten Forscher zuerst beantworten? Teile den Artikel, wenn er dir neue Perspektiven gegeben hat.*

Schreibe einen Kommentar