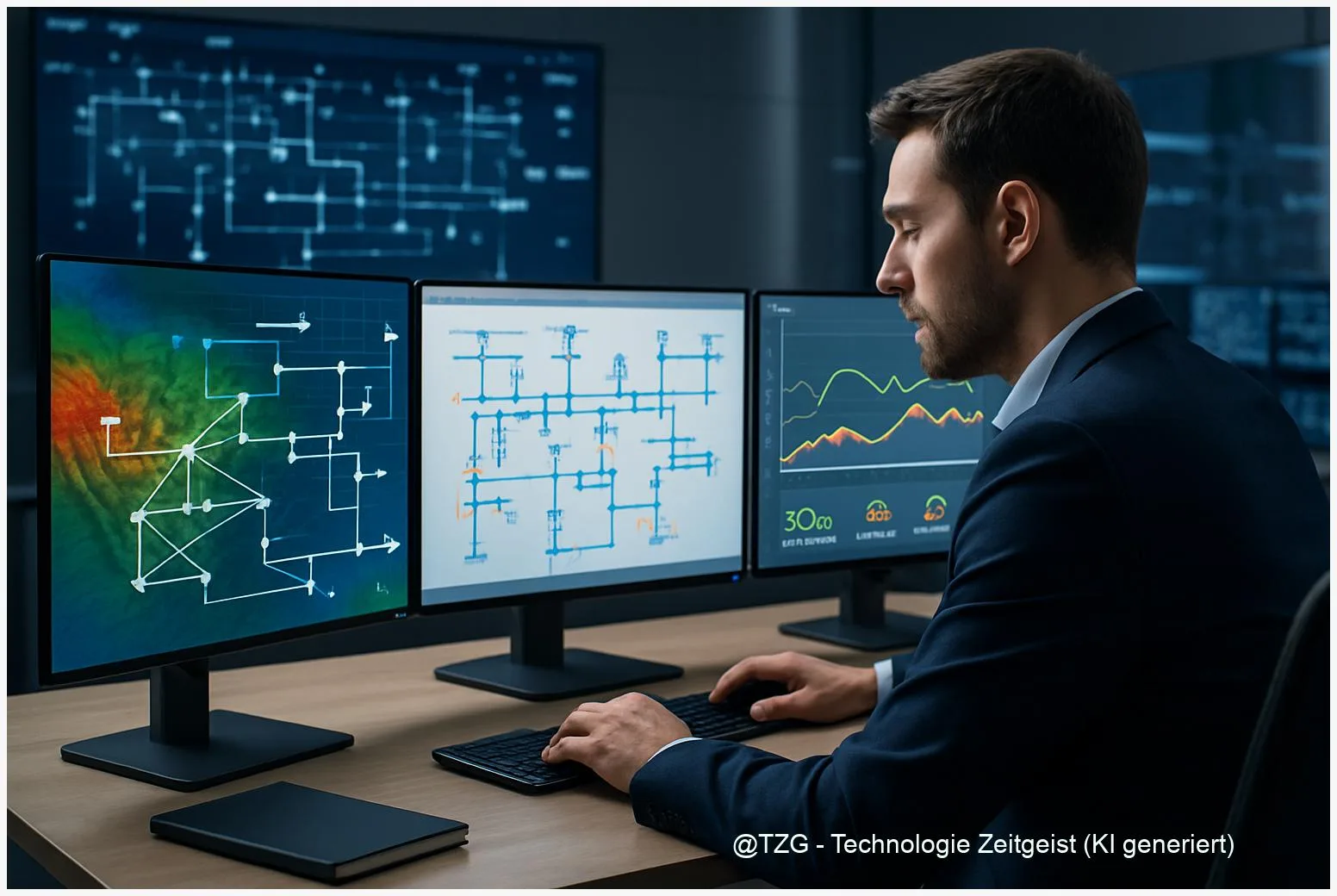

Kaskadierte Modelle für Energienetze: Planung trifft Echtzeit

Kurzfassung

Neue Forschung zeigt, wie kaskadierte Modelle helfen, langfristige stochastische Modellierung Energie mit Echtzeit-Regelung zu koppeln: Planungsschritte sorgen für robuste Szenario‑Sets, die kurze Zeithorizonte in der Echtzeitsteuerung präzise versorgen. Das Ergebnis sind bessere Speicherzyklen, effizientere Lastverschiebung und stabilere Einspeisung. Dieser Artikel erklärt, wie die Methode funktioniert, welche Algorithmen genutzt werden und was das für Netzbetreiber und Energieversorger konkret bedeutet.

Einleitung

Netze werden komplexer: mehr volatile Erzeugung, mehr dezentrale Speicher, mehr flexible Verbraucher. Deshalb gewinnt das Zusammenspiel von Planung und Echtzeitsteuerung an Bedeutung. Kaskadierte Modelle kombinieren langfristige, stochastische Planung mit kurzzyklischer, schnellen Regelung — und schaffen so einen klaren Informationsfluss: Szenarien, die die Unsicherheiten in Forecasts abbilden, geben Impulse an die reale Steuerung. In diesem Artikel lesen Sie, warum diese Kopplung für Netzbetreiber und Energieversorger entscheidend ist, welche algorithmischen Muster sich durchsetzen und welche betrieblichen Vorteile zu erwarten sind.

Stochastische Modelle vs. Echtzeitverfahren

Kurz erklärt: stochastische Modellierung Energie bedeutet, dass die Planung nicht von einem einzigen, perfekten Forecast ausgeht, sondern von vielen möglichen Zukunftsbildern. Diese Szenarien fangen Erzeugungs- und Verbrauchsunsicherheiten ein — zum Beispiel Wind- oder Solarprognosefehler. Echtzeitverfahren dagegen arbeiten mit kurzen Steuerzyklen, reagieren auf Abweichungen und sorgen für Spannungsausgleich, Frequenzstabilität und lokale Engpassbehandlung.

“Gute Planung liefert der Echtzeitsteuerung die Werkzeuge — sie bestimmt, was kurzfrisitg überhaupt möglich ist.”

Die Trennung hat Vorteile: große Horizonte erlauben wirtschaftliche Entscheidungen (Investitionen, Speicherstrategien), kurze Horizonte sichern Netzstabilität. Doch die Trennung birgt Risiken: Wenn die langfristige Planung Unsicherheiten zu grob zusammenfasst, trifft die Echtzeitsteuerung immer nur suboptimale Entscheidungen. Kaskadierte Modelle überbrücken diese Lücke, indem sie Planungslösungen (z. B. Wahrscheinlichkeitsverteilungen oder konservative Reserven) in Form einfacher Regeln oder Parameter an die Echtzeitkontrollen übergeben.

Ein praktisches Beispiel: Ein Netzbetreiber plant mit einem zweistufigen, stochastischen Optimierer (two‑stage stochastic programming). In der ersten Stufe werden Kapazitäten und Speicherfahrpläne für den nächsten Tag unter Szenarien bestimmt; in der zweiten Stufe werden reale Messungen verwendet, um kurzfristig nachzuregeln. Die Echtzeitebene nutzt diese Vorgaben als Constraints oder als Referenztrajektorien — so bleibt Betriebssicherheit erhalten und wirtschaftliche Ziele werden nicht komplett geopfert.

Übersichtstabelle: Planung vs. Echtzeit

| Merkmal | Beschreibung | Ziel |

|---|---|---|

| Horizont | Stunden bis Tage (Szenario‑basiert) | Kostenminimierung, Reserveplanung |

| Zyklus | Sekunden bis Minuten (Regelung) | Stabilität, schnelle Reaktion |

Für Netzbetreiber bedeutet das: stochastische Modellierung Energie liefert robuste Vorgaben, die aber so gestaltet sein müssen, dass Echtzeitalgorithmen sie praktisch nutzen können. Im nächsten Kapitel schauen wir uns an, wie diese Übergabe methodisch gelingt.

Kopplungsdesign: Planung trifft Regelung

Kopplungsdesign beschreibt die Schnittstelle: Was übergibt die Planung an die Echtzeitsteuerung und in welcher Form? Praktische Muster sind Parameter, Referenzpfade, Sicherheitsmargen und scenario‑weighted Kostenfunktionen. Gute Kopplung heißt: möglichst viel Entscheidungswert übergeben, ohne die Echtzeitkontrolle mit Details zu überfrachten.

Ein verbreiteter Ansatz ist die hierarchische Steuerung mit zwei Ebenen: Die obere Ebene optimiert mit stochastischen Szenarien wirtschaftliche Ziele und berechnet Zieltrajektorien sowie Reservepläne. Die untere Ebene ist ein schneller Regelkreis (z. B. Model Predictive Control, MPC), der mit kürzeren Zeithorizonten arbeitet und die Vorgaben als weiche Ziele oder als Constraints nutzt. Die Kunst besteht darin, Vorgaben so zu formulieren, dass sie Robustheit und Flexibilität liefern: etwa als Wahrscheinlichkeitsgrenzen (chance constraints), als Hysterese‑Regeln für Speicher oder als dynamische Preis-Signale für Lastverschiebung.

Ein weiteres Muster ist das Rolling‑Horizon‑Design: Planungsoptimierer liefern regelmäßig aktualisierte Szenarien und Vorhersagefehlerstatistiken, die in jedem Receding‑Horizon‑Schritt die Grenzen der Echtzeitoptimierung anpassen. So reagiert das System nicht nur auf aktuelle Messwerte, sondern auf eine bewusste Einschätzung künftiger Risiken. Netzbetreiber nutzen das, um Reservekapazitäten gezielt zu platzieren und Speichermanagement intelligent zu timen.

Für die Praxis sind zwei Faktoren entscheidend: Latency und Interpretierbarkeit. Latency meint, wie viel Zeit die Echtzeitebene hat, um Entscheidungen zu treffen; Interpretierbarkeit heißt, dass Betriebspersonal und Schutzsysteme Vorgaben verstehen und bei Bedarf eingreifen können. Deshalb enthalten erfolgreiche Kopplungsdesigns oft Fallback‑Regeln: Wenn ein Szenario extrem abweicht, greift ein vordefinierter Notmodus mit konservativen Sicherheitsmargen.

Schließlich spielt die Kommunikation eine Rolle: Standards und Schnittstellen (z. B. offene Telemetriedaten, API‑basierte Szenariolieferung) machen die Kopplung reproduzierbar. Ohne klare Datenformate verliert die Echtzeitkontrolle die Aussagekraft der Planung — und damit einen Großteil des Nutzens.

Algorithmen & Implementierung

Auf der algorithmischen Ebene treffen drei Familien aufeinander: two‑stage/stochastic programming, chance‑constrained Optimierung und modellprädiktive Regelung (MPC). In Kombination entstehen hybride Lösungen: Die Planung nutzt stochastic programming, um robuste Off‑Line‑Pläne zu erstellen; die Echtzeitebene implementiert MPC oder schnelle Heuristiken, die auf den Planvorgaben aufbauen.

Wichtig ist die Auswahl der Szenario‑Strategie. Monte‑Carlo‑Sampling liefert eine breite Streuung, ist aber rechenintensiv. Szenario‑Reduktion (z. B. k‑means oder Moment‑Matching) komprimiert diese Bank in handhabbare Repräsentanten. Welche Option passt, hängt von Ziel und Rechenbudget ab: Netzweite Planung kann mehr Szenarien vertragen, während Feldgeräte mit limitierter Rechenleistung auf aggressive Reduktion angewiesen sind.

Ein Praxisdetail: Solver-Latenz. Echtzeit‑MPC läuft oft in Sekunden oder Millisekunden. Deshalb wandeln Entwickler komplexe stochastische Vorgaben in leichte Constraints oder Regelparameter um. Manche Teams nutzen vortrainierte Policies (Machine Learning) als Proxy für teure Optimierer: Ein kleiner, in Echtzeit ausführbarer ML‑Policyschritt übernimmt die Aufgabe, die Lösung des langfristigen Optimierers approximativ nachzubilden. Solche Policy‑Ansätze sind vielversprechend, benötigen aber gute Trainingsdaten und solide Evaluierung, um Sicherheit nicht zu gefährden.

Technisch gesehen spielen verteilte Architekturen eine große Rolle: Bei virtuellen Kraftwerken (VPPs) oder Microgrids werden lokale Optimierer und ein zentraler Coordinator kombiniert. Die lokale Ebene steuert Batteriesysteme und flexible Lasten, die zentrale Ebene liefert Szenarios und Preisimpulse. Kommunikationsprotokolle, Datenintegrität und Synchronisation sind hier kritische Punkte — ohne sie können akzeptable theoretische Gewinne im Feld verloren gehen.

Abschließend: Implementierungsentscheidungen sind Trade‑offs zwischen Optimalität, Reaktionszeit und Betriebssicherheit. Gute Teams testen in Simulationen mit realistischen Forecast‑Fehlern, messen Latenzen und bereiten Notfallprozeduren vor.

Simulationsergebnisse: Effizienzgewinne & Stabilität

Simulationen aus jüngeren Studien zeigen konsistente Vorteile: gekoppelte, kaskadierte Modelle senken Betriebskosten, reduzieren unerwünschte Batteriezyklen und verbessern die Einhaltung technischer Grenzwerte. Typische Kennzahlen sind Einsparungen bei Betriebs- und Reservekosten zwischen 5 % und 15 % gegenüber rein deterministischen Ansätzen sowie eine messbar verringerte Anzahl an Systemeingriffen durch die Netzführung.

Ein zentrales Messergebnis ist die Stabilität unter Extremereignissen: Wenn schlechte Forecasts auftreten, reagieren kaskadierte Systeme robuster, weil die Planung konservative Reserven vorhält und die Echtzeitkontrolle diese Reserven adaptiv freigibt. Zudem zeigen Simulationen, dass durch intelligente Lastverschiebung (dynamische Tarife oder automatische Laststeuerung) Spitzenlasten flacher werden, was Investitionsbedarf in Netzverstärkung mindert.

Wichtig ist die Validierung gegen realistische Daten: Studien, die mit historischen Wind‑ und Solarprognosefehlern sowie mit realen Verbrauchsprofilen arbeiten, liefern die belastbarsten Aussagen. In mehreren Fallstudien (Microgrids, VPPs und Verteilnetze) reduzierten kaskadierte Ansätze Leistungsengpässe und erhöhten die Auslastungsrate von Speichern — also mehr nutzbare Energiemenge pro Ladezyklus. Das verbessert Wirtschaftlichkeit und Nachhaltigkeit gleichzeitig.

Doch es gibt Grenzen: Komplexe Modelle benötigen aufwändige Kalibrierung; Szenarioerstellung ist eine Fehlerquelle. Wenn die Szenariomodelle falsche Wahrscheinlichkeiten zuweisen, können die Planvorgaben trügerisch wirken. Deshalb empfehlen Forscher, Sensitivitätsanalysen und Back‑testing mit mehreren Datensätzen durchzuführen und operative Metriken (z. B. Reglerauslastung, SoC‑Verteilung) kontinuierlich zu überwachen.

Zusammengefasst: Simulationen belegen reale Effizienzgewinne und stabilisierende Effekte, wenn Kopplung, Szenariodesign und Implementierung pragmatisch zusammenspielen. Näher an der Praxis bringen Feldtests in Kombination mit transparenten Leistungskennzahlen den letzten Schritt zur breiten Adoption.

Fazit

Kaskadierte Modelle bringen Planung und Echtzeitsteuerung zusammen und nutzen die Stärken beider Ebenen: langfristige Robustheit und kurzfristige Reaktionsfähigkeit. Für Netzbetreiber bedeutet das konkret: effizientere Speicherzyklen, bessere Lastverschiebung und weniger Eingriffe. Erfolg hängt von gutem Szenariodesign, klaren Schnittstellen und realistischer Implementierung ab. Schrittweise Feldtests und transparente Metriken sind der Weg zur Praxisreife.

*Diskutiere mit in den Kommentaren und teile diesen Beitrag in den sozialen Medien!*