Audio-KI gewinnt an Bedeutung: Sprachassistenten sind nicht länger nur Spielerei, sondern dienen zunehmend als praktische Bedienoberfläche für Geräte im Alltag. Das Hauptargument lautet: Stimme reduziert Reibung — Geräte reagieren schneller, oft lokal und mit weniger Ablenkung. Dieser Text erklärt, warum Audio-KI 2026 auf mehr Geräten zu finden ist, welche technischen und rechtlichen Faktoren das beeinflussen und was das für Nutzerinnen und Nutzer bedeutet.

Einleitung

Viele Menschen nutzen bereits Sprachbefehle, ohne es bewusst wahrzunehmen: Beim Einschalten der Lampen, beim Nachfragen nach dem nächsten Termin oder beim Abspielen von Musik. In Häusern, Autos und Wearables nimmt die Stimme eine wachsende Rolle als Steuerungsweg ein. Für Hersteller ist das ein Weg, Funktionen leichter zugänglich zu machen; für Nutzerinnen und Nutzer bedeutet es oft weniger Tippen und weniger Menüzugriff.

Hinter diesem Trend stehen drei Entwicklungen: leistungsfähigere, lokal laufende Modelle, bessere Spracherkennung (ASR) und ein strenger werdender Datenschutzrahmen, der On‑Device‑Verarbeitung belohnt. Zugleich treiben Analysten und Marktstudien das Wachstum: Smart‑Speaker‑Shipments lagen 2024 in der Größenordnung von 87,4 Millionen Einheiten weltweit, bei gleichzeitigem Druck auf Cloud‑Lösungen durch Regulierungsfragen. Dieser Artikel beschreibt verständlich, warum 2026 mehr Geräte Stimme als primäre Schnittstelle anbieten werden und welche Folgen das hat.

Warum Audio-KI jetzt auf Stimme setzt

Audio‑Künstliche Intelligenz, kurz Audio-KI, bezeichnet Technologien, die gesprochene Sprache erkennen, verstehen und darauf reagieren. Ein sprachgesteuertes Gerät kombiniert drei Kernkomponenten: ein Hot‑word‑Erkennungsmodul (das zuhört, ob es angesprochen wird), die automatische Spracherkennung (ASR) zur Transkription und ein Modell, das Absicht und Antwort bestimmt. Diese Bausteine sind in den letzten Jahren kompakter und effizienter geworden — sie brauchen weniger Rechenleistung und lassen sich teilweise direkt auf dem Gerät betreiben.

Lokale Verarbeitung kann Latenz senken und Datenschutz erhöhen, ist aber kein Allheilmittel: sie bringt eigene technische Grenzen mit sich.

Warum führt das zu einer Verbreiterung von sprachgesteuerten Geräten? Erstens reduziert On‑Device‑Processing die Abhängigkeit von Cloud‑Verbindungen: Sprachbefehle werden sofort erkannt, auch bei instabiler Internetverbindung. Zweitens verlangen Regulierungen in Europa zunehmend Nachweise für datensparsame Architekturen; wer lokale Verarbeitung anbietet, kann das als Vertrauensvorteil kommunizieren. Drittens erlauben neue Hardware‑Designs (effiziente NPU/TPU in Smartphones, Edge‑Chips in Speakern) den Betrieb kleinerer Modelle mit guter Qualität.

Eine knappe Tabelle fasst typische Merkmale zusammen:

| Merkmal | Beschreibung | Auswirkung |

|---|---|---|

| Hot‑word lokal | Ein kleiner Erkennungsprozess läuft dauerhaft auf dem Gerät | Sofortige Reaktion, weniger Datenübertragung |

| On‑Device‑ASR | Grundlegende Spracherkennung ohne Cloud | Geringere Latenz, begrenzte Modelle, bessere Privatsphäre |

Diese technischen Schritte senken die Eintrittsbarriere für Hersteller und erhöhen die Nutzungsqualität. Analysten sehen deshalb wachsende Investitionen in Conversational‑AI‑Produkte und mehr Interaktionen durch AI‑Agenten — Zahlen aus Branchenanalysen belegen einen starken Zuwachs bei automatisierten Interaktionen in Unternehmen in den Jahren 2025–2027.

Wie Sprachsteuerung den Alltag praktisch verändert

Sprachsteuerung ist praktisch, weil sie Hände und Blick frei lässt. Im Haushalt bedeutet das: Kochen und gleichzeitiges Abrufen eines Rezepts per Sprachbefehl; im Auto reduziert Sprache Ablenkung; auf Wearables ermöglichen kurze Sprachbefehle schnelle Interaktionen bei Bewegung. Diese Alltagsszenen sind keine Zukunftsmusik, sie sind bereits weit verbreitet.

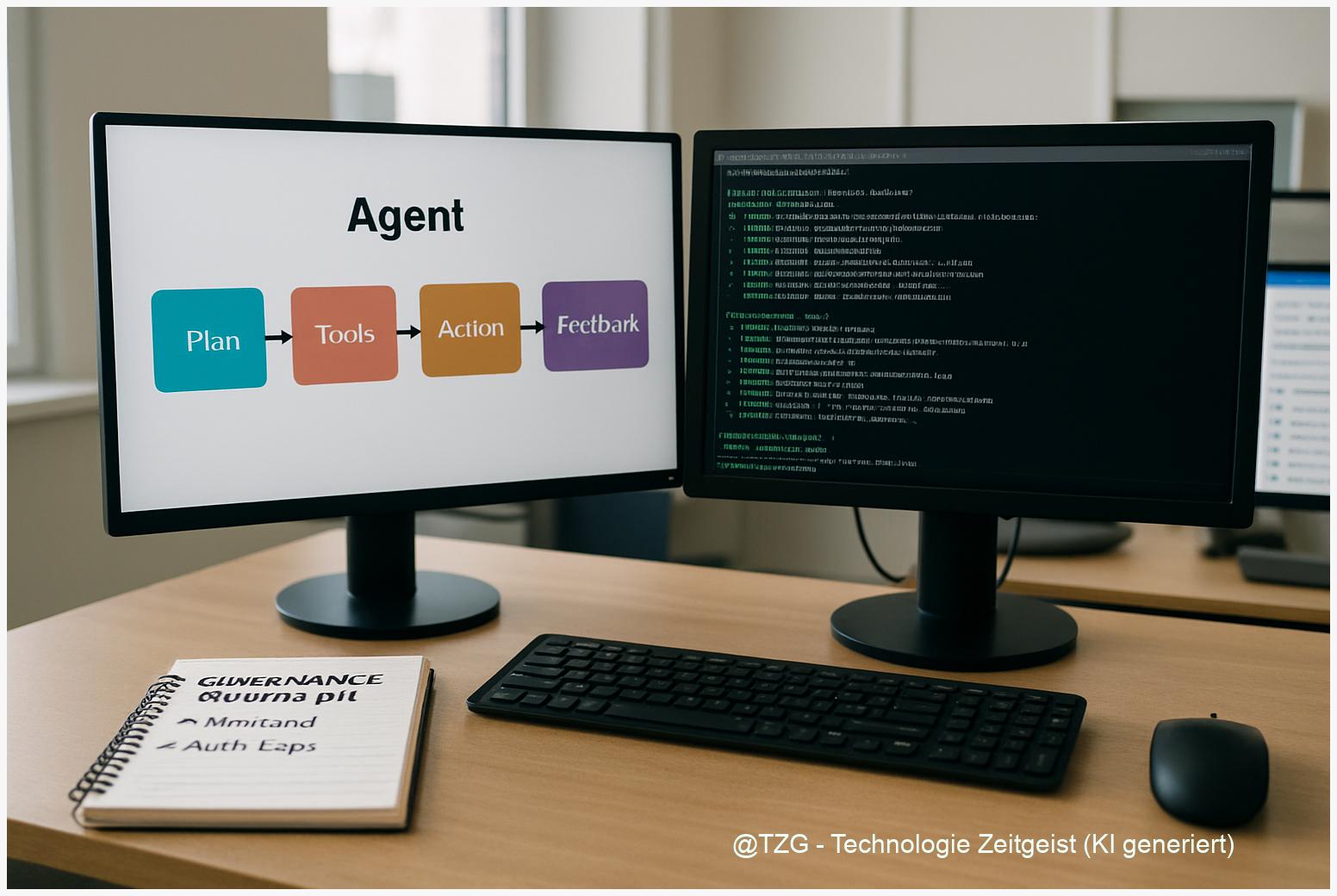

Technisch gesprochen verlagern viele Hersteller Routineaktionen in Agenten‑Workflows: statt manuell Musik zu suchen, fragt die Nutzerin per Stimme nach „entspannter Jazz“ und das System schlägt eine Playlist vor, personalisiert anhand vorheriger Präferenzen. Wichtig ist: Personalisierung erfordert Daten. Hier trennt sich die Spreu vom Weizen — wer Personalisierung lokal ermöglicht oder granulare Zustimmungen anbietet, schafft Vertrauen.

Für Unternehmen eröffnen sprachgesteuerte Geräte neue Kontaktpunkte: Kundenservice per Sprach‑Bot, nahtlose Smart‑Home‑Steuerung und kontextbezogene Angebote. Juniper Research erwartet in diesem Umfeld starkes Umsatzwachstum für Conversational‑AI‑Lösungen in den kommenden Jahren; das heißt: Anbieter investieren stärker in Sprachfähigkeiten, weil Nutzerinteraktionen monetarisierbar werden (z. B. Service‑Automatisierung).

Gleichzeitig bleibt die Benutzerführung eine Herausforderung. Screenless‑UIs benötigen auditive oder einfache visuelle Rückmeldungen, damit Nutzerinnen verstehen, was gespeichert wird und wie sie Kontrolle ausüben. Gute Beispiele sind sichtbare Leuchtringe an Speakern für aktives Zuhören und einfache Sprachkommandos zum Löschen der letzten Aufnahme. Solche Konzepte machen Sprachsteuerung verlässlicher und erhöhen die Akzeptanz.

Chancen und Risiken beim Einsatz von Audio-KI

Die Chancen sind offensichtlich: schnellere Bedienung, niedrigere Barrieren für ältere oder eingeschränkte Menschen, neue Dienste in Smart‑Homes und Automobilen. Für Unternehmen entstehen Möglichkeiten zur Automatisierung von Routineanfragen und zur Schaffung neuer, sprachbasierter Services.

Risiken betreffen vor allem Datenschutz, Sicherheit und Wettbewerbsfragen. Sprachdaten können biometrische Merkmale enthalten; die Verarbeitung solcher Daten fällt häufig unter strengere Regeln. Die EU‑Regeln (DSGVO plus AI Act) verlangen transparente Gründe für Speicherung und klare Rechtsgrundlagen für biometrische oder profilierende Verwendungen. Deshalb werden On‑Device‑Ansätze nicht nur technisch, sondern auch rechtlich attraktiver, solange sie dokumentiert und nachvollziehbar sind.

Sicherheitsrisiken gibt es ebenfalls: Ein kompromittiertes Gerät mit lokalen Modellen kann sensible Daten preisgeben. Zudem ist die Qualität lokaler Modelle nicht immer gleich. Anbieter müssen daher hybride Architekturen mit selektivem Cloud‑Fallback und starken Update‑Mechanismen bauen. Auditierbare Protokolle, DPIAs (Datenschutz-Folgenabschätzungen) und regelmäßige Sicherheits‑Reviews helfen, das Risiko zu senken.

Wettbewerbspolitisch besteht die Gefahr von Gatekeeper‑Effekten: Plattformbetreiber, die Betriebssystem, Voice‑Service und Ökosystem kontrollieren, können Marktzugänge prägen. Aus Sicht von Nutzerinnen ist Interoperabilität wichtig; technische Standards wie Matter und offene APIs können Abhängigkeiten verringern und Auswahlfreiheit stärken.

Wohin die Entwicklung gehen könnte

In den kommenden Jahren ist mit einer Zunahme hybrider Architekturen zu rechnen: lokale Hot‑word‑Erkennung und Basis‑ASR auf dem Gerät, ergänzt durch Cloud‑Modelle für komplexe Aufgaben oder personalisierte Antworten. Dieses Muster verbindet die Vorteile von Latenzreduktion und Datenschutz mit der Leistungsfähigkeit großer Modelle.

Technisch werden effizientere Modelle und spezialisierte Edge‑Chips die Fähigkeiten lokaler Verarbeitung erweitern. Regulatorisch dürften EU‑Vorgaben (AI Act, EDPB‑Guidelines) die Anforderungen an Nachweise und Minimierung verschärfen; Hersteller, die früh dokumentierte, datensparsame Lösungen anbieten, gewinnen Vertrauensvorteil.

Für Nutzerinnen bedeutet das konkret: mehr Geräte, die Stimmen verstehen, aber auch klarere Kontrollmechanismen. Die Interaktion wird natürlicher, wenn Geräte Kontext berücksichtigen (z. B. ob mehrere Personen sprechen) und wenn einfache Kommandos zur Datenverwaltung verfügbar sind. Für Entwickler heißt das: Fokus auf Privacy‑by‑Design, erklärbare Sprachverarbeitung und robuste Update‑Pipelines.

Marktseitig erwarten Analysten weiteres Wachstum im Bereich Conversational AI und mehr automatisierte Interaktionen in Unternehmen. Zugleich bleibt die Messung herausfordernd: Shipments (z. B. rund 87,4 Millionen Smart‑Speaker‑Einheiten 2024) sind nur ein Indikator; aktive Nutzung und qualitative Akzeptanz sind mindestens genauso wichtig.

Fazit

Sprachsteuerung ist 2026 kein optionales Gimmick mehr, sondern eine praktikable Schnittstelle, die durch technische Verbesserungen und regulatorischen Druck an Bedeutung gewinnt. On‑device‑Verarbeitung und hybride Architekturen reduzieren Latenz und bieten Datenschutzvorteile, während Cloud‑Modelle komplexere Aufgaben übernehmen. Nutzerinnen profitieren von schnelleren, natürlicheren Interaktionen; Hersteller müssen dafür sorgsames Datenmanagement, Transparenz und Interoperabilität liefern. Am Ende entscheiden Qualität, Vertrauen und einfache Kontrolle darüber, wie weit Stimme die bevorzugte Bedienform wird.

Diskutiere gerne mit: Welche Erfahrungen hast du mit sprachgesteuerten Geräten? Teile diesen Artikel, wenn er hilfreich war.

Schreibe einen Kommentar