Schlagwort: Deep Learning

-

Video-KI „Frag dein Video“: Inhalte in Clips schneller finden

Zuletzt aktualisiert: 01. February 2026 Berlin, 01. February 2026 Auf einen Blick Video-KI verschiebt das Finden in Clips von Stichwörtern zu Fragen in normaler Sprache.

Batteriesicherheit: Kann KI Akku-Brände Tage vorher erkennen?

Akku-Brände wirken oft wie ein plötzliches Ereignis, doch im Hintergrund laufen messbare Prozesse ab: Temperatur steigt lokal, Zellen gasen aus, und in geschlossenen Gehäusen kann

Moonshot AI veröffentlicht Kimi K2.5: Warum das KI-Modell auffällt

Zuletzt aktualisiert: 27. January 2026 Berlin, 27. January 2026 Auf einen Blick Mit Kimi K2.5 sorgt ein neues KI-Modell von Moonshot AI für Aufmerksamkeit: Es

KI-Batteriedesign: Wie Algorithmen Akkus schneller und günstiger machen

Neue Akkus zu entwickeln dauert oft Jahre, obwohl der Bedarf längst da ist. Genau an dieser Stelle setzt KI-Batteriedesign an. Gemeint ist der Einsatz von

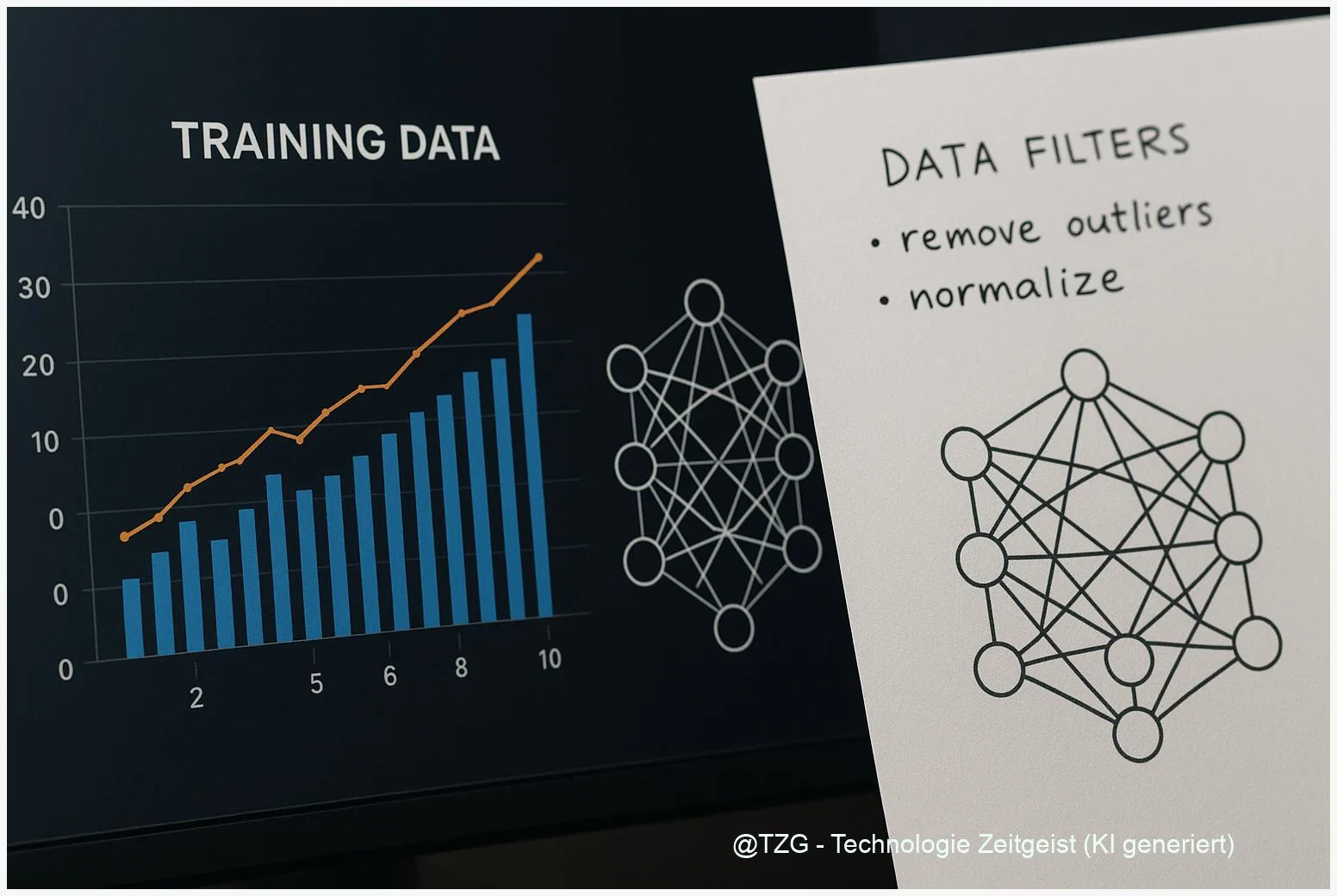

Datenqualität in KI-Apps: Warum saubere Infos jetzt zum Erfolgsfaktor werden

Eine KI-App wirkt oft beeindruckend, bis sie im falschen Moment Unsinn schreibt, wichtige Details auslässt oder Dinge behauptet, die nie passiert sind. In vielen Fällen

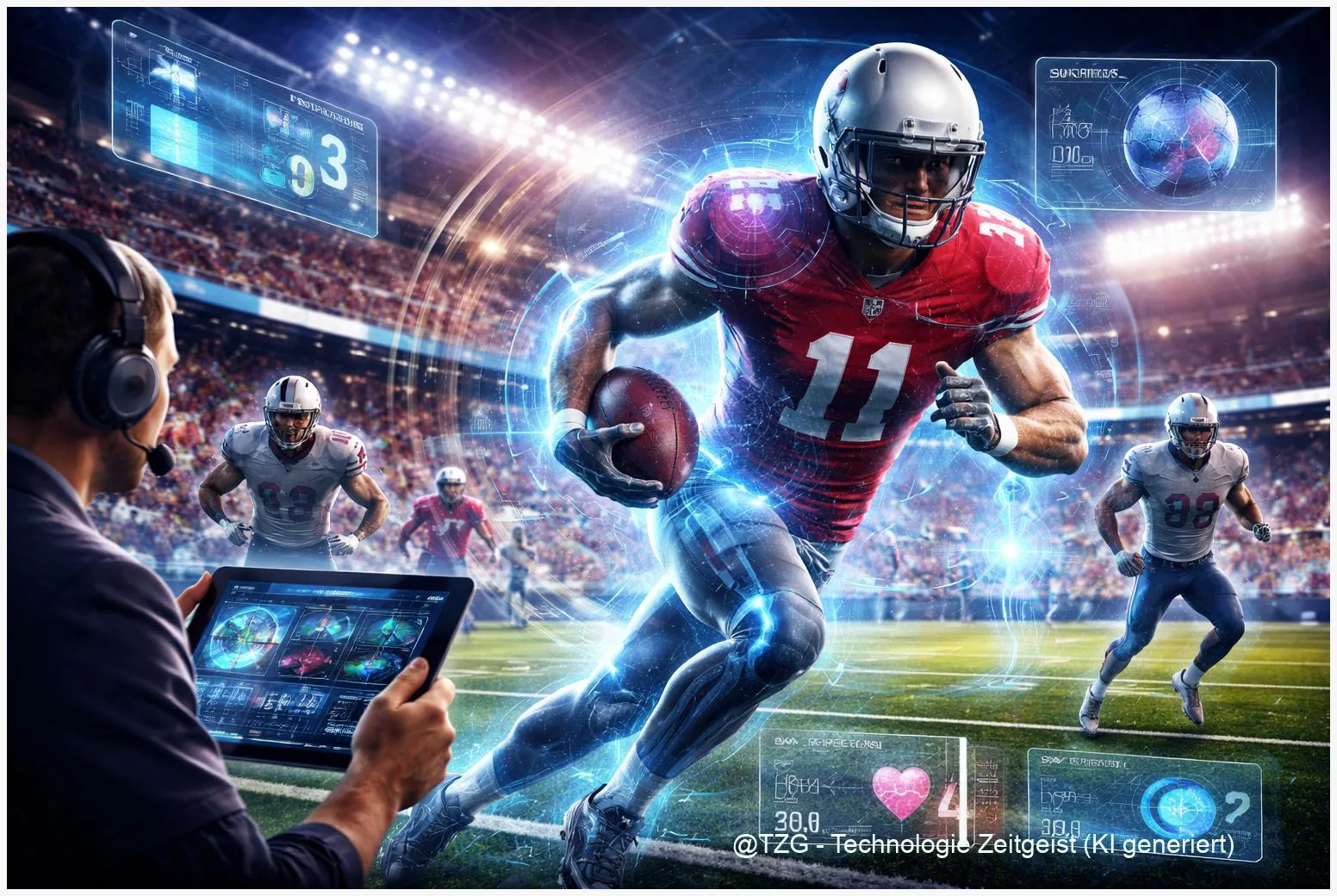

Wie KI die NFL verändert: Tracking, Gesundheit, Entscheidungen

Zuletzt aktualisiert: 2026-01-10 Kurzfassung KI in der NFL nutzt Positions‑Tracking, Datenanalyse und ML‑Modelle, um Spielzüge zu visualisieren, Ausfallrisiken einzuschätzen und Broadcast‑Statistiken zu liefern. Seit Mitte

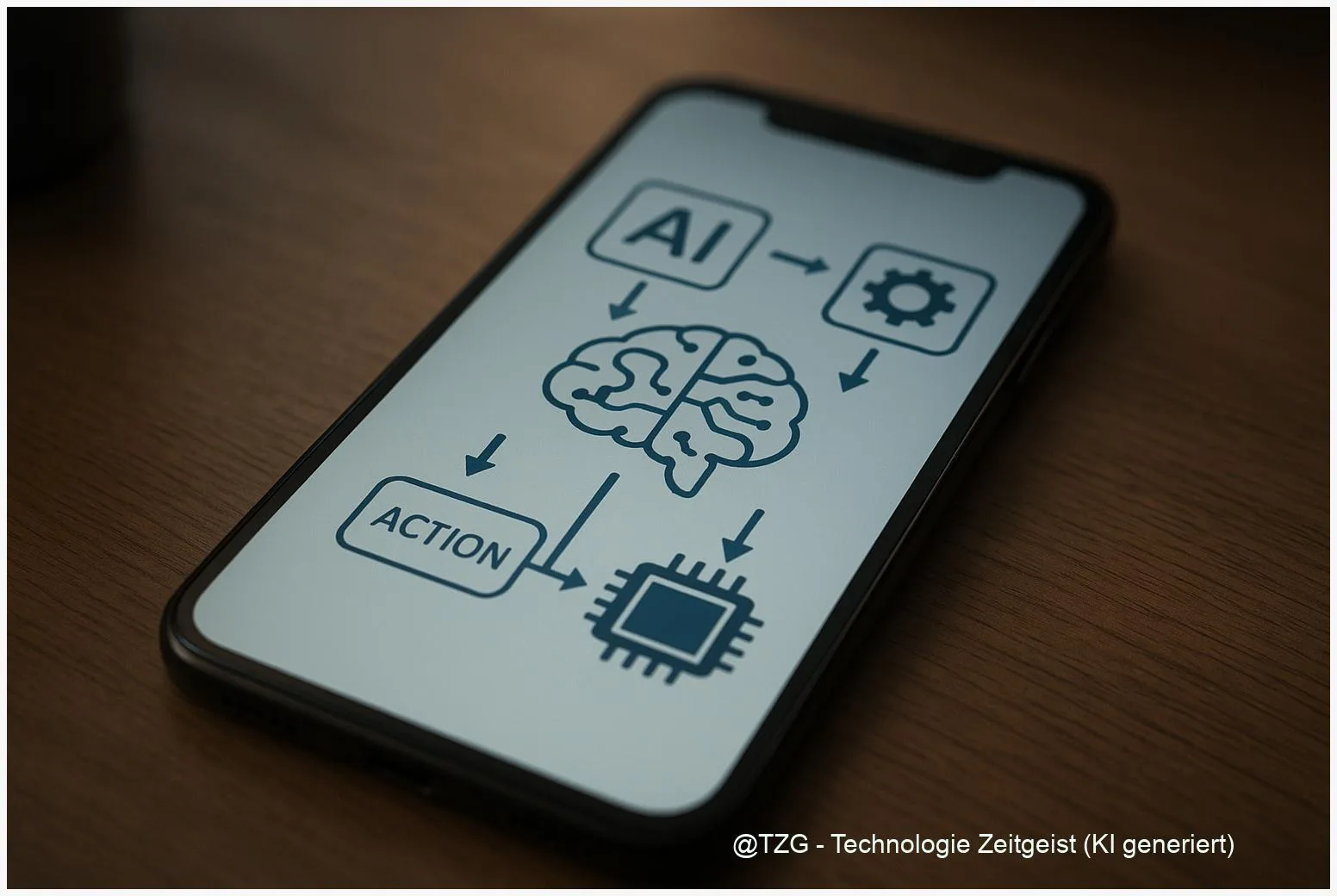

Kleine KI‑Modelle: Reinforcement Learning macht On‑Device‑KI zuverlässiger

Kleine Sprachmodelle können direkte Antworten auf dem Smartphone liefern, ohne Daten an Server zu senden. Reinforcement Learning, speziell Reinforcement Learning from Human Feedback (RLHF), hilft,

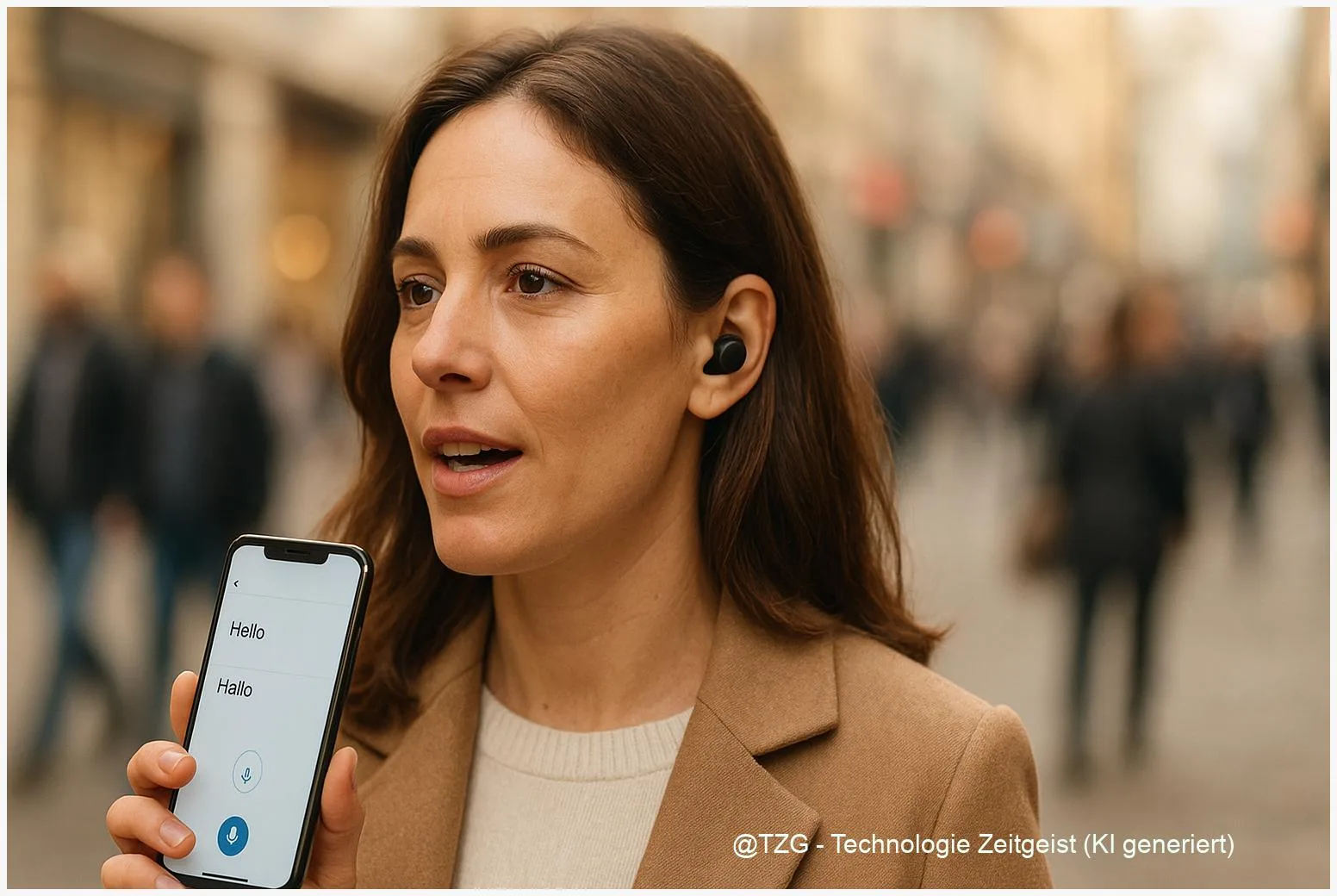

Live‑Übersetzung im Ohr: Wie gut funktionieren In‑Ear‑Translator 2025?

Zuletzt aktualisiert: 26. December 2025 Berlin, 26. December 2025 Insights Live‑Übersetzung im Ohr (In‑Ear‑Translator) funktioniert 2025 in vielen Alltagsszenen brauchbar, liefert aber je nach Gerät

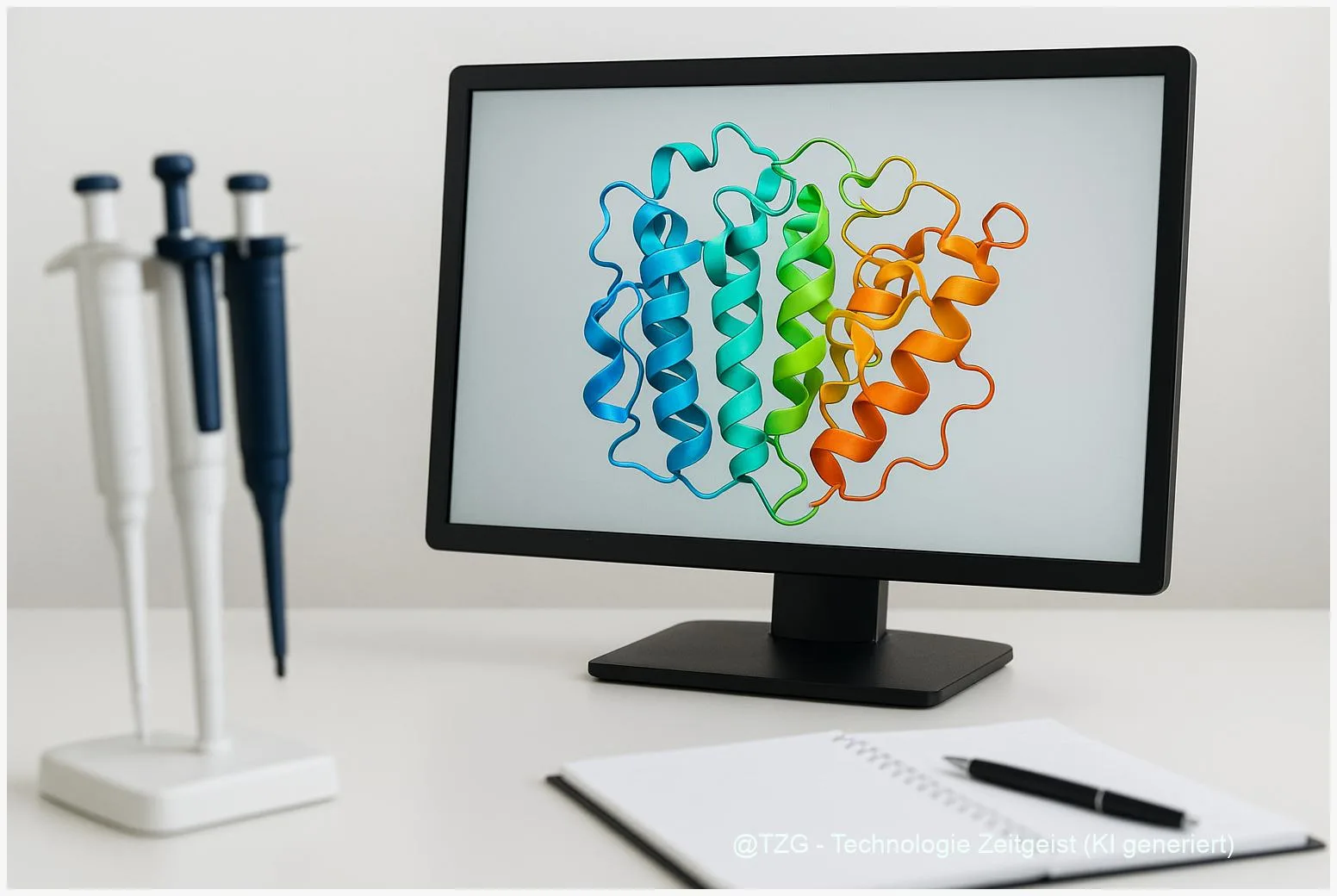

AlphaFold erklärt: Wie KI Proteine faltet – und warum das wichtig ist

AlphaFold hat die Vorhersage von Proteinstrukturen deutlich vorangebracht und heißt deshalb oft AlphaFold. Die Technologie nutzt tiefe Lernverfahren, um aus einer Aminosäurefolge eine räumliche Struktur

Wie Machine Learning historische Karten den Landnutzungswandel sichtbar macht

Historical maps enthalten wertvolle Informationen über Landschaften, die heute oft verschwunden sind. maschinelles lernen historische karten macht diese Informationen systematisch zugänglich: Modelle erkennen Felder, Wälder,

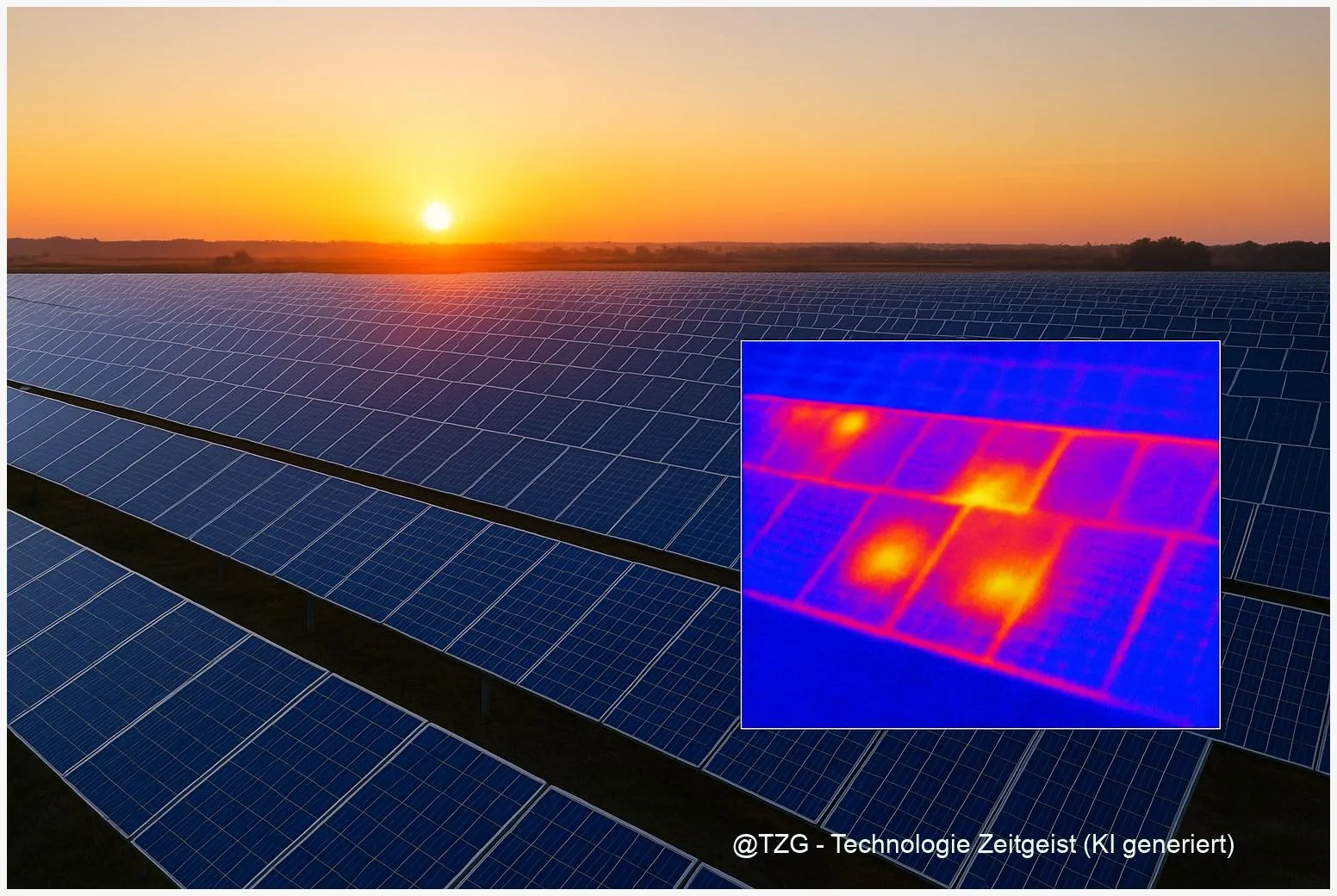

KI für Solaranlagen: Wie Machine Learning versteckte Moduldefekte erkennt

Moderne Systeme auf Basis von KI Solaranlagen nutzen Machine Learning, um Defekte zu erkennen, bevor sie sichtbar werden. Das reduziert Ertragsverluste und Wartungskosten, weil versteckte

KI-Bildgeneratoren werden realistischer — warum Erkennung schwieriger wird

KI-Bildgeneratoren erreichen in den letzten Jahren ein deutlich höheres Niveau an Foto‑Realismus. Modelle erzeugen Hautstrukturen, Lichtreflexe und Details, die früher sofort auffielen. Das erschwert das

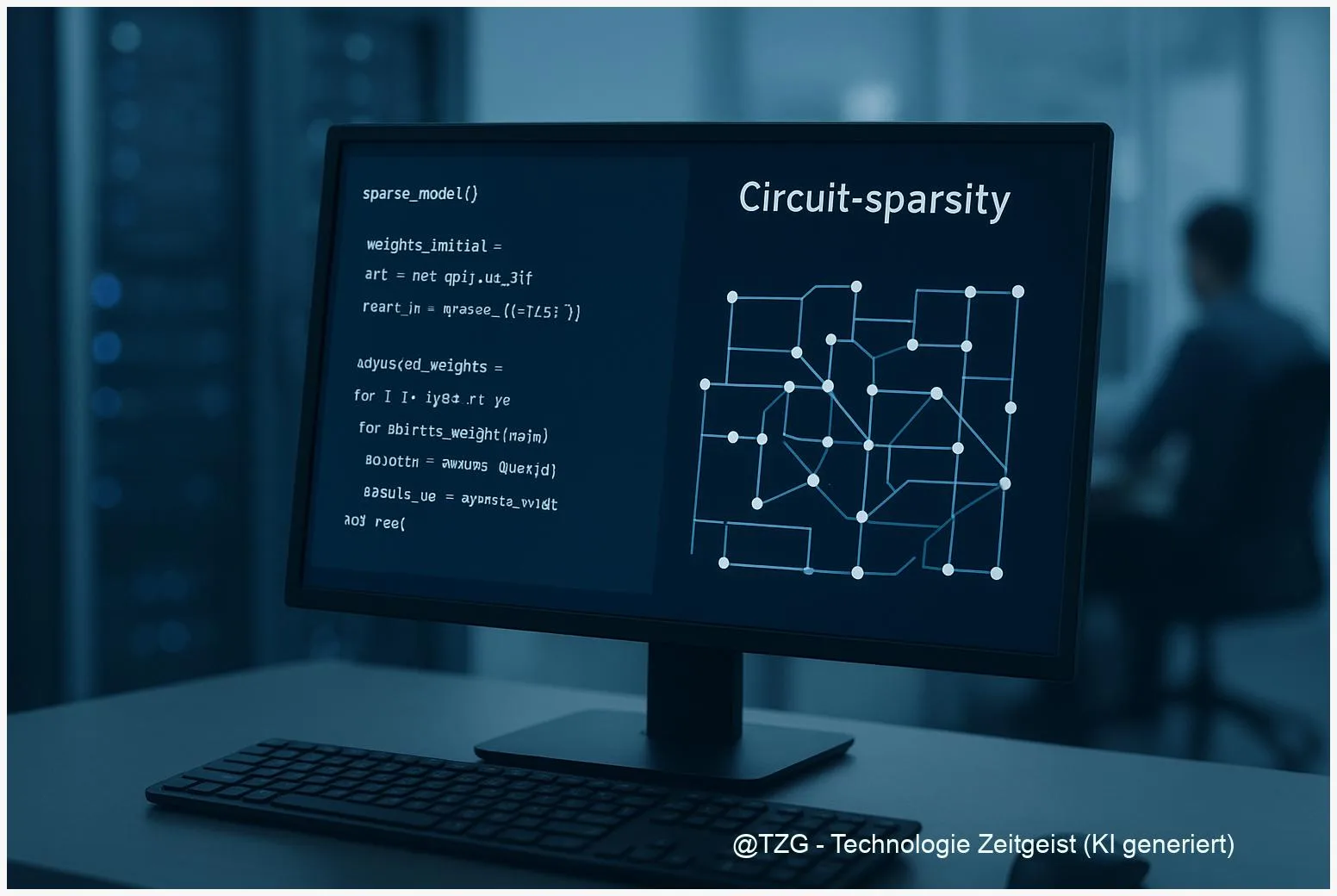

Circuit‑sparsity: Wie sparsames Training KI‑Modelle erklärbarer macht

Zuletzt aktualisiert: 14. December 2025 Berlin, 14. December 2025 Insights Circuit‑sparsity beschreibt ein Trainingsprinzip, bei dem ein Modell so viele Gewichte wie möglich auf null

Wenn KI Sprache so gut wie ein Mensch analysiert — was das bedeutet

KI Sprachverarbeitung steht heute an einem Punkt, an dem Maschinen Texte sehr menschlich erscheinen lassen können. Dieser Text zeigt, welche Fähigkeiten solche Systeme wirklich haben,

Kleine LLMs, große Leistung: Wie Daten‑Rezepte 3B‑Modelle stärken

Modelle mit nur wenigen Milliarden Parametern können überraschend viel leisten, wenn die Trainingsdaten stimmen. Dieses Stück zeigt, wie datenzentrierte Trainingsrezepte kleine Sprachmodelle konkret stärken und