Überwachung von Tiefsee-Bergbau ist kein einzelnes Messinstrument, sondern ein System aus Satellitendaten, Schiffstracking und Unterwasser-Sensoren. Dieses Stück erklärt, welche Technik heute möglich ist, welche Lücken bleiben und warum Daten aus Monitoringprojekten wie dem Patania-II‑Test für die Debatte wichtig sind. Die Übersicht zeigt Praxisbeispiele, Kostenabschätzungen und die wichtigsten Unsicherheiten bei der Tiefsee-Bergbau Überwachung.

Einleitung

Ob in Diskussionen um Batterien oder in Umweltrunden: Tiefsee‑Bergbau steht inzwischen regelmäßig auf der Agenda. Wer verantwortungsvoll entscheiden will, fragt zuerst, wie sich Eingriffe messen, überwachen und nachverfolgen lassen. Auf See laufen viele Prozesse gleichzeitig: Schiffe auf der Oberfläche, Fördergeräte auf dem Meeresboden, Sedimentwolken in der Wassersäule. Die Herausforderung ist, aus diesem heterogenen Datenmix verlässliche Hinweise zu gewinnen. Praktische Beispiele aus jüngsten Feldtests und neue Portale zur Schiffsüberwachung zeigen, was heute technisch möglich ist — und wo die Erkenntnislücken bleiben.

Wie funktioniert die Überwachung von Tiefsee‑Bergbau?

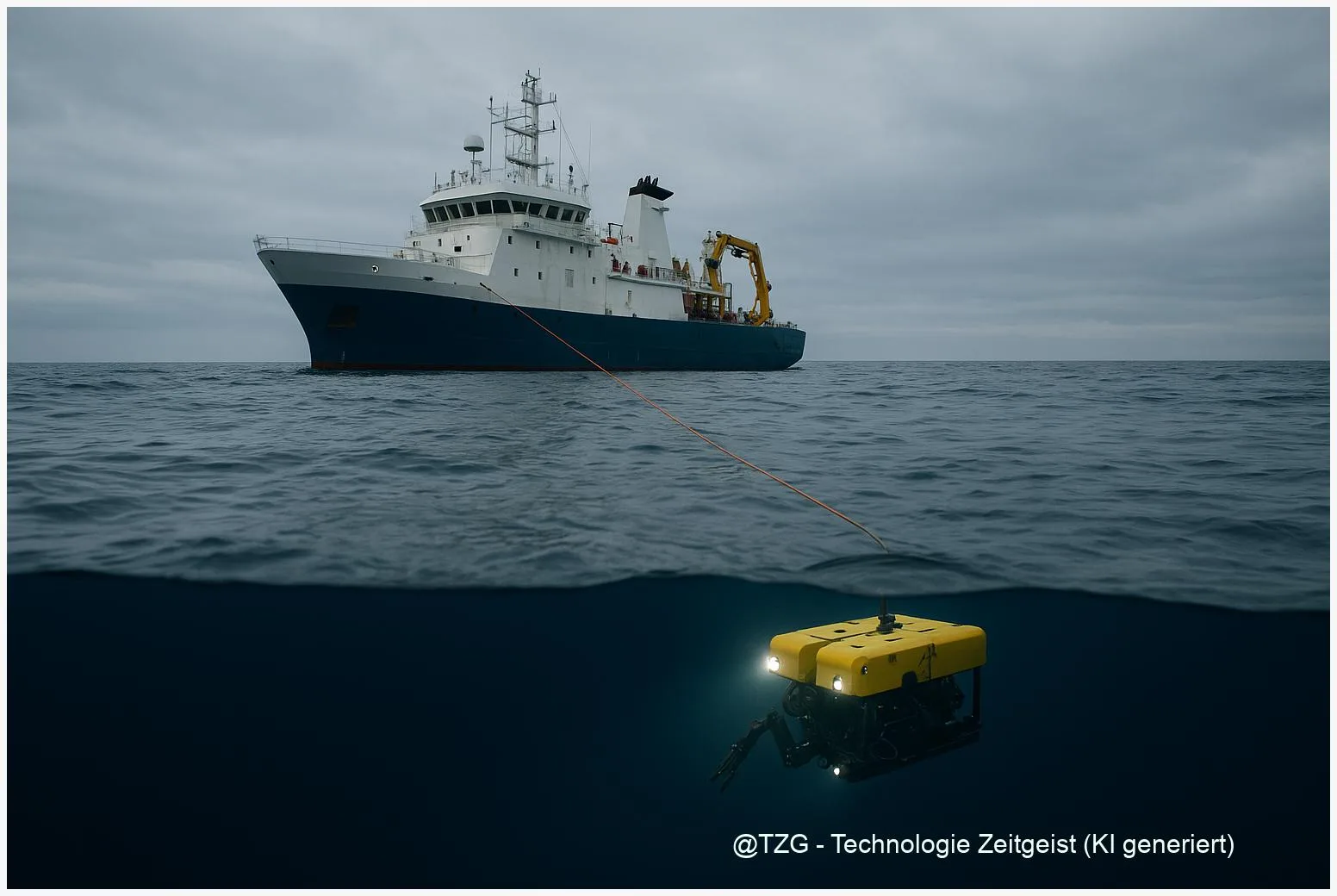

Monitoring vereint mehrere Ebenen: Satelliten und Funkdienste verfolgen Schiffe, autonome Fahrzeuge und ROVs liefern Bilder und Proben vom Meeresboden, Moorings und Landers messen Strömung und Trübung in der Wassersäule. An Land werden diese Daten zusammengeführt, validiert und modelliert, etwa um das Ausbreitungsverhalten von Sedimentplumes zu berechnen.

Überwachung ist ein Puzzle: Keines der Systeme reicht allein, erst die Kombination ergibt ein brauchbares Bild.

Techniken im Überblick:

| Merkmal | Beschreibung | Wert / Bemerkung |

|---|---|---|

| Satelliten & AIS | Positionsdaten von Schiffen, SAR-Bilder für Oberflächenphänomene | Deckung von Erkundungsschiffen, >40 Schiffe beobachtbar |

| ROV / AUV | Visuelle Inspektion, Probenahme, Sensoren für Trübung und Chemie | Direkte Befunde auf dem Meeresboden |

| Moorings / Lander | Langzeitmessungen von Strömung, Partikeldichte, Akustik | Stabile Zeitreihen über Monate bis Jahre |

Die Internationale Meeresboden‑Behörde (ISA) hat in einer technischen Studie (2022) verschiedene Kombinationen untersucht und wie Datenintegrität sichergestellt werden kann. Diese Studie stammt aus dem Jahr 2022 und ist damit älter als zwei Jahre; ihre Kosten- und Technikschätzungen sind dennoch eine nützliche Orientierung für heutige Planungen.

Praktische Überwachung: von Schiffen bis zu Sedimentplumes

Ein konkretes Beispiel verändert die Diskussion oft schneller als theoretische Modelle: In diesem Jahr wurde öffentlich, dass neue Online‑Portale Meeresbeobachtung und Schiffsbewegungen zusammenbringen. Solche Werkzeuge zeigen auf einen Blick, wo Erkundungsschiffe unterwegs sind und wie ihre Routen zu Schutzgebieten oder Fischereizonen stehen. Die Sichtbarkeit auf der Oberfläche hilft, Aktivitäten zu dokumentieren, sagt aber noch nichts über Plumes oder Lebensgemeinschaften am Meeresboden.

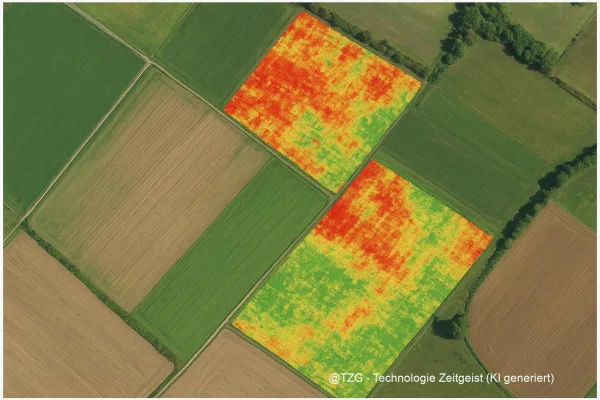

Feldtests liefern die andere Hälfte der Information. Beim sogenannten Patania‑II‑Test im Pazifik deckten Forscherinnen und Forscher direkte Effekte auf den Meeresboden auf: In bearbeiteten Fahrspuren sank die Zahl der Tiere um rund 37 % und der Artenreichtum um 32 %. Solche Messungen entstehen durch kombinierte Einsätze von ROVs, Sedimentproben und Lander‑Sensoren, die Trübung (turbidity), Stromprofile (ADCP) und Partikelkonzentration aufzeichnen.

In der Praxis entsteht aus diesen Messpunkten ein Monitoring‑Workflow: Oberflächen‑Tracking identifiziert Verdachtsfälle, ROV‑Einsätze überprüfen den Meeresboden, und Moorings halten Langzeitdaten bereit, die Modelle zur Ausbreitung von Plumes füttern. Nur wenn diese Ebenen zusammenwirken, lassen sich Aussagen zur lokalen Belastung und möglichen Fernwirkung treffen.

Chancen und Risiken der Datenerhebung

Die Kombination aus Satelliten, Schiffs‑Trackern und Unterwasser‑Sensorik erhöht Transparenz und Nachvollziehbarkeit. Neue Portale erlauben zivilgesellschaftlichen Gruppen, Aktivitäten zu recherchieren und Behörden mit Daten zu konfrontieren. Gleichzeitig bleiben Unsicherheiten, die Entscheidungen erschweren.

Eines der grundsätzlichen Probleme ist die natürliche Variabilität: Tiefe Ozeansysteme schwanken über Jahres‑ und Dekadenzyklen, sodass kurzfristige Veränderungen schwer von langfristigen Trends zu trennen sind. Hinzu kommt technische Unsicherheit: Sensoren wie Optische Backscatter‑Detektoren (OBS) müssen kalibriert werden, und Modelle zur Plumausbreitung reagieren empfindlich auf lokale Strömungsdaten.

Politisch ist die Frage, wer Daten liefert und wer sie überprüft. Die ISA schlägt vor, dass Vertragsparteien und Betreiber „Black‑Boxes” für Positions‑ und Produktionsdaten betreiben, während Satelliten‑Spotchecks externe Kontrolle liefern. Solche Vorschläge enthalten Kostenschätzungen: Für die ISA‑Überprüfung wurden in der Studie Werte um rund 99,000 USD pro Projekt und Jahr genannt; das ist eine Orientierung, keine feste Vorgabe.

Hinzu kommt: Feldtests zeigen, dass Eingriffe sehr langlebige Spuren hinterlassen können. Ältere Untersuchungen machten deutlich, dass Spuren von 1970er‑Tests noch Jahrzehnte später sichtbar sind; der Langzeiteffekt auf nodule‑gebundene Arten kann über Jahrzehnte anhalten.

Blick nach vorn: Technik, Politik und Handlungsspielräume

Die Technik für bessere Überwachung entwickelt sich in zwei Richtungen: Bessere Ferndetektion auf der Oberfläche und robustere Unterwassernetzwerke. Satelliten‑AIS‑Daten und SAR liefern schnell Hinweise auf Schiffsbewegungen; offene Portale bündeln diese Informationen für Wissenschaft und Öffentlichkeit. Unterwasser steigen Investitionen in AUV‑Schwärme, die Plumes in hoher räumlicher Auflösung verfolgen könnten.

Auf der regulatorischen Seite besteht die Möglichkeit, Messpflichten zu standardisieren: einheitliche Protokolle für Vor‑und‑Nach‑Proben, definierte Schwellenwerte für Partikelkonzentrationen und verpflichtende Datenfreigabe über sichere Schnittstellen. Solche Vorgaben würden die Vergleichbarkeit verbessern und unabhängige Prüfungen erleichtern.

Für Bürgerinnen und Bürger bedeutet das konkret: Portale zur Schiffsüberwachung ermöglichen eine frühe Transparenz, wissenschaftliche Langzeitmessungen liefern belastbare Trends. Beide zusammen könnten dazu führen, dass Entscheidungen auf nachprüfbaren Daten beruhen — vorausgesetzt, Standards und Kontrollmechanismen werden verbindlich.

Fazit

Überwachung von Tiefsee‑Bergbau ist eine Praxis aus vielen Schritten: Satelliten zeigen Aktivitäten an der Oberfläche, ROVs und Lander geben Einblick in den Meeresboden, und Modelle verbinden Messdaten zu belastbaren Szenarien. Jüngste Feldtests belegen, dass Eingriffe messbare Auswirkungen hinterlassen können; andere Studien und technische Untersuchungen zeigen Wege, diese Effekte zu überwachen und zu bewerten. Entscheidend ist weniger ein einzelnes Instrument als die Kombination aus Transparenz, standardisierten Messmethoden und unabhängiger Kontrolle. Nur so lassen sich Risiken abschätzen und politisch verantwortbare Entscheidungen fällen.

Schreibe einen Kommentar