KI‑Rechenzentren sind heute ein zentraler Treiber für Nachfrage nach Strom, Kühlung und Infrastruktur. Dieses Abstract fasst zusammen, warum der Bau und Betrieb solcher Anlagen hohe Milliardenkosten verursacht, welche Größenordnungen beim Energie‑ und Wasserverbrauch relevant sind und welche Unsicherheiten Studien beschreiben. Die Analyse stützt sich auf aktuelle Berichte von IEA (2025), LBNL (2024) und Branchenstudien und nennt Zahlen zur globalen Rechenzentrums‑Last, typischen Baukosten und Wasserintensität.

Einleitung

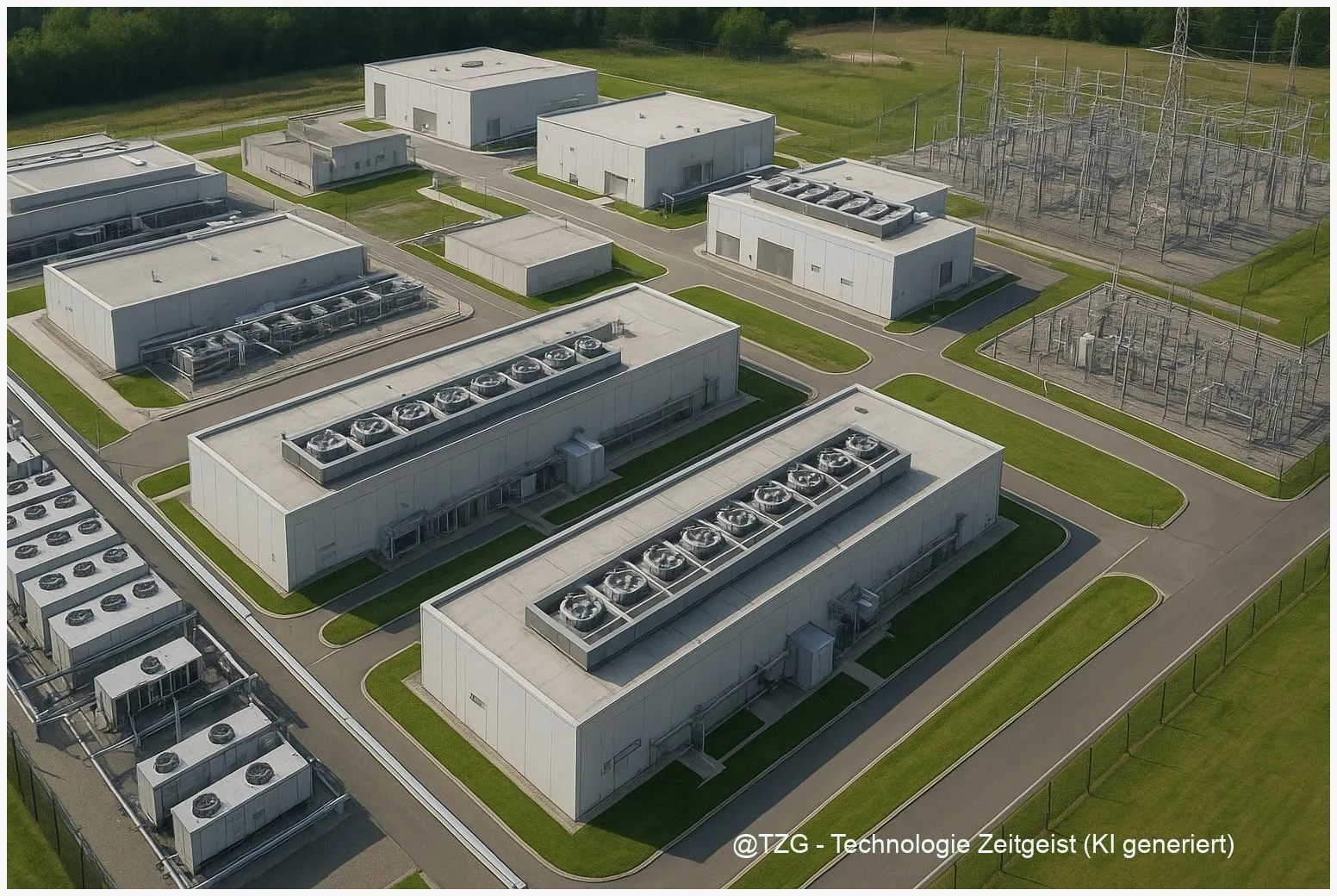

Wenn große Modelle trainiert oder ständig genutzte KI‑Dienste Anfragen beantworten, bleibt das nicht ohne Folgen für Strom- und Wassernetze. KI‑Rechenzentren enthalten spezialisierte Server und GPUs, die deutlich mehr Leistung pro Rack verlangen als klassische Web‑ oder Office‑Server. Das erhöht die Anforderungen an Stromanschluss, Kühlung und Bautiefe – und treibt so die Kosten in Milliardenhöhe. Zahlreiche Studien zeigen: Rechenzentrumsenergie ist aktuell ein einstelliger Prozentanteil des weltweiten Stromverbrauchs, doch die Geschwindigkeit des Wachstums und die Konzentration großer Standorte können lokale Netzbelastungen erzeugen. Die folgenden Kapitel erklären, welche Komponenten teuer sind, wie Energie und Wasser eingesetzt werden und welche Gestaltungsspielräume existieren.

Wie funktionieren KI‑Rechenzentren?

KI‑Rechenzentren unterscheiden sich in einigen zentralen Punkten von traditionellen Rechenzentren. Entscheidend sind drei Dimensionen: die IT‑Dichte (kW pro Rack), die elektrische Infrastruktur (Transformatoren, Unterstationen, Redundanz) und die Kühltechnik. Große Trainingsläufe laufen oft auf GPU‑Clustersystemen, die pro Rack mehrere zehn Kilowatt verbrauchen. Diese Dichte erfordert nicht nur leistungsfähigere Stromverteilungen, sondern auch flüssigkeitsbasierte oder hochleistungsfähige Luftkühlungen, weil klassische Klimaanlagen an ihre Grenzen stoßen.

Höhere IT‑Dichte bedeutet: mehr Leistung pro Quadratmeter, stärkere Kühlung und teurere Stromanschlüsse.

Einfach gesagt: je mehr Leistung in einem Rack steckt, desto teurer wird die gesamte Infrastruktur um dieses Rack herum. Das schlägt sich in Bau- und Anschlusskosten nieder. Marktstudien geben eine grobe Orientierung: typische Bau‑ und Infrastrukturkosten liegen im Bereich von etwa 9–15 Mio. USD pro MW kritischer Last, abhängig von Region, Dichte und Netzanforderungen.

Die folgende Tabelle zeigt drei Kernkennzahlen zur Einordnung.

| Merkmal | Beschreibung | Beispielwert |

|---|---|---|

| Globaler DC‑Stromverbrauch (Schätzung) | Betrieb/ohne Krypto, konsolidierte Schätzungen | ~300–380 TWh (2023) |

| US‑Rechenzentren | Nationaler Bericht mit detaillierten Messungen | ~178 TWh (2023, LBNL) |

| Baukosten | Infrastruktur pro MW kritischer Last | ~9–15 Mio. USD/MW |

Wie KI‑Lasten den Alltag und die Netze beeinflussen

Im Alltag merkt man die KI‑Last kaum direkt — das Smartphone lädt weiter, der Voice‑Assistent antwortet. Im Netz aber können große KI‑Standorte Spitzenlasten erzeugen. Betreiber berichten, dass reine AI‑Workloads oft Spitzenleistungsprofile haben: Trainingsphasen benötigen für Stunden bis Tage sehr viel Leistung; Inferenz (die laufende Beantwortung von Anfragen) ist weniger spitz, kann aber dauerhaft hoch sein, sobald Dienste millionenfach genutzt werden.

Für Stadtwerke und Übertragungsnetzbetreiber sind drei Effekte relevant: Standortkonzentration, 24/7‑Lastprofile und Unsicherheit bei Prognosen. Standortkonzentration bedeutet, dass viele Kapazitäten in wenigen Regionen gebündelt werden — dort kann schnell Engpassgefahr entstehen. 24/7‑Lastprofile zwingen Betreiber, Kapazität vorzuhalten. Prognoseunsicherheit erschwert die Netzplanung; langfristige Projekte wie neue Umspannwerke brauchen Jahre und können Millionen kosten.

Ein weiterer Faktor ist Wasser. Verschiedene Kühlsysteme haben sehr unterschiedliche Wasserintensitäten: offene Kühltürme verbrauchen deutlich mehr Wasser durch Verdunstung, während luftbasierte oder Immersion‑Kühlung das Wasserrisiko erheblich reduzieren. Mehrere Berichte betonen, dass der Wasserverbrauch regional ein kritisches Risiko ist, besonders in wasserarmen Gebieten.

Kurz: Für Netzbetreiber und Kommunen ist nicht allein die Gesamtmenge an Strom relevant, sondern wie, wann und wo dieser Strom gebraucht wird. Das beeinflusst Strompreise, Anschlussbedingungen und Genehmigungsverfahren.

Chancen, Risiken und Spannungsfelder

Der Ausbau von KI‑Rechenzentren bringt Vorteile und erhebliche Herausforderungen zugleich. Chancen liegen in Effizienzgewinnen: spezialisierte Hardware (ASICs, TPUs), Softwareoptimierung und besseres Scheduling können Energiebedarf pro Rechenoperation deutlich senken. Solche Verbesserungen senken Betriebskosten und reduzieren Netzlasten.

Risiken sind strukturell. Ohne transparente, standardisierte Berichte zu Energie‑ und Wasserverbrauch entstehen Unsicherheiten in Politik und Planung. Studien zeigen breite Streuungen in Schätzungen – verschiedene Methodiken liefern sehr unterschiedliche Ergebnisse. Das erschwert belastbare Prognosen für Netzausbau und Klimapolitik.

Ein weiteres Spannungsfeld liegt bei der Kostenverteilung: Netzanschluss, Substation‑Upgrades und Übertragungsleitungen können hohe Zusatzkosten verursachen. Es ist umstritten, wie diese Kosten verteilt werden — zwischen Betreiber, Netzbetreiber und allgemeiner Stromkundschaft. Solche Fragen beeinflussen, ob Projekte in bestimmten Regionen wirtschaftlich realisierbar sind.

Hinzu kommt die Standortwahl: Wasserarme Regionen sollten wasserarme Kühllösungen bevorzugen; Regionen mit hoher Erzeugung aus erneuerbaren Quellen bieten Vorteile für CO₂‑Bilanz und langfristige Stromkosten. Die politische Dimension ist nicht zu unterschätzen: Genehmigungsprozesse, lokale Infrastrukturinvestitionen und regulatorische Vorgaben entscheiden oft über Erfolg oder Verzögerung großer Projekte.

Wohin die Entwicklung führen kann

Mehrere plausible Entwicklungen zeichnen sich ab. Erstens: stärkere Regulierung und mehr Transparenz. Fachorganisationen fordern verbindliche Meldungen zu kWh‑Verbrauch, PUE (Power Usage Effectiveness) und WUE (Water Usage Effectiveness). Solche Standards würden Vergleichbarkeit schaffen und Planbarkeit für Netze erhöhen.

Zweitens: technischer Wandel. Hardwareeffizienz, spezialisierte Beschleuniger und neue Kühlkonzepte (Immersion, direkte Flüssigkühlung) können die Opex senken und zugleich den Wasserverbrauch reduzieren. Diese Optionen erhöhen die Anfangsinvestitionen, bieten aber langfristig Entlastung für Netze und Ressourcen.

Drittens: Marktmechanismen für Flexibilität. Zeitvariable Tarife, PPA‑Modelle (Power Purchase Agreements) mit 24/7‑Ausweisung und Anreize für Lastverschiebung würden Betreiber motivieren, Verbrauch zu glätten. Das reduziert Spitzen und kann Investitionen in neue Übertragungsleitungen verzögern oder vermeiden.

Schließlich: eine differenzierte Standortstrategie. Projekte, die echte lokale Netzkapazität, verfügbare Kühlressourcen und Zugang zu erneuerbaren Erzeugern nachweisen, haben bessere Chancen. Ohne solche Nachweise steigen Kosten und Genehmigungsrisiken. Diese Linien zeichnen mögliche Szenarien, die auch mittelfristig relevant bleiben.

Fazit

KI‑Rechenzentren verursachen hohe Milliardeninvestitionen, weil spezialisierte Hardware, hohe IT‑Dichten, leistungsfähige Stromanschlüsse und anspruchsvolle Kühlung zusammenkommen. Diese Faktoren bestimmen sowohl den Energie‑ als auch den Wasserbedarf. Aktuelle Berichte zeigen, dass Rechenzentrumsenergie zwar noch ein überschaubarer Anteil des globalen Stroms ist, aber das rasche Wachstum, die räumliche Konzentration und die Unsicherheit in Schätzungen lokale Netz- und Wassersysteme stark beanspruchen können. Transparente Standards für Energie‑ und Wasserberichterstattung, gezielte Standortwahl und Investitionen in Effizienz sind zentrale Hebel, um Kosten, Netzwirkungen und Umweltfolgen zu begrenzen.

Schreibe einen Kommentar