Schlagwort: LLM

-

Olmo 3: Was offene 7B/32B‑Modelle für reproduzierbare LLM‑Forschung bedeuten

Zuletzt aktualisiert: 2025-11-21 Kurzfassung Olmo 3 open models stehen für eine seltene Kombination: vollständig offen publizierte Modelle (7B und 32B), ein nachvollziehbares „model flow“ und

Data‑Fabric für agentic AI — Architektur für selbstheilende Systeme

Zuletzt aktualisiert: 2025-11-21 Kurzfassung Ein Data Fabric für agentic AI verbindet Telemetrie, Metadaten und Aktionspfade zu einer einheitlichen Ebene, auf der autonome Agenten Entscheidungen treffen

On‑Prem AI mit leichten LLMs: Wie NTTs tsuzumi 2 Single‑GPU‑Rollouts möglich macht

Zuletzt aktualisiert: 2025-11-20 Kurzfassung Leichte LLMs bieten für regulierte Branchen einen pragmatischen Pfad zu On‑Premise‑KI. NTTs tsuzumi 2 adressiert genau das: eine japanisch‑optimierte Architektur, die laut

Zuverlässiges RAG-Database-Management für Enterprise Search

Zuletzt aktualisiert: 2025-11-20 Kurzfassung Ein praktischer Leitfaden zu RAG database management: Wie Unternehmen Retrieval‑Augmented‑Generation verlässlich betreiben, Quellen sauber nachverfolgen und Vector‑Datenbanken stabil skalieren. Der Text

Grok 4.1: Halluzinationsreduktion und EQ in der Conversational UX

Zuletzt aktualisiert: 2025-11-19 Kurzfassung Grok 4.1 bringt eine neue Balance zwischen Präzision und Einfühlungsvermögen. Dieser Text erklärt, wie Grok 4.1 conversational UX engineering einsetzt, um

Local LLMs für Programmatic: Privatsphäre im Bidstream schützen

Zuletzt aktualisiert: 2025-11-18 Kurzfassung Local LLMs for programmatic ermöglichen, Teile des Bidstreams unmittelbar auf Endgeräten oder Edge‑Knoten zu verarbeiten, um rohe Daten nicht breit freizugeben.

On‑Device LLMs: Roadmap für NPU‑fähige Laptops und Copilot+ PCs

Zuletzt aktualisiert: 2025-11-17 Kurzfassung Diese kurze on-device LLM roadmap erklärt, wie NPU‑fähige Laptops (Copilot+ PCs) Produktstrategien verändern: sie reduziert Latenz, erlaubt lokale Funktionen und verlangt

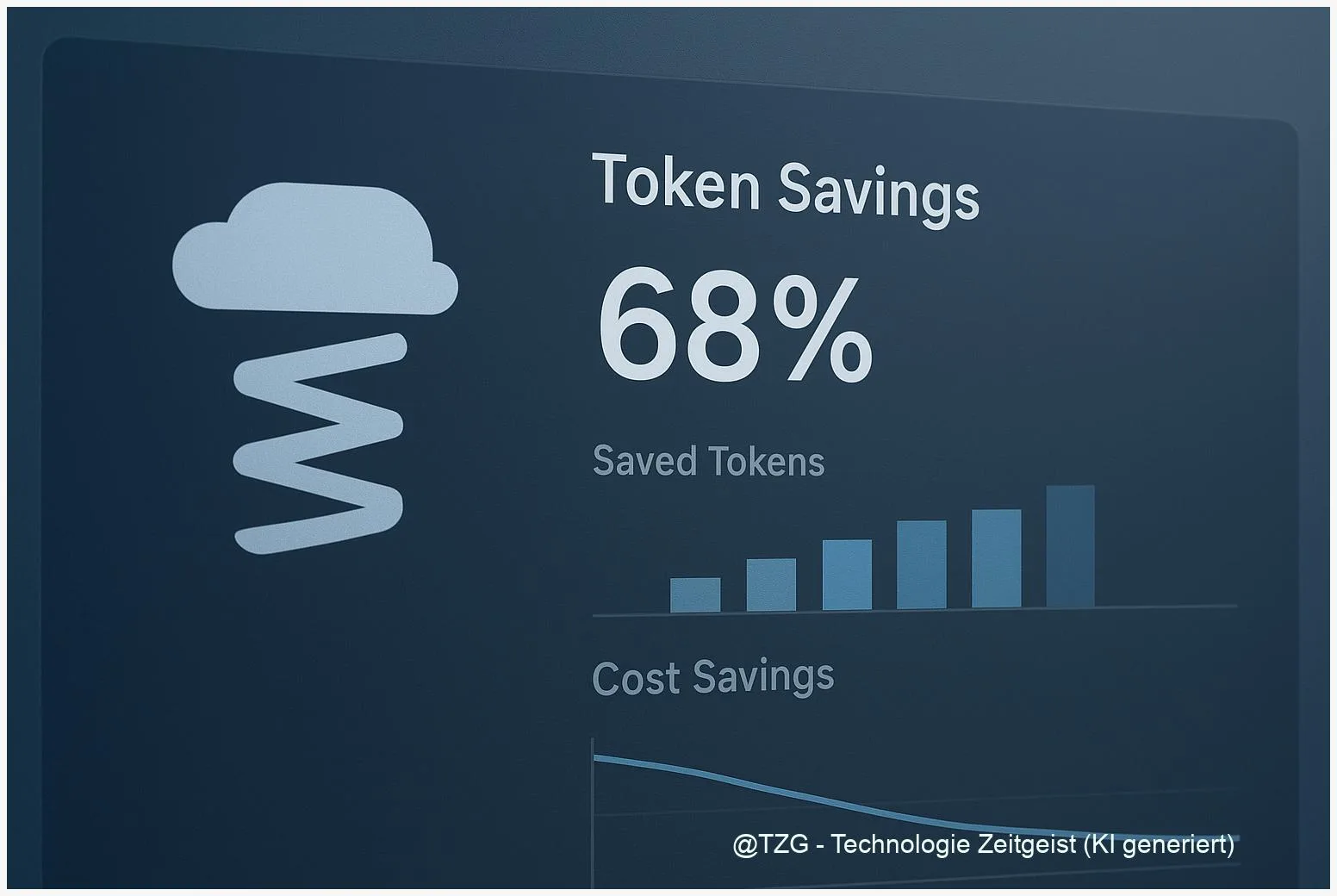

Prompt‑Compression mit LLMLingua: LLM‑API‑Kosten um 5–20× senken

Zuletzt aktualisiert: 2025-11-17 Kurzfassung Prompt compression llmlingua ist eine Technik, mit der lange Prompts verdichtet werden, um LLM‑API‑Kosten und Latenzen deutlich zu reduzieren. Dieser Praxis‑Guide

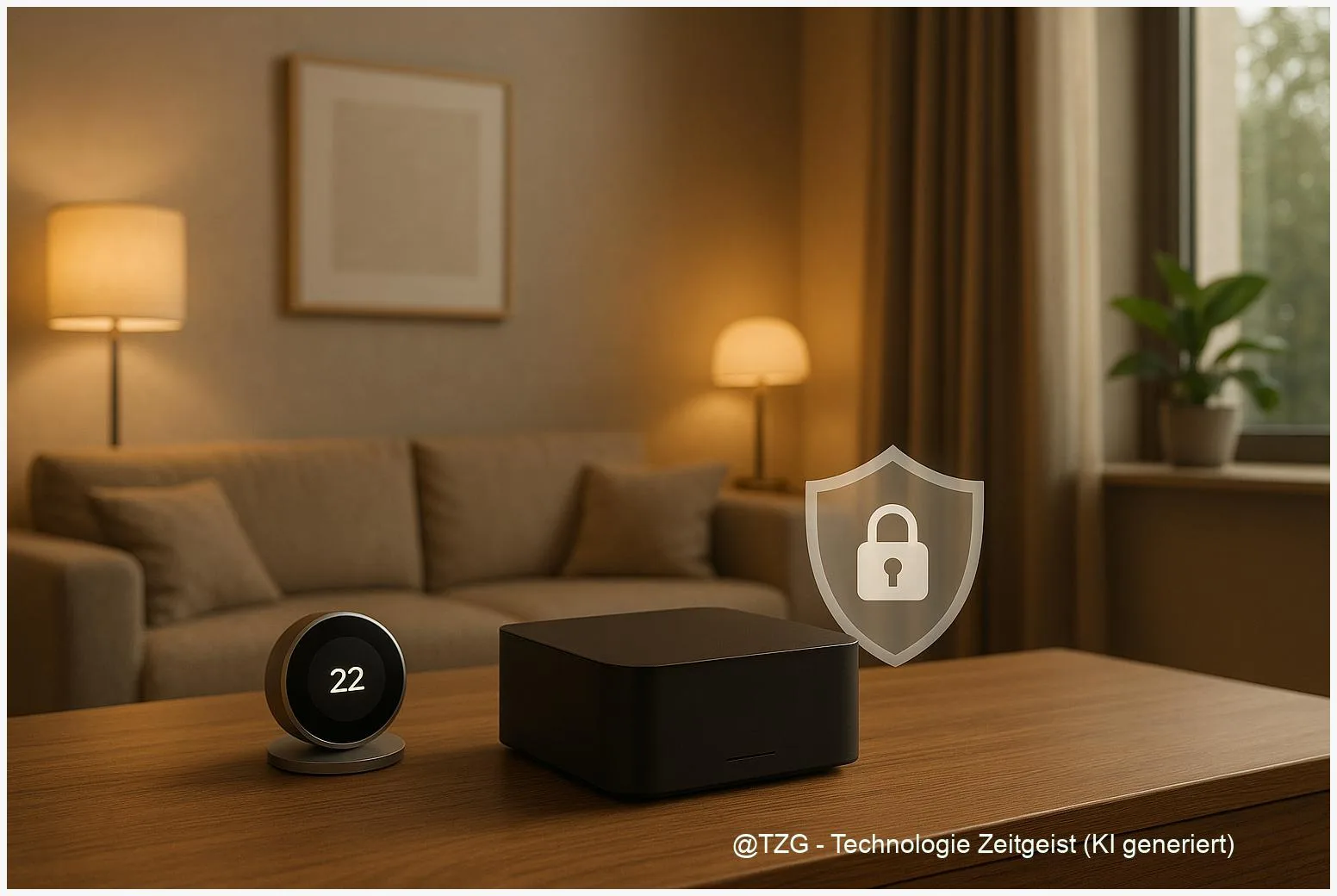

Lokale LLMs im Smart Home: Besser als Alexa 2025

Zuletzt aktualisiert: 2025-11-16 Kurzfassung In einer Zeit, in der Datenschutz im Smart Home zentral wird, überzeugen lokale LLMs durch ihre Fähigkeit, alles vor Ort zu

MiniMax-M2-REAP deployment: Praxisguide für SMoE-Coding-Assistant

Zuletzt aktualisiert: 2025-11-16 Kurzfassung Dieser Praxisguide erklärt, wie ein ressourcenschonendes MiniMax-M2-REAP deployment für Coding‑Assistenten gelingt. Er erklärt die Grundidee der REAP‑Pruning‑Methode, nennt sinnvolle Prüfungen vor

Echtzeit‑Websuche für LLMs: Tavily und LangChain praktisch nutzen

Zuletzt aktualisiert: 2025-11-16 Kurzfassung Dieser Beitrag erklärt, wie Sie Echtzeit‑Websuche für LLMs mit Tavily und LangChain in zuverlässige RAG‑Pipelines überführen. Er zeigt zentrale API‑Bausteine, Integrationstipps,

Offline‑KI in Produktivitäts‑Apps: Privatsphäre, Technik & Praxis

Zuletzt aktualisiert: 2025-11-15 Kurzfassung Dieser Text erklärt, wie man privacy‑first, offline KI in Produktivitäts‑Apps gestaltet, am Beispiel von OmniFocus. Er zeigt Wege für On‑Device‑Inference, Sync‑Optionen

Warum Lasttests bei KI versagen: Token‑Durchsatz, Confusion & Kontext

Zuletzt aktualisiert: 15. November 2025 Kurzfassung Klassische Lasttests messen oft nur Token‑Durchsatz. Wer aber sinnvolle AI‑Performance verstehen will, muss token throughput testing mit Wahrnehmungsmetriken koppeln:

Transparente LLMs: Was OpenAIs Weight‑Sparse Transformer für sichere, prüfbare KI bedeutet

Zuletzt aktualisiert: 14. November 2025 Kurzfassung OpenAI zeigt: Ein weight‑sparse Training kann neuronale Schaltkreise sichtbar machen und so die weight-sparse transformer interpretability erhöhen. Der Ansatz

Clause-Level Governance: Wie LLMs nachweisbar Compliance einhalten

Zuletzt aktualisiert: 13. November 2025 Kurzfassung Clause-level governance for LLMs bringt Compliance auf Satz- und Klausel-Ebene in den Output. Dieser Beitrag erklärt, wie Policy-as-Code, ein