Schlagwort: LLM

-

Gemini 3.1 Pro: 1 Mio. Token – was es kostet und riskiert

Gemini 3.1 Pro bringt ein Kontextfenster von bis zu 1.048.576 Tokens in die Praxis. Das klingt nach “alles auf einmal hochladen” – vom 500‑seitigen Vertrag

KI-Backdoors: Wie Microsoft versteckte „Schläfer“ finden will

Du nutzt KI im Alltag: für E-Mails, Code, Support-Texte oder Automatisierung. Genau dabei wird KI-Sicherheit plötzlich sehr konkret, denn ein Modell kann unauffällig „normal“ wirken

LLMjacking: warum selbst gehostete KI-Server zur Kostenfalle werden

LLMjacking beschreibt Angriffe, bei denen Unbefugte Zugriff auf KI-Server oder Zugangsdaten zu KI-Diensten bekommen und dann auf deine Kosten Modelle abfragen. Das fällt oft erst

Moonshot AI veröffentlicht Kimi K2.5: Warum das KI-Modell auffällt

Zuletzt aktualisiert: 27. January 2026 Berlin, 27. January 2026 Auf einen Blick Mit Kimi K2.5 sorgt ein neues KI-Modell von Moonshot AI für Aufmerksamkeit: Es

GPT-5.2: Was das neue Spitzenmodell bei KI-Assistenz und Kosten ändert

Zuletzt aktualisiert: 27. January 2026 Berlin, 27. January 2026 Auf einen Blick Mit GPT-5.2 steht ein neues Spitzenmodell unter den KI-Modellen bereit. Entscheidend sind weniger

AI as a Service: Warum KI aus der Cloud gerade zum Alltag wird

Zuletzt aktualisiert: 2026-01-24 Kurzfassung AI as a Service heißt: KI aus der Cloud per Klick oder API nutzen – wie Streaming, nur für Text, Bilder

Souveräne KI: Warum immer mehr Firmen Modelle selbst betreiben wollen

Souveräne KI wird für viele Unternehmen zum Prüfstein, weil KI-Modelle plötzlich in Bereiche rutschen, die früher klar getrennt waren. in Kundendialoge, interne Dokumente, Quellcode und

Programmieren mit KI: Wie Vibe Coding Softwareentwicklung neu formt

Programmieren mit KI ist für viele Teams vom Experiment zur Gewohnheit geworden. Dabei taucht immer häufiger ein Begriff auf, der weniger nach Technik klingt als

Datenqualität in KI-Apps: Warum saubere Infos jetzt zum Erfolgsfaktor werden

Eine KI-App wirkt oft beeindruckend, bis sie im falschen Moment Unsinn schreibt, wichtige Details auslässt oder Dinge behauptet, die nie passiert sind. In vielen Fällen

ChatGPT Erdős‑Probleme: Einordnung zu OpenAI‑Claims

Zuletzt aktualisiert: 12. January 2026 Berlin, 12. January 2026 Kurzfassung ChatGPT Erdős‑Probleme tauchen seit OpenAIs Bericht zu GPT‑5 auf: OpenAI dokumentiert AI‑unterstützte Beiträge zu mathematischen

KI als Therapeut: Chancen, Risiken und Regeln für Chatbot‑Gespräche

KI-Therapie gewinnt an Sichtbarkeit: Therapie-Chatbots versprechen niederschwellige Unterstützung bei Angst und Depression, liefern aber nur teilweise belegte Effekte. Dieser Artikel erklärt, wie textbasierte Systeme funktionieren,

KI‑Begriffe 2025 einfach erklärt: RAG, Agenten, Tokens

Wer Begriffe rund um Künstliche Intelligenz schneller einordnen möchte, findet hier klare Antworten: KI-Begriffe einfach erklärt, mit Fokus auf RAG (Retrieval Augmented Generation), KI-Agenten, Tokens

Gemini Live: So nutzt du Sprach‑KI nach dem großen Update im Alltag

Gemini Live bietet eine neue Form der Sprach‑KI: in Echtzeit per Stimme kommunizieren, die Kamera oder der Bildschirm teilen und direkte Aktionen auf dem Smartphone

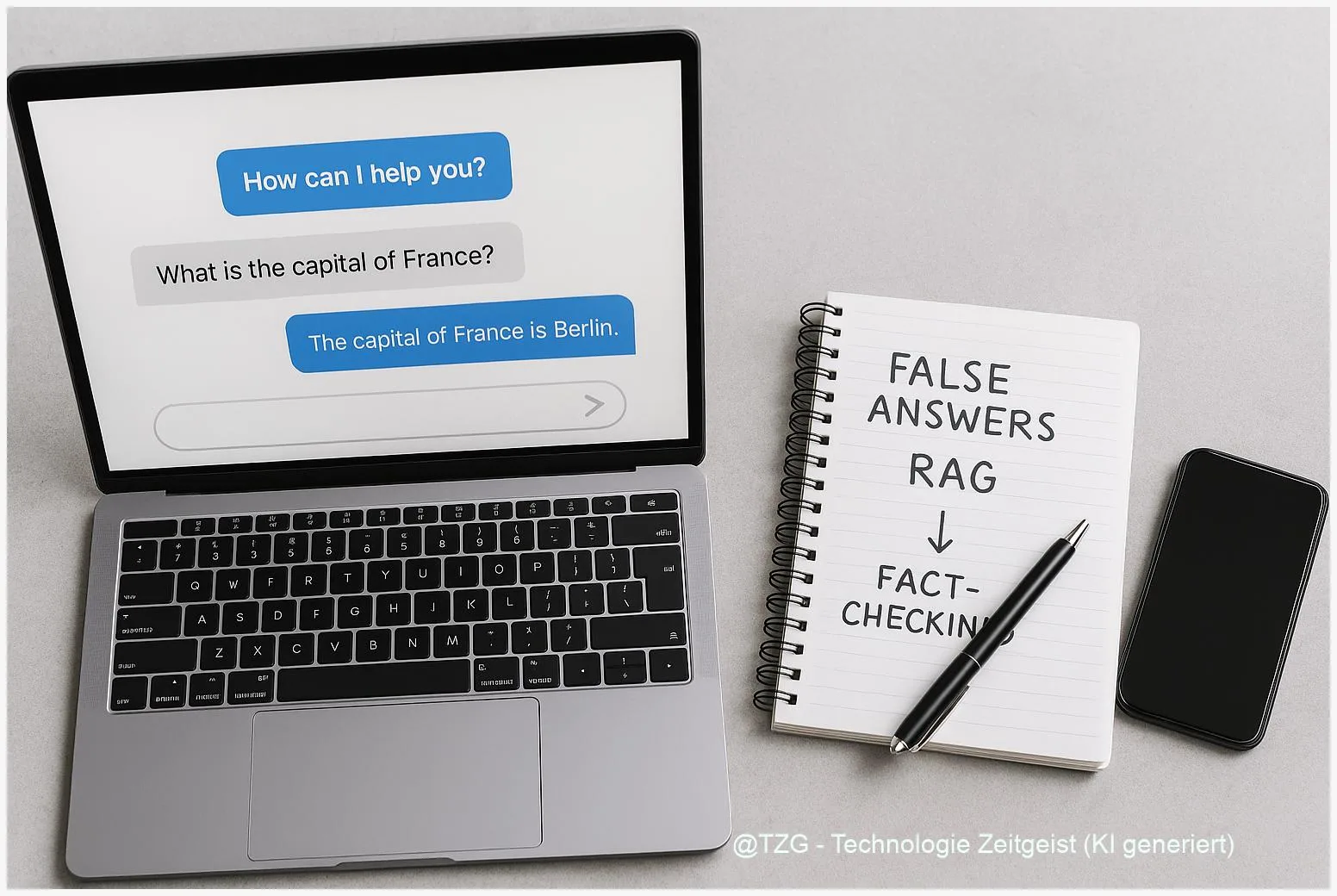

RAG erklärt: Warum KI-Chatbots falsche Antworten geben – und was hilft

RAG steht für Retrieval‑Augmented Generation und kombiniert ein Sprachmodell mit einer externen Wissensdatenbank. In dieser Kurzfassung wird erklärt, warum KI‑Chatbots trotz moderner RAG‑Architekturen falsche oder

Kleine KI-Modelle im Klassenzimmer: Warum sie oft besser passen als große

Kleine, lokal ausführbare KI-Modelle, oft Small Language Models (SLM) genannt, erlauben viele nützliche Funktionen direkt auf Schulgeräten – ohne ständige Verbindung zur Cloud. Das reduziert