Schlagwort: Computing

-

LLMjacking: warum selbst gehostete KI-Server zur Kostenfalle werden

LLMjacking beschreibt Angriffe, bei denen Unbefugte Zugriff auf KI-Server oder Zugangsdaten zu KI-Diensten bekommen und dann auf deine Kosten Modelle abfragen. Das fällt oft erst

Satelliten-Rechenzentren: Warum Server im All realistischer werden

Zuletzt aktualisiert: 01. February 2026 Berlin, 01. February 2026 Auf einen Blick Satelliten-Rechenzentren rücken als Idee wieder in den Fokus: Laut Reuters sucht SpaceX bei

Satelliten‑Rechenzentren: Neue Daten zu Chancen und technischen Hürden

Zuletzt aktualisiert: 01. February 2026 Berlin, 01. February 2026 Auf einen Blick Satelliten-Rechenzentren sollen Rechenleistung in den Erdorbit verlagern, betrieben mit nahezu kontinuierlichem Solarstrom. Neue

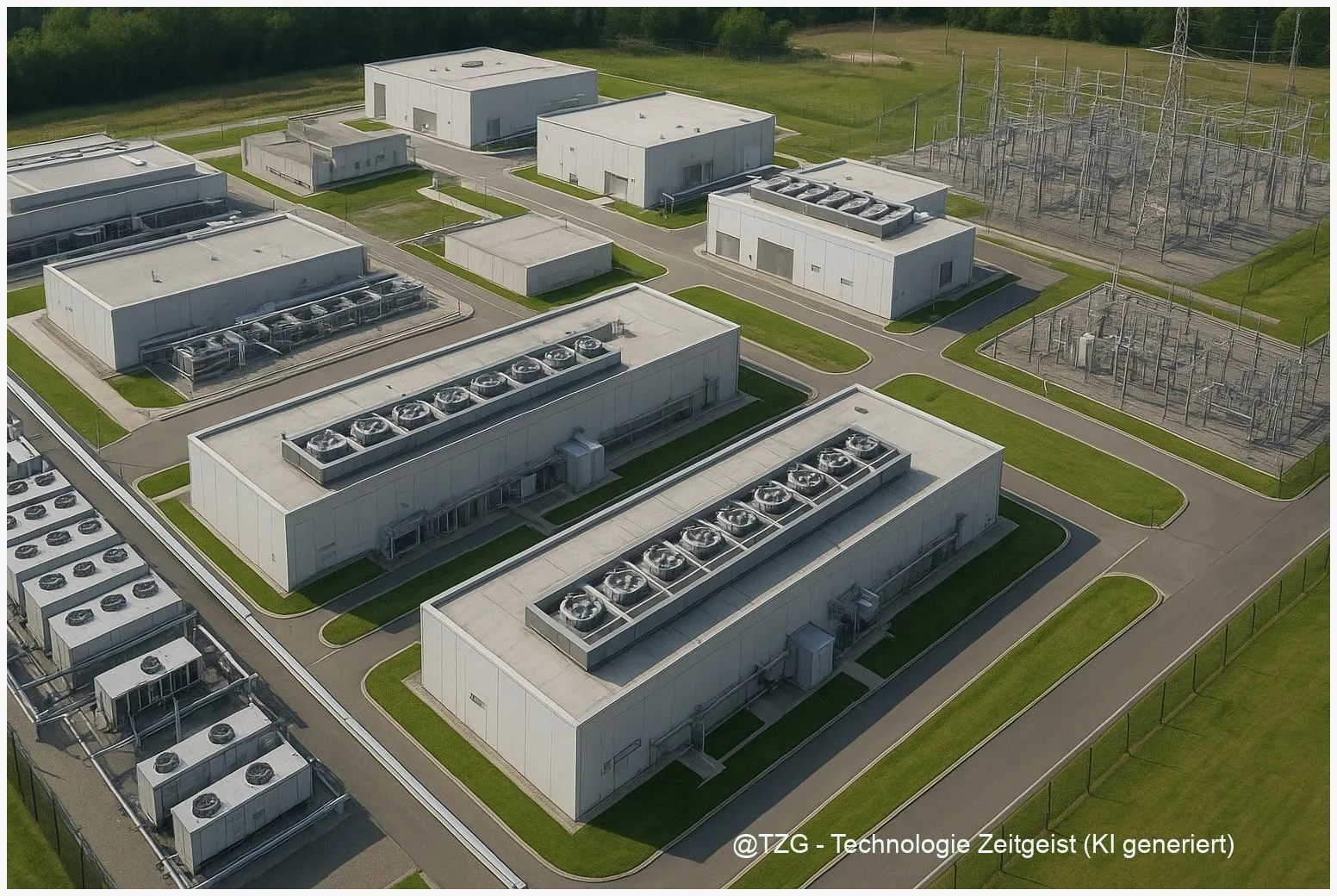

Warum KI‑Rechenzentren Milliarden kosten – und was das für Energie bedeutet

KI‑Rechenzentren sind heute ein zentraler Treiber für Nachfrage nach Strom, Kühlung und Infrastruktur. Dieses Abstract fasst zusammen, warum der Bau und Betrieb solcher Anlagen hohe

Warum ein Mini‑PC kein vollwertiger Desktop‑Ersatz ist

Mini‑PC vs Desktop: Kleine Rechner sparen Platz und Energie, aber nicht immer Leistung oder Aufrüstbarkeit. Viele Mini‑PCs reichen für Office, Streaming und Alltagsarbeit – bei

Warum alte Kraftwerke zu Rechenzentren werden

Alte Industrieflächen werden zunehmend für Rechenzentren genutzt. Rechenzentren in Kraftwerken bieten unmittelbare Vorteile: vorhandene Hochspannungsanschlüsse, Kühlressourcen und große Flächen ermöglichen schnelle, kosteneffiziente Ansiedlungen von Serverfarmen.

Mistral 3 Inferenz: Was steckt hinter der 10×‑Aussage?

Anbieter und Medien nennen für Mistral 3 in Verbindung mit NVIDIAs GB200 NVL72 ungewöhnlich hohe Beschleunigungen — oft als “10×” formuliert. Diese Zahl fällt in

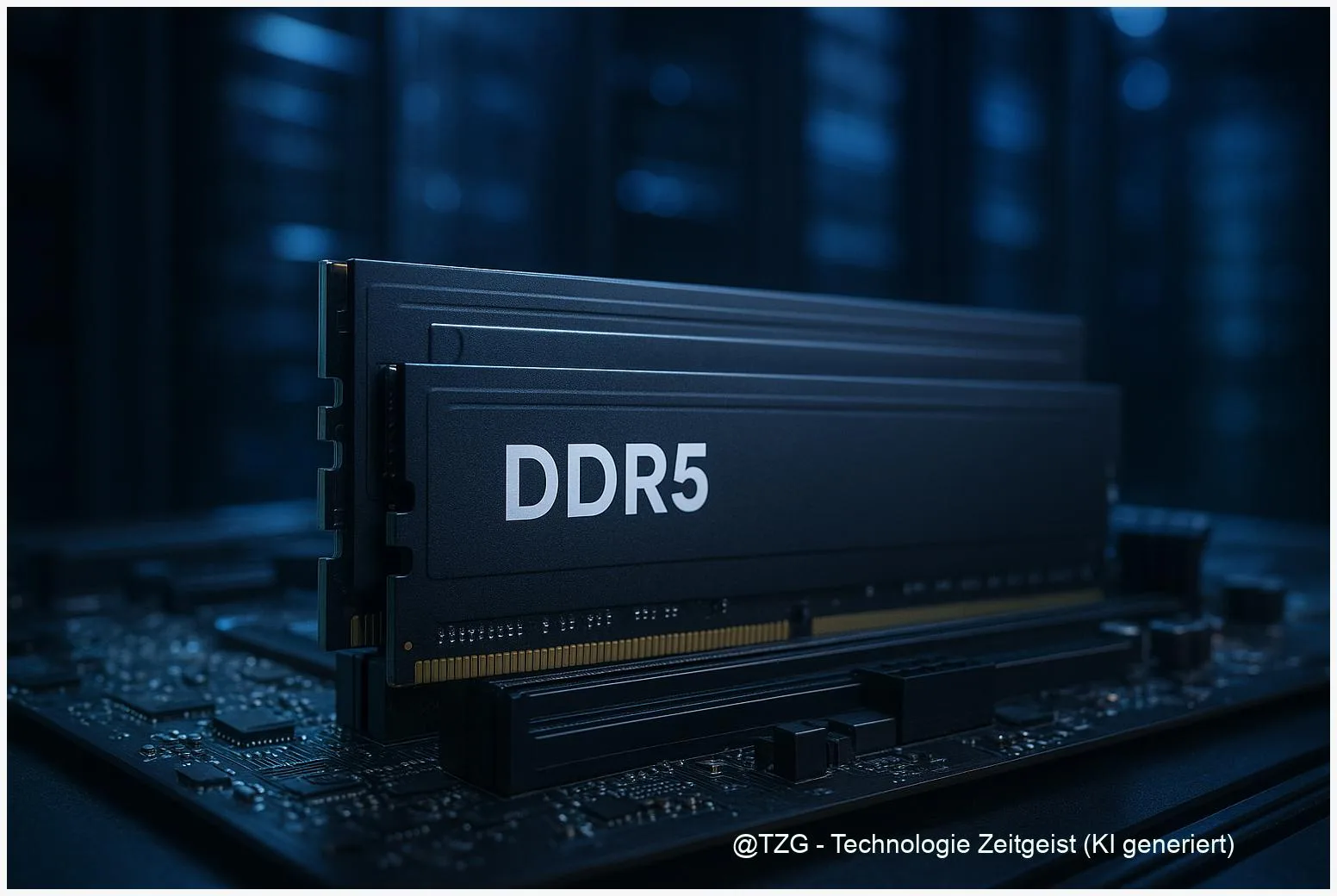

Warum RAM Preise 2025 steigen — Einfluss von AI‑Rechenzentren

In vielen Bereichen wirkt sich der knappe Arbeitsspeicher direkt auf Kosten und Entscheidungen aus: RAM Preise 2025 sind spürbar gestiegen, weil neue Serverarchitekturen und große

Warum KI so viel Compute braucht

Große KI‑Modelle verlangen enorme Rechenleistung. Warum KI so viel Compute braucht ist die zentrale Frage dieses Beitrags: Er zeigt, welche technischen Gründe hinter hohen FLOP‑Zahlen

Fara-7B: Ein 7 Milliarden‑Parameter‑Agent für Computer‑Aufgaben

Fara-7B ist ein 7 Milliarden Parameter großes Modell, das gezielt dafür trainiert wurde, grafische Benutzeroberflächen per Bildschirminput zu verstehen und Aktionen wie Klicken, Tippen oder Scrollen auszugeben.

From POC to Profit: Inference‑First‑Pipelines, die ROI liefern

Zuletzt aktualisiert: 2025-11-19 Kurzfassung Dieser Text erklärt, wie Teams den Schritt von POC zu Profit schaffen, indem sie eine inference‑first Denkweise etablieren. Wer AI inference

Der versteckte CO₂‑Preis generativer KI — messen, berichten, reduzieren

Zuletzt aktualisiert: 11. November 2025 Kurzfassung Dieser Artikel erklärt praktisch, wie sich der generative AI carbon footprint erfassen, berichten und senken lässt — ohne komplizierte

Run It Locally: Roadmap für Open‑Source‑LLMs auf Consumer‑Hardware

Zuletzt aktualisiert: 10. November 2025 Kurzfassung Dieser praktische Fahrplan zeigt, wie Entwickler und Hobby‑Tüftler run llm locally: von Hardware‑Checks über Modellwahl (z. B. Gemma 270M)

TPUs im Weltraum: Was Googles Project Suncatcher wirklich bedeutet

Zuletzt aktualisiert: 5. November 2025 Kurzfassung Project Suncatcher erforscht, wie TPUs im Weltraum genutzt werden könnten, um skalierbare AI‑Rechenzentren an Sonnenplätzen zu betreiben. Erste Tests

Fusion und dezentrale Energie: Wege zu unbegrenzter Power

Zuletzt aktualisiert: 4. November 2025 Kurzfassung Fusion, orbitales Solar und gebäudeintegrierte Batterien könnten zusammen eine neue Form von dezentrale Energie liefern: reichlich, verteilt und resilient.