RAG steht für Retrieval‑Augmented Generation und kombiniert ein Sprachmodell mit einer externen Wissensdatenbank. In dieser Kurzfassung wird erklärt, warum KI‑Chatbots trotz moderner RAG‑Architekturen falsche oder unbelegte Antworten liefern können und welche technischen Ansätze die Trefferquote und Nachprüfbarkeit verbessern. Der Text zeigt gängige Fehlerquellen beim Abruf von Informationen, pragmatische Maßnahmen für bessere Genauigkeit und praxisnahe Hinweise, die auch bei künftigen Systemen relevant bleiben.

Einleitung

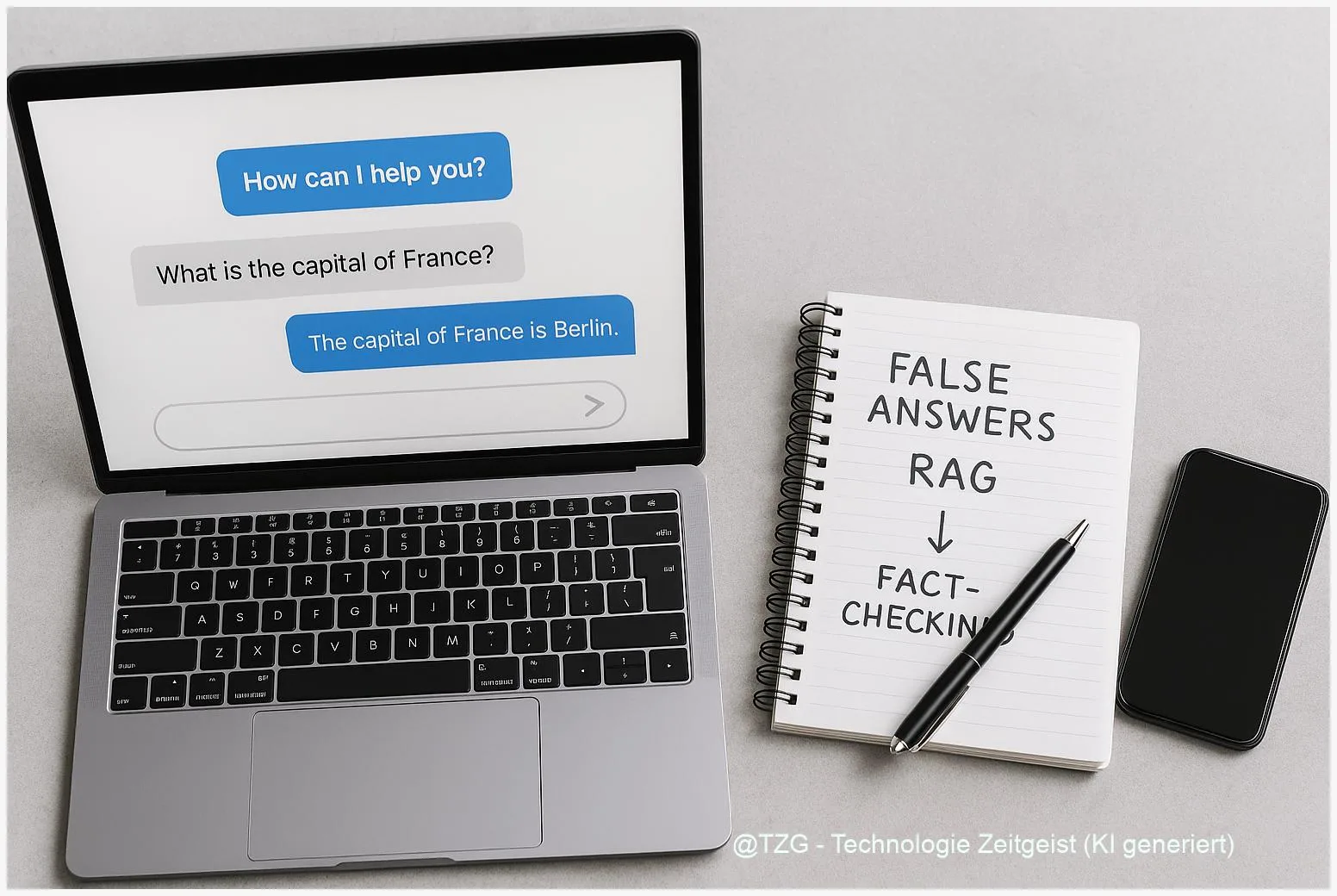

Viele Nutzerinnen und Nutzer erleben gelegentlich, dass ein Chatbot plausibel klingende, aber falsche Antworten gibt. Hinter solchen Fehlern steckt nicht nur das Sprachmodell selbst, sondern oft der Such‑Teil, der die Informationen aus externen Quellen holt. Moderne RAG‑Systeme koppeln ein generatives Modell an eine Vektordatenbank mit Text‑Embeddings. Das verbessert die Basis für faktenbasierte Antworten, beseitigt aber nicht alle Ursachen für Fehler.

Im Alltag zeigt sich das zum Beispiel, wenn ein Chatbot zur Firmengeschichte oder zu Produktdetails Angaben macht, die sich später nicht bestätigen lassen. Solche Fälle haben Einfluss auf Vertrauen, Arbeitsabläufe und die praktische Nutzbarkeit. Der folgende Text erklärt Schritt für Schritt, wie RAG technisch arbeitet, welche Fehlerarten häufig sind, welche Folgen sie haben und welche Maßnahmen die Genauigkeit erhöhen können.

Wie RAG funktioniert: Grundlagen und Architektur

RAG kombiniert zwei Kernkomponenten: einen Retriever, der aus einer großen Sammlung von Texten passende Dokumente auswählt, und einen Generator, der auf Basis dieser Dokumente eine Antwort formuliert. Der Retriever nutzt Vektoren – das sind Zahlenreihen, die Textinhalte zusammenfassen. Ein Embedding‑Modell wandelt Sätze oder Absätze in solche Vektoren um. Eine Vektordatenbank (auch Vektorindex genannt) ermöglicht dann schnelles Auffinden ähnlicher Inhalte.

Wichtig ist die Trennung von parametrischem Wissen, das im Modellgewicht steckt, und non‑parametrischem Wissen in der Datenbank. Wenn die Datenbank aktuelle oder spezialisierte Fakten enthält, kann der Generator diese Informationen in seine Antwort einbinden. Zwei häufige Varianten sind RAG‑Sequence (ein Dokument für eine gesamte Antwort) und RAG‑Token (Dokumentauswahl pro Token‑Entscheidung); beide haben Vor‑ und Nachteile bei Genauigkeit und Rechengeschwindigkeit.

Kernproblem: Gute Embeddings und ein gut strukturierter Index sind entscheidend; fehlt beides, entstehen falsche oder unbelegte Aussagen.

Bei der Umsetzung spielen technische Details eine große Rolle: Wie werden Texte in sinnvolle “Chunks” geteilt (Chunking‑Strategie)? Welche Embedding‑Modelle werden genutzt (größere Modelle erfassen oft feinere Bedeutungen)? Welche Indexierungsoptionen und Suchalgorithmen (z. B. FAISS, HNSW) kommen zum Einsatz? Kleine Entscheidungen hier führen zu spürbaren Unterschieden in der Trefferqualität.

Die folgende Tabelle fasst drei zentrale Eigenschaften und typische Einschätzungen zusammen.

| Merkmal | Beschreibung | Typischer Einfluss |

|---|---|---|

| Chunking‑Größe | Wie lang Textabschnitte sind, die indiziert werden | Mittel: beeinflusst Kontexttreue |

| Embedding‑Qualität | Genauigkeit, mit der Bedeutungen im Vektorraum abgebildet werden | Hoch: zentrale Einflussgröße |

| Reranker | Zusatzmodell zur Bewertungsreihenfolge gefundener Treffer | Mittel bis hoch: reduziert irrelevante Treffer |

Wenn der Abruf versagt: typische Fehler im Alltag

Falsche Antworten tauchen meist nicht aus heiterem Himmel auf. Vier praktische Fehlerarten wiederholen sich in Produktivfällen:

- Irrelevante Treffer: Der Retriever findet Dokumente, die oberflächlich ähnlich sind, inhaltlich aber nicht zur Frage passen. Das Modell kombiniert dann Teile daraus zu einer plausibel klingenden, aber falschen Aussage.

- Fehlender Recall: Relevante Belege sind im Index nicht vorhanden oder wurden beim Chunking zerstückelt, so dass sie nicht als Ganzes erkennbar sind.

- Veraltete oder fehlerhafte Quellen: Wenn die Datenbank veraltete Texte enthält, gibt das System alte Fakten als aktuell aus.

- Context‑Drift bei der Prompt‑Formulierung: Kleine Unterschiede in der Suchanfrage führen zu sehr unterschiedlichen Treffern; Embedding‑Modelle reagieren empfindlich auf Formulierungen.

Ein simples Beispiel: Bei einer Frage zu Produktfunktionen liefert der Retriever einen Blogbeitrag, der eine ältere Version beschreibt. Der Generator fasst zusammen und ergänzt möglicherweise falsche Ergänzungen aus seinem eigenen Wissen. Für die Nutzerin oder den Nutzer klingt die Antwort kohärent, ist aber in Teilen falsch.

Messgrößen helfen, Probleme einzugrenzen. Recall‑Werte, die angeben, wie oft eine gold‑standard Referenz unter den Top‑k Treffern liegt, sind aussagekräftig. Ebenso wichtig ist eine Prüfung der “Provenance” — also die Herkunft der verwendeten Textpassagen. Ohne diese Metadaten bleibt es schwer, eine Antwort nachzuprüfen.

Technisch lassen sich einige Verbesserungen sofort umsetzen: ein stärkerer Reranker, der Treffer besser sortiert; iterative Retrieval, bei der das System nach einer ersten Antwort noch einmal gezielt nach Belegen sucht; und einfache Heuristiken, die unsichere Kombinationen von Quellen erkennen und kennzeichnen. Solche Maßnahmen reduzieren, aber eliminieren nicht alle Fehler.

Was das für Vertrauen und Risiken bedeutet

Falsche Antworten haben unterschiedliche Folgen, je nachdem, wie der Chatbot eingesetzt wird. Bei allgemeinen Fragen oder Unterhaltung ist der Schaden meist gering. In Wissens‑ oder Entscheidungsprozessen kann er erheblich sein: falsche Empfehlungen, fehlerhafte Dokumentationen oder inkonsistente Vorgaben sind mögliche Folgen.

Ein zentrales Problem ist die vermeintliche Autorität von KI‑Antworten. Viele Menschen neigen dazu, eine klare, formulierte Antwort schnell als korrekt zu akzeptieren. Deshalb sind hinreichende Transparenz und einfache Prüfpfade wichtig: Quellenangaben, Zitate aus der Datenbank und ein Hinweis, wie aktuell die Grundlage ist, helfen Nutzerinnen und Nutzern, Aussagen selbst zu validieren.

Organisationen müssen entscheiden, wie weit sie auf automatische Antworten vertrauen. In regulierten Bereichen oder bei sicherheitsrelevanten Informationen ist ein menschlicher Prüfprozess oft unverzichtbar. Technische Gegenmaßnahmen können das Risiko senken: Confidence‑Calibrations, explizite Kennzeichnung von unsicheren Punkten und ein Fallback‑Mechanismus, der bei niedriger Trefferqualität auf eine Rückfrage oder einen Expertenverweis umschaltet.

Schließlich ist zu beachten, dass auch die Index‑Qualität und Pflege organisatorische Aufgaben sind. Ein veralteter oder schlecht kuratierter Index erhöht langfristig das Fehlerrisiko. Regelmäßige Aktualisierung, Logging von Retrieval‑Statistiken und Mensch‑in‑the‑Loop‑Prüfung reduzieren systematische Fehlerquellen.

Wohin sich Systeme entwickeln könnten

Die Entwicklung geht in mehrere, sich ergänzende Richtungen. Bessere Embedding‑Modelle und feinere Chunking‑Strategien verbessern die Rohqualität der Treffer. Parallel werden Reranker und faktische Evaluatoren eingesetzt, die Antworten gegen mehrere Belege abgleichen. Solche mehrstufigen Pipelines senken die Wahrscheinlichkeit unbelegter Aussagen.

Ein weiterer Trend ist das verlässlichere Reporting: Systeme geben nicht nur eine Antwort, sondern am Ende eine kurze Provenance‑Zusammenfassung mit Links zu den genutzten Quellen und einer einfachen Einschätzung, wie gut die gefundene Evidenz die Antwort stützt. Technisch nötig sind dafür Indexmetadaten und schnelle On‑The‑Fly Verifikationsschritte.

In Zukunft werden auch Monitoring‑Systeme und automatische Detektoren eine größere Rolle spielen. Forschungsarbeiten zeigen erste Erfolge bei Token‑level Detection und LLM‑gestützten Prüfern. Solche Tools helfen, problematische Antworten früh zu erkennen und zu kennzeichnen. Wichtig bleibt, dass Erkennung nicht gleichbedeutend mit Verhinderung ist — Eingriffe in Echtzeit erfordern oft zusätzliche Systeme und menschliche Überprüfung.

Für Anwenderinnen und Anwender bedeutet das: Eine Kombination aus besseren Modellen, sorgfältig gepflegten Datenbanken und transparenten UI‑Elementen wird die Vertrauenswürdigkeit von RAG‑basierten Chatbots erhöhen. Technisch ist das anspruchsvoll, aber machbar; die Praxis wird zeigen, welche Kombinationen sich als robust erweisen.

Fazit

RAG reduziert viele gängige Ursachen für falsche Chatbot‑Antworten, macht das System aber nicht automatisch fehlerfrei. Die Qualität hängt stark von Index‑Design, Embedding‑Modellen, Chunking‑Strategie und zusätzlichen Rerankern ab. Für verlässliche Antworten sind außerdem Pflege der Datenbasis, transparente Quellenangaben und Monitoring unerlässlich. Wer auf RAG setzt, profitiert von besseren Faktenbelegen, sollte aber Verantwortung für Aktualität und Nachprüfbarkeit übernehmen.

Schreibe einen Kommentar