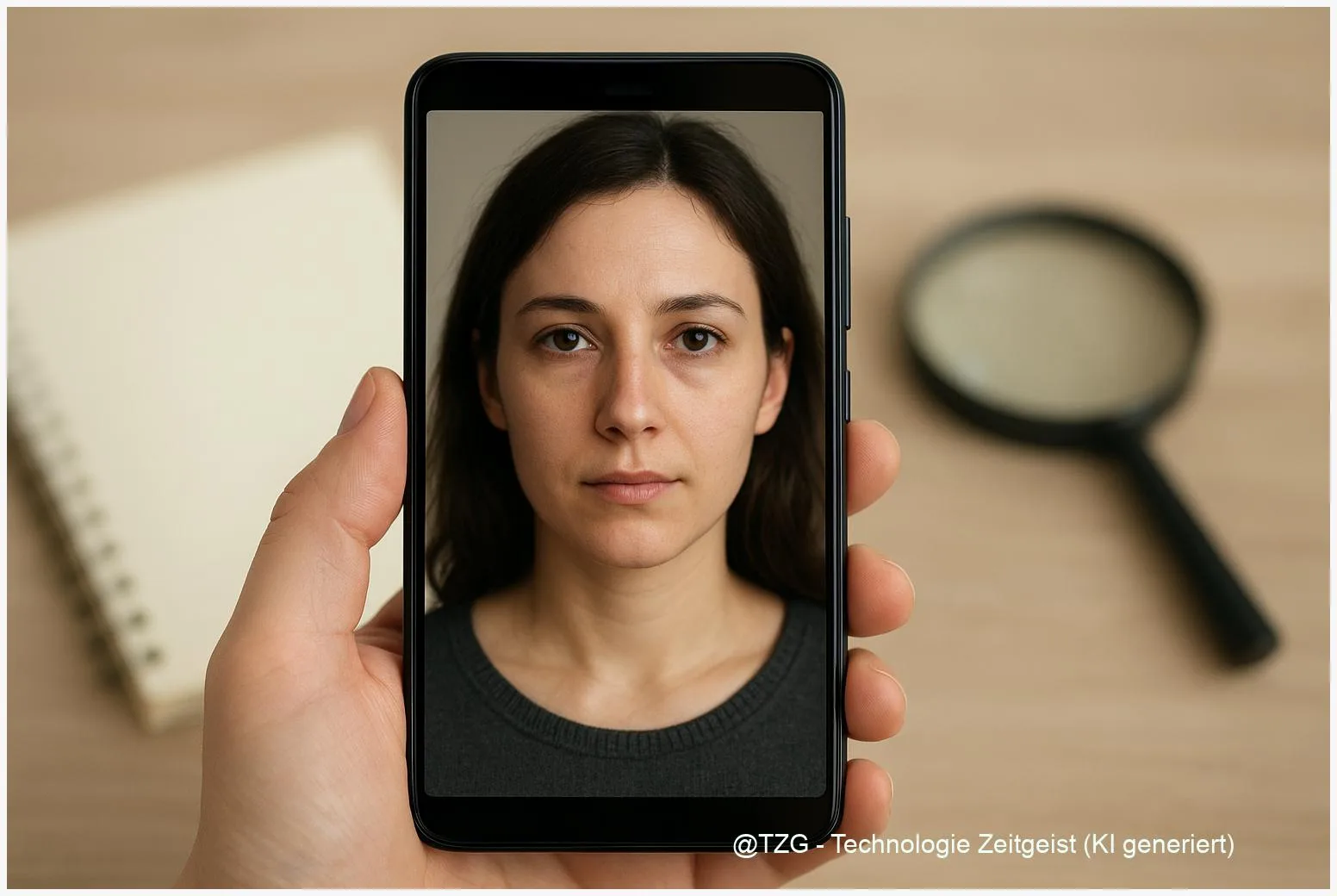

KI-Deepfakes tauchen immer realistischer auf und erschweren die Unterscheidung von echten und manipulierten Bildern. Diese Kurzfassung nennt konkrete Anzeichen, einfache Prüfmethoden und Werkzeuge, mit denen sich Manipulationen schneller erkennen lassen. Wer Bilder prüft, kombiniert Sichtkontrolle, Metadatenanalyse, Rückwärtssuche und forensische Tools, um Fehleinschätzungen zu vermeiden. Die beschriebenen Schritte eignen sich für Social‑Media‑Beiträge, Nachrichtenfotos und private Aufnahmen.

Einleitung

Jedes Jahr werden Bildgeneratoren feinkörniger: Hauttexturen, Licht und Haare wirken natürlicher, Porträt‑ und Gruppenbilder lassen sich mit wenigen Klicks erzeugen. Für Menschen, die Nachrichten, Social‑Media‑Posts oder private Bilder bewerten, stellt das eine wachsende Herausforderung dar. Häufig reicht ein kurzer Blick nicht aus, weil KI‑Generatoren typische Täuschungen sehr plausibel nachbilden. Praktisch relevant wird das, wenn manipulierte Bilder in Nachrichten, Jobsuchen oder privaten Konflikten auftauchen.

Gleichzeitig gibt es einfache Prüfverfahren, die die Wahrscheinlichkeit einer Fälschung deutlich reduzieren. Sie funktionieren, ohne Spezialsoftware zu beherrschen. In der Folge werden Grundlagen erklärt, ein konkreter Prüf‑Workflow vorgeschlagen, Chancen und Risiken abgewogen und ein Blick auf künftige Entwicklungen gegeben.

Wie KI-Bilder entstehen und was das sichtbar macht

Moderne Bildgeneratoren nutzen neuronale Netze, die aus großen Mengen Fotos lernen, welche Formen, Farben und Strukturen typisch sind. Das Modell erzeugt neue Bilder, indem es Muster kombiniert. Dabei entstehen wiederkehrende Artefakte: unsaubere Übergänge an Haaransätzen, asymmetrische Augen, unregelmäßige Reflexionen auf Brillen oder merkwürdige Hände. Solche Merkmale sind Hinweise, aber keine Beweise — sie erhöhen nur die Wahrscheinlichkeit, dass ein Bild künstlich ist.

Einige visuelle Hinweise erscheinen unauffällig, werden bei genauer Betrachtung aber konsistent sichtbar: asymmetrische Lichtreflexe, seltsame Halskonturen oder unnatürliche Zahnformen.

Technisch gesehen resultieren diese Auffälligkeiten oft aus Begrenzungen im Trainingsdatensatz oder aus Artefakten bei der Bild‑Synthese. Wenn Generatoren später nachbearbeitet werden (Upscaling, Color Grading, Kompression), verschleiern diese Schritte die Hinweise für automatische Detektoren. Viele etablierte Datensätze und Benchmarks stammen aus 2019–2021; diese Quellen sind in Teilen älter als zwei Jahre, was die Übertragbarkeit auf neuere Generatoren einschränken kann.

Die folgende Tabelle fasst typische Merkmale knapp zusammen.

| Merkmal | Beschreibung | Warum es auffällig ist |

|---|---|---|

| Asymmetrische Augen | Größen- oder Blickabweichung beider Augen | GANs tun sich schwer mit präziser Gesichtsgeometrie |

| Unnatürliche Hände | Zuviel oder zu wenige Finger, ungewöhnliche Gelenkwinkel | Hände sind komplex und oft schlecht gerendert |

| Hintergründe | Verschwommene Übergänge oder sich wiederholende Muster | Generatoren priorisieren Vordergrunddetails |

Praxis: Konkrete Prüf-Schritte für jedes Bild

Ein verlässlicher Prüfablauf kombiniert mehrere einfache Schritte. Beginne mit der Sichtprüfung: Vergrößere das Bild, achte auf Augen, Haare, Ohren und Hände. Suche nach Unstimmigkeiten bei Schatten und Reflexionen. Danach folgt die Metadaten‑Kontrolle: EXIF‑Daten geben Aufschluss über Kamera, Aufnahmezeit und Bearbeitung. Fehlen diese Angaben völlig oder sind sie widersprüchlich, ist das ein Hinweis, nicht das letzte Wort.

Für die nächste Prüfung nutze eine Rückwärts‑Bildersuche (etwa TinEye oder die Bildersuche großer Suchmaschinen) — so lässt sich prüfen, ob das Bild oder ähnliche Varianten bereits online existieren. Findet sich kein passendes Original, kann das auf Generierung oder starkes Nachbearbeiten hindeuten. Ergänzend empfiehlt sich die Nutzung von mindestens zwei forensischen Tools: eine Fehler‑Level‑Analyse (ELA) zeigt unterschiedliche Kompressionsregionen, ein neuronaler Detektor weist typische KI‑Signale nach. Automatische Tools liefern keine Gewissheit; ihre Aussagen werden belastbarer, wenn mehrere Methoden übereinstimmen.

Im Alltag reicht oft folgender 4‑Schritte‑Workflow: 1) Sichtprüfung dokumentieren, 2) EXIF/Provenienz prüfen, 3) Rückwärtssuche durchführen, 4) zwei forensische Tools anwenden und Befunde vergleichen. Bei hoher Relevanz — zum Beispiel vor Veröffentlichung in einem Medium oder bei rechtlichen Fragen — ist eine forensische Fachanalyse ratsam. Die beschriebene Kombination reduziert False Positives und False Negatives deutlich.

Chancen und Risiken bei der Verbreitung

Künstlich erzeugte Bilder eröffnen kreative Möglichkeiten: Illustration, Werbung, schnelles Prototyping. Für Medien und Bildung bieten sie neue Bildquellen. Gleichzeitig entstehen Risiken: Manipulierte Bilder können gezielt Desinformation verbreiten, private Konflikte eskalieren lassen oder in Identitätsdiebstahl münden. Entscheidend ist die Wirkung — ein manipuliertes Bild mit geringem Publikum bleibt meist harmlos, bei großer Reichweite kann es jedoch erheblichen Schaden anrichten.

Auf Seiten der Erkennung bieten sich Chancen durch bessere Tools und standardisierte Benchmarks. Behörden und Forschungseinrichtungen fordern seit einigen Jahren versionierte Testsets und Cross‑Domain‑Evaluationen, weil viele Detektoren stark über ihre Trainingsdaten hinaus an Genauigkeit verlieren. In der Praxis muss man mit Unsicherheiten rechnen: Automatische Detektoren in Laborbedingungen erreichen oft hohe Werte, verlieren aber Leistung bei komprimierten oder nachbearbeiteten Social‑Media‑Bildern.

Deshalb ist Medienkompetenz zentral: Wer Quellen prüft, reduziert die Wirksamkeit manipulativer Inhalte. Plattformbetreiber können zusätzlich durch klare Kennzeichnung, Faktenchecks und einfache Prüftools das Risiko mindern. Rechtliche und ethische Fragen bleiben komplex; technische Lösungen sind nur ein Teil des gesamten Schutzes.

Wie sich Erkennung und Technik weiterentwickeln könnten

Die technische Entwicklung läuft in zwei Richtungen: die Generatoren werden realistischer, gleichzeitig verbessern sich Erkennungswerkzeuge durch bessere Trainingsmethoden und multimodale Ansätze. Forscher setzen zunehmend auf selbstüberwachtes Lernen und Vision‑Transformer‑Modelle, die Robustheit gegenüber Domänenwechseln verbessern sollen. Solche Fortschritte zeigen Potenzial, allerdings sind viele Studien auf älteren Datensätzen validiert — deshalb ist langfristige Generalisierung noch nicht garantiert.

Wahrscheinliche Trends: stärkere Nutzung multimodaler Signale (Bild+Audio+Metadaten), erklärbare Forensik (Heatmaps, lokalisiertes Artefakt‑Reporting) und standardisierte Stress‑Tests (Kompression, Upscaling, adversariale Störungen). Praktisch bedeutet das für Nutzer: Prüfroutinen bleiben wichtig, aber es wird bessere Unterstützung durch Tools geben, die mehrere Indizien bündeln und die Entscheidungshilfe transparenter machen.

Für Organisationen empfiehlt sich, Evaluationsprotokolle regelmäßig zu aktualisieren und auf unabhängige Benchmarks zu bestehen. Nutzer sollten bei wichtigen Entscheidungen nicht nur auf ein einzelnes Tool vertrauen, sondern mehrere Quellen und Expertisen einbeziehen.

Fazit

Realistische KI‑Deepfakes machen das Prüfen von Bildern zunehmend erforderlich. Sichtkontrolle, Metadatenanalyse, Rückwärtssuche und forensische Tools zusammen liefern eine robuste Arbeitsweise: Kein einzelnes Verfahren bringt Gewissheit, aber das Zusammenführen mehrerer Indizien schafft verlässliche Einschätzungen. Forschung und Praxis bewegen sich hin zu multimodalen und erklärbaren Lösungen, doch solange Generatoren weiter ausreifen, bleibt eine vorsichtige, dokumentierte Prüfung der beste Schutz gegen Fehlinterpretationen.

Schreibe einen Kommentar