Kategorie: KI

Künstliche Intelligenz revolutioniert unsere Welt, von autonomem Fahren bis hin zu personalisierten Medikamenten. Tauchen Sie ein in faszinierende Artikel, die das Potenzial, die Ethik und die Risiken rund um diese transformative Technologie beleuchten.

-

KI‑Begriffe 2025 einfach erklärt: RAG, Agenten, Tokens

Wer Begriffe rund um Künstliche Intelligenz schneller einordnen möchte, findet hier klare Antworten: KI-Begriffe einfach erklärt, mit Fokus auf RAG (Retrieval Augmented Generation), KI-Agenten, Tokens

Gemini Live: So nutzt du Sprach‑KI nach dem großen Update im Alltag

Gemini Live bietet eine neue Form der Sprach‑KI: in Echtzeit per Stimme kommunizieren, die Kamera oder der Bildschirm teilen und direkte Aktionen auf dem Smartphone

Online‑Prüfungen im KI‑Zeitalter: Warum viele Tests Präsenz wählen

Prüfungsformen verändern sich: Die Angst vor KI‑basiertem Schummeln treibt viele Hochschulen dazu, Prüfungen neu zu denken. Eine Online‑Prüfung bleibt praktisch, zugleich wächst das Bedürfnis nach

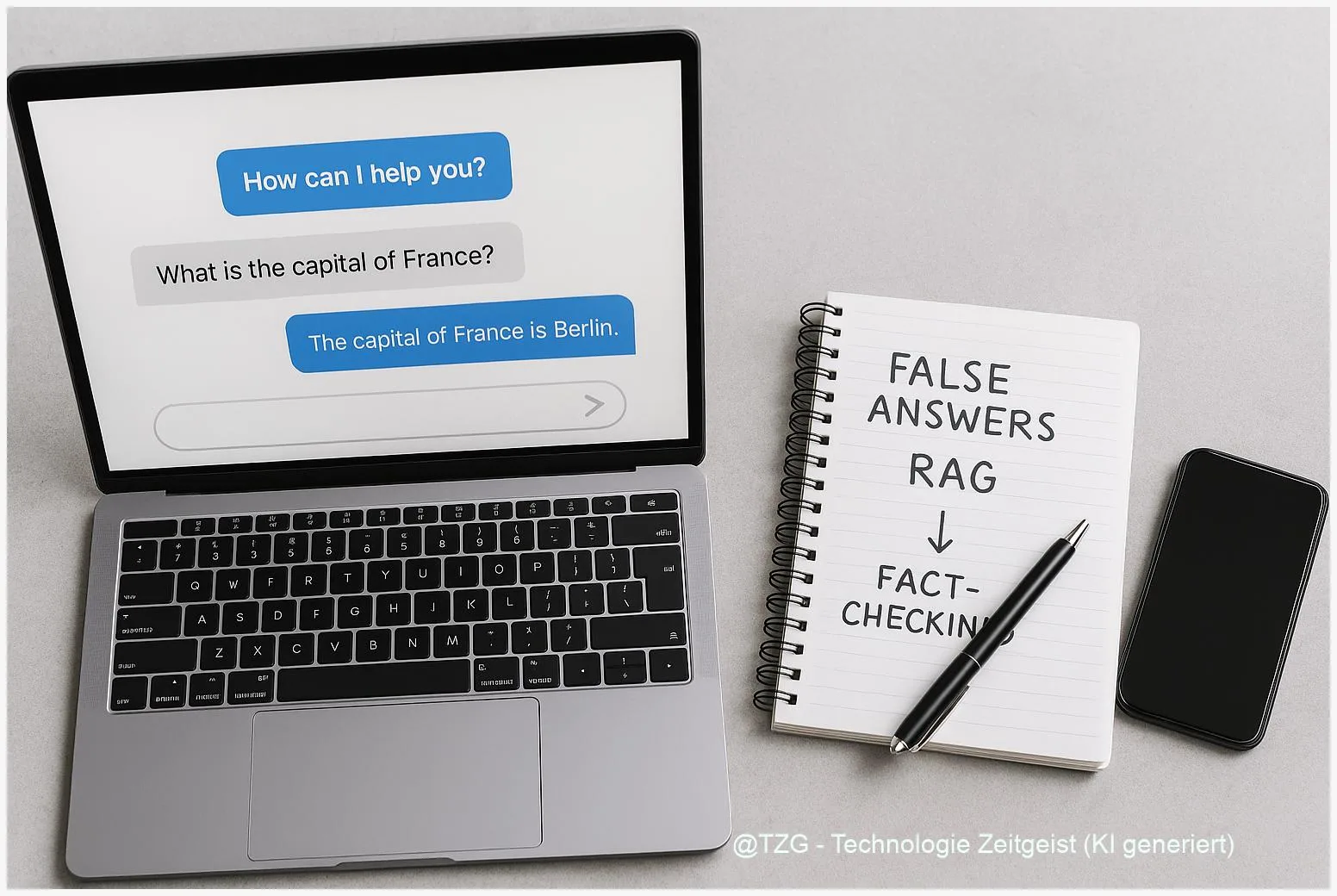

RAG erklärt: Warum KI-Chatbots falsche Antworten geben – und was hilft

RAG steht für Retrieval‑Augmented Generation und kombiniert ein Sprachmodell mit einer externen Wissensdatenbank. In dieser Kurzfassung wird erklärt, warum KI‑Chatbots trotz moderner RAG‑Architekturen falsche oder

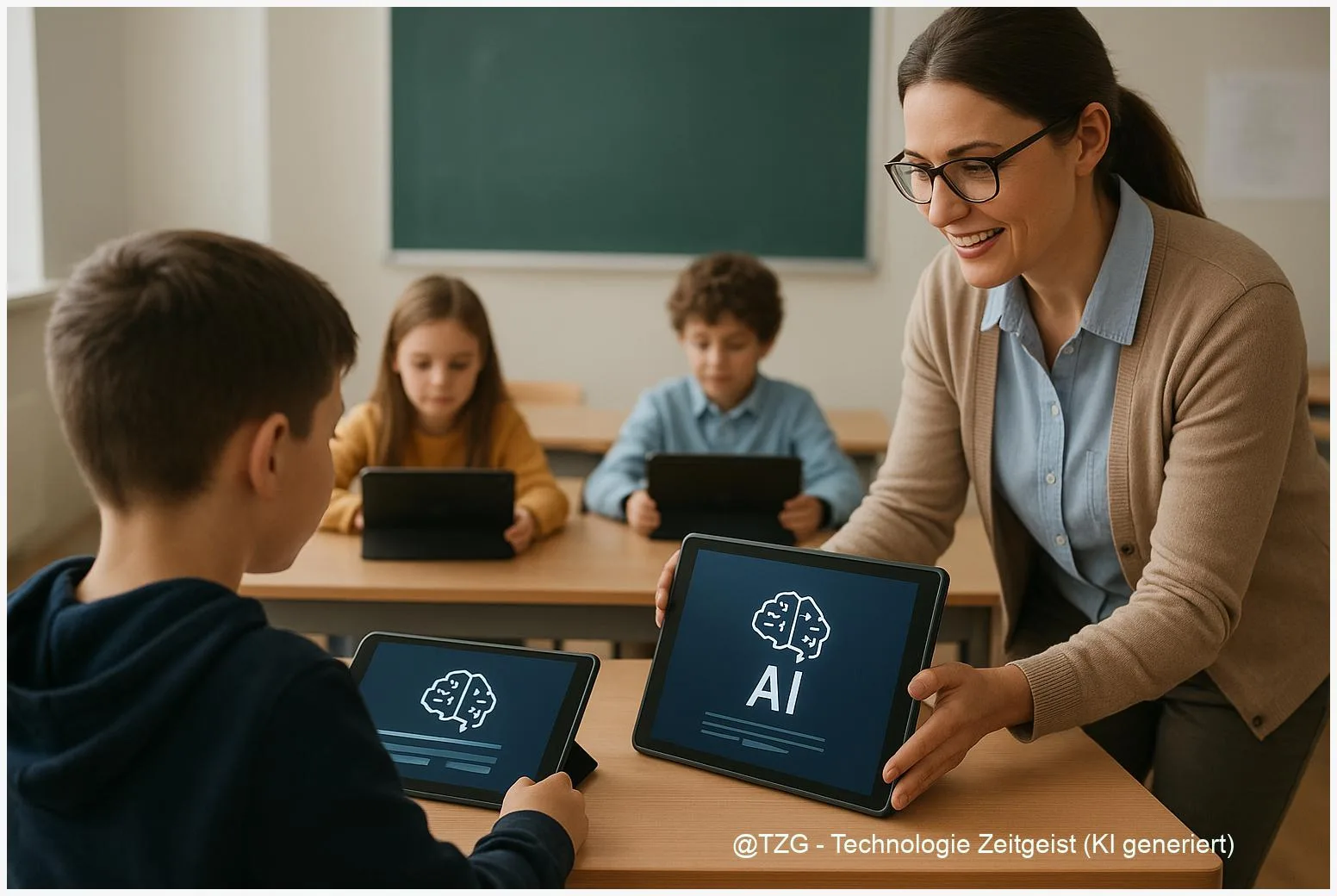

Kleine KI-Modelle im Klassenzimmer: Warum sie oft besser passen als große

Kleine, lokal ausführbare KI-Modelle, oft Small Language Models (SLM) genannt, erlauben viele nützliche Funktionen direkt auf Schulgeräten – ohne ständige Verbindung zur Cloud. Das reduziert

Kleine KI‑Modelle: Reinforcement Learning macht On‑Device‑KI zuverlässiger

Kleine Sprachmodelle können direkte Antworten auf dem Smartphone liefern, ohne Daten an Server zu senden. Reinforcement Learning, speziell Reinforcement Learning from Human Feedback (RLHF), hilft,

KI‑Begleiter im Alltag: Chancen, Risiken und gesunde Grenzen

KI-Begleiter sind heute an vielen digitalen Orten präsent und beeinflussen, wie Menschen sich fühlen und Entscheidungen treffen. In diesem Text steht das Verhältnis zwischen Alltagspraxis,

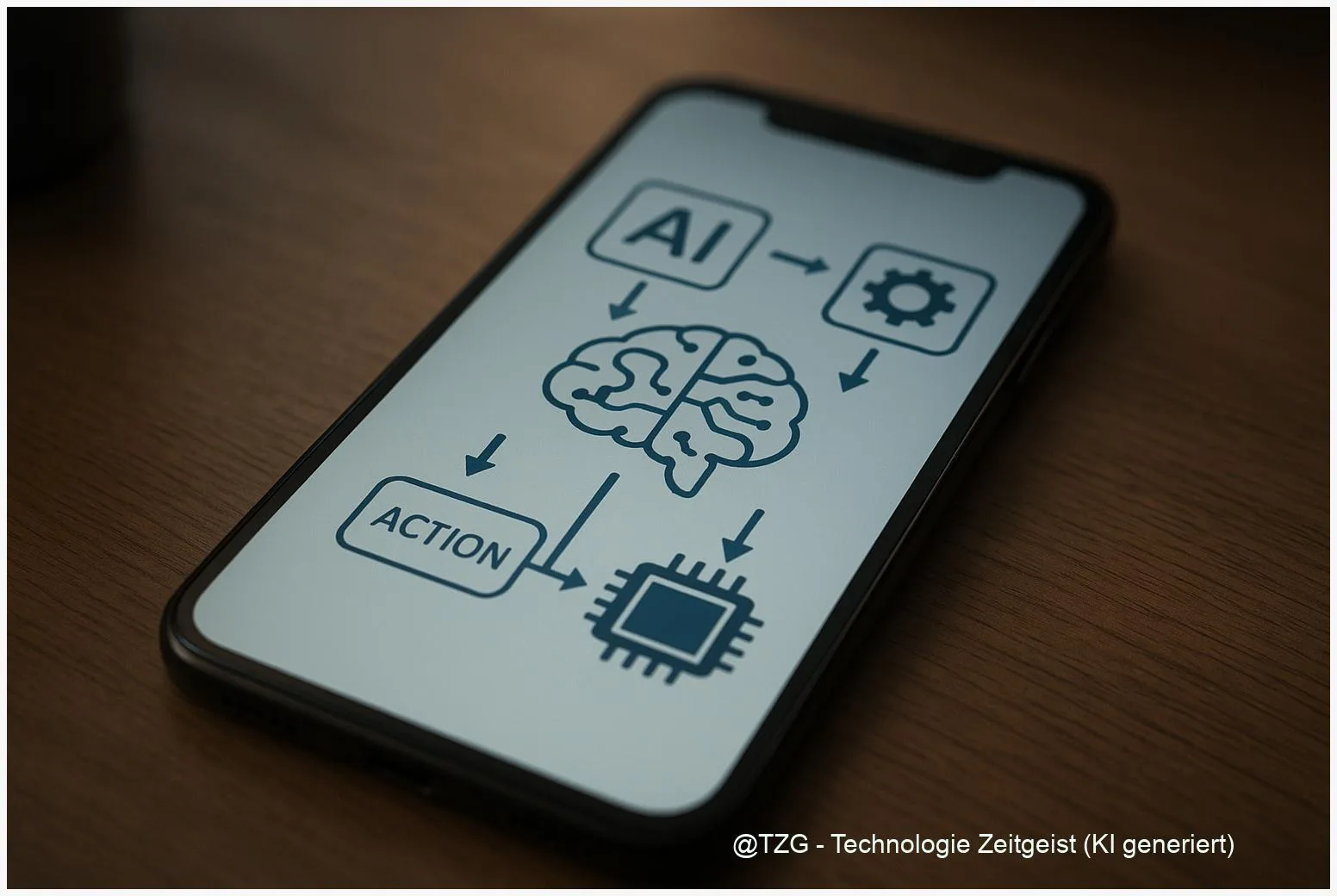

Agentische Workflows: Wie KI-Agenten mit Tools zuverlässig handeln

Agentische Workflows verbinden mehrere KI-Agenten mit externen Werkzeugen, damit komplexe Aufgaben zuverlässig erledigt werden. Das Konzept “agentische Workflows” beschreibt, wie einzelne Agenten, Tool-Aufrufe und ein

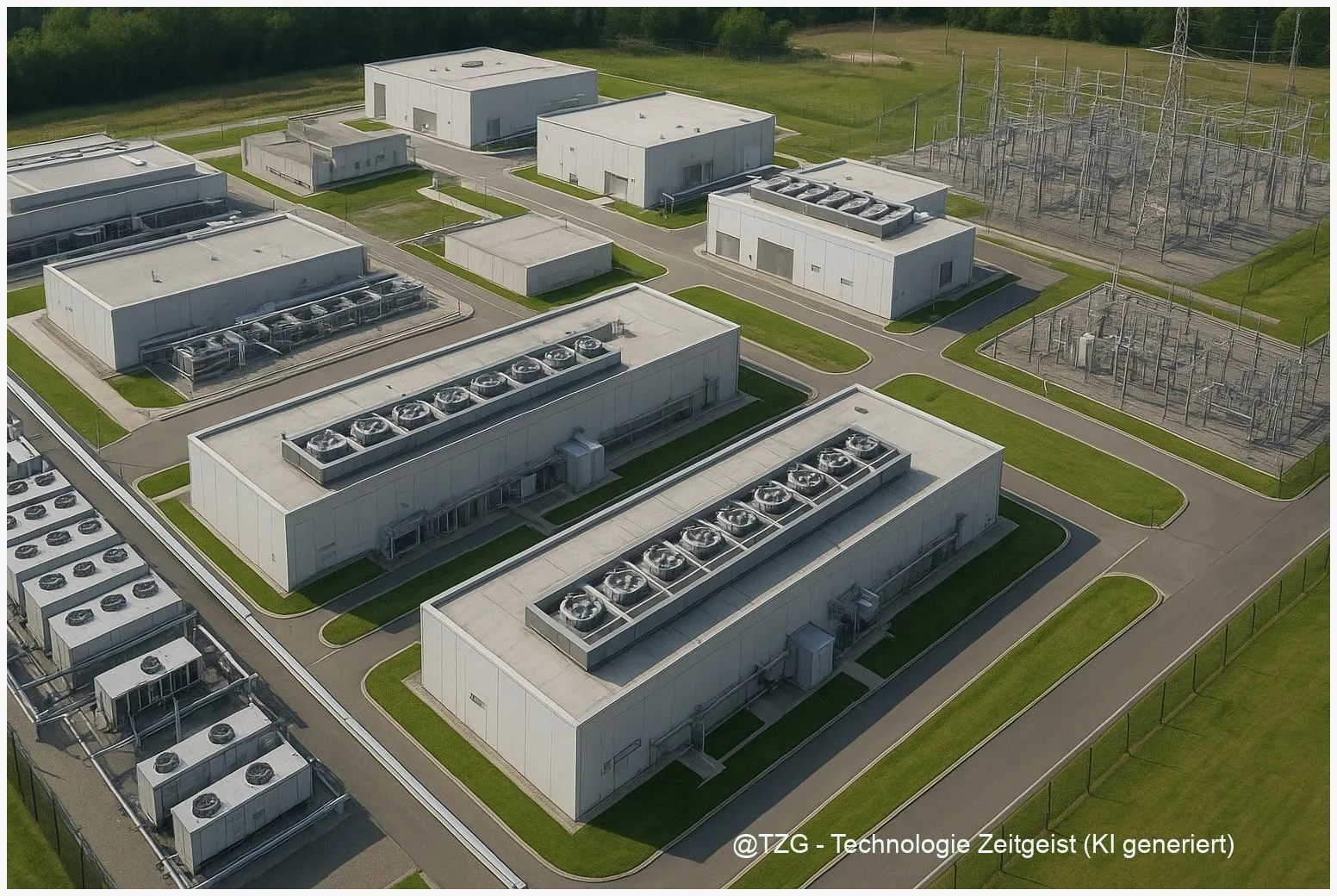

Warum KI‑Rechenzentren Milliarden kosten – und was das für Energie bedeutet

KI‑Rechenzentren sind heute ein zentraler Treiber für Nachfrage nach Strom, Kühlung und Infrastruktur. Dieses Abstract fasst zusammen, warum der Bau und Betrieb solcher Anlagen hohe

Vogelstimmen per App erkennen: Wie Merlin Bird ID KI nutzt

Merlin Bird ID hilft beim Vogelstimmen erkennen per Smartphone: die App vergleicht kurze Aufnahmen mit großen Referenzsammlungen und liefert Artenvorschläge samt Vertrauenswerten. Merlin Bird ID

Warum Open-Source-Modelle wie Qwen den KI-Markt 2026 prägen könnten

Open‑Source‑LLMs gewinnen an Gewicht: Projekte wie Qwen bieten Herstellern und Forschern Zugang zu Modellen, die lokal betrieben, angepasst und geprüft werden können. Für Anwenderinnen und

On-Device KI-Agenten: Wie „Function Calling“ Apps und Geräte steuern kann

Moderne On‑Device KI-Agenten erlauben lokalen, schnellen und datensparsamen Betrieb von Assistenzfunktionen auf Smartphones und Edge‑Geräten. Ein zentrales Konzept dafür ist Function Calling: die Möglichkeit, dass

Warum KI-Forschung nicht automatisch zu schnellen Heilmitteln führt

KI hat die Forschung beschleunigt, liefert aber nicht automatisch neue Medikamente. Das Hauptproblem liegt in Datenqualität, biologischer Komplexität und fehlender prospektiver Validierung — zentrale Gründe,

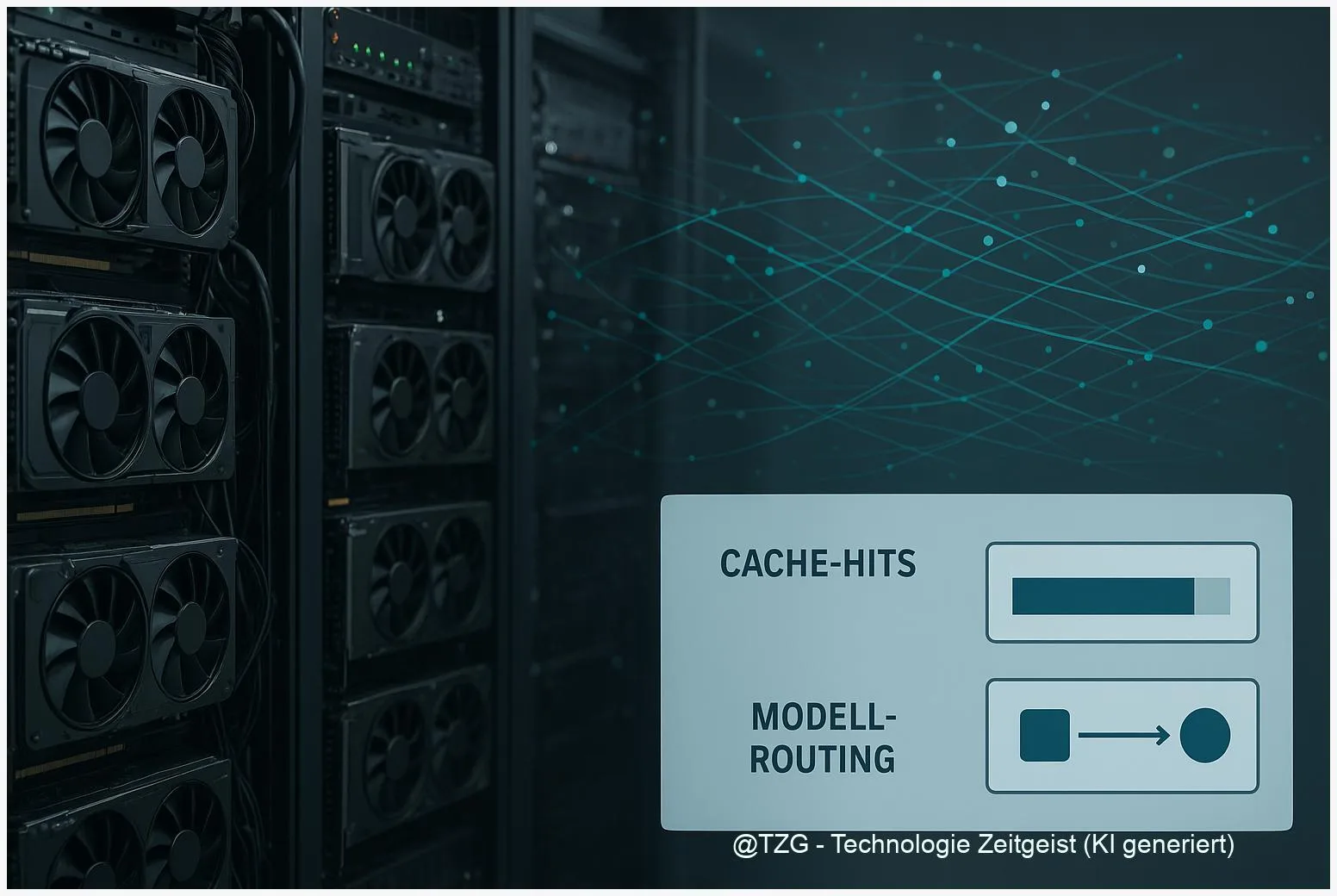

AI Gateways erklärt: Warum LLMs in Apps plötzlich Infrastruktur werden

Ein AI Gateway ist die zentrale Technik, die Anfragen an verschiedene große Sprachmodelle koordiniert und damit LLM‑Betrieb in Apps handhabbar macht. Das Stichwort AI Gateway

Warum GenAI in Produktion teuer wird – und wie Orchestrierung Kosten senkt

Generative KI in Produktion kann schnell hohe laufende Kosten verursachen – vor allem durch Inference-Aufwände, großes Kontextfenster und häufige Modellaufrufe. Dieses Stück zeigt, wie LLM