Personalisierte Inhalte durch KI entscheiden zunehmend, welche Nachrichten, Filme oder Musik wir sehen. Dieser Text ordnet, wie solche Systeme arbeiten, welche Erwartungen sie bedienen und welche Regeln in Europa gelten. Er zeigt praxisnahe Beispiele aus Streaming, News und Social Media, benennt zentrale Chancen für Nutzerinnen, Medien und Werbetreibende sowie die wichtigsten Risiken für Vielfalt, Datenschutz und Urheberrecht. Am Ende stehen realistische Szenarien, wie sich Dienste, Regulierungen und Publizierende anpassen könnten.

Einleitung

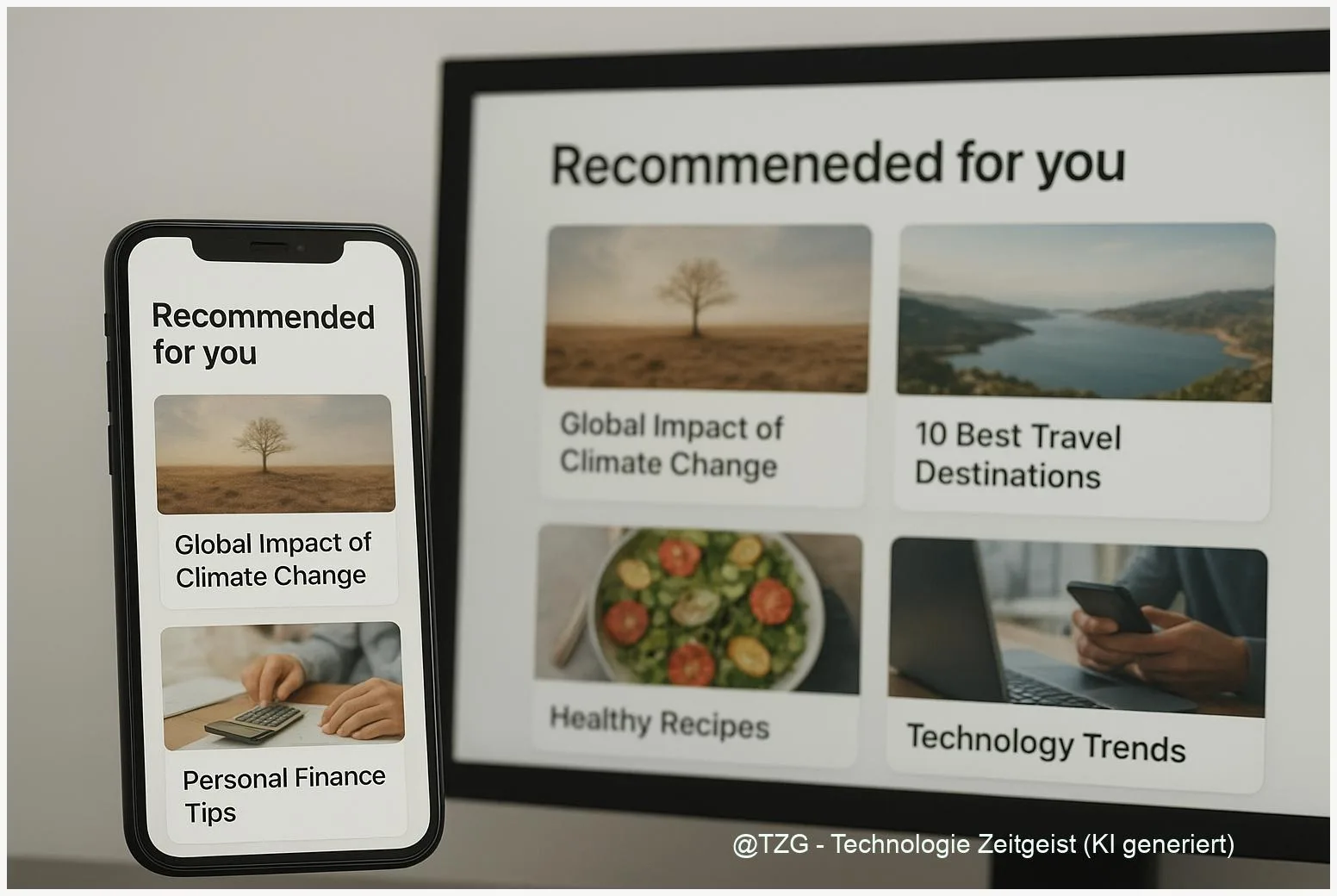

Viele Dienste bieten heute Empfehlungen, die genau zu Interessen passen sollen: Streamingplattformen wählen Filme, News-Apps sortieren Meldungen, Plattformen liefern Werbung mit vermeintlich passender Ansprache. Diese Empfehlungen entstehen nicht zufällig; hinter ihnen arbeiten Algorithmen und große Datensätze. Für Nutzerinnen bedeuten sie mehr Komfort und schnellere Entdeckung relevanter Inhalte. Für Medien und Werbetreibende sind sie ein Hebel für Aufmerksamkeit und Umsatz. Gleichzeitig entstehen Fragen: Wie transparent sind die Entscheidungen? Wer profitiert wirtschaftlich? Und wie bleiben Vielfalt und Rechte geschützt? Dieser Text erklärt die Mechanik, zeigt konkrete Alltagsfälle, bewertet Chancen und Risiken und ordnet ein, welche Regeln in Europa inzwischen gelten.

Wie personalisierte Inhalte durch KI funktionieren

Personalisierung beginnt mit Daten: Welche Filme Sie angesehen haben, welche Artikel Sie anklicken oder wie lange Sie ein Video schauen. Diese Signale speisen Modelle, die Muster erkennen und Vorhersagen treffen. Ein typisches System kombiniert drei Bausteine: Datensammlung (Logfiles, Profilangaben), ein Empfehlungsmodell (zum Beispiel kollaboratives Filtern oder neuronale Netze) und eine Bewertungsschicht, die Erfolg misst (Klickrate, Verweildauer).

„Empfehlungssysteme ordnen Vorlieben; sie sind statistische Vermutungen, keine Fakten.“

Begriffe kurz erklärt: Kollaboratives Filtern vergleicht Nutzerinnen mit ähnlichem Verhalten, um Inhalte vorzuschlagen. Neuronale Netze sind Rechenmodelle, die komplexe Muster aus vielen Faktoren lernen. Beide Ansätze können kombiniert werden: hybride Systeme mischen Verhaltensdaten mit Inhaltsmerkmalen (Genre, Themen, Schlagworte).

Einfaches Beispiel: Wenn zwei Nutzerinnen oft dieselben Dokumentarfilme schauen, empfiehlt das System der einen häufiger Dokumentationen, die die andere noch nicht gesehen hat. Das Modell schätzt Wahrscheinlichkeit und sortiert Vorschläge nach erwartetem Interesse.

Damit Personalisierung sinnvoll funktioniert, brauchen Dienste außerdem Messgrößen (KPIs) und kontinuierliches Feedback. Unternehmen optimieren auf Engagement‑Metriken, weil sie mit mehr Verweildauer Einnahmen steigern können. Genau hier entstehen Konflikte zwischen optimalem Geschäftserfolg und öffentlichen Zielen wie Vielfalt und genauer Information.

Wenn Daten fehlen oder verzerrt sind, entstehen Fehleinschätzungen: ein neuer Nutzer erhält irrelevante Vorschläge, eine Minderheit wird weniger sichtbar. Technische Gegenmaßnahmen reichen von Zufallsanteilen in Empfehlungen bis zu Regularien, die Transparenz und Opt‑outs fordern.

Tabelle: Typen der Personalisierung

| Merkmal | Beschreibung | Beispiel |

|---|---|---|

| Verhaltensbasiert | Empfehlungen aus vergangenem Nutzerverhalten | „Ähnliche Filme wie gesehen“ |

| Kontextuell | Berücksichtigt Zeit, Gerät, Standort | News für Morgenpendelnde |

| Inhaltsbasiert | Matching anhand von Metadaten und Themen | Artikel mit ähnlichen Schlagworten |

Einsatz im Alltag: Beispiele aus Streaming, News und Werbung

Im Streaming sorgen Empfehlungsmaschinen dafür, dass Nutzerinnen neue Serien entdecken. Sie verwenden Wiedergabezeit, Bewertungen und Skip‑Muster. Bei News‑Apps mischt das System Interessen mit Aktualität und Popularität; einige Dienste erlauben zudem redaktionelle „Boosts“ für wichtige Themen. In Werbung wählt Personalisierung Zielgruppen aus und passt Botschaften an – das ist effektiv, aber datenschutzrechtlich sensibel.

Konkreter Alltag: Beim Öffnen einer Video‑App sieht man oft eine personalisierte Startseite. Ganz oben landen Titel mit hoher vorhergesagter Klickwahrscheinlichkeit. Für die Plattform erhöht das Engagement die Einnahmen; für die Zuschauerin kann es nützlich sein, weil passende Inhalte schneller sichtbar sind. Allerdings reduzieren stark optimierte Empfehlungen die Chance, auf völlig unerwartete Inhalte zu stoßen.

Im Newsbereich zeigen Studien, dass personalisierte Feeds Verweildauer steigern, aber die Vielfalt der Quellen verringern können. Dienste können gegensätzliche Effekte erzielen: Mehr Relevanz, aber weniger zufällige Entdeckung. Deshalb verlangen Regulierungen wie die DSA in Europa inzwischen, dass große Plattformen auch eine nicht‑personalisierte Ranking‑Option anbieten.

Für Werbetreibende sind Personalisierung und Attribution wichtige Werkzeuge. Sie erlauben gezieltere Kampagnen, weniger Streuverlust und bessere Messbarkeit. Doch Nutzerinnen verlangen zunehmend Transparenz und Kontrollmöglichkeiten über die Verwendung ihrer Daten. Rechtliche Rahmenbedingungen sowie technische Opt‑outs sind deshalb Teil moderner Marketing‑Strategien.

Chancen und Risiken: Eine nüchterne Abwägung

Personalisierung bietet klare Vorteile: Zeitersparnis, bessere Relevanz und Geschäftsmodelle, die kostenlose oder günstige Inhalte ermöglichen. Für kleinere Anbieter kann zielgerichtete Werbung einen Wettbewerbsvorteil schaffen, weil Budgets effizienter eingesetzt werden.

Auf der anderen Seite stehen Risiken, die nicht nur technisch lösbar sind. Ein zentrales Problem ist die Vielfalt: Wenn Algorithmen auf Engagement optimieren, werden konfliktärmere, stärker bestätigende Inhalte begünstigt. Das kann zu Echo‑Effekten führen und die Sichtbarkeit von Randthemen reduzieren. Für Qualitätsmedien besteht die Gefahr, dass Zusammenfassungen und KI‑Overviews Traffic entziehen und damit Einnahmen schmälern.

Datenschutz ist ein weiteres Spannungsfeld. In Europa regelt die DSGVO die Nutzung personenbezogener Daten; jüngere Leitlinien der Datenschutzbehörden betonen, dass Modelle und Trainingsdaten transparent dokumentiert werden müssen. Die EU‑Regelwerke (AI Act, DSA) ergänzen diese Normen: etwa durch Transparenzpflichten, Anforderungen an Risikoanalysen und das Recht auf nicht personalisierte Alternativen.

Rechtlich bleibt das Urheberrecht ein offenes Feld: Trainingsdaten für generative Modelle enthalten oft fremde Werke. Juristische Auseinandersetzungen und politische Initiativen zielen darauf ab, faire Lizenzmodelle und maschinenlesbare Opt‑outs zu schaffen. Solche Mechanismen würden die wirtschaftliche Basis vieler Medien sichern, ohne die Entwicklung von KI‑Anwendungen völlig zu blockieren.

Technisch helfen Maßnahmen wie Zufallsanteile in Feeds, Diversity‑Metriken oder menschliche Kuratierung, negative Effekte abzumildern. Wirtschaftlich und politisch sind jedoch klare Regeln und Vergütungsmodelle nötig, damit Vielfalt, faire Vergütung und Innovation zusammen bestehen können.

Blick nach vorn: Regulierungen, Geschäftsmodelle, Nutzerwahl

In Europa bilden AI Act, DSA und Datenschutzleitlinien bereits den Rahmen, der Personalisierung einschränkt und zugleich leiten soll. Der AI Act verbietet manipulatives Personalizing und fordert Risikobewertungen; die DSA verlangt Optionen für nicht‑personalisierte Feeds. Diese Regelungen zielen darauf ab, Transparenz, Wahlmöglichkeiten und Verantwortlichkeit zu stärken.

Geschäftsmodelle werden sich anpassen müssen. Möglich sind Lizenzmodelle für Trainingsdaten, Kompensationsmechanismen für Publisher und hybride Bezahlschranken, die Sichtbarkeit von Inhalten steuern. Plattformen könnten Tools anbieten, mit denen Nutzerinnen Feineinstellungen vornehmen: stärker redaktionell kuratierte Feeds, konservative Empfehlungen oder komplett nicht‑personalisierte Ansichten.

Aus technischer Sicht werden Fairness‑ und Diversity‑Messungen wichtiger. Entwicklerinnen und Entwickler müssen zeigen, wie Modelle trainiert wurden, welche Daten genutzt wurden und welche Maßnahmen zur Fehlerreduktion getroffen sind. Audits und Zertifizierungen könnten Vertrauensbestandteil werden. Gleichzeitig werden Open‑Standards für maschinenlesbare Opt‑outs und Metadaten an Bedeutung gewinnen.

Für Nutzerinnen lohnt sich kritische Auswahl: Wer Wert auf Vielfalt legt, kann Dienste mit transparenten Einstellungen bevorzugen oder nicht‑personalisierte Alternativen nutzen. Für Medien empfiehlt sich, Lizenzstrategien zu prüfen und Verhandlungsfähigkeit mit Plattformen auszubauen. Regulierer sollten prüfen, ob bestehende Instrumente ausreichen oder feingranularere Vorgaben nötig sind.

Fazit

Personalisierte Inhalte durch KI sind kein rein technisches Detail, sondern ein Gestaltungsfeld für Öffentlichkeit, Wirtschaft und Recht. Sie bieten vielen Nutzerinnen relevantere Erlebnisse und wirtschaftliche Chancen für Plattformen und Werbetreibende. Gleichzeitig verlangen sie Schutzmechanismen: Transparenz, Datenschutz, faire Vergütung von Urheberinnen sowie Optionen, die Vielfalt sichern. Europa setzt bereits Standards, aber die praktische Ausgestaltung bleibt eine Aufgabe für Politik, Industrie und Medien. Entscheidend wird sein, Techniknutzen mit öffentlichen Interessen dauerhaft in Einklang zu bringen.

Schreibe einen Kommentar