Transformer‑Sprachmodelle sind eine weitverbreitete Architektur für moderne KI‑Texterzeugung und -verstehen. In wenigen Worten: Sie nutzen Attention‑Mechanismen, um Wörter im Kontext miteinander zu gewichten, statt sie nur der Reihenfolge nach zu lesen. Das macht sie besonders gut geeignet für Aufgaben wie Autocomplete, Übersetzung und Chat‑Assistenten. Dieser Text erläutert die Grundidee, typische Anwendungen, Chancen und Risiken sowie die wichtigsten Entwicklungen, die auch in den kommenden Jahren relevant bleiben.

Einleitung

Viele Menschen nutzen täglich Funktionen, die von großen Sprachmodellen angetrieben werden, ohne genau zu wissen, wie diese Technik arbeitet. Beispiele sind automatische Vorschläge beim Schreiben, Antworten in Chat‑Assistenten oder maschinelle Übersetzung. Auf den ersten Blick wirken diese Dienste wie Zauberei: Ein kurzer Texteingabe reicht, und das System ergänzt oder formuliert ganze Sätze. Hinter dieser Bedienerfreundlichkeit steckt eine Kombination aus Statistiken, Rechenleistung und speziellen Netzwerkstrukturen. Die Herausforderung besteht darin, den Kern dieser Technik so zu beschreiben, dass die Hauptidee verständlich bleibt, ohne in technische Details zu verlieren. Dieser Text nimmt die grundlegende Architektur, typische Einsatzfelder, realistische Vorteile und mögliche Probleme in den Blick und ordnet ein, was Nutzerinnen und Nutzer daraus ableiten können.

Was sind Transformer‑Sprachmodelle?

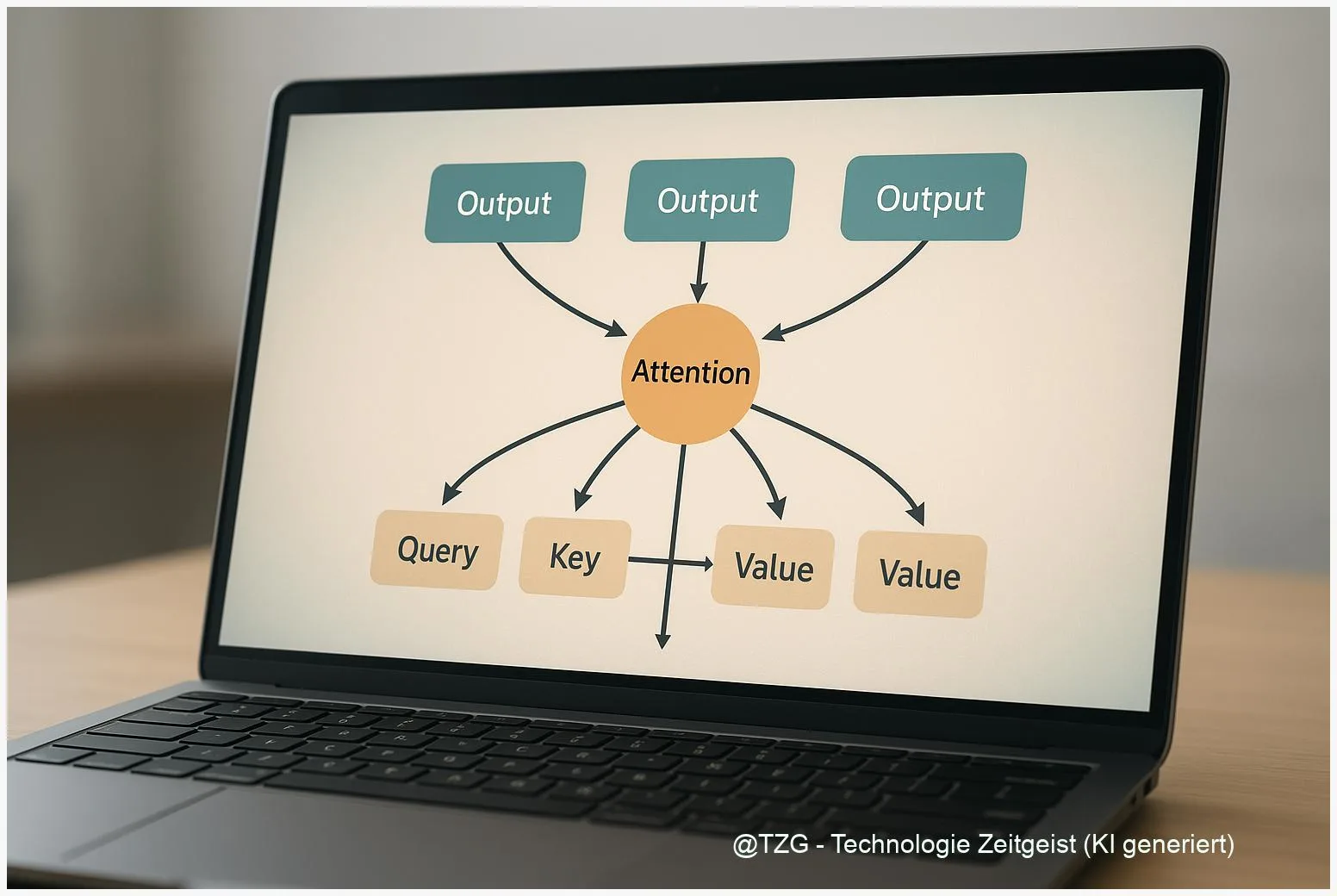

Ein Transformer ist eine besondere Form eines neuronalen Netzes, das vor allem auf sogenannten Attention‑Mechanismen beruht. Im Kern geht es darum, für jedes Wort (oder Token) zu bestimmen, wie stark es mit anderen Teilen des Textes in Beziehung steht. Anders als frühere Modelle, die Wörter Schritt für Schritt in Reihenfolge verarbeiteten, erlauben Transformer, viele Teile des Textes gleichzeitig zu betrachten. Das beschleunigt Training und verbessert die Fähigkeit, längere Zusammenhänge zu erfassen.

Aufmerksamkeit statt strenger Reihenfolge: Transformer gewichten Tokens zueinander, um Kontext zu bilden.

Wichtige Bausteine sind:

- Self‑Attention: Berechnet, wie stark jedes Token auf jedes andere Token im gleichen Satz oder Absatz reagiert.

- Multi‑Head Attention: Mehrere parallele Sichtweisen (Köpfe) erfassen verschiedene Aspekte des Kontexts zugleich.

- Positionskodierung: Da die Architektur Reihenfolge nicht automatisch kennt, werden Positionsinformation zu den Wortvektoren hinzugefügt.

Transformer lassen sich in drei Grundtypen einordnen, die für unterschiedliche Aufgaben genutzt werden:

| Modelltyp | Aufgabentyp | Beispiele |

|---|---|---|

| Encoder‑only | Textverständnis | Textklassifikation, Fragebeantwortung |

| Decoder‑only | Textgenerierung | Autocomplete, Chat‑Antworten |

| Encoder‑Decoder | Seq2Seq | Übersetzung, Zusammenfassung |

Das ursprüngliche Transformer‑Design wurde 2017 publiziert; die Idee ist damit bereits älter als zwei Jahre und bildet trotzdem die Basis zahlreicher heutiger Systeme. Die grundlegende Formel hinter Attention ist technisch präzise, für das Verständnis reicht aber das Bild, dass das Modell ständig gewichtet, welche Wörter für eine Antwort relevant sind.

Wie erscheinen sie im Alltag?

Im Alltag merkt man Transformer‑Technik oft nur indirekt: Autovervollständigung beim Tippen, Vorschläge in Suchmaschinen, automatische E‑Mail‑Formulierungen oder Chatbots auf Websites. In der Praxis läuft dabei meistens zweierlei ab: Ein größeres Modell erzeugt mögliche Antworten auf Basis von Wahrscheinlichkeiten, und weitere Komponenten prüfen oder ergänzen diese Rohantworten.

Ein einfaches Beispiel: Beim Schreiben einer Nachricht schlägt die Tastatur eine mögliche Fortsetzung vor. Das Modell hat gelernt, welche Wortfolgen in ähnlichen Kontexten wahrscheinlich sind, und zeigt Vorschläge mit hoher Wahrscheinlichkeit. Bei komplexeren Diensten, etwa einem Chat‑Assistenten, werden zusätzlich Regeln oder externe Wissensquellen herangezogen, damit Antworten faktentreuer oder aktueller werden.

Auch automatische Übersetzung profitiert: Statt Wort‑für‑Wort‑Ersetzungen berücksichtigen moderne Systeme den Gesamtzusammenhang eines Satzes. Das reduziert Fehler bei Ausdrücken und Mehrdeutigkeiten. Bei Anwendungen wie Inhaltsmoderation oder Zusammenfassung kombinieren Anbieter oft mehrere Modelle, um eine Aufgabe robuster zu lösen.

Wichtig zu wissen ist, dass Modelle zwar oft flüssige, plausibel klingende Texte erzeugen, sie aber nicht über Pflichtbewusstsein oder Faktensicherheit verfügen. Sie berechnen Wahrscheinlichkeiten für Wortfolgen, nicht Wahrheitswerte. Deshalb können Antworten überzeugend klingen und trotzdem falsch sein.

Chancen und Risiken

Transformer‑Sprachmodelle bieten mehrere praktische Vorteile: Sie machen Spracheingaben natürlicher, helfen beim Schreiben, unterstützen Übersetzung und barrierefreie Zugänge zu Informationen. Für Unternehmen ermöglichen sie Automatisierung bei Kundendialogen oder Zusammenfassungen von langen Texten.

Gleichzeitig entstehen reale Risiken. Ein zentrales Problem ist die sogenannte Halluzination: Modelle können unsinnig klingende oder faktisch falsche Aussagen erzeugen. Ein weiteres Thema ist Verzerrung (Bias), weil Trainingsdaten gesellschaftliche Vorurteile enthalten können. Darüber hinaus sind Trainings und Betrieb großer Modelle ressourcenintensiv: Rechenleistung, Energieverbrauch und damit verbundene Umweltkosten steigen mit Modellgröße.

Ein dritter Bereich betrifft Privatsphäre und Datenqualität. Wenn Modelle mit großen Mengen öffentlich verfügbarer Texte trainiert werden, können sensible oder private Informationen indirekt reproduziert werden. Deshalb sind Datenfilterung, Prüfmechanismen und klare Nutzungsregeln wichtige Begleitmaßnahmen.

Technisch gibt es Antworten auf einige Probleme: Effizienztechniken wie Sparse‑Attention reduzieren Rechenkosten für sehr lange Texte, und Retrieval‑gestützte Systeme verbinden Modellantworten mit geprüften Quellen. Gleichzeitig bleiben viele Fragen offen, etwa wie Modelle besser kalibriert werden können, damit sie Unsicherheiten anzeigen statt feste Antworten zu liefern.

Blick nach vorn: Entwicklungen und Auswirkungen

In den kommenden Jahren dürften drei Trends besonders sichtbar werden. Erstens: Effizienzsteigerung. Forschung an sparsamerer Attention, Komprimierung und spezialisierten Architekturen zielt darauf ab, ähnliche Leistungen mit deutlich weniger Ressourcen zu erzielen. Zweitens: Integration mit externen Wissensquellen. Kombinationen aus großen Sprachmodellen und Datenbanken oder Suchlösungen verbessern die Faktentreue und Aktualität von Antworten. Drittens: Multimodalität. Modelle, die Text, Bild und Ton gleichzeitig verarbeiten, erweitern Nutzungsszenarien, zum Beispiel bei Assistenzsystemen oder barrierefreien Diensten.

Auf gesellschaftlicher Ebene sind Transparenz und Regulierung relevante Aspekte. Nutzerinnen und Nutzer profitieren, wenn Systeme klar kennzeichnen, woher ein Ergebnis stammt und wie sicher es ist. Anbieter wiederum müssen technische und organisatorische Maßnahmen ergreifen, um Missbrauch zu vermeiden und die Privatsphäre zu schützen.

Für Personen, die mit solchen Technologien arbeiten oder sie nutzen, entsteht eine einfache Erwartung: Kritisches Prüfen statt blinder Übernahme. Wenn eine Antwort wichtig ist — medizinisch, rechtlich oder finanziell — empfiehlt es sich, die Information mit unabhängigen, verlässlichen Quellen abzugleichen. Das ist weniger eine Anweisung als eine sinnvolle Gewohnheit, die die Vorteile der Technik sichert und gleichzeitig Risiken mindert.

Fazit

Transformer‑Sprachmodelle sind eine technisch elegante Lösung, weil sie Kontext dynamisch gewichten und dadurch Texte besser verstehen und erzeugen können als viele frühere Ansätze. Ihre Stärke liegt in der Vielseitigkeit: Sie sind Bausteine für Übersetzung, Generierung, Zusammenfassung und mehr. Gleichzeitig sind sie keine verlässliche Quelle per se; Fragen der Datenqualität, des Energiebedarfs und möglicher Verzerrungen bleiben relevant. Wer diese Technik nutzt oder begegnet, gewinnt, wenn er das Potenzial kennt und zugleich eine gesunde Skepsis wahrt — besonders bei wichtigen Entscheidungen, die auf Modellantworten beruhen.

Schreibe einen Kommentar