Schlagwort: XAI

-

Black-Box-KI verstehen: Warum Transparenz bei KI-Entscheidungen zählt

Black-Box-KI taucht in vielen Alltagssystemen auf: von Kreditentscheidungen bis zu automatischer Inhaltsmoderation. In diesem Text steht das Thema Transparenz im Mittelpunkt: warum nachvollziehbare Entscheidungen wichtig

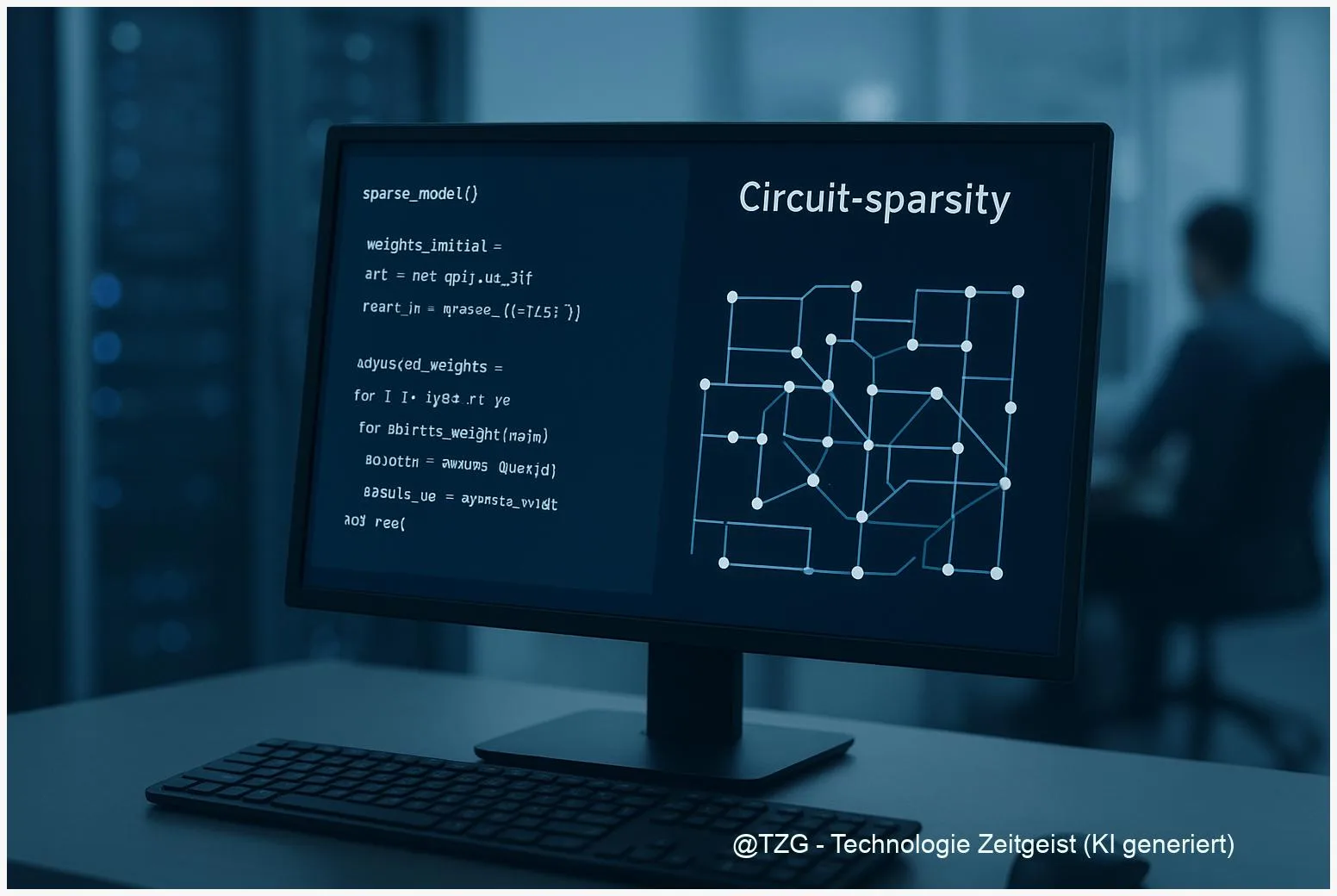

Circuit‑sparsity: Wie sparsames Training KI‑Modelle erklärbarer macht

Zuletzt aktualisiert: 14. December 2025 Berlin, 14. December 2025 Insights Circuit‑sparsity beschreibt ein Trainingsprinzip, bei dem ein Modell so viele Gewichte wie möglich auf null

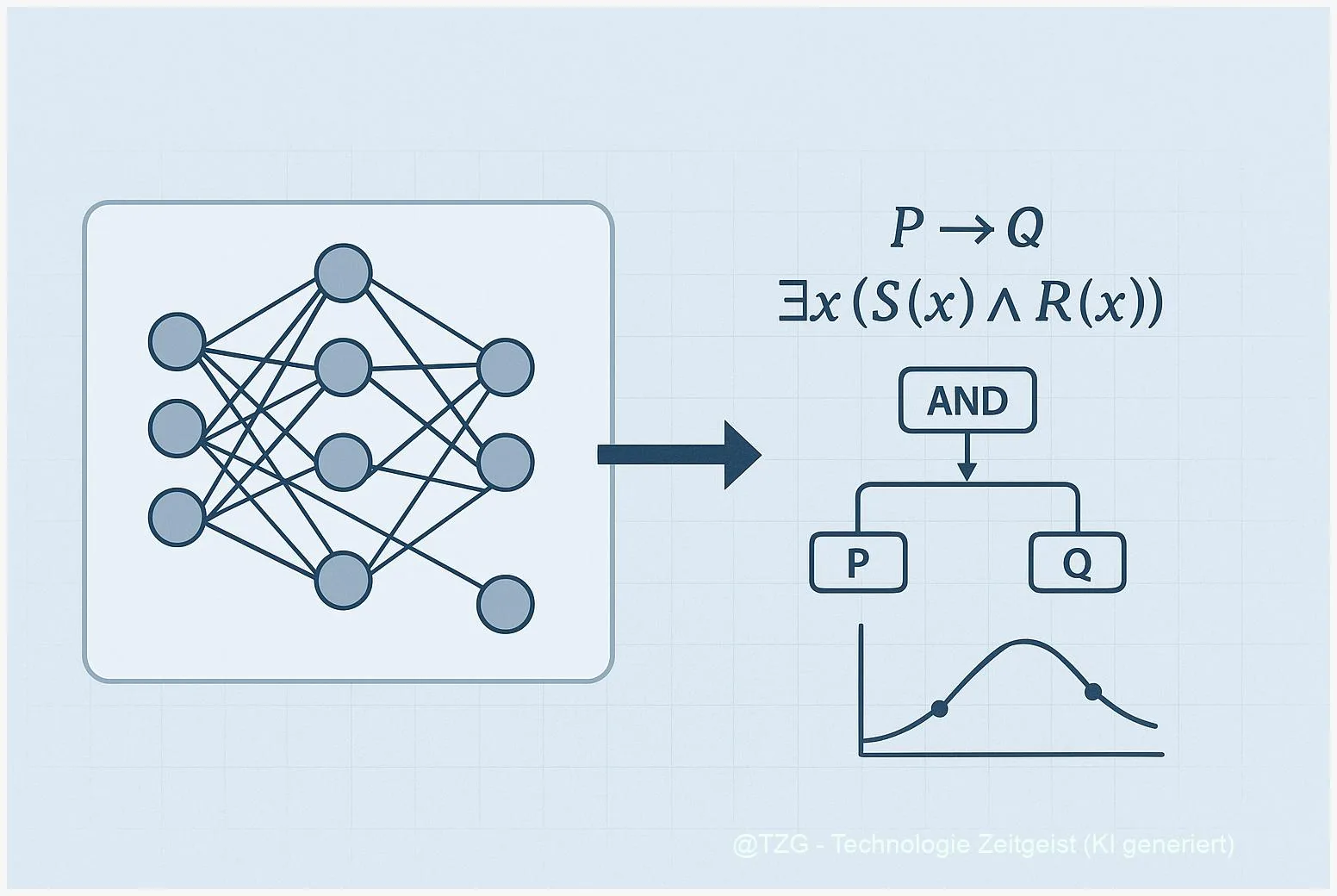

Neuro‑symbolische KI: Wie Lernen und Logik zusammenspielen

Neuro‑symbolische KI kombiniert neuronale Netze mit symbolischer Logik, um Lernen und strukturiertes Denken zu verbinden. Für viele Aufgaben – von visueller Erkennung bis zur Entscheidungsfindung

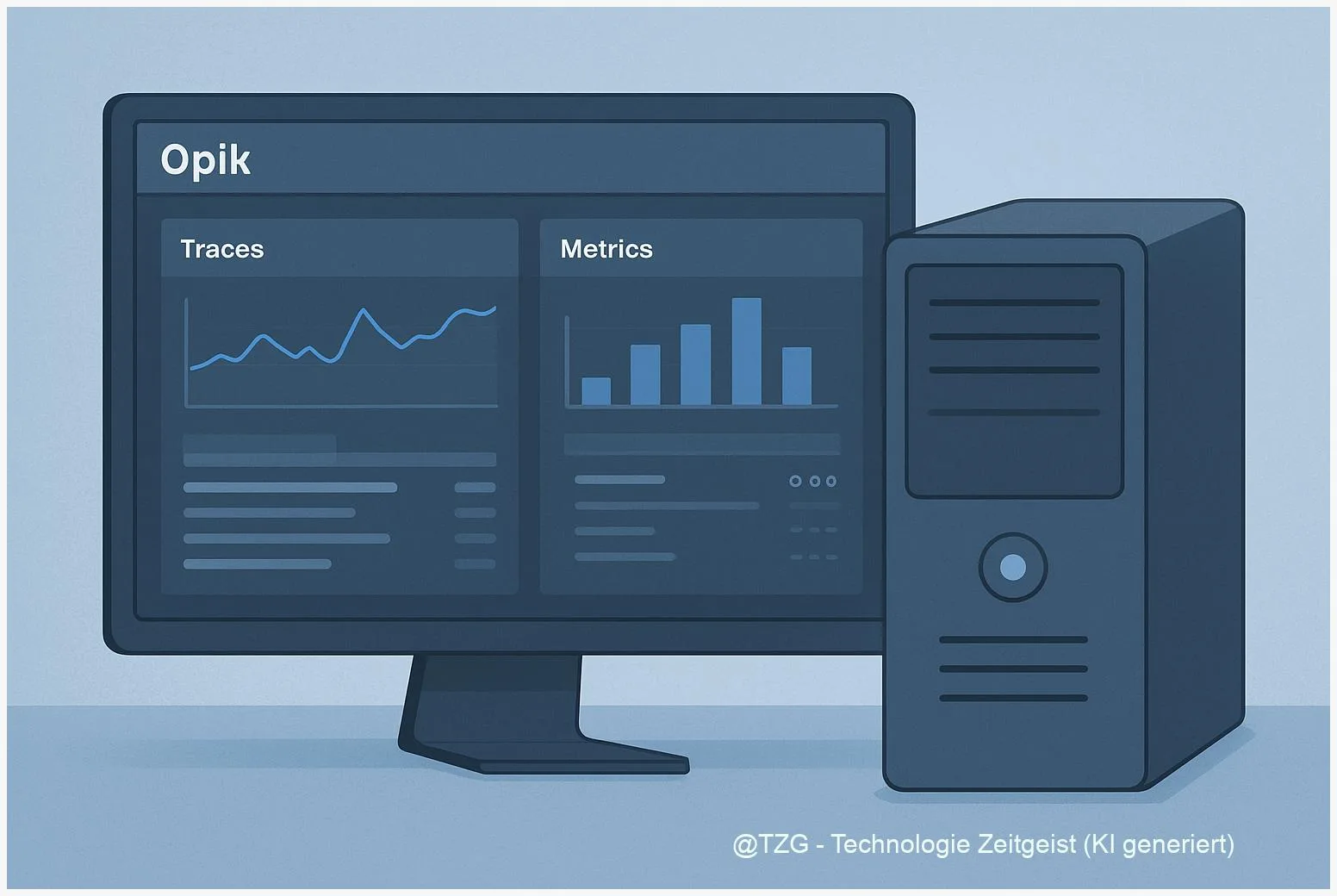

Transparente lokale LLM‑Pipelines mit Opik und Colocated Models

Zuletzt aktualisiert: 2025-11-22 Kurzfassung Opik local LLM pipeline ist heute ein pragmatischer Weg, um LLM‑Anwendungen lokal beobachtbar und reproduzierbar zu betreiben. Dieser Artikel zeigt, wie

Grok 4.1: Halluzinationsreduktion und EQ in der Conversational UX

Zuletzt aktualisiert: 2025-11-19 Kurzfassung Grok 4.1 bringt eine neue Balance zwischen Präzision und Einfühlungsvermögen. Dieser Text erklärt, wie Grok 4.1 conversational UX engineering einsetzt, um

Transparent AI Investing: Wie Firmen wie Vellius Modelle erklärbar und prüfbar machen

Zuletzt aktualisiert: 2025-11-17 Kurzfassung Transparent AI investing steht für die Forderung, dass Algorithmen im Finanzbereich erklärbar, nachvollziehbar und prüfbar sind. Dieser Text untersucht, wie Firmen

Bewertung neu gedacht: Prüfungen für KI‑native Klassen

Zuletzt aktualisiert: 2025-11-15 Kurzfassung Schulen stehen vor der Aufgabe, Bewertung neu zu denken: KI in der Bildung macht simple Reproduktionsaufgaben angreifbar und verschiebt, was Leistung

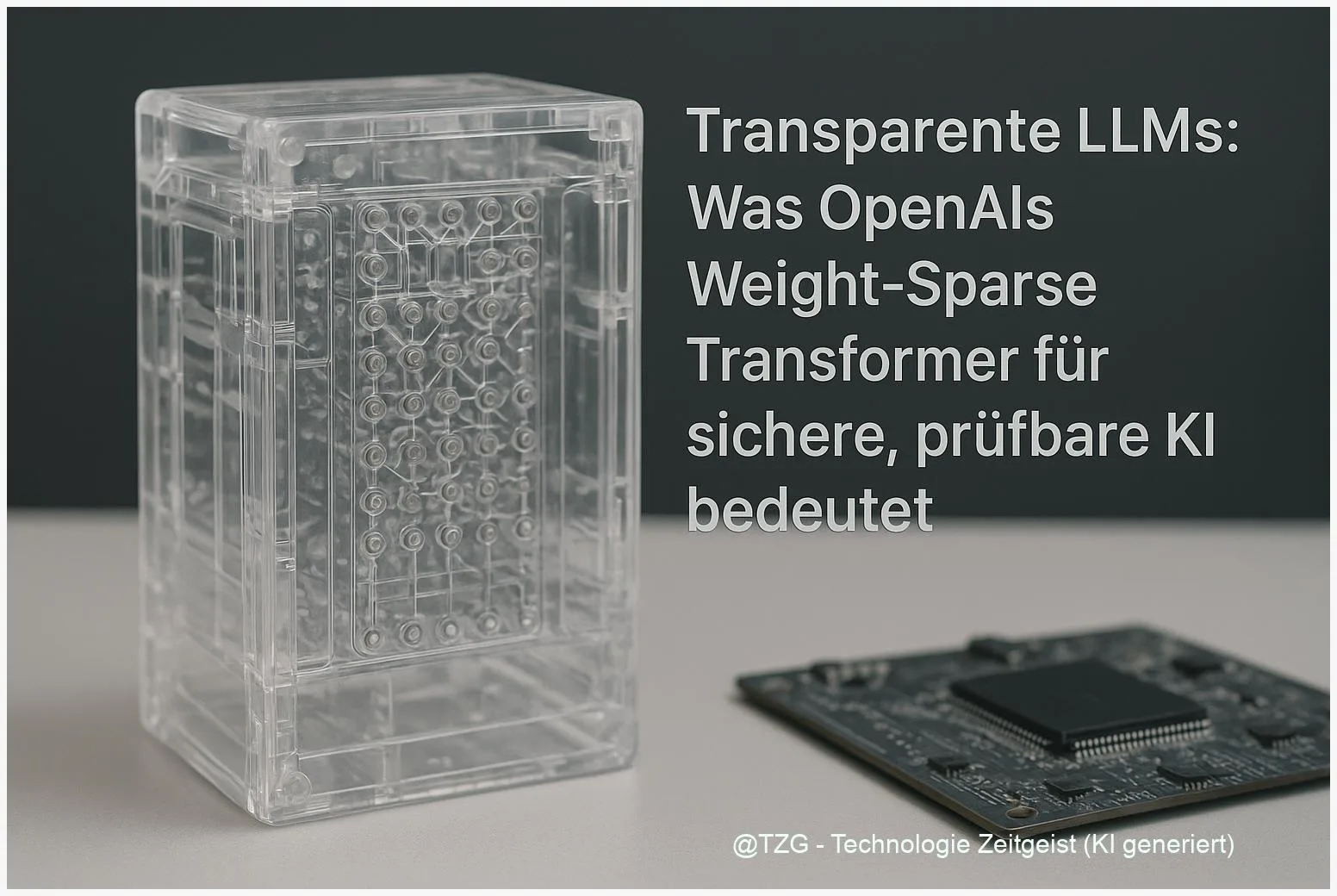

Transparente LLMs: Was OpenAIs Weight‑Sparse Transformer für sichere, prüfbare KI bedeutet

Zuletzt aktualisiert: 14. November 2025 Kurzfassung OpenAI zeigt: Ein weight‑sparse Training kann neuronale Schaltkreise sichtbar machen und so die weight-sparse transformer interpretability erhöhen. Der Ansatz

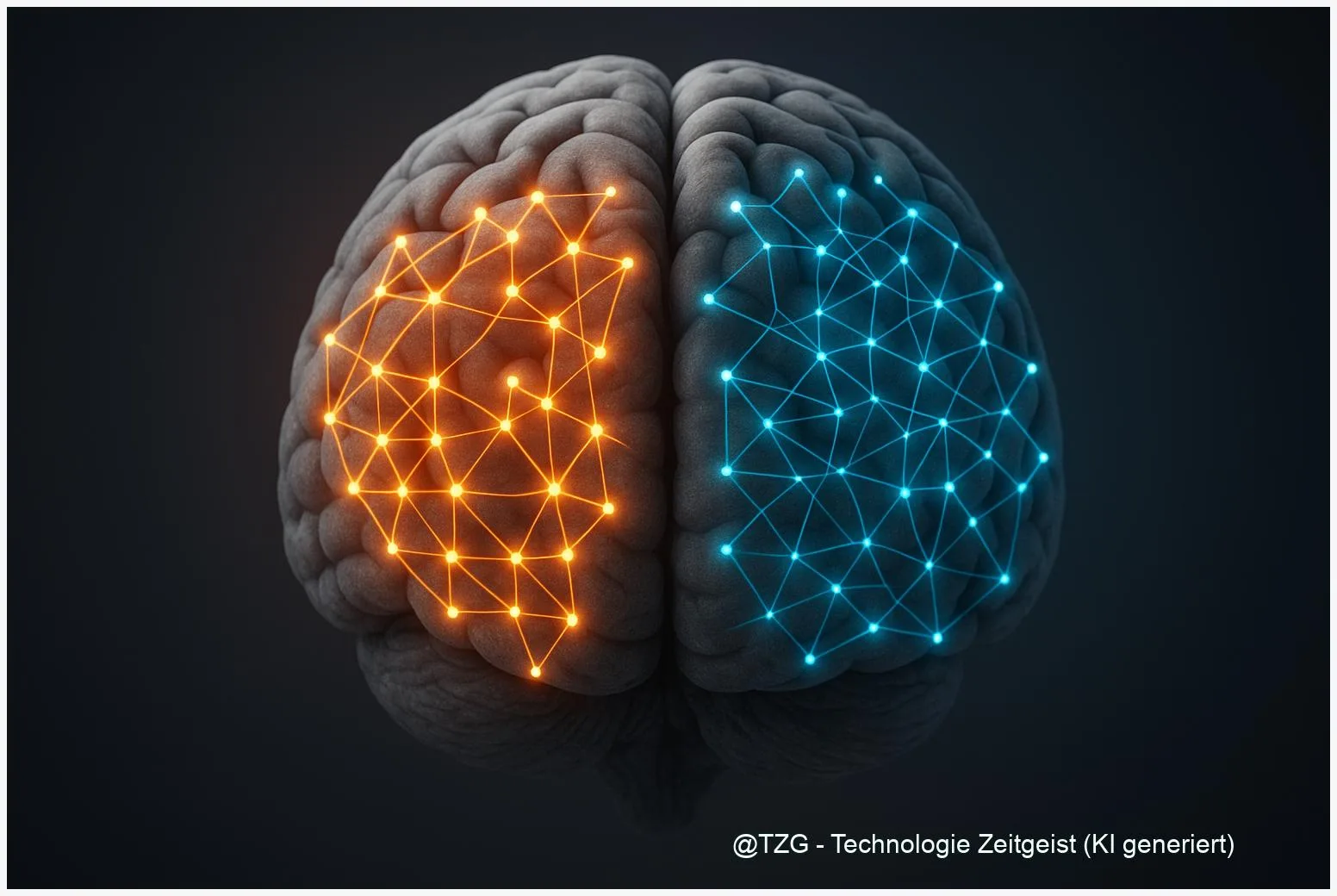

Memorization vs. Reasoning: Neural‑Pfade in LLMs verstehen

Zuletzt aktualisiert: 11. November 2025 Kurzfassung Forscher haben gezeigt, dass sich memorization vs reasoning neural pathways in modernen LLM‑Gewichten unterscheiden lassen. Die Goodfire‑Studie nutzt eine

Wie Recommendation Systems Stereotype verbergen — Auditleitfaden

Zuletzt aktualisiert: 11. November 2025 Kurzfassung Recommendation‑Systeme können Attribut‑Assoziationen so verbergen, dass Vorurteile über Nutzer:innen oder Inhalte kaum sichtbar bleiben. Dieser Praxisleitfaden erklärt, wie ein

Anthropic: Ein kompletter Guide zu „Emergent Introspective Awareness in Large Language Models“

Zuletzt aktualisiert: 30. Oktober 2025 Kurzfassung Anthropic hat im Frühjahr 2025 zentrale Arbeiten zur internen Struktur großer Sprachmodelle veröffentlicht — oft diskutiert unter dem Schlagwort

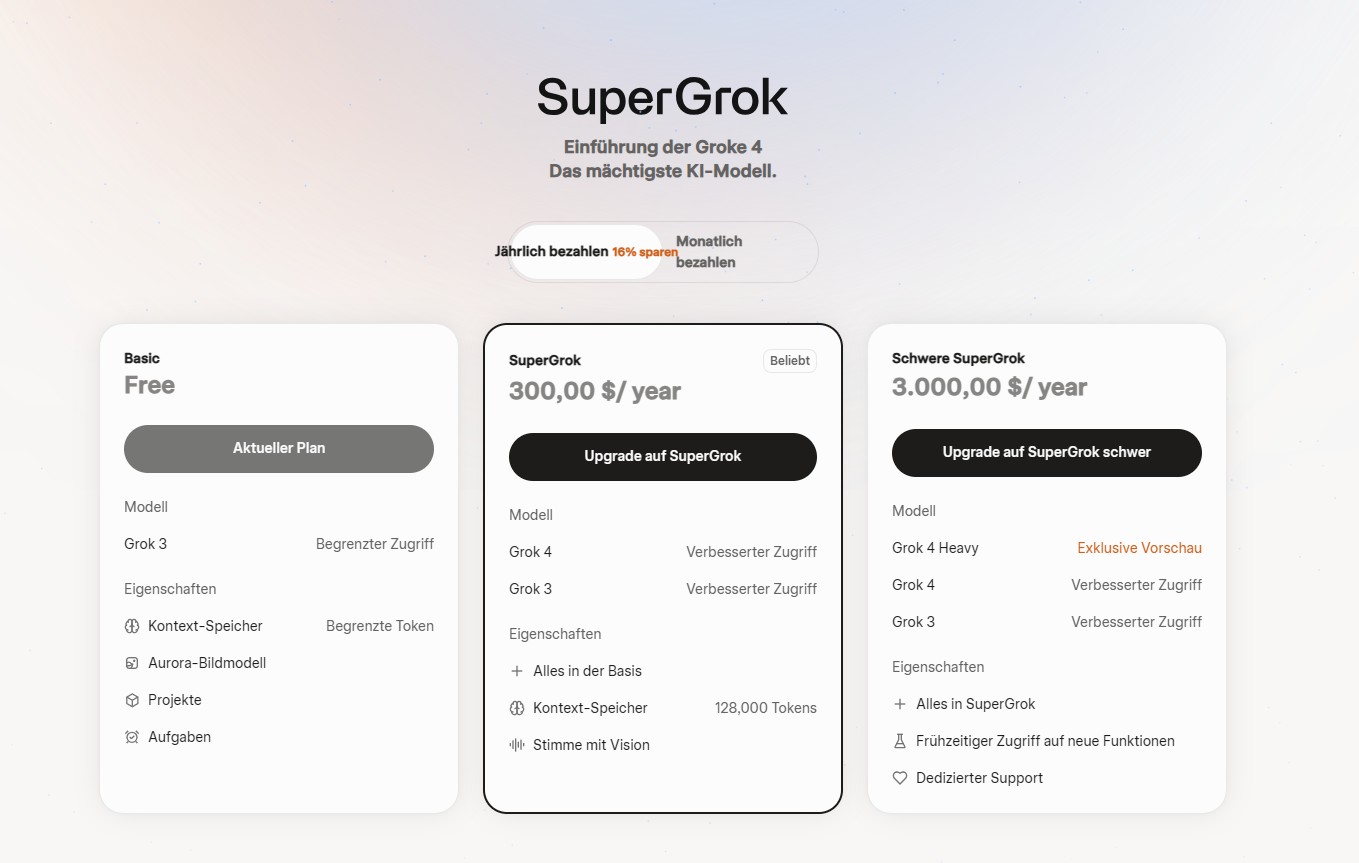

Grok 4 von xAI: Die nächste Evolutionsstufe künstlicher Intelligenz

Grok 4 von xAI ist da: Mit neuen Leistungsdaten, exklusiven Features und einem innovativen Preismodell greift Elon Musks KI direkt OpenAI und Google an. Alles