Schlagwort: LLM

-

Kleine KI‑Modelle: Reinforcement Learning macht On‑Device‑KI zuverlässiger

Kleine Sprachmodelle können direkte Antworten auf dem Smartphone liefern, ohne Daten an Server zu senden. Reinforcement Learning, speziell Reinforcement Learning from Human Feedback (RLHF), hilft,

Warum Open-Source-Modelle wie Qwen den KI-Markt 2026 prägen könnten

Open‑Source‑LLMs gewinnen an Gewicht: Projekte wie Qwen bieten Herstellern und Forschern Zugang zu Modellen, die lokal betrieben, angepasst und geprüft werden können. Für Anwenderinnen und

AI Gateways erklärt: Warum LLMs in Apps plötzlich Infrastruktur werden

Ein AI Gateway ist die zentrale Technik, die Anfragen an verschiedene große Sprachmodelle koordiniert und damit LLM‑Betrieb in Apps handhabbar macht. Das Stichwort AI Gateway

AI Slop: Warum das Internet mit KI‑Massencontent geflutet wird

Schätzungen zeigen, dass “AI Slop” — qualitativ schlechter, massenhaft erzeugter KI‑Content — heute einen spürbaren Anteil am Netz hat. Dieser Beitrag ordnet die Ursachen, typischen

Gefährliche KI in BI: Warum plausibel klingende Antworten trügen

KI in Business Intelligence kann Berichte, Erklärungen und Kennzahlen erzeugen, die plausibel klingen, aber fehlerhaft sind. Diese Kurzfassung skizziert, wie solche “plausibel falschen” Antworten entstehen,

Open‑Source für KI‑Sicherheit: Automatisierte Tests großer Sprachmodelle

Open-Source KI Evaluationsframeworks sind heute zentrale Werkzeuge, um das Verhalten großer Sprachmodelle systematisch zu prüfen. Sie verbinden wiederholbare Testpipelines, standardisierte Metriken und Automatisierung, damit Entwicklerinnen

Warum LLMs bei langen Texten langsamer werden – wie KV‑Caching hilft

Längere Texte führen bei großen Sprachmodellen oft zu spürbar langsameren Antwortzeiten, weil das Modell für jedes neue Wort bereits erzeugte Informationen wiederholt verarbeitet. KV‑Caching reduziert

Lokale KI auf dem iPhone: Wie AnywAIr Sprachmodelle offline nutzt

Lokale KI auf dem iPhone gewinnt an Bedeutung, weil sie Sprachverarbeitungsfunktionen ohne permanente Internetverbindung ermöglicht und so Datenschutz sowie Reaktionszeit verbessert. Apps wie AnywAIr laden

Beste KI‑Automationsplattformen 2026: Tools für smarte Workflows

In diesem Text geht es um KI-Automationsplattformen und darum, welche Tools 2026 für automatisierte Workflows am sinnvollsten sind. Unternehmen und Teams finden eine klare Einordnung:

Lokales LLM‑Fine‑Tuning: Unsloth & NVIDIA – Feintuning auf dem RTX‑PC

Lokales LLM fine‑tuning macht es möglich, Sprachmodelle direkt auf dem eigenen Rechner anzupassen — ohne Cloud‑Upload sensibler Daten. Dieser Beitrag erklärt praxisnah, wie Unsloth in Kombination

Nvidia wird Modellbauer: Was Nemotron 3 für KI und Europa bedeutet

Nemotron 3 steht für eine neue Modellfamilie von Nvidia, die lange Kontexte, sparsames Rechnen und offene Artefakte kombiniert. Für Europa bedeutet das zugleich Chancen bei

Warum generative KI ablenkt und prädiktive KI den Alltag verbessert

Generative KI erzeugt kreative Inhalte, zieht Aufmerksamkeit auf sich und ist oft fehleranfällig; prädiktive KI dagegen macht aus Daten konkrete Vorhersagen, die im Alltag nützlich

Circuit‑sparsity: Wie sparsames Training KI‑Modelle erklärbarer macht

Zuletzt aktualisiert: 14. December 2025 Berlin, 14. December 2025 Insights Circuit‑sparsity beschreibt ein Trainingsprinzip, bei dem ein Modell so viele Gewichte wie möglich auf null

Wenn KI Sprache so gut wie ein Mensch analysiert — was das bedeutet

KI Sprachverarbeitung steht heute an einem Punkt, an dem Maschinen Texte sehr menschlich erscheinen lassen können. Dieser Text zeigt, welche Fähigkeiten solche Systeme wirklich haben,

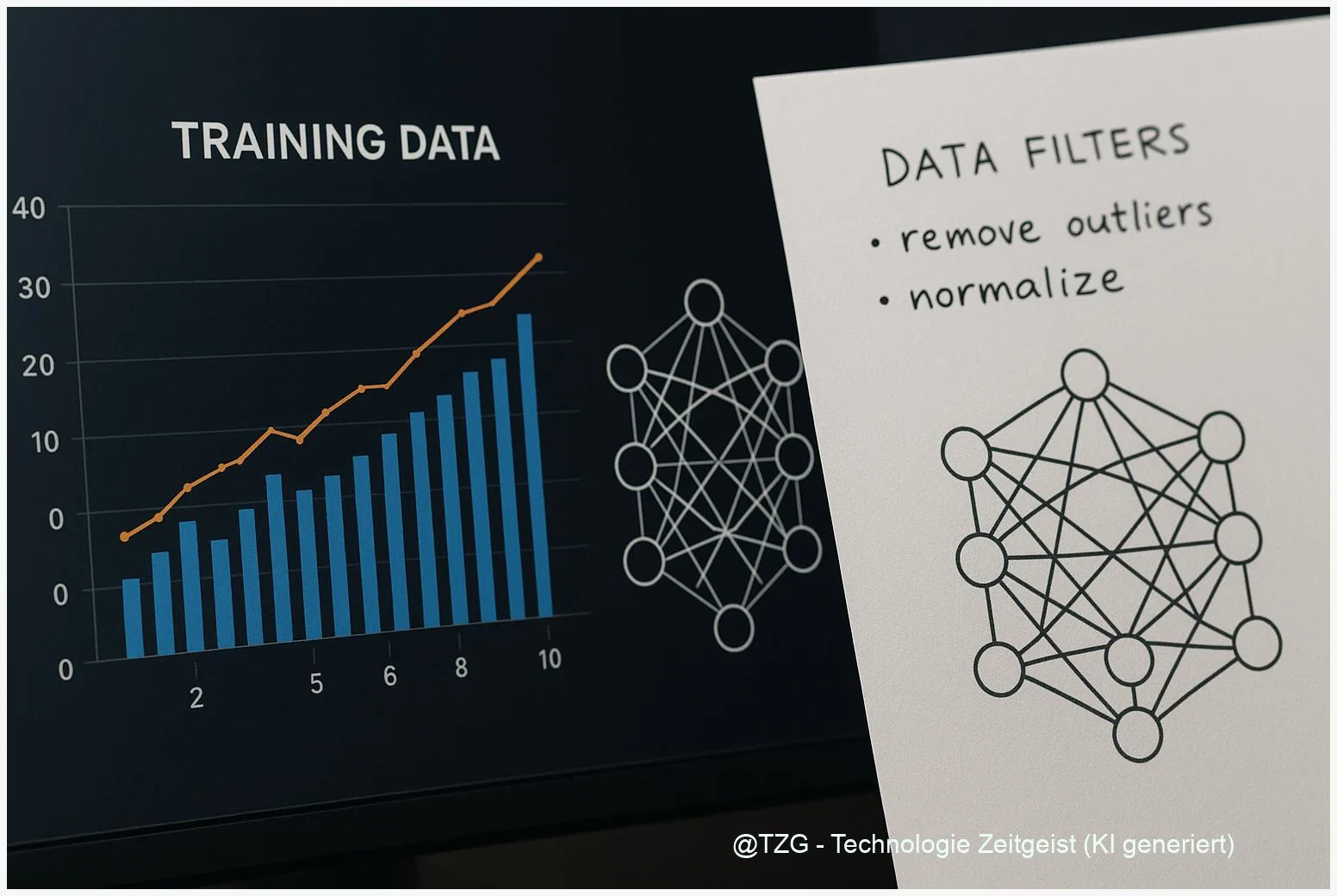

Kleine LLMs, große Leistung: Wie Daten‑Rezepte 3B‑Modelle stärken

Modelle mit nur wenigen Milliarden Parametern können überraschend viel leisten, wenn die Trainingsdaten stimmen. Dieses Stück zeigt, wie datenzentrierte Trainingsrezepte kleine Sprachmodelle konkret stärken und