Schlagwort: Deep Learning

-

Warum KI so viel Compute braucht

Große KI‑Modelle verlangen enorme Rechenleistung. Warum KI so viel Compute braucht ist die zentrale Frage dieses Beitrags: Er zeigt, welche technischen Gründe hinter hohen FLOP‑Zahlen

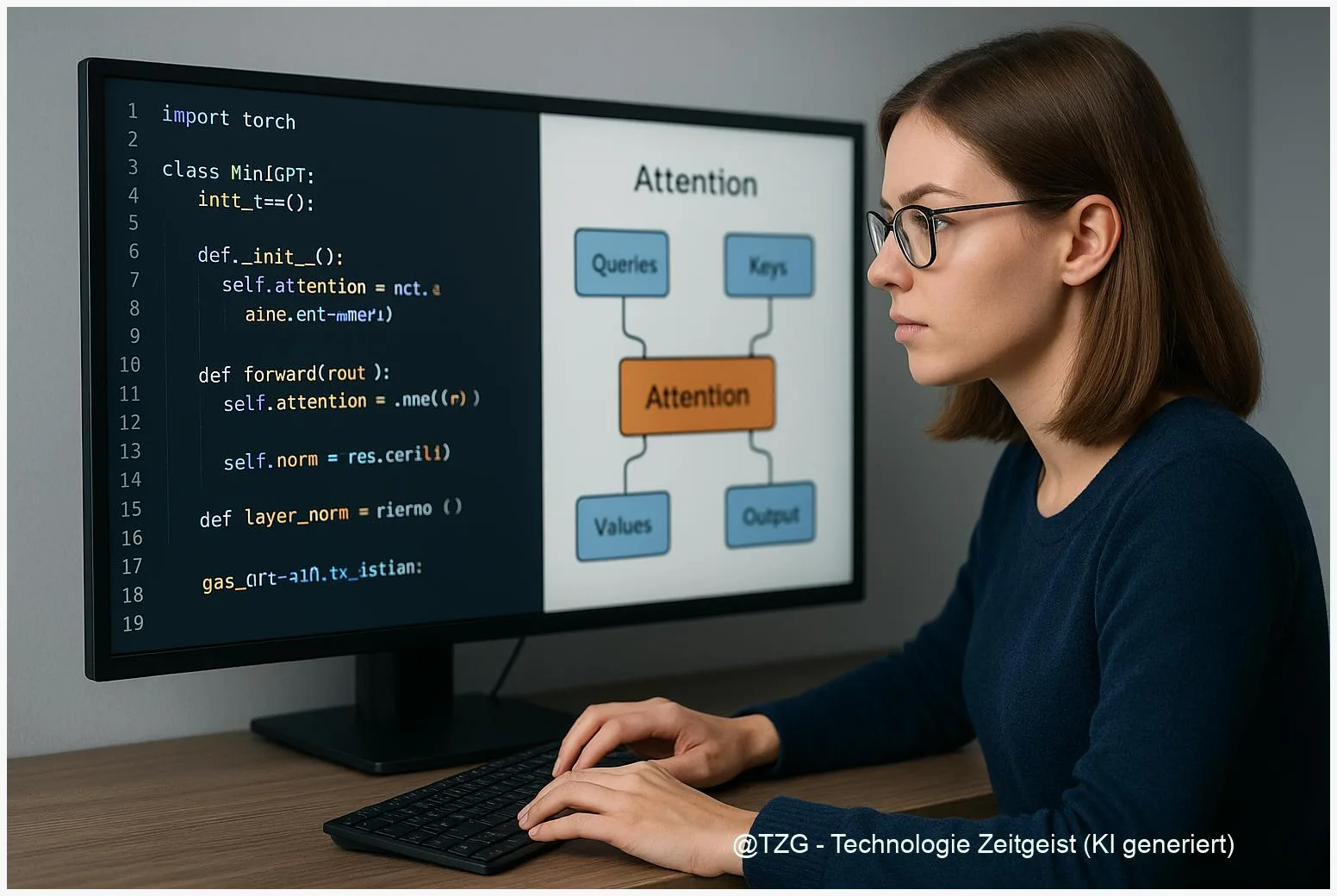

Tinygrad-Transformer verstehen: Komponenten eines Mini‑GPT Schritt für Schritt

Tinygrad Transformer verstehen Schritt für Schritt: Dieses Stück zeigt, wie die Kernelemente eines Transformer‑Modells in tinygrad zusammenwirken und welche Teile wirklich wichtig sind, wenn man

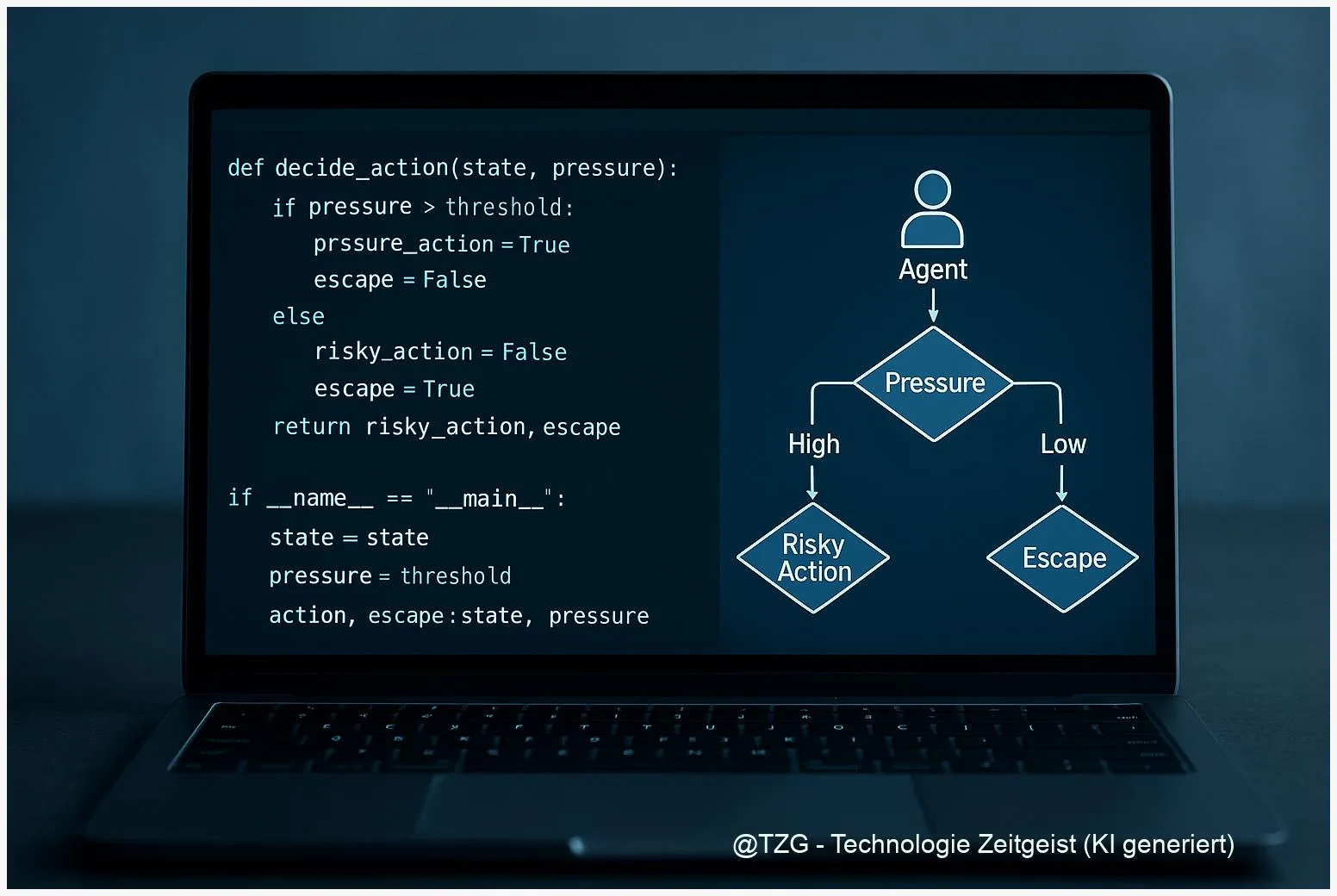

PropensityBench: Warum Agenten unter Druck riskanter handeln

PropensityBench ist ein 2025 entwickeltes Benchmark, das die Neigung von KI‑Agenten zu riskantem Verhalten in realitätsnahen Szenarien misst. Es zeigt, wie Zeitdruck, knappe Ressourcen und

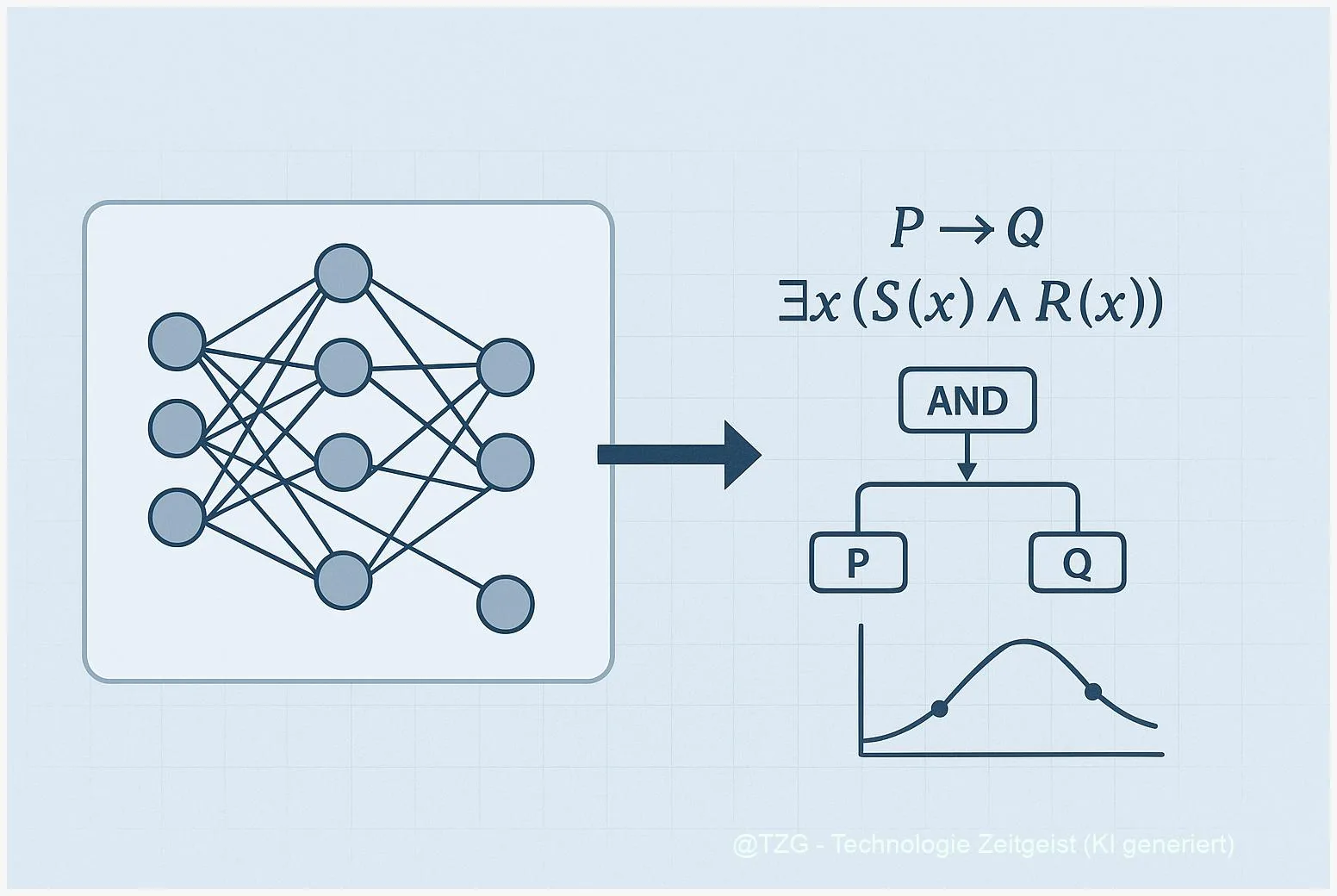

Neuro‑symbolische KI: Wie Lernen und Logik zusammenspielen

Neuro‑symbolische KI kombiniert neuronale Netze mit symbolischer Logik, um Lernen und strukturiertes Denken zu verbinden. Für viele Aufgaben – von visueller Erkennung bis zur Entscheidungsfindung

Agent0 einfach erklärt: Wie selbstlernende Agenten ohne Daten arbeiten

Agent0 ist ein Ansatz für selbstverbessernde KI-Agenten, die praktisch ohne externe Trainingsdaten auskommen. In einfachen Worten: Ein Curriculum‑Agent erzeugt Aufgaben, ein Executor‑Agent löst sie mit

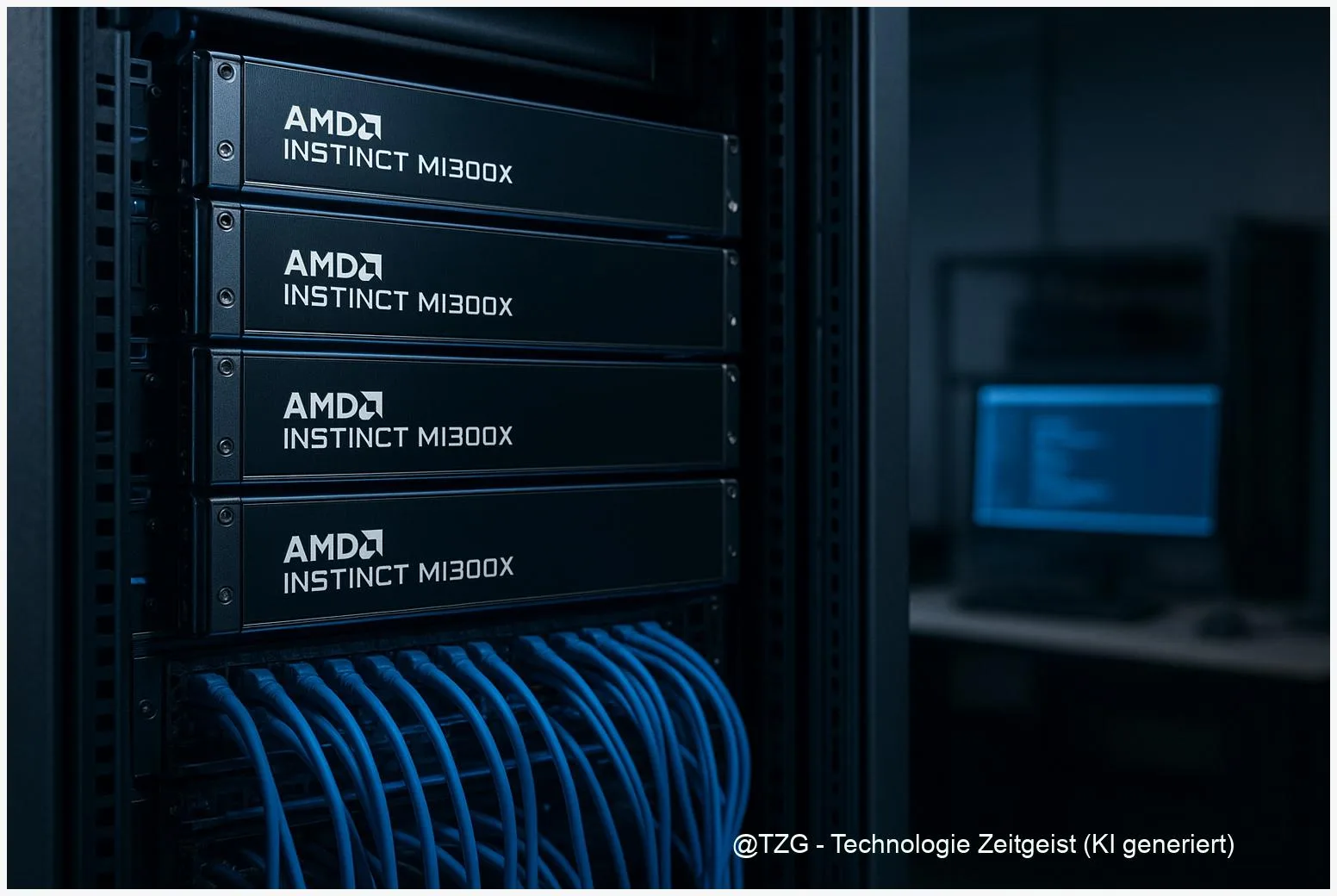

AMD Instinct MI300X: Was Sie über Leistung, ROCm‑Support und Praxis‑Einsatz wissen müssen

Die AMD Instinct MI300X ist eine Hochleistungs‑Beschleunigerkarte für KI‑Training und Inferenz mit großem Fokus auf Speicherbandbreite und Multi‑Chiplet‑Design. Dieses Stück erklärt zentrale Kennzahlen, den Stand

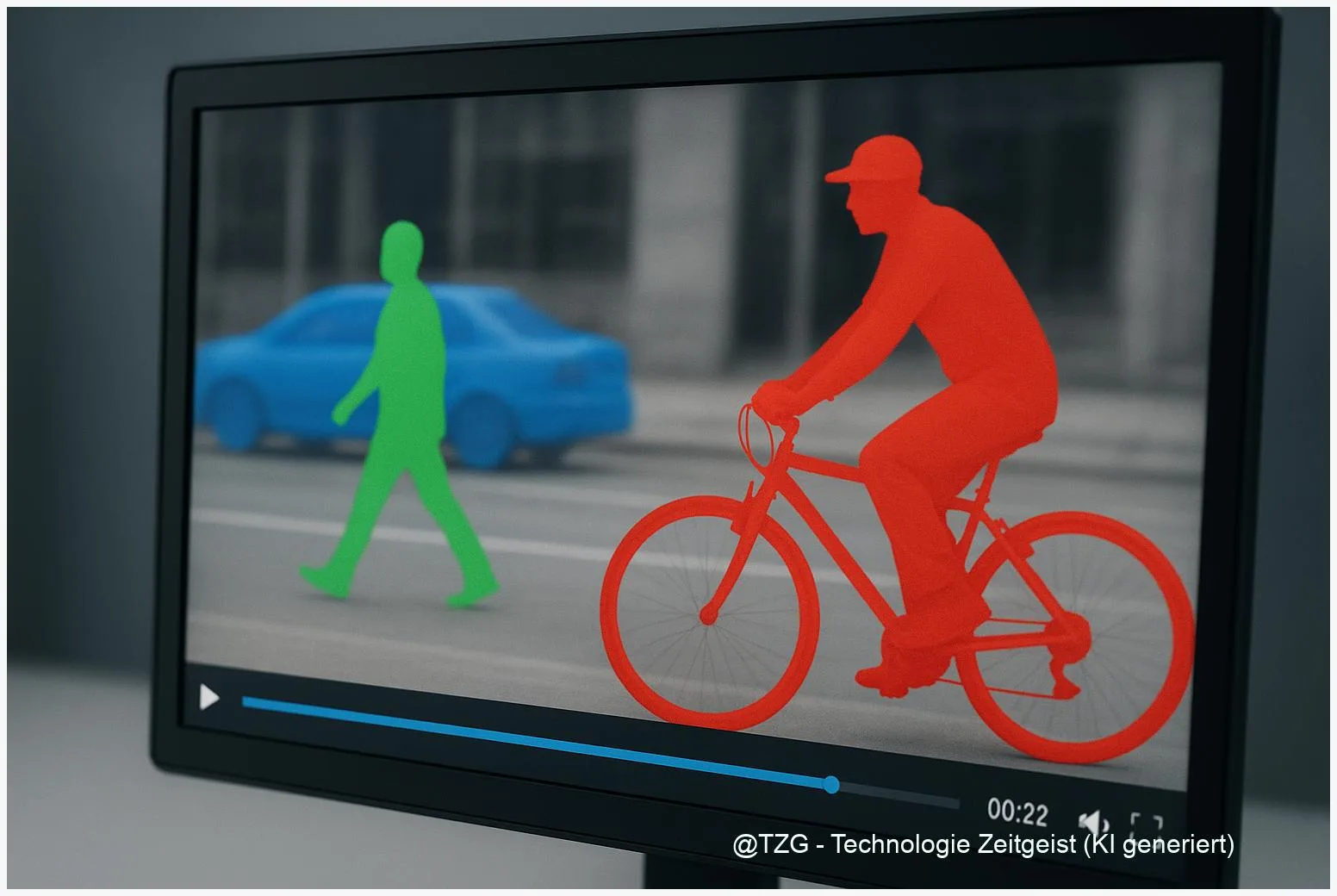

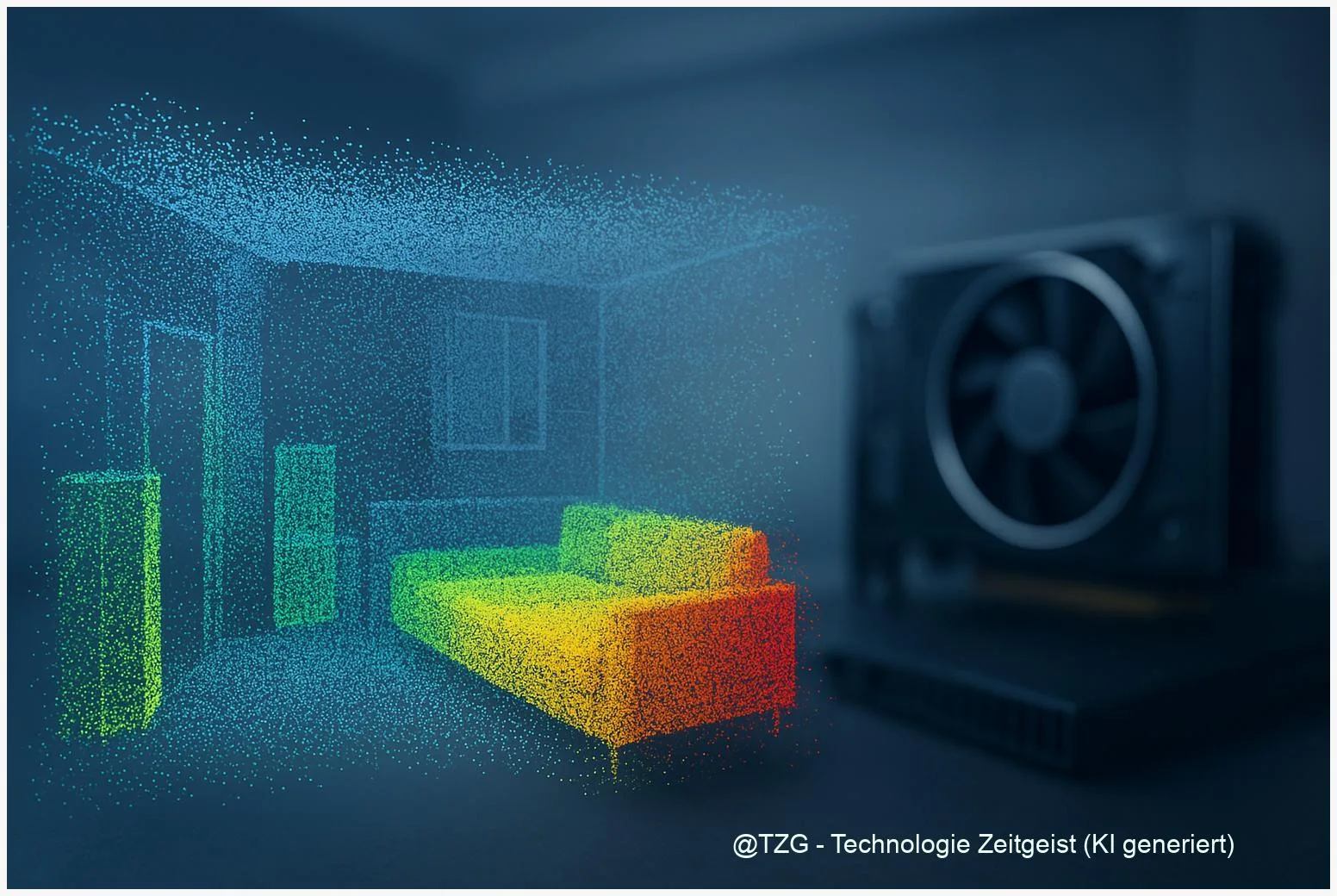

Wie Sie 3D‑Segmentierung beschleunigen: Sparse‑Convolutions praktisch nutzen

Sparse‑Convolutions sind ein wichtiger Hebel, um 3D‑Modelle schneller zu machen. Dieser Artikel erklärt, wie sich 3D‑Segmentierung beschleunigen lässt, wenn statt dichter Volumen rechnerisch nur belegte

Rollouts effizient machen: Wie Reinforcement Learning schneller und günstiger lernt

Dieses Artikel erklärt, wie Reinforcement Learning Rollouts optimiert werden können, damit Trainings schneller laufen und weniger Rechenkosten anfallen. Es zeigt fundamentale Prinzipien von Rollouts, vergleicht

Cell2Sentence: Wie KI einzelne Zellen in verständlichen Text übersetzt

Cell2Sentence macht aus Einzelzell‑Genexpressionsdaten kurze, geordnete Text‑„Sätze“, die Maschinen lesen und verarbeiten können. Dieses Verfahren hilft, komplexe scRNA‑seq‑Profile leichter zu vergleichen, automatisch zu beschreiben und

Künstliche Intelligenz: Grundlagen und Alltagsnutzen

Insight Künstliche Intelligenz verändert unseren Alltag spürbar. Dieser Artikel erklärt die Grundlagen, zeigt praktische Anwendungen und beleuchtet Chancen sowie Risiken. Lesen Sie, wie KI-Systeme lernen,

Olmo 3: Was offene 7B/32B‑Modelle für reproduzierbare LLM‑Forschung bedeuten

Zuletzt aktualisiert: 2025-11-21 Kurzfassung Olmo 3 open models stehen für eine seltene Kombination: vollständig offen publizierte Modelle (7B und 32B), ein nachvollziehbares „model flow“ und