Schlagwort: Deep Learning

-

5 KI‑Architekturen, die du verstehen solltest

Fünf grundlegende KI‑Architekturen prägen heute Forschung und Produkte: dichte Transformer‑Modelle (LLM), Vision‑Language‑Modelle, Mixture‑of‑Experts, große Aktionsmodelle und kompakte Modelle für Geräte. Wer sich mit KI beschäftigt,

KI‑Grundlagen verständlich: Wie Sprachmodelle arbeiten und was zählt

KI Grundlagen sind der Schlüssel, um zu verstehen, warum Sprachassistenten so plausibel wirken und welche Folgen das hat. In diesem Text erfahren Sie in kompakten

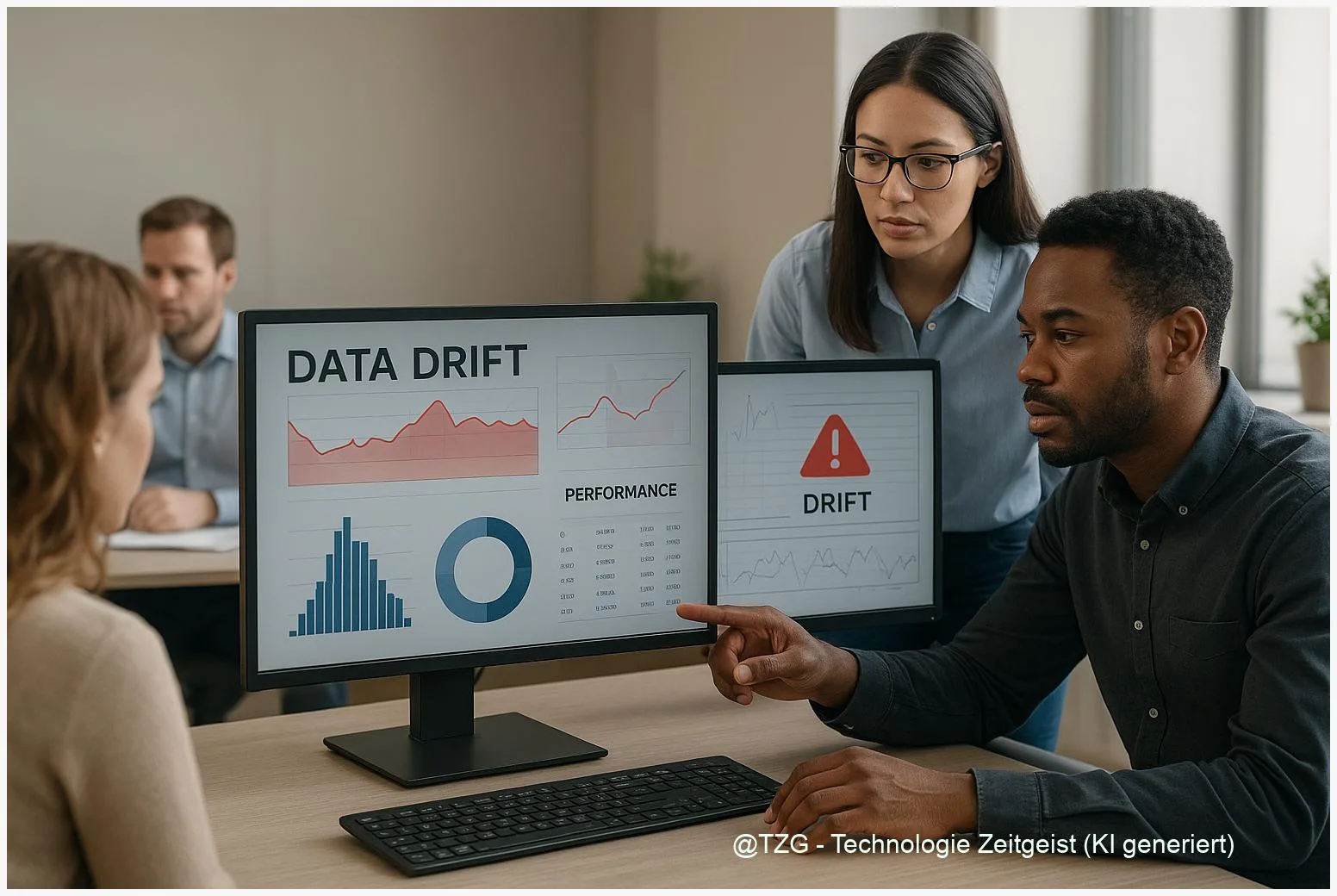

Wie man Daten‑Drift erkennt: Datenqualität für KI im Betrieb

Datenqualität für KI entscheidet im Betrieb oft darüber, ob Vorhersagen verlässlich bleiben. Dieses Kurzportrait erklärt, warum Daten‑ und Konzept‑Drift auftreten, wie gängige Erkennungsverfahren funktionieren und

V‑JEPA: Wie KI aus Videos physikalische Intuition lernt

V‑JEPA ist ein Ansatz, bei dem ein Modell aus reinen Videoaufnahmen lernt, Bewegungen und Zusammenhänge vorherzusagen. Das zentrale Ziel ist, latente Repräsentationen so zu trainieren,

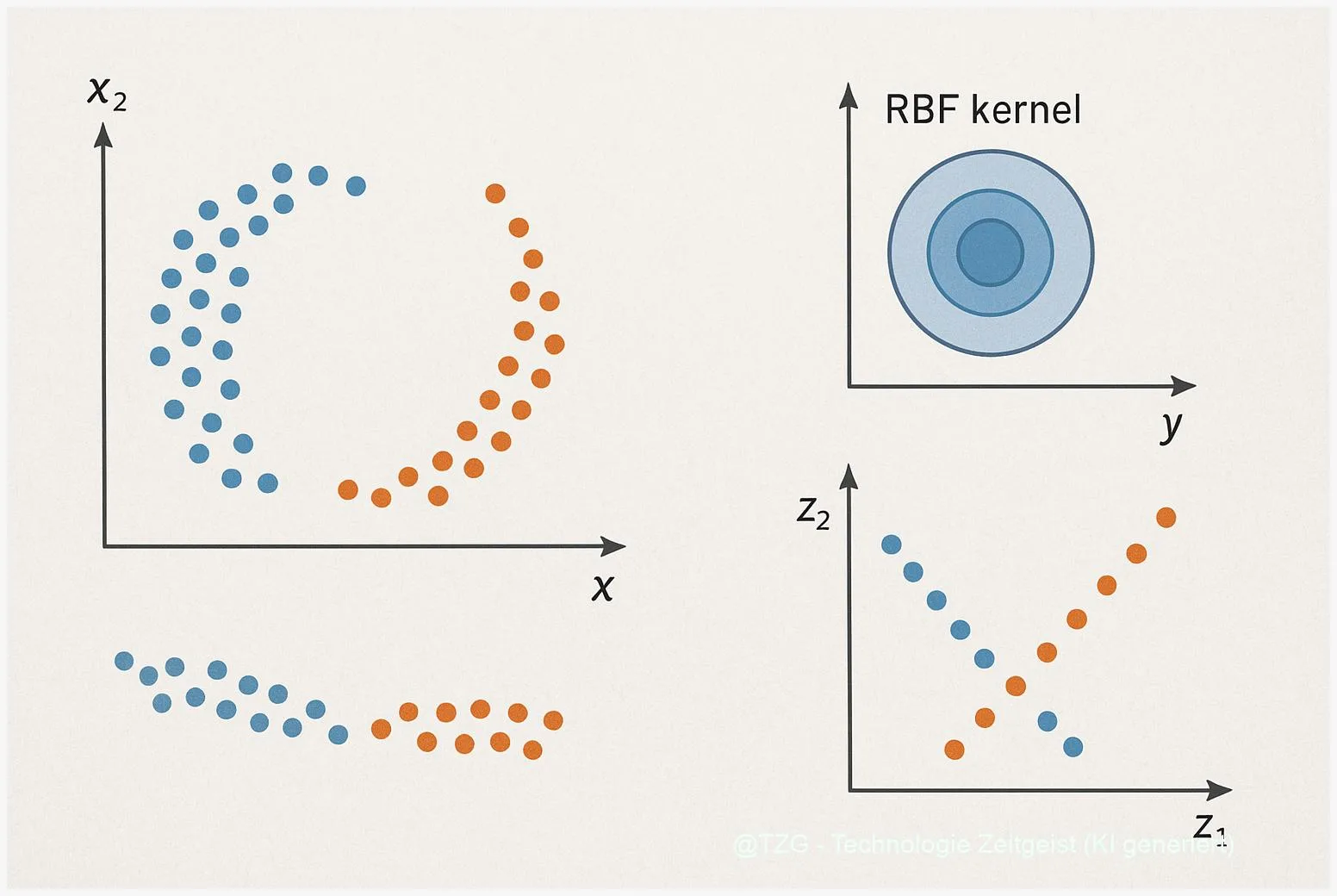

Kernel PCA einfach erklärt: Wie nichtlineare Strukturen sichtbar werden

Kernel PCA ist eine Methode zur nichtlinearen Dimensionsreduktion, die mit Hilfe einer Kernel‑Funktion komplexe Muster sichtbar macht. In einfachen Worten nutzt Kernel PCA Ähnlichkeiten zwischen

Open‑vocabulary Objekterkennung: Wie Vision‑Language‑Modelle Formen sehen, nennen und übertragen

Open‑vocabulary Objekterkennung verbindet Bildverstehen mit Sprache: Modelle lernen aus Bild‑Text‑Paaren, erkennen Objekte auch jenseits vordefinierter Klassen und reagieren auf freie Textanfragen. Für Anwender bedeutet das:

AlphaFold erklärt: Wie KI Proteinstrukturen vorhersagt

AlphaFold ist ein KI‑gestütztes System zur Proteinstruktur‑Vorhersage, das Forscherinnen und Forschern hilft, die Form von Eiweißen ohne aufwendige Versuchsaufbauten einzuschätzen. Die Vorhersagen liefern per‑Residue‑Konfidenz und

Mistral 3 Inferenz: Was steckt hinter der 10×‑Aussage?

Anbieter und Medien nennen für Mistral 3 in Verbindung mit NVIDIAs GB200 NVL72 ungewöhnlich hohe Beschleunigungen — oft als “10×” formuliert. Diese Zahl fällt in

Deepfakes erkennen: Wie Sie manipulierte Videos und Stimmen prüfen

Deepfakes erkennen ist heute eine praktische Frage: Manipulierte Bilder, Videos und Stimmen können täuschend echt wirken und Informationen verzerren. Dieser Text zeigt, welche technischen Grundlagen

Generative Modelle einfach erklärt: Sampling, Mapping und ein klarer Vergleich

Generative Modelle beschreiben, wie Computer neue Daten erzeugen — von Bildern bis Texten. Dieses Stück zeigt, wie unterschiedliche Prinzipien wie Sampling und Mapping bei Variational

Neues Audio‑LLM Step‑Audio‑R1 nutzt Test‑Time Compute Scaling

Zuletzt aktualisiert: 30. November 2025 Berlin, 30. November 2025 Insights Step‑Audio‑R1 ist ein neues Audio‑LLM, das Modality‑Grounded Reasoning Distillation (MGRD) mit Test‑Time Compute Scaling kombiniert.

Audio LLM: Wie Computer Hören, Verstehen und Antworten

Audio LLM sind Modelle, die Ton und Sprache direkt in große Sprachmodelle einbinden, um Fragen zu hören, Inhalte zu übersetzen oder Audio in Text und

KI und Energiebedarf großer Sprachmodelle

Große Sprachmodelle brauchen Rechenleistung — und damit Strom. Das Thema “KI und Energiebedarf großer Sprachmodelle” betrifft sowohl die Betreiber von Rechenzentren als auch Menschen, die

Warum AI‑Modelle in Produktion scheitern: Ursachen und Praxis

Warum AI‑Modelle in Produktion scheitern ist eine Frage, die oft bei Unternehmen auftritt, die ML‑Projekte skalieren wollen. Dieser Beitrag zeigt die häufigsten Ursachen: falscher Problem‑Fit,

Top AI-Startups 2025: Listen, Funding und Trends

Diese Übersicht ordnet den Markt der Top AI-Startups 2025: Welche Listen existieren, wie verlässlich sind Funding‑Angaben und welche Kategorien dominieren aktuell. Anhand geprüfter Quellen wie